Command Palette

Search for a command to run...

Das Für CVPR 2025 Ausgewählte Shanghai AI Lab Und Andere Schlugen Das Erste Vollmodale Framework Zur Reidentifizierung Medizinischer Bilder Vor, Das SOTA Für 11 Datensätze Erreichte

Im Bereich des KI-gesteuerten medizinischen Bildmanagements ist die medizinische Bildreidentifizierung (MedReID) eine Schlüsseltechnologie, die darauf abzielt, Patientenbilddaten aus verschiedenen Modalitäten und zu verschiedenen Zeiten automatisch zu verknüpfen und so eine starke Datenunterstützung für eine personalisierte Diagnose und Behandlung zu bieten. Allerdings ist dieser Bereich noch wenig erforscht.Herkömmliche Methoden basieren meist auf einfachen Bildmerkmalen oder manuell verwalteten Metadaten, die den klinischen Anforderungen an eine genaue Zuordnung umfangreicher, multimodaler Bilder kaum gerecht werden können.

Um dieser Herausforderung zu begegnen,Das Shanghai Artificial Intelligence Laboratory hat zusammen mit einer Reihe namhafter Universitäten das MaMI-Modell (Modality-adaptive Medical Identifier) vorgeschlagen.Hierbei handelt es sich um eine neue Methode zur Neuidentifizierung medizinischer Bilder, die die traditionelle Beschränkung auf eine einzelne Modalität durchbricht, indem sie einen kontinuierlichen Modalitätsparameteradapter einführt, sodass ein einheitliches Modell zur Laufzeit automatisch an ein modalitätsspezifisches Modell angepasst werden kann, das für die aktuelle Eingabe (wie Röntgen, CT, Fundus, Pathologie, MRT usw.) geeignet ist.

Mit dieser Strategie hat MaMI bei der Auswertung von 11 öffentlichen medizinischen Bilddatensätzen eine hochmoderne Reidentifizierungsleistung bewiesen und bietet eine präzise und dynamische Unterstützung bei der Abfrage historischer Bilddaten für die personalisierte Medizin.

Papieradresse:

https://arxiv.org/pdf/2503.08173

Code und Modell Open Source-Adresse:

https://github.com/tianyuan168326/All-in-One-MedReID-Pytorch

Forschungshighlights

Schlagen Sie das All-in-One Medical Re-ID Model (MaMI) vor

Zum ersten Mal hat das Forschungsteam ein Modell erstellt, das das Problem der erneuten Identifizierung medizinischer Bilder mehrerer Modalitäten einheitlich bewältigen kann, und ein einziges Modell verwendet, um die Erkennung von Bildern verschiedener Modalitäten (wie Röntgen, CT, Fundus, Pathologie, MRT usw.) zu erreichen.

Aufbau eines umfassenden medizinischen Re-ID-Benchmarks

Das Forschungsteam erstellte einen umfassenden und fairen Benchmark anhand von 11 öffentlichen medizinischen Bilddatensätzen, die mehrere Bildgebungsverfahren und verschiedene Organe abdecken, und stellte damit eine standardisierte Bewertungsplattform für die nachfolgende Forschung zu diesem Thema bereit.

Entwurf eines kontinuierlichen Modalparameter-Adapters (ComPA)

Das Forschungsteam hat einen innovativen Adapter für kontinuierliche modale Parameter vorgeschlagen, der dynamisch modalspezifische Parameter basierend auf dem Eingabebild generieren kann und so das ursprüngliche modalitätsunabhängige Modell in ein modalitätsspezifisches Modell umwandelt, das sich an die aktuellen Eingabeeigenschaften anpasst.

Medizinisches Vorwissen integrieren

Durch die Modellierung von Unterschieden zwischen den Bildern übertrug das Forschungsteam das umfangreiche medizinische Vorwissen des vorab trainierten medizinischen Basismodells auf die Neuidentifizierungsaufgabe und verbesserte so effektiv die Fähigkeit des Modells, subtile Identitätshinweise zu erfassen.

Überprüfen Sie den Anwendungswert in tatsächlichen Szenarien

* Diagnose mithilfe historischer Daten: MaMI kann personalisierte Patienteninformationen aus unorganisierten historischen Bilddaten abrufen und so die Genauigkeit bestehender medizinischer Untersuchungen erheblich verbessern;

* Datenschutz: MaMI kann subtile identifizierende Informationen in Bildern erkennen und diese automatisch entfernen, bevor Daten weitergegeben werden. So wird sichergestellt, dass notwendige medizinische Informationen erhalten bleiben und gleichzeitig die Privatsphäre der Patienten geschützt wird.

Modellarchitektur: Einführung eines Parameteradapters basierend auf dem kontinuierlichen Modus

Im Bereich der medizinischen Bildverwaltung gibt es zwei große Herausforderungen: die Verwaltung historischer Bilder und den Schutz der Privatsphäre.

Erste,Herkömmliche Methoden basieren hauptsächlich auf der manuellen Vorverknüpfung von Bildern mit Patientenmetadaten (wie Name, Krankenaktennummer) und dem Abrufen von Bildern über Abfragesysteme. Wenn die Daten jedoch auf verschiedenen PACS-Plattformen gespeichert werden,Solche Links sind oft unvollständig oder ungenau, was ihre effiziente Verwaltung erschwert.Daher besteht dringender Bedarf an einer Methode, mit der sich aus verstreuten und schlecht organisierten Daten präzise historische Bilder von Patienten abrufen lassen, um zuverlässige historische Beweise für die Krankheitsdiagnose zu liefern.

Zweitens,Derzeit konzentrieren sich die meisten Datenschutzmaßnahmen lediglich auf das Entfernen expliziter Informationen (wie etwa des Patientennamens). Studien haben jedoch ergeben, dassDarüber hinaus enthalten die Bilder subtile visuelle Hinweise, die die Identität des Patienten preisgeben können.Ein ideales Modell zur Reidentifizierung medizinischer Bilder sollte in der Lage sein, identitätsrelevante Bereiche im Bild automatisch zu erkennen und diese Bereiche durch entsprechende Nachbearbeitung unkenntlich zu machen. Dadurch wird das Risiko eines Datenschutzverstoßes wirksam verringert und gleichzeitig die medizinische Anwendbarkeit der Daten gewährleistet.

Als Reaktion auf die oben genannten Herausforderungen haben zwar einige wenige Studien begonnen, sich mit dem Problem der Reidentifizierung medizinischer Bilder zu befassen, doch die meisten dieser Arbeiten beschränken sich auf bestimmte Modalitäten. Zu den vorhandenen Studien gehören:

* Fukuta et al. und Singh et al. verwendete Low-Level-Funktionen, um eine Identitätserkennung auf Fundusbildern durchzuführen;

* Packhauser et al. nutzte neuronale Netzwerke, um eine erneute Identifizierung von Röntgenaufnahmen des Brustkorbs zu erreichen.

Diese Methoden sind alle auf eine einzige Modalität ausgelegt und können die komplementären Vorteile multimodaler Daten nur schwer nutzen. Gleichzeitig nutzen sie weniger medizinische Vorinformationen, was die Generalisierungsfähigkeit des Modells einschränkt.

Generell steckt die Forschung im Bereich der Reidentifizierung medizinischer Bilder noch in den Kinderschuhen.Es besteht dringender Bedarf an der Entwicklung einer einheitlichen Lösung, die multimodale Informationen integrieren kann und gleichzeitig die Verwaltung historischer Bilder und den Datenschutz berücksichtigt.

MaMI, vorgeschlagen vom Shanghai Artificial Intelligence Laboratory in Zusammenarbeit mit mehreren Universitäten, weist zwei wesentliche Neuerungen auf. Die erste besteht darin, eine modalitätsadaptive Merkmalsextraktion zu erreichen, indem ein modalitätsunabhängiges Modell zur Laufzeit in ein modalitätsspezifisches Modell umgewandelt wird. Die zweite besteht darin, das Modell zu optimieren, indem die umfangreichen medizinischen Vorkenntnisse des medizinischen Basismodells auf die medizinische Neuidentifizierungsaufgabe übertragen werden, um den Fokus stärker auf medizinisch relevante Bereiche zu richten.

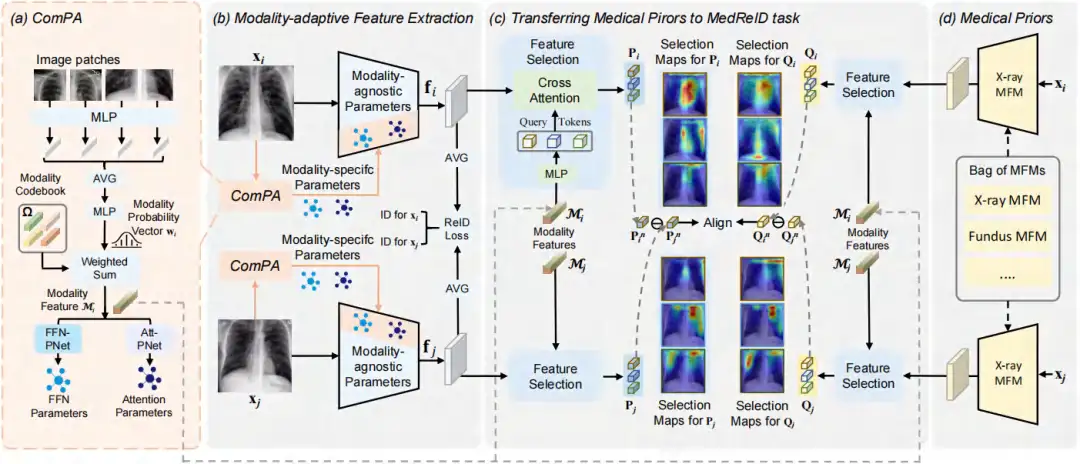

Wie in der folgenden Abbildung (a) gezeigt,Die Forscher führten einen kontinuierlichen Modus-basierten Parameteradapter (ComPA) einPassen Sie ein modalitätsunabhängiges Modell zur Laufzeit dynamisch an ein Modell an, das für die aktuelle Eingabemodalität geeignet ist. Das angepasste Modell extrahiert identitätsbezogene visuelle Merkmale aus dem medizinischen Eingabebild, wie in Abbildung (b) unten dargestellt. Während des Optimierungsprozesses haben die Forscher die wichtigsten Unterschiede zwischen den Bildern angeglichen.Übertragung umfangreichen medizinischen Vorwissens aus medizinischen Grundlagenmodellen (MFMs) auf medizinische Re-ID-Aufgaben,Wie in Abbildung (c) unten gezeigt.

Kontinuierlicher Modus-basierter Parameteradapter (ComPA)

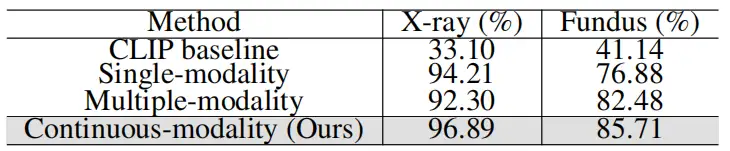

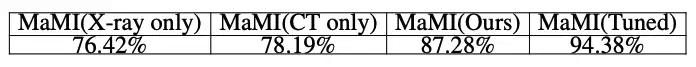

Um die spezifischen Merkmale der verschiedenen medizinischen Bildgebungsmodalitäten vollständig zu erfassen, stellten die Forscher fest, dass es durch eine einfache Feinabstimmung des einheitlichen Modells schwierig ist, die Vorteile der einzelnen Modalitäten hervorzuheben (siehe Tabelle 1). Daher ist eine modalitätsadaptive Merkmalsextraktion erforderlich. Zu diesem Zweck wurde das ComPA-Modul entwickelt, das zur Laufzeit durch kontinuierliche modale Darstellung und Vorhersage von Parametern mit niedrigem Rang dynamisch modellspezifische Parameter für das Eingabebild generiert und so den Mangel an modalitätsspezifischen Informationen im einheitlichen Modell effektiv ausgleicht.

Übertragen Sie medizinische Vorerkrankungen von medizinischen Grundlagenmodellen auf ReID-Modelle

Wenn man sich lediglich auf den Re-ID-Verlust verlässt, kann es sein, dass sich das Modell zu sehr auf triviale Texturen (wie etwa Geräterauschen) konzentriert und die intrinsischen biologischen Eigenschaften des Patienten ignoriert. Im Gegensatz dazu konzentrieren sich Medical Foundation Models (MFMs), die anhand großformatiger medizinischer Bilder vortrainiert wurden, auf anatomische Strukturen und bieten umfangreichere medizinische Vordaten für die Identitätserkennung.Die Forscher übertrugen ihr bisheriges Wissen auf das Re-ID-Modell und verwendeten lokale Merkmalskarten zur Steuerung des Modells.

Um die Domänenlücke zwischen der MFM-Vortrainingsaufgabe und der MedReID-Aufgabe zu schließen, werden zwei Strategien vorgeschlagen:

Erstens istAdaptive Auswahl von Schlüsselstrukturen. Die Forscher zuerstDie modalen Merkmale des Bildes werden in eine Reihe modalitätsspezifischer Abfragetoken projiziert, die wichtige Strukturinformationen in jeder Modalität erfassen können, wie etwa Organkonturen in Röntgenaufnahmen des Brustkorbs oder die Gefäßverteilung in Fundusbildern. Anschließend werden diese Abfragetoken über den Cross-Attention-Mechanismus mit lokalen Feature-Maps abgeglichen, wodurch eine genaue Auswahl der wichtigsten medizinischen semantischen Merkmale erreicht wird.Im Vergleich zur Verwendung aller Merkmalsinformationen verringert die Extraktion von Schlüsselstrukturen das Risiko einer Überanpassung.

Der zweite Grund ist vorheriges Lernen auf der Grundlage struktureller Residuen.Anders als bei der herkömmlichen Methode der direkten Ausrichtung von Merkmalen richten die Forscher die Unterschiede zwischen den Bildern aus und nutzen den Kontrastverlust, um subtile Unterschiede zwischen den Bildern zu lernen. Dadurch verbessern sie die Fähigkeit des Modells, Identitätsmerkmale zu erfassen.

Experimentelle Ergebnisse: Überprüfung des Nutzens in tatsächlichen Anwendungsszenarien

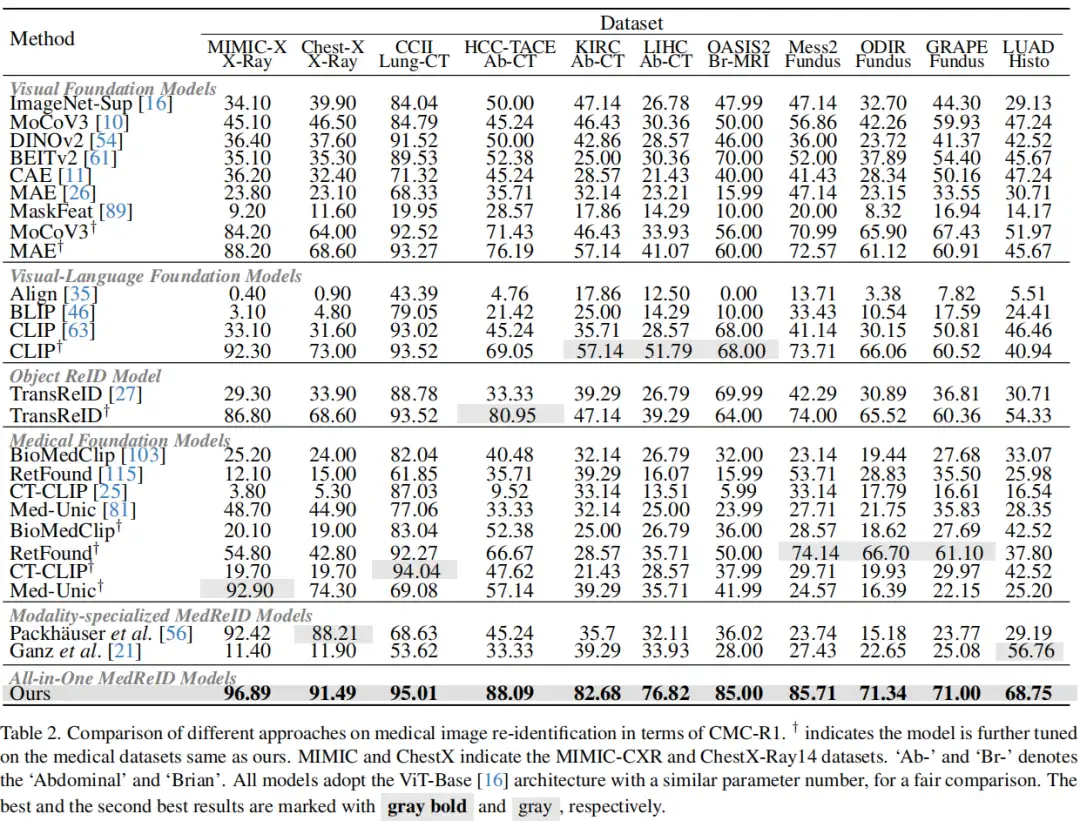

Die erste medizinische ReID-Liste

Wie in der folgenden Tabelle gezeigt, bewerteten die Forscher das visuelle Basismodell, das visuelle Sprachbasismodell, das Reidentifizierungsmodell, das medizinische Basismodell und das unimodale MedReID-Modell. Um ihr Potenzial voll auszuschöpfen und einen fairen Vergleich zu gewährleisten, haben sie die repräsentativen Modelle verfeinert.Die Ergebnisse zeigen, dass MaMI in mehreren Tests konstant die SOTA-Leistung erreicht.

Anwendungsszenario 1: Automatisierter Abruf historischer Fälle zur Unterstützung der Präzisionsmedizin

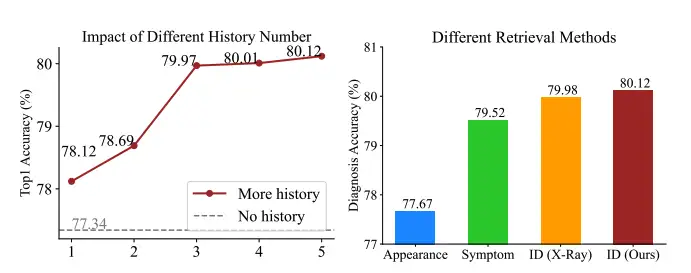

In tatsächlichen Szenarien, wenn man die schlechte Verwaltung der medizinischen Bilder der Patienten in der Vergangenheit berücksichtigt,Das Forschungsteam schlug vor, MaMI zu verwenden, um historische Bilder abzurufen, die mit dem aktuellen Bild in Zusammenhang stehen, und die Merkmale mehrerer historischer Bilder durch ein einfaches MLP zu fusionieren, um die Diagnose zu unterstützen und sich nur auf Bildinformationen zu verlassen.Keine Verlaufs-Tags erforderlich.

Beim Abrufen von 5 historischen Bildern,Die diagnostische Genauigkeitsrate stieg von 77,34% auf 80,12%, eine Steigerung um 2,78%.Wir demonstrieren die Wirksamkeit von MaMI bei der Nutzung historischer Daten in unstrukturierten Archiven zur Verbesserung des klinischen Nutzens. Weitere Vergleichsexperimente zeigen, dass unser Ansatz bei der Bildabrufleistung durchweg besser abschneidet als auf dem Erscheinungsbild (DINOv2), auf Symptomen (Med-Unic) und auf Röntgenstrahlen basierende ReID-Methoden, die speziell für Röntgenstrahlen entwickelt wurden (Packhauser et al.).

Anwendungsszenario 2: Automatisierter Datenschutz zur Gewährleistung ethischer Sicherheit im Zeitalter großer Modelle

Die Forscher verwendeten ein einfaches U-Net-Modell, um identitätsbezogene visuelle Merkmale in Bildern vorherzusagen und zu entfernen, und führten ihr ID-Modell als Verlust der Identitätsähnlichkeit ein.Dadurch wird die Ähnlichkeit der Identitätsmerkmale verringert, während die Ähnlichkeit der medizinischen Merkmale hoch bleibt.Die Ergebnisse des Trainings mit dem MIMIC-X-Datensatz und der Auswertung mit dem Chest-X-Datensatz zeigen, dass die geschützten Bilder Reidentifizierungsangriffen standhalten können, während die Genauigkeit der Krankheitsklassifizierung nur geringfügig niedriger ist als die der Originalbilder. Die Ergebnisse sind in der folgenden Tabelle dargestellt:

Abschluss

Das MaMI-Modell vereinheitlicht die Aufgaben der erneuten Identifizierung medizinischer Bilder und des Datenschutzes und verbessert die Gesamtleistung beim Abrufen historischer Bilder und beim Schutz von Identitätsinformationen erheblich. Der verstärkende Effekt von MaMI wird durch solide theoretische Analysen und umfassende experimentelle Überprüfungen unterstützt. Wir sind davon überzeugt, dass der innovative kontinuierliche Modalitätsparameteradapter und sein Design, das medizinisches Vorwissen integriert, ein neues Paradigma für die multimodale medizinische Bildverwaltung darstellen und voraussichtlich die Entwicklung fortschrittlicherer Bildverarbeitungstechnologien für eine personalisierte Diagnose und Behandlung sowie den Schutz der Privatsphäre anregen werden.

Darüber hinaus stellt das neu gegründete große Modellbewertungsteam des Shanghai Artificial Intelligence Laboratory Praktikanten ein. Interessierte Freunde können auf diesen Artikel klicken, um Einzelheiten anzuzeigen, oder ihren Lebenslauf direkt an [email protected] senden.