Command Palette

Search for a command to run...

Stable Virtual Camera Definiert Die Generierung Von 3D-Inhalten Neu Und Erschließt Neue Bilddimensionen; BatteryLife Hilft, Die Batterielebensdauer Genauer Vorherzusagen

Im harten Wettbewerb um die Erstellung digitaler Inhalte steht Stability AI an einem Scheideweg des Schicksals. Das Unternehmen, das einst mit Stable Diffusion eine Revolution in der Bilderzeugung auslöste, geriet aufgrund von Problemen im oberen Management in eine Krise. Vor Kurzem hat Stability AI das Modell Stable Virtual Camera auf den Markt gebracht. Ich frage mich, ob es mit einem kräftigen Schlag den Stillstand beenden kann.

Stable Virtual Camera ist ein Multi-View-Diffusionsmodell, das die Steuerungsmöglichkeiten einer herkömmlichen virtuellen Kamera mit der Kreativität generativer KI kombiniert. Die Technologie wandelt gewöhnliche 2D-Bilder in 3D-Videos mit realistischer Tiefe und Perspektive um, ohne dass eine komplexe Szenenrekonstruktion oder spezielle Kenntnisse erforderlich sind.

Im Vergleich zu herkömmlichen 3D-VideomodellenDas Modell erfordert keine große Anzahl von Eingabebildern oder komplexe Vorverarbeitungsschritte, wodurch die Generierung von 3D-Inhalten viel einfacher und praktikabler wird.Und diese Technologie schneidet beim Novel View Synthesis (NVS)-Benchmark gut ab.Die Leistung übertrifft einige bestehende Modelle.

Derzeit ist HyperAI Super Neural online „Stabile virtuelle Kamerabilder werden in Sekundenschnelle in 3D-Videos verwandelt.“Tutorial, komm und probier es aus~

Online-Nutzung:https://go.hyper.ai/N2u9l

Vom 24. bis 28. März gibt es Updates auf der offiziellen Website von hyper.ai:

* Hochwertige öffentliche Datensätze: 10

* Auswahl an hochwertigen Tutorials: 3

* Community-Artikelauswahl: 3 Artikel

* Beliebte Enzyklopädieeinträge: 5

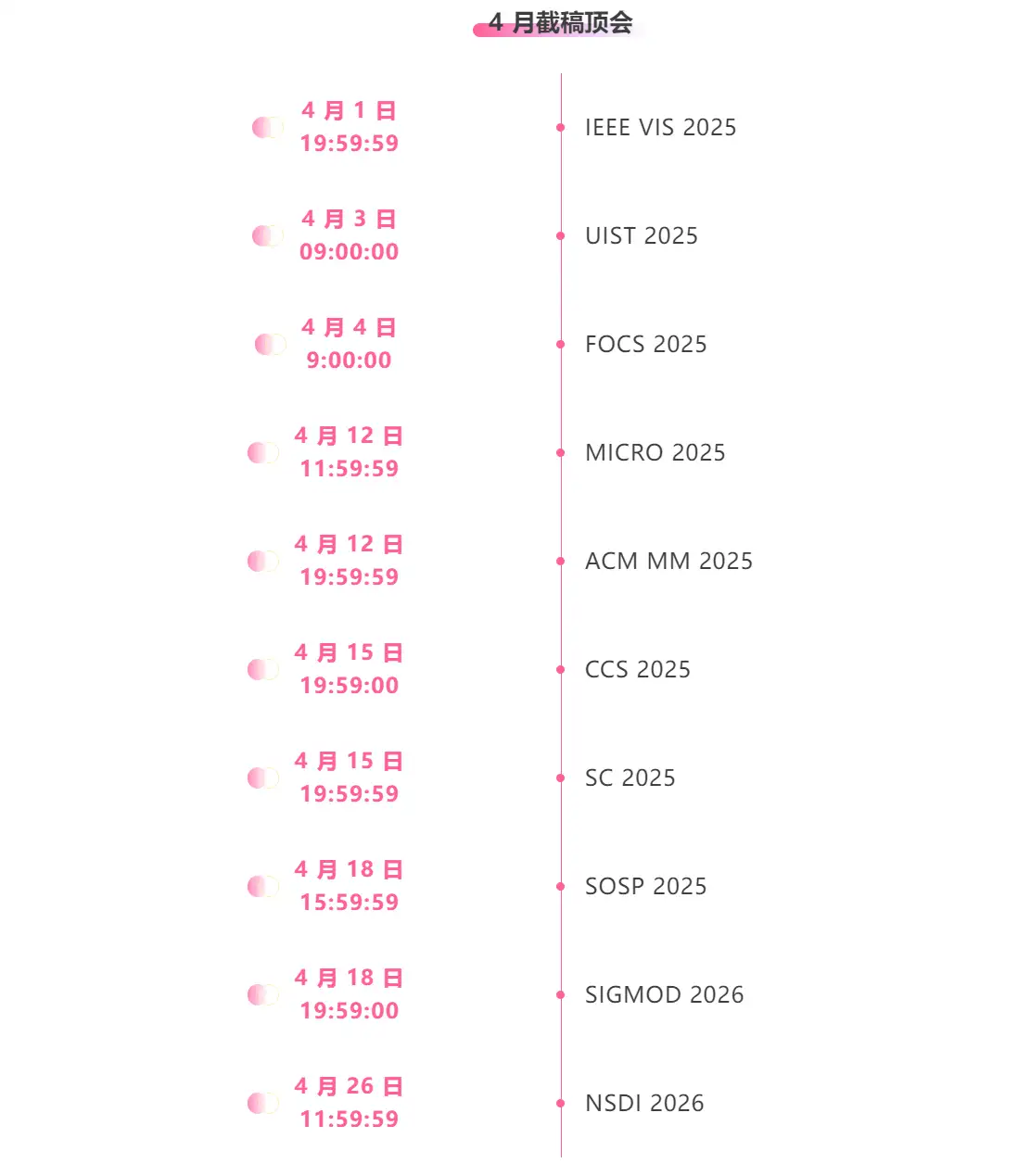

* Top-Konferenzen mit Deadline im April: 10

Besuchen Sie die offizielle Website:hyper.ai

Ausgewählte öffentliche Datensätze

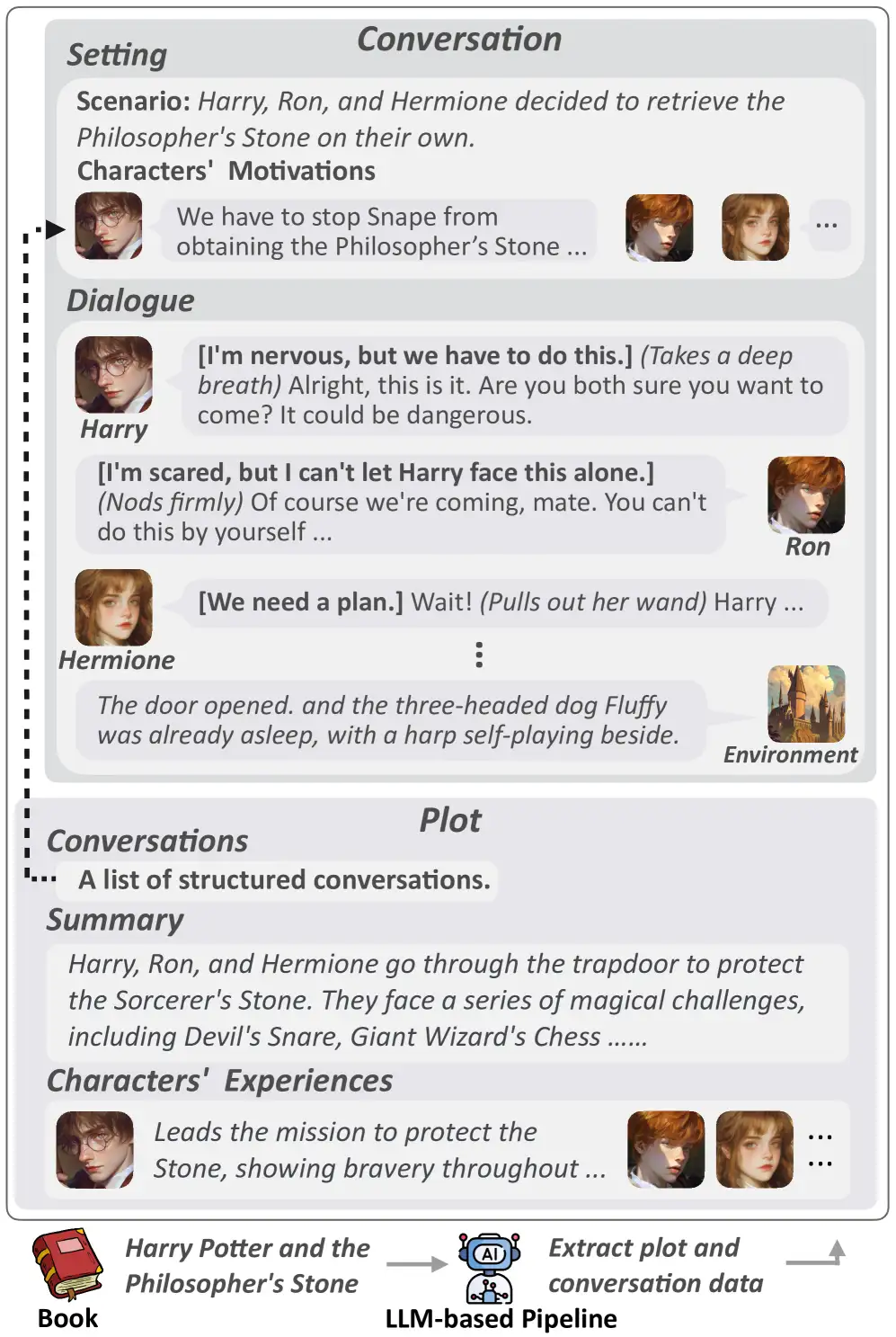

1. CoSER-Rollenspiel-Datensatz

Der Datensatz umfasst 17.966 Zeichen und 29.798 echte Dialoge. Es enthält nicht nur Charakterübersichten und Dialoge, sondern bietet auch umfangreiche Inhalte wie Handlungszusammenfassungen, Charaktererlebnisse und Dialoghintergründe. Darüber hinaus umfasst der Dialoginhalt drei Dimensionen: Sprache, Handlung und Denken, wodurch die Charakterdarstellung dreidimensionaler wird.

Direkte Verwendung:https://go.hyper.ai/1WbXV

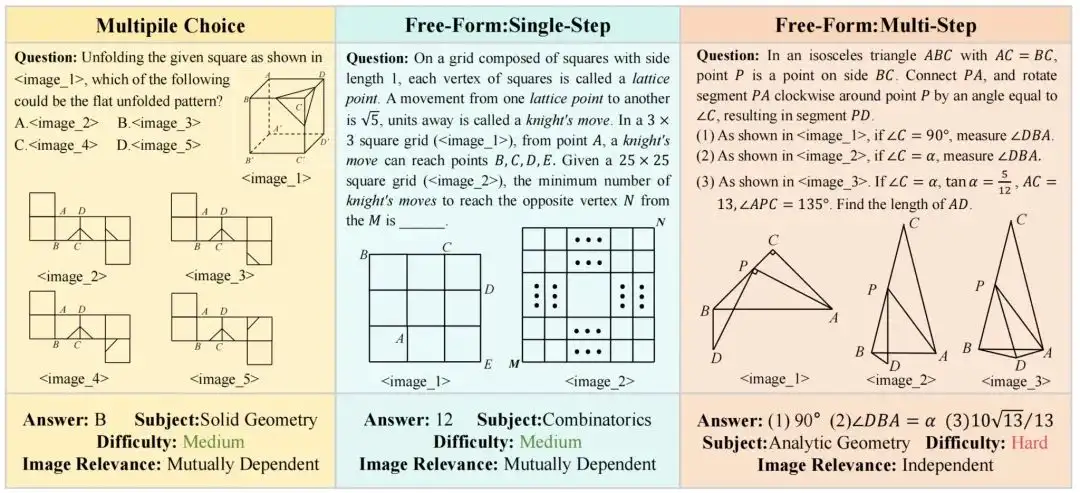

2. MV-MATH Mathematical Reasoning Annotation Dataset

Der MV-MATH-Datensatz enthält 2.009 hochwertige Mathematikaufgaben, die in drei Typen unterteilt sind: Multiple-Choice-Fragen, Lückentextfragen und mehrstufige Fragen. Der Datensatz enthält mehrere visuelle Szenen und jede Frage ist mit 2 bis 8 Bildern ausgestattet. Diese Bilder werden mit Text verflochten, um komplexe multivisuelle Szenen zu bilden, die mathematischen Problemen in der realen Welt näher kommen und die Denkfähigkeit des Modells zur Verarbeitung multivisueller Informationen effektiv bewerten können.

Direkte Verwendung:https://go.hyper.ai/tRQsA

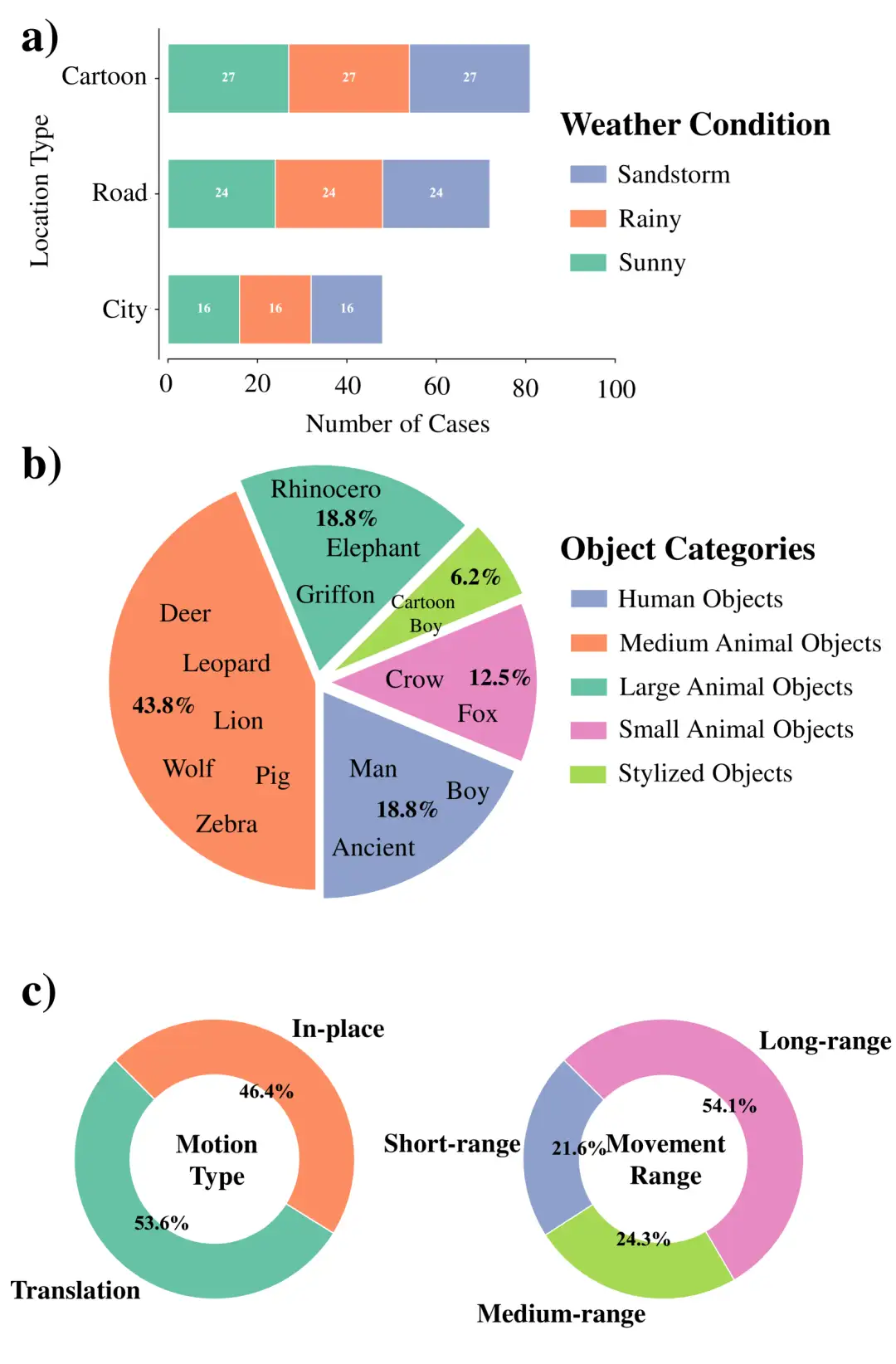

3. WideRange4D Multi-View-Szenendatensatz

Dieser Datensatz füllt die Lücke in vorhandenen 4D-Rekonstruktionsdatensätzen in komplexen dynamischen Szenen, indem er 4D-Szenendaten mit einem großen Bereich räumlicher Bewegung einführt. Es zeichnet sich durch Szenenreichtum, Bewegungskomplexität und Umgebungsvielfalt aus, einschließlich realer Szenen (wie Stadtstraßen, Landstraßen) und virtueller Szenen, die Bewegungen über kurze, mittlere und lange Distanzen sowie komplexe Bewegungsbahnen abdecken und gleichzeitig eine Vielzahl von Wetterbedingungen wie sonnige Tage, regnerische Tage und Sandstürme simulieren.

Direkte Verwendung:https://go.hyper.ai/9KszI

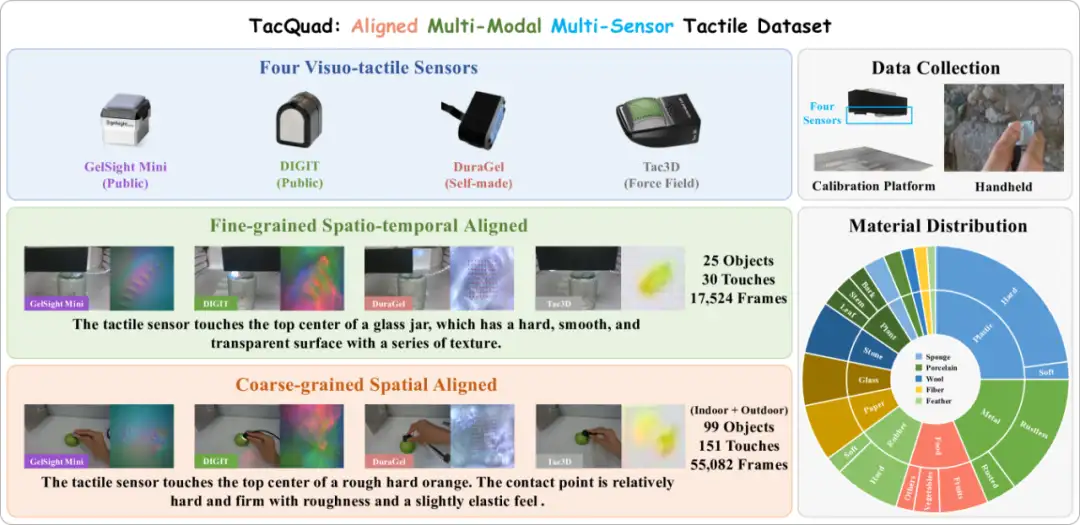

4. TacQuad Multimodaler Multisensor-Taktildatensatz

TacQuad ist ein abgestimmter multimodaler taktiler Multisensor-Datensatz, der von vier Arten visueller taktiler Sensoren (GelSight Mini, DIGIT, DuraGel und Tac3D) gesammelt wurde. Es bietet eine umfassendere Lösung für die geringe Standardisierung visueller Tastsensoren, indem es Multisensor-Ausrichtungsdaten mit Text und visuellen Bildern bereitstellt. Dies ermöglicht dem Modell ausdrücklich, taktile Attribute auf semantischer Ebene und sensorunabhängige Merkmale zu erlernen und so durch einen datengesteuerten Ansatz einen einheitlichen Multisensor-Darstellungsraum zu bilden.

Direkte Verwendung:https://go.hyper.ai/uL0Zd

5. Videodatensatz zu physischer KI-Robotik und autonomem Fahren

Dieser Datensatz ist ein physischer KI-Datensatz, der von NVIDIA auf der GTC25-Konferenz veröffentlicht wurde. Es enthält 15 TB Daten, mehr als 320.000 Trajektorien für das Robotertraining und bis zu 1.000 Assets zur allgemeinen Szenenbeschreibung (OpenUSD), einschließlich der SimReady-Sammlung, die verschiedene Straßentypen und geografische Umgebungen, unterschiedliche Infrastrukturen und unterschiedliche Wetterumgebungen abdeckt.

Direkte Verwendung:https://go.hyper.ai/LEHa5

6. Luftbildlandschaften Luftbildlandschaftsdatensatz

Skyview ist ein kuratierter Datensatz zur Klassifizierung von Landschaften aus der Luft mit insgesamt 12.000 Bildern und 15 verschiedenen Kategorien. Jede Kategorie enthält 800 qualitativ hochwertige Bilder mit einer Auflösung von 256 × 256 Pixeln. Dieser Datensatz vereint Bilder aus den öffentlich verfügbaren AID- und NWPU-Resisc45-Datensätzen. Ziel der Zusammenstellung ist die Förderung von Forschung und Entwicklung im Bereich der Computervision, insbesondere der Landschaftsanalyse aus der Luft.

Direkte Verwendung:https://go.hyper.ai/mne9z

7. EMM-AU-Videodatensatz zu Verkehrsunfällen

Dieser Datensatz ist der erste Datensatz, der speziell für Aufgaben zur Schlussfolgerung im Zusammenhang mit Verkehrsunfällen entwickelt wurde, und er erweitert den MM-AU-Datensatz durch die Nutzung fortschrittlicher Techniken zur Videogenerierung und -verbesserung. Der Datensatz enthält 2.000 neu erstellte, detaillierte Unfallszenenvideos, die durch Feinabstimmung des vortrainierten Open-Sora 1.2-Modells generiert werden, mit dem Ziel, umfangreichere und vielfältigere Trainingsdaten zum Verständnis und zur Prävention von Unfällen bereitzustellen.

Direkte Verwendung:https://go.hyper.ai/gy0mb

8. BatteryLife Datensatz zur Vorhersage der Akkulaufzeit

Dieser Datensatz wurde ursprünglich erstellt, um die Forschung zur Vorhersage der Batterielebensdauer zu unterstützen. Es integriert 16 verschiedene Datensätze und bietet mehr als 90.000 Proben von 998 Batterien, alle mit Lebensdaueretiketten. Der BatteryLife-Datensatz ist 2,4-mal größer als die bisher größte Ressource zur Akkulaufzeit, BatteryML.

Direkte Verwendung:https://go.hyper.ai/0PzfZ

9. VenusMutHub Proteinmutation kleiner Stichprobendatensatz

VenusMutHub ist der erste kleine Beispieldatensatz von Proteinmutationen für reale Anwendungsszenarien. Das Forschungsteam hat sorgfältig 905 kleine experimentelle Mutationsdatensätze für reale Anwendungsszenarien zusammengestellt, die 527 Proteine abdecken (von denen 981 TP3T-Proteine 5–200 Mutationen aufweisen) und eine Vielzahl funktioneller Messdaten wie Stabilität, Aktivität, Bindungsaffinität und Selektivität abdecken. Um die Genauigkeit der Bewertung sicherzustellen, wurden alle Daten mithilfe direkter biochemischer Messungen und nicht mithilfe alternativer Fluoreszenzmessungen gewonnen.

Direkte Verwendung:https://go.hyper.ai/8y20R

10. Vogel vs. Drohne Datensatz zur Klassifizierung von Vogel- und Drohnenbildern

Dieser Datensatz enthält eine vielfältige Sammlung von Bildern von der Pexel-Website, die Vögel und Drohnen in Bewegung darstellen. Die Bilder werden aus Videobildern aufgenommen, segmentiert, erweitert und vorverarbeitet, um verschiedene Umgebungsbedingungen zu simulieren und so den Modelltrainingsprozess zu verbessern.

Direkte Verwendung:https://go.hyper.ai/RdN4d

Ausgewählte öffentliche Tutorials

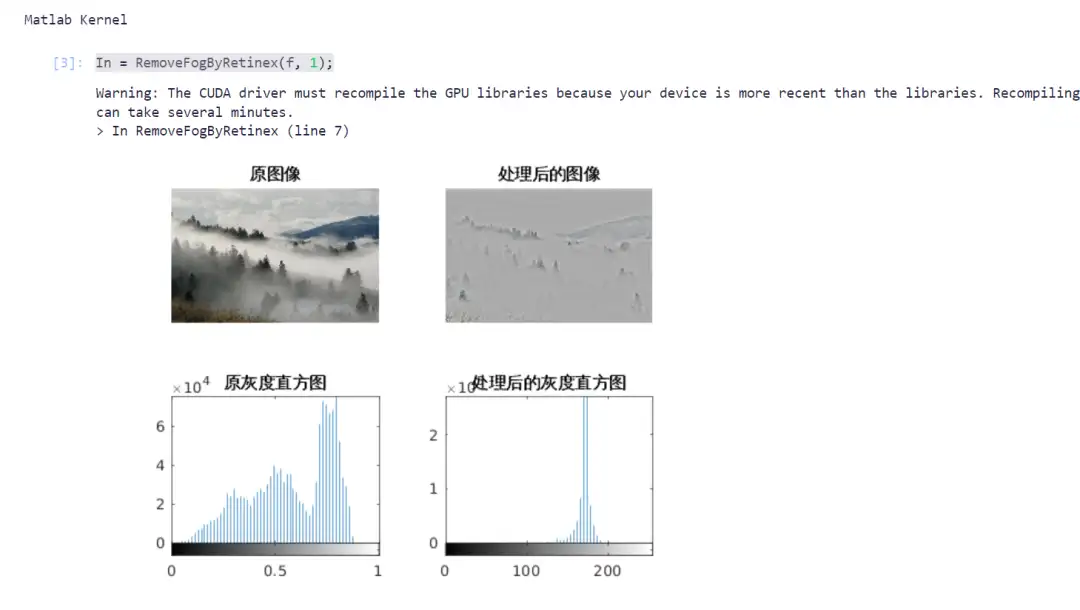

Im Bereich der Computervision ist die Bildentnebelung eine wichtige Vorverarbeitungsaufgabe, insbesondere beim autonomen Fahren, der Fernerkundungsbildanalyse und bei Überwachungssystemen. Durch die Entfernung von Dunst kann die Bildqualität effektiv verbessert und das Ziel deutlicher sichtbar gemacht werden.

Dieses Projekt verwendet den Retinex-Algorithmus zur Bildentnebelung und kombiniert ihn mit GPU-Beschleunigung, um die Rechenleistung zu verbessern. Geben Sie den entsprechenden Code gemäß dem Tutorial ein, um den Bildentnebelungsprozess abzuschließen.

Online ausführen:https://go.hyper.ai/wu1fE

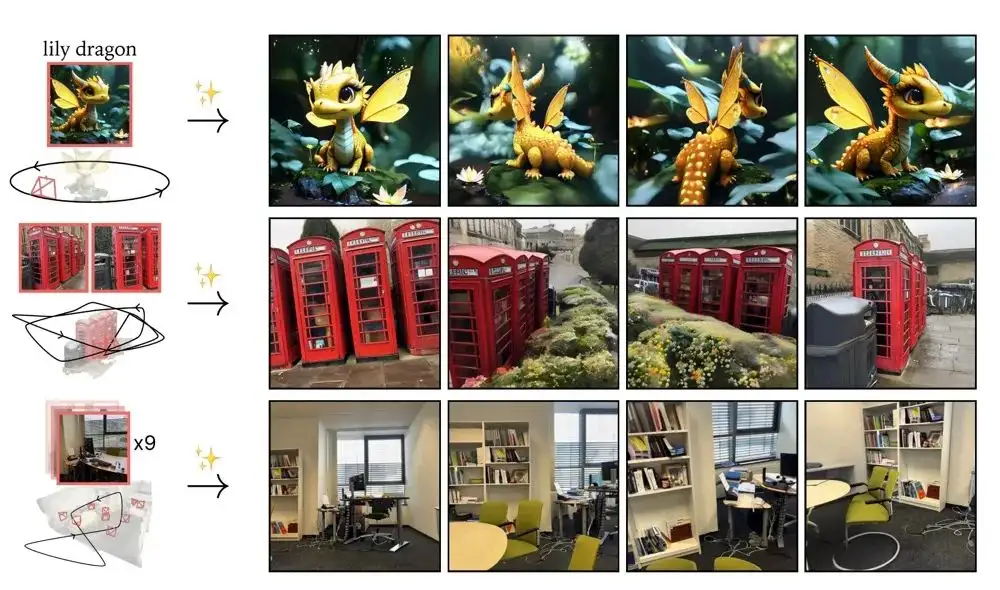

2. Stabile virtuelle Kamera verwandelt Bilder in Sekundenschnelle in 3D-Videos

Stable Virtual Camera (kurz Seva) ist ein allgemeines Diffusionsmodell, das im März 2025 von Stability AI eingeführt wurde. Seva kann bei einer beliebigen Anzahl von Eingabeansichten und Zielkameras neue Ansichten einer Szene generieren. Sein Design überwindet die Einschränkungen bestehender Methoden bei der Generierung von Stichproben mit großen Blickwinkelvariationen oder zeitlich glatten Stichproben, ohne auf eine bestimmte Aufgabenkonfiguration angewiesen zu sein.

Ein bemerkenswertes Merkmal dieses Modells besteht darin, dass es eine äußerst konsistente Stichprobengenerierung aufrechterhalten kann, ohne dass zusätzliches 3D-Darstellungslernen erforderlich ist, wodurch der Prozess der Perspektivensynthese in praktischen Anwendungen vereinfacht wird. Darüber hinaus kann Seva qualitativ hochwertige Videos mit einer Länge von bis zu einer halben Minute erstellen und nahtlos in einer Schleife abspielen. Umfangreiche Benchmarktests zeigen, dass Seva bei unterschiedlichen Datensätzen und Einstellungen bestehende Methoden übertrifft.

Die relevanten Modelle und Abhängigkeiten dieses Projekts wurden bereitgestellt. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen.

Online ausführen:https://go.hyper.ai/N2u9l

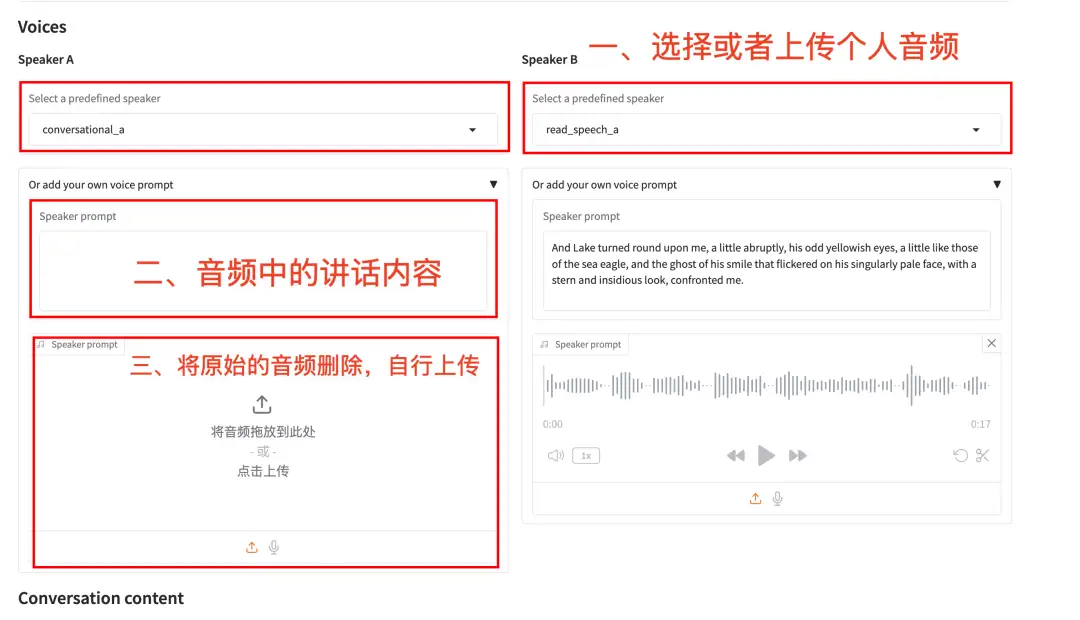

Das vom Sesame-Team eingeführte Sprachgenerierungsmodell CSM (Conversational Speech Model) kann auf der Grundlage von Text- und Audioeingaben flüssige, natürliche und emotionale Sprache ausgeben. Im Vergleich zu herkömmlichen KI-Modellen zur Sprachgenerierung verfügt CSM über ein stärkeres emotionales Verständnisvermögen, einen natürlicheren Gesprächsrhythmus, eine nahezu verzögerungsfreie Echtzeitinteraktion und kein Drohnengefühl.

Online ausführen:https://go.hyper.ai/bxOoN

Community-Artikel

Der vom Team des Peking University International Hospital entwickelte Deep-Learning-Algorithmus AcneDGNet kann Akne-Läsionen präzise identifizieren und ihren Schweregrad automatisch bestimmen, und zwar mit einer diagnostischen Genauigkeit, die mit der von erfahrenen Dermatologen vergleichbar ist. Es bietet umfassende Unterstützung für Online-Beratungen und medizinische Offline-Behandlungen und trägt so zu einer effizienteren Behandlung von Akne bei. Dieser Artikel ist eine detaillierte Interpretation und Weitergabe der Forschungsergebnisse.

Den vollständigen Bericht ansehen:https://go.hyper.ai/qAjYK

Ein Forschungsteam der Universität Cambridge hat eine Methode namens AlphaFold-Metainference vorgeschlagen. Diese Methode nutzt die Korrelation zwischen der von AlphaFold vorhergesagten Ausrichtungsfehlerkarte und der Distanzänderungsmatrix in der molekulardynamischen Simulation, um eine strukturelle Sammlung ungeordneter Proteine und Proteine mit ungeordneten Regionen zu erstellen. Dies liefert neue Ideen für die Vorhersage ungeordneter Proteinstrukturen auf der Grundlage von Deep-Learning-Methoden und erweitert den Anwendungsbereich von AlphaFold weiter. Dieser Artikel ist eine detaillierte Interpretation und Weitergabe der Forschungsergebnisse.

Den vollständigen Bericht ansehen:https://go.hyper.ai/6Bbhc

Studien haben gezeigt, dass die visuelle Ermüdung von Fachkräften nach stundenlanger Arbeit mit medizinischen Bildern zu Grenzfehlern von bis zu 12% führen kann. Um dieses Problem zu lösen, hat sich NVIDIA kürzlich mit anderen Forschungsteams zusammengetan, um ein multimodales VISTA3D-Modell zur medizinischen Bildsegmentierung vorzuschlagen. Dieses Modell war Vorreiter einer Methode zur dreidimensionalen Supervoxel-Merkmalsextraktion und erreichte durch eine einheitliche Architektur eine kollaborative Optimierung der dreidimensionalen automatischen Segmentierung und interaktiven Segmentierung. In einem umfassenden Benchmarktest mit 23 Datensätzen wurde die Segmentierungsgenauigkeit im Vergleich zum bestehenden optimalen Expertenmodell um 5,2% verbessert. Die entsprechenden Ergebnisse wurden als Preprint auf arXiv veröffentlicht. Dieser Artikel ist eine detaillierte Interpretation und Weitergabe der Forschungsergebnisse.

Den vollständigen Bericht ansehen:https://go.hyper.ai/D19LU

Beliebte Enzyklopädieartikel

1. DALL-E

2. Reziproke Sortierfusion RRF

3. Pareto-Front

4. Umfangreiches Multitasking-Sprachverständnis (MMLU)

5. Kontrastives Lernen

Hier sind Hunderte von KI-bezogenen Begriffen zusammengestellt, die Ihnen helfen sollen, „künstliche Intelligenz“ zu verstehen:

Zentrale Verfolgung der wichtigsten wissenschaftlichen KI-Konferenzen:https://go.hyper.ai/event

Das Obige ist der gesamte Inhalt der Auswahl des Herausgebers dieser Woche. Wenn Sie über Ressourcen verfügen, die Sie auf der offiziellen Website von hyper.ai veröffentlichen möchten, können Sie uns auch gerne eine Nachricht hinterlassen oder einen Artikel einreichen!

Bis nächste Woche!