Command Palette

Search for a command to run...

Online-Tutorial: Die Einzelkarte A6000 Setzt Gemma 3 Problemlos Ein Und Identifiziert Die Echte Aufnahme Von Huang Renxuns Rede Genau

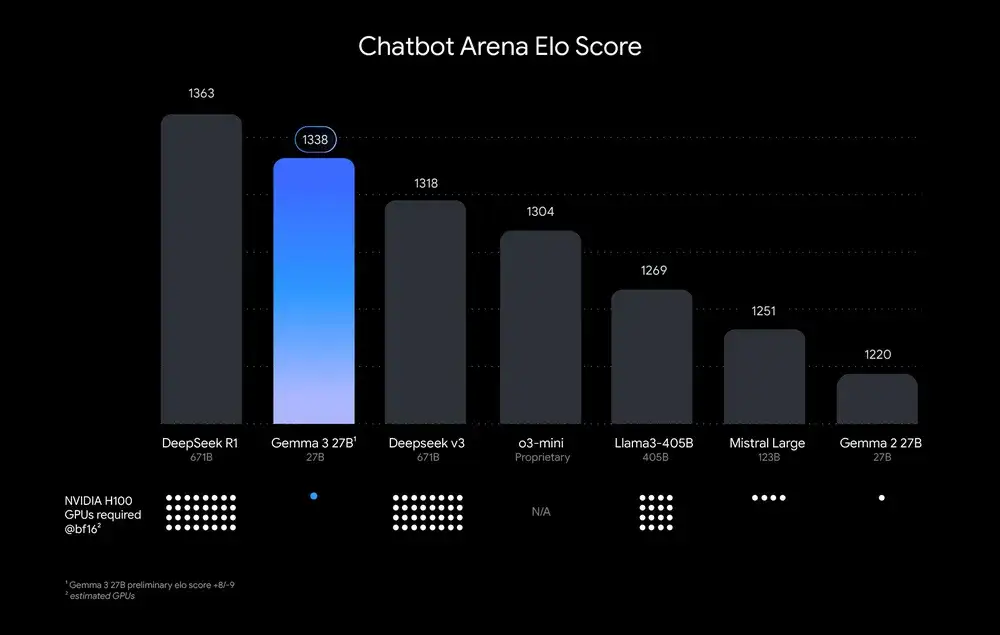

Am Abend des 12. MärzGoogle hat Gemma 3 veröffentlicht, den „Single-Card-Teufel“, der als das leistungsstärkste Modell gilt, das auf einer einzelnen GPU oder TPU ausgeführt werden kann.Die tatsächlichen Ergebnisse bestätigten auch, was im offiziellen Blog stand: Die 27-B-Version übertraf den Vollblut-DeepSeek V3 mit 671 B sowie o3-mini und Llama-405 B und wurde nur vom DeepSeek R1 übertroffen, doch sein Rechenleistungsbedarf war weitaus geringer als bei anderen Modellen. Wie in der folgenden Abbildung dargestellt:

*Modelle werden nach Chatbot Arena Elo-Score eingestuft; Punkte stellen den geschätzten Rechenleistungsbedarf dar

Anschließend hob Google auch großzügig das Verbot des technischen Berichts zu Gemma 3 auf. Darin wird eingeführt, dass Gemma 3 Methoden wie Destillation, bestärkendes Lernen und Modellzusammenführung kombiniert und die Leistung sowohl der vorab trainierten als auch der anweisungsoptimierten Version besser ist als bei Gemma 2. Gleichzeitig werden visuelle Verständnisfunktionen und umfassendere Sprachverständnisfunktionen eingeführt, die das Verständnis von mehr als 140 Sprachen und 128.000 langen Kontexten unterstützen.

In Anwendungsszenarien kann das multimodale Großmodell Gemma 3 Text- und Bildeingaben verarbeiten und Textausgaben generieren, was sich für verschiedene Aufgaben zur Textgenerierung und zum Bildverständnis eignet, einschließlich der Beantwortung von Fragen, Zusammenfassungen und Schlussfolgerungen. Die vier Parameterversionen 1B, 4B, 12B und 27B, die dieses Mal als Open Source bereitgestellt werden, umfassen sowohl vortrainierte Modelle als auch allgemeine Feinabstimmungsversionen für Anweisungen, die schnell direkt auf Geräten wie Mobiltelefonen, Laptops und Workstations ausgeführt werden können.

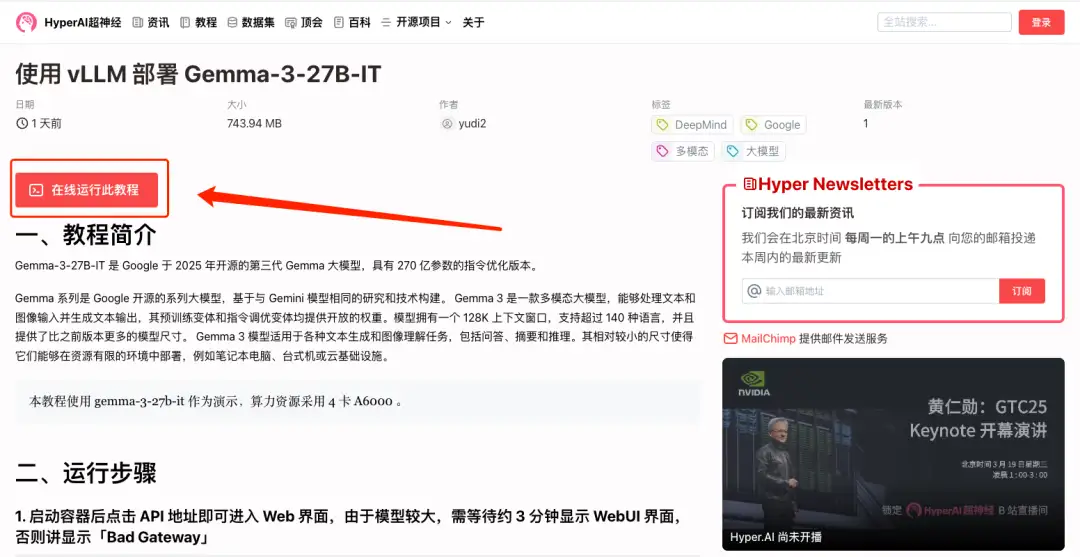

Damit jeder dieses „leistungsstärkste multimodale Modell einer einzelnen GPU“ besser erleben kann,Im Tutorial-Bereich der offiziellen Website von HyperAI wurde „Deploying Gemma-3-27B-IT using vLLM“ veröffentlicht, eine befehlsoptimierte Version mit 27 Milliarden Parametern.

Link zum Tutorial:

Darüber hinaus haben wir für alle einen Überraschungsbonus vorbereitet - 4 Stunden Einzelkarte RTX A6000 Kostenloser Nutzungszeitraum (Gültigkeitsdauer der Ressource beträgt 1 Monat), neue Benutzer verwenden einen Einladungscode Gemma-3Registrieren Sie sich, um es zu erhalten. Es sind nur 10 Plätze verfügbar. Wer zuerst kommt, mahlt zuerst!

Demolauf

1. Melden Sie sich bei hyper.ai an, wählen Sie auf der Tutorial-Seite „Gemma-3-27B-IT mit vLLM bereitstellen“ und klicken Sie auf „Dieses Tutorial online ausführen“.

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

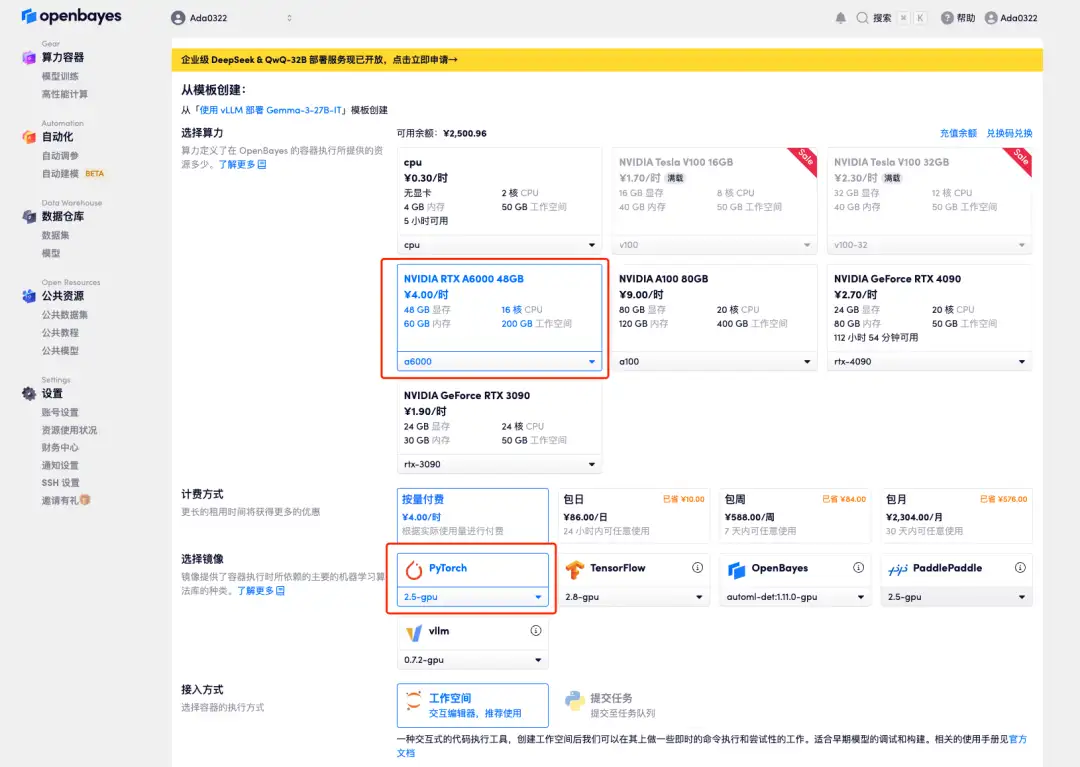

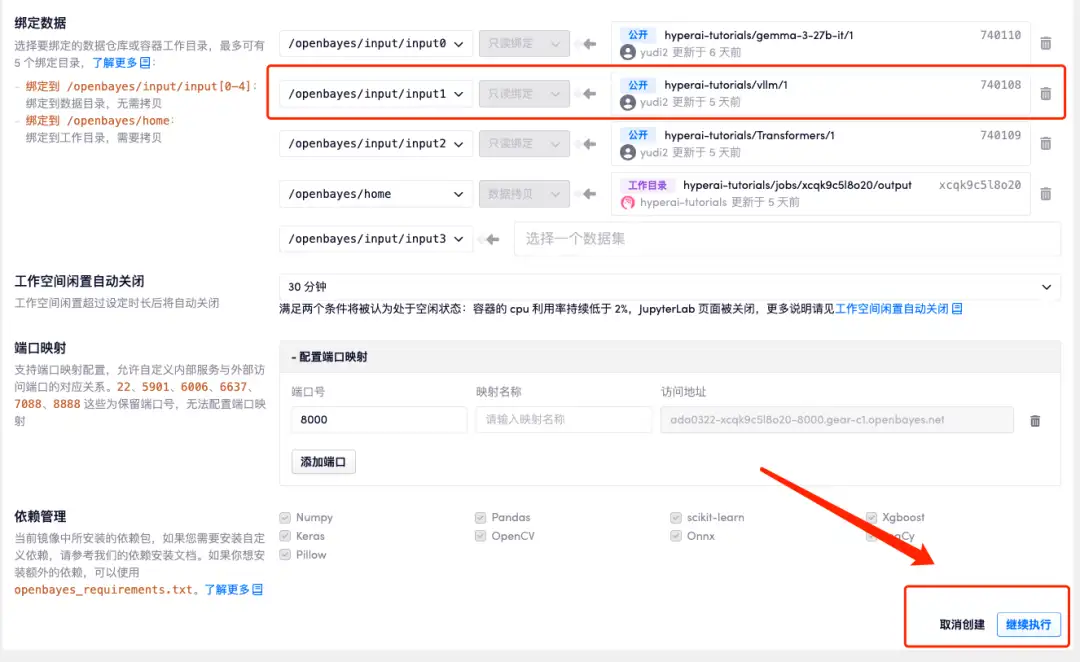

3. Wählen Sie NVIDIA A6000- und PyTorch-Bilder aus und klicken Sie auf „Weiter“. Wir haben die neueste Version von vLLM in den Container vorgeladen.

Die OpenBayes-Plattform hat eine neue Abrechnungsmethode eingeführt. Sie können je nach Bedarf zwischen „Pay as you go“ oder „Tages-/Wochen-/Monatspaket“ wählen. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren, um 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit zu erhalten!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

4. Warten Sie, bis die Ressourcen zugewiesen wurden. Der erste Klonvorgang dauert etwa 2 Minuten. Wenn sich der Status in „Läuft“ ändert, klicken Sie auf den Sprungpfeil neben „API-Adresse“, um zur Demoseite zu springen. Da das Modell groß ist, dauert es etwa 3 Minuten, bis die WebUI-Schnittstelle angezeigt wird, andernfalls wird „Bad Gateway“ angezeigt. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresszugriffsfunktion eine Echtnamenauthentifizierung durchführen müssen.

Effektanzeige

Gestern (19. März) hielt Huang Renxun, der „Lederschwertkämpfer“, am frühen Morgen eine Grundsatzrede auf der NVIDIA GTC 2025. Ich habe ihn benutzt, um Gemma 3s Bildverständnis zu testen. Es erkannte Huang nicht nur auf den ersten Blick, sondern erkannte auch, dass er eine Fernbedienung hielt und auf der Bühne stand, wie in der folgenden Abbildung dargestellt: