Command Palette

Search for a command to run...

Der Aktienkurs Konnte Seinen Abwärtstrend Nicht stoppen. Huang Renxun Gab Die Startzeit Von Blackwell Ultra Und Vera Rubin Bekannt, Und Die Denkfähigkeit Rückte in Den Mittelpunkt

In den letzten Jahren war NVIDIA bei fast jedem wichtigen Trend im globalen Technologiebereich präsent, von Cloud Computing bis hin zu Kryptowährungen, vom Metaversum bis hin zu künstlicher Intelligenz. Insbesondere in der neuen Welle der künstlichen Intelligenz kontrolliert NVIDIA mit seiner umfassenden technologischen Akkumulation den Marktanteil der GPUs für Rechenzentren von etwa 951 TP3T und wird zum absoluten Marktführer im Bereich der KI-Chips.

Doch Anfang dieses JahresDeepSeek Das Aufkommen von Inferenzmodellen hat der Öffentlichkeit ein klares Signal gesendet: Das Modell „mit großem Aufwand Wunder vollbringen“, das in der Vergangenheit auf der Anhäufung von Daten und Rechenleistung beruhte, ist allmählich wirkungslos geworden. Dies hat die Erwartungen des Marktes hinsichtlich der Rechenleistung von KI erschüttert und die Aktienkurse vieler Technologiegiganten, darunter Nvidia, sind stark gefallen. Obwohl sich der Aktienkurs von Nvidia inzwischen erholt hat, ist seine Dominanz in der Branche nicht mehr so unerschütterlich wie früher. Um die Stärke des Unternehmens unter Beweis zu stellen, muss Nvidia seine GPU umfassend aufrüsten und aktualisieren.

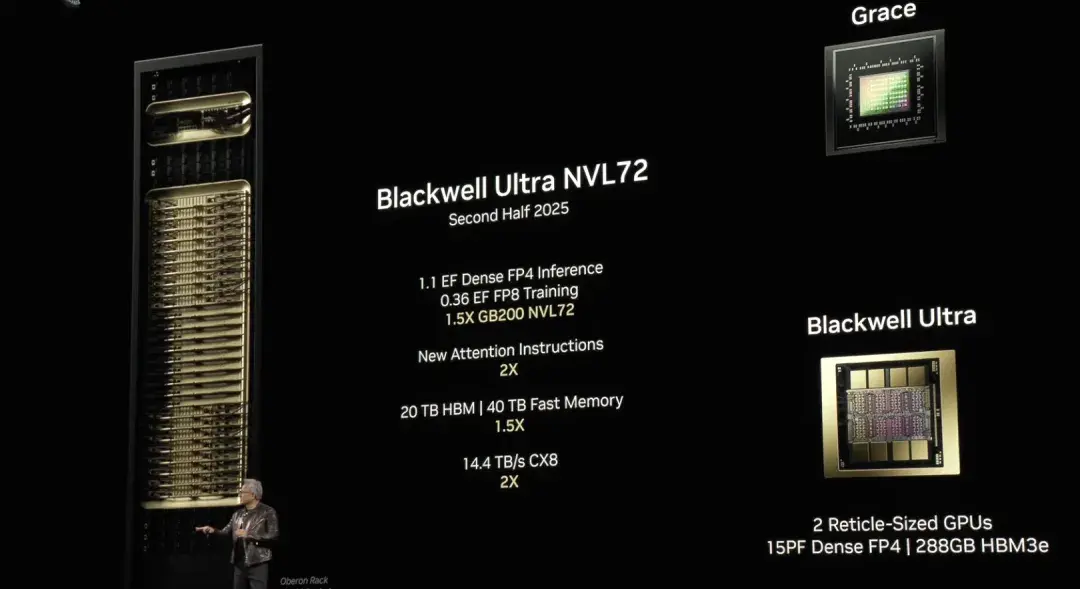

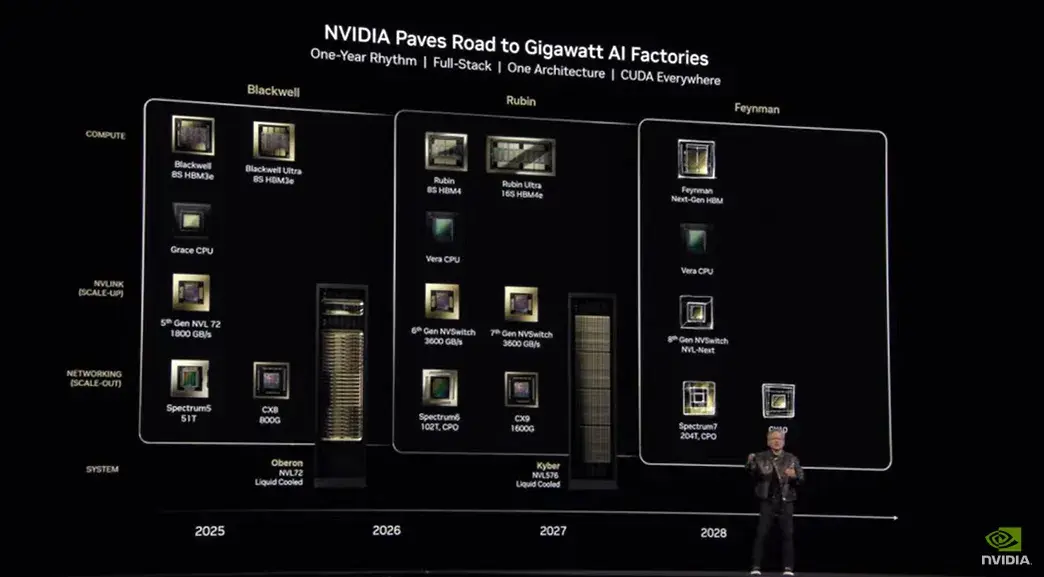

Auf der GTC 2025-Konferenz, die am 19. März um 1 Uhr Pekinger Zeit stattfand, brachte Huang Renxun die neuesten Nachrichten über Nvidia-Chips:Die verbesserte Version der KI-Chiparchitektur Blackwell, Blackwell Ultra, wird in der zweiten Hälfte dieses Jahres auf den Markt kommen. NVIDIA GB300 NVL72 und NVIDIA HGX™ B300 NVL16 werden die Fähigkeiten zur Modellbegründung umfassend verbessern. NVIDIAs GPU-Architektur der nächsten Generation, Vera Rubin, wird nächstes Jahr verfügbar sein.

NVIDIA Blackwell Ultra beschleunigt KI-Inferenz

Auf der letztjährigen GTC-Konferenz kündigte Huang Renxun die KI-Chiparchitektur Blackwell der nächsten Generation an. Trichter Als Nachfolger der NVIDIA GeForce GPU verfügt die Blackwell-Architektur über 208 Milliarden Transistoren und konzentriert sich auf die Beschleunigung generativer KI-Aufgaben, groß angelegtes Training und Inferenz-Workloads. Huang Renxun erklärte in seiner Rede stolz, dass dies die bislang leistungsstärkste KI-Chip-Serie sei.

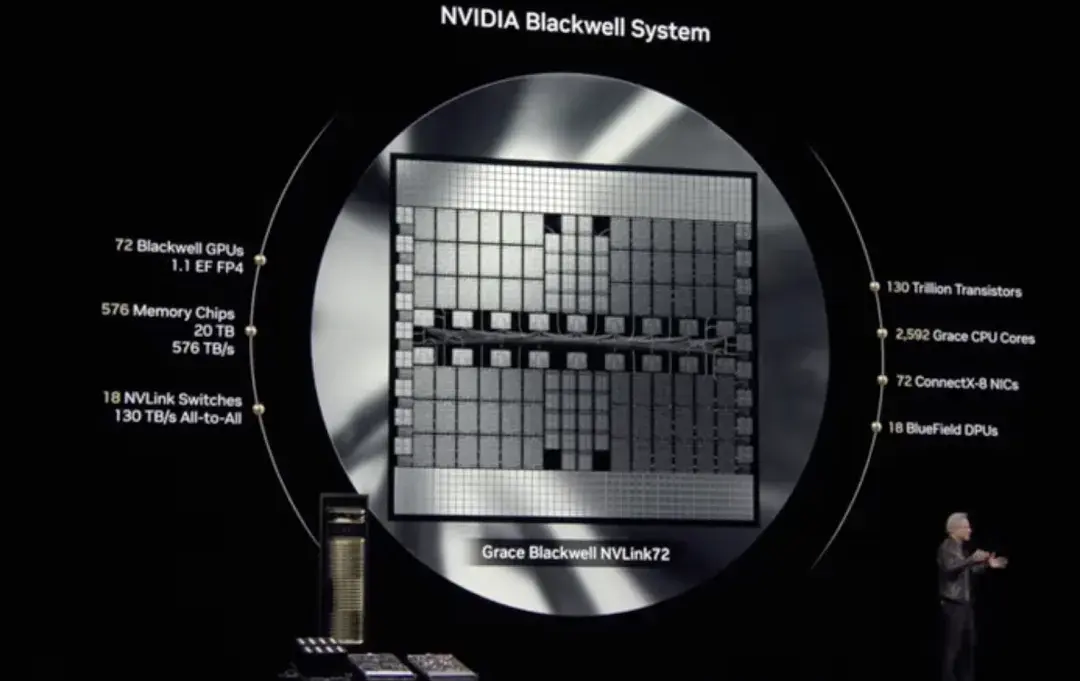

In der heutigen Live-Übertragung erwähnte Huang Renxun Blackwell erneut.Er sagte: „Die Vorteile von Blackwell sind, dass es schneller und größer ist, mehr Transistoren hat und über eine stärkere Rechenleistung verfügt.“ Darüber hinaus verbessert die verwendete NVL 72-Architektur und das FP4-Rechenpräzisionsmodell die Leistung von Blackwell weiter, was bedeutet, dass wir dieselben Rechenaufgaben mit weniger Energieverbrauch erledigen können.

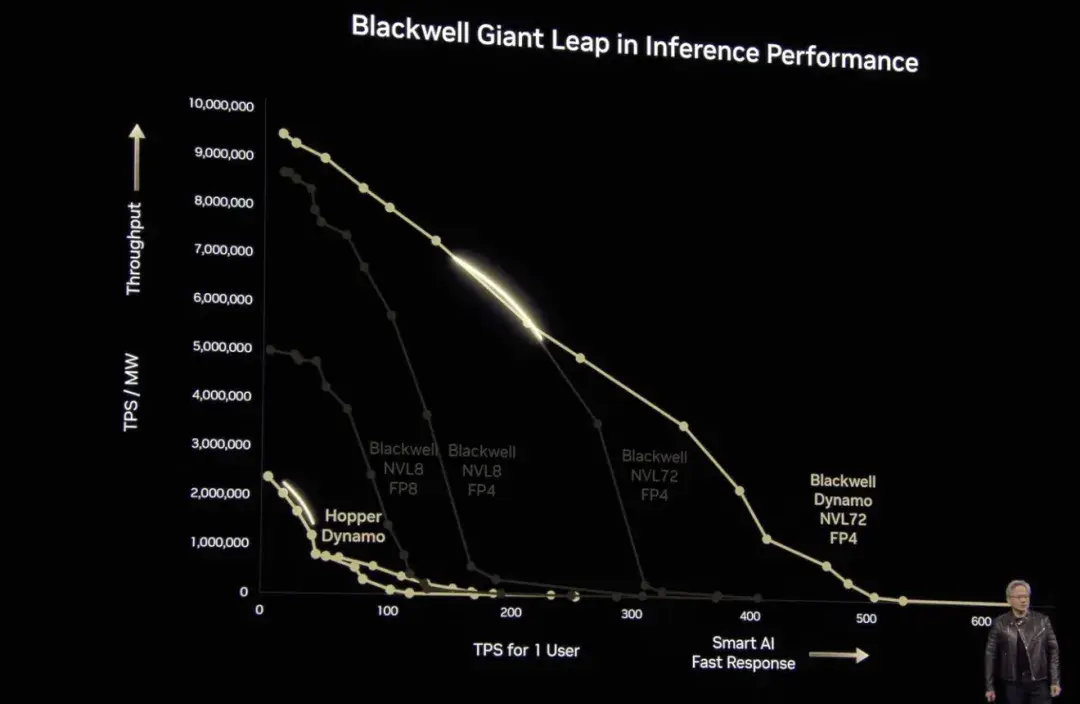

Es ist erwähnenswert, dass sich der Schwerpunkt des Marktes für künstliche Intelligenz nach dem Aufkommen von DeepSeek allmählich vom „Training“ auf die „Inferenz“ verlagert hat. Auf dieser Konferenz führte Huang Renxun insbesondere einen Fall eines Inferenzmodells an, um die Überlegenheit der Rechenleistung von Blackwell zu beweisen – sie sei 40-mal höher als die von Hopper. „Ich habe es schon einmal gesagt: Wenn Blackwell anfängt, sie in großen Mengen auszuliefern, werden Sie Hopper nicht einmal mehr auf den Markt bringen können.“ Natürlich erwähnte Huang Renxun auch, dass Blackwell voll in die Produktion investiert habe und die NVIDIA Blackwell AI-Fabrik in der zweiten Hälfte dieses Jahres erneut aufgerüstet werde.Und nahtloser Übergang zu Blackwell Ultra.

Blackwell Ultra wird die NVIDIA GB300 NVL72 Rack-Scale-Lösung enthalten und NVIDIA HGX B300 NVL16 System.

Erstens verwendet der NVIDIA GB300 NVL72 ein vollständig flüssigkeitsgekühltes Rack-Design, das 72 NVIDIA Blackwell Ultra GPUs und 36 Arm-basierte NVIDIA Grace™ CPU Integrieren Sie es in eine einzige Plattform, die für Scale-Out-Inferenz zur Testzeit optimiert ist. Im Vergleich zur vorherigen Generation NVIDIA GB200 NVL72 verfügt der GB300 NVL72 über die 1,5-fache KI-Leistung, kann mehrere Lösungen erkunden und komplexe Aufgaben in mehrere Schritte unterteilen, um qualitativ hochwertigere Antworten zu generieren.

Zweitens stellt NVIDIA HGX B300 NVL16 einen Durchbruch für die effiziente Verarbeitung komplexer Aufgaben wie KI-Argumentation dar. Im Vergleich zu Hopper erhöht es die Argumentationsgeschwindigkeit großer Sprachmodelle um das 11-fache, die Rechenleistung um das 7-fache und die Speicherkapazität um das 4-fache.

Zusammenfassend lässt sich sagen, dass Blackwell Ultra die erweiterte Inferenz während des Trainings und Tests verbessert und starke Unterstützung für Anwendungen wie beschleunigtes KI-Reasoning, KI-Agent und physische KI bietet.

Huang Renxun sagte hierzu: „Die KI-Technologie hat enorme Fortschritte gemacht und die Anforderungen an die Rechenleistung für logisches Denken und KI-Agenten sind deutlich gestiegen. Zu diesem Zweck haben wir Blackwell Ultra entwickelt – eine multifunktionale Plattform, die Aufgaben vor und nach dem Training sowie logisches Denken effizient ausführen kann.“

Nvidias GPU-Architektur der nächsten Generation Vera Rubin

Nvidia benennt seine Architekturen seit 1998 nach Wissenschaftlern und dieses Mal ist keine Ausnahme.Nvidias kommende GPU-Architektur der nächsten Generation, Vera Rubin, ist nach Vera Rubin benannt, der amerikanischen Astronomin, die die dunkle Materie entdeckte.

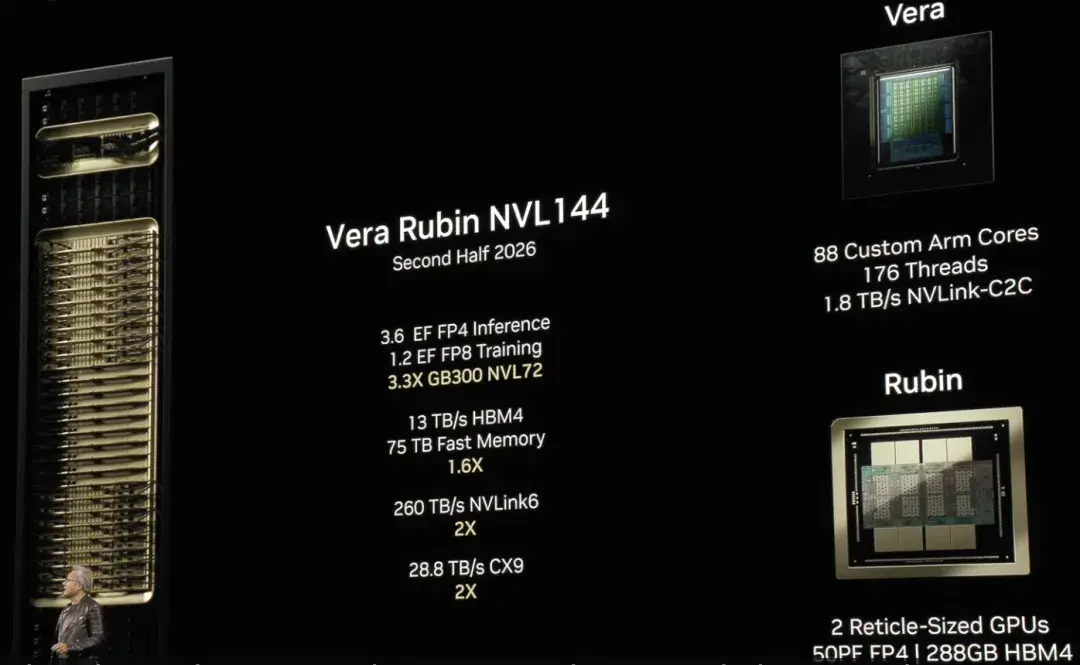

Vera Rubin hat erstmals die selbst entwickelte CPU- und GPU-Architektur umfassend integriert.Dies stellt einen weiteren Durchbruch für NVIDIA in der KI-Computerarchitektur dar und erweitert die Grenzen der KI-Computerleistung weiter.

„Im Grunde ist alles außer dem Chassis neu“, sagte Huang Renxun. Als erste vollständig unabhängig entwickelte CPU-Architektur von NVIDIA basiert Vera auf einem angepassten Arm-Kern. Es handelt sich um eine kleine CPU mit nur 50 Watt, aber mit größerem Speicher und höherer Bandbreite. Offiziellen Angaben von NVIDIA zufolge ist die Rechenleistung von Vera im Vergleich zu Grace Blackwell direkt um das Zweifache gesteigert. Darüber hinaus ist es auch stark für KI-Lasten optimiert. Durch die Optimierung des Befehlssatzes wird die Kommunikationslatenz erheblich reduziert, wodurch die Datenverarbeitung effizienter und reibungsloser wird und das Training und die Argumentation von KI stark unterstützt werden.

Gleichzeitig bringt die neue Rubin-GPU auch einen weiteren Sprung nach vorne im KI-Computing. Beim Ausführen mit Vera kann das Rubin-Inferenz-Computing 50 Petaflops erreichen, mehr als die doppelte Leistung vorhandener Blackwell-GPUs. Darüber hinaus unterstützt Rubin auch bis zu 288 GB Hochgeschwindigkeitsspeicher und stellt so sicher, dass KI-Training und -Argumentation große Datenmengen effizient verarbeiten können.

Huang Renxun gab außerdem bekannt, dass Vera Rubin NVL144 in der zweiten Hälfte des nächsten Jahres erhältlich sein wird.In der zweiten Hälfte des Jahres 2027 erwartet NVIDIA die Markteinführung von Vera Rubin Ultra, das die NVL576-Technologie verwendet und aus 2,5 Millionen Komponenten besteht. Jedes Rack verfügt über eine Leistung von bis zu 600 Kilowatt. Die Anzahl der Gleitkommaoperationen wird um das 14-fache auf 15 Exaflops erhöht, wodurch eine extreme Skalierbarkeit erreicht wird.

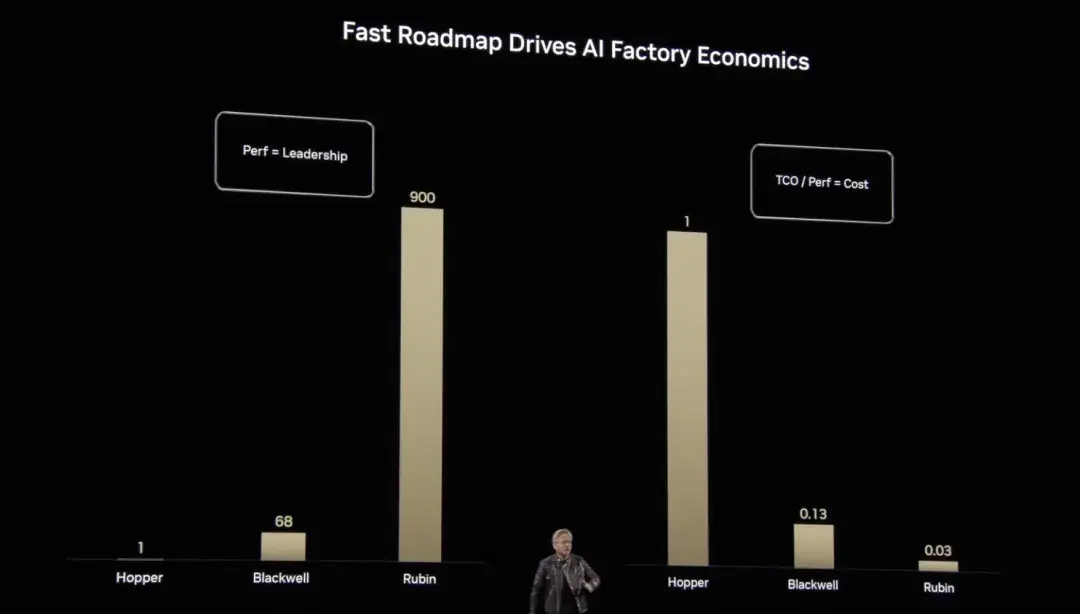

Von Grace Hopper über Blackwell bis hin zu Rubin hat uns Huang Renxun die enormen Fortschritte von NVIDIA in puncto Rechenleistung und Kostenoptimierung gezeigt.Im Vergleich zur Benchmark-Rechenleistung erreichen Hoppers vertikal erweiterte Gleitkommaoperationen das 1-Fache des Benchmarks, Blackwell steigert sie auf das 68-Fache und Rubin springt auf das 900-Fache und erreicht damit ein exponentielles Wachstum. Dieser Durchbruch reduziert nicht nur die Stückkosten der KI-Berechnung erheblich, sondern macht auch das Trainieren und Schlussfolgern komplexerer und umfangreicherer KI-Modelle effizient und durchführbar.

Nvidia wird umfassende Dienstleistungen für den Bau von KI-Fabriken anbieten

In den letzten Jahren hat sich der Schwerpunkt im KI-Bereich allmählich vom Training großer Modelle hin zur weit verbreiteten Anwendung von Inferenzmodellen verlagert. Inferenz ist zur zentralen Antriebskraft für das schnelle Wachstum der KI-Wirtschaft geworden. Dieser Wandel verändert nicht nur die Technologielandschaft, sondern bringt auch neue Anforderungen an die Computerinfrastruktur mit sich. Herkömmliche Rechenzentren sind nicht für das neue KI-Zeitalter ausgelegt. Um das Denken und den Einsatz von KI effizient zu fördern, werden KI-Fabriken (KI-Fabriken) entstand.

KI-Fabriken speichern und verarbeiten nicht nur Daten, sondern „produzieren auch Intelligenz“ im großen Maßstab, indem sie Rohdaten in Echtzeit-Erkenntnisse umwandeln. NVIDIA erklärte: „Investitionen in Unternehmen, die sich auf den Bau von KI-Fabriken spezialisiert haben, werden auf dem zukünftigen Markt die Führung übernehmen.“

Um diese Transformation zu unterstützen, hat NVIDIA die Bausteine für Full-Stack-KI-Fabriken geschaffen und stellt seinen Partnern die folgenden Schlüsselkomponenten zur Verfügung: Hochleistungs-Computerchips, fortschrittliche Netzwerktechnologien, Infrastrukturmanagement und Workload-Orchestrierung, das größte KI-Inferenz-Ökosystem, Speicher- und Datenplattformen, Design- und Optimierungs-Blueprints, Referenzarchitekturen und flexible Bereitstellungsmethoden.

Es besteht kein Zweifel, dass die Rechenleistung die tragende Säule von KI-Fabriken ist. Von Hopper- bis Blackwell-Architekturen bietet NVIDIA das leistungsstärkste beschleunigte Computing der Welt. Durch die auf Blackwell Ultra basierende GB300 NVL72-Rack-Level-Lösung können AI Factories eine bis zu 50-mal höhere KI-Inferenzleistung erzielen und eine beispiellose Leistungsunterstützung für die Verarbeitung komplexer Aufgaben bieten.