Command Palette

Search for a command to run...

Das QwQ-32B-Ein-Klick-Bereitstellungs-Tutorial Ist Online verfügbar. Die Leistung Ist Vergleichbar Mit Der Vollversion Von DeepSeek-R1.

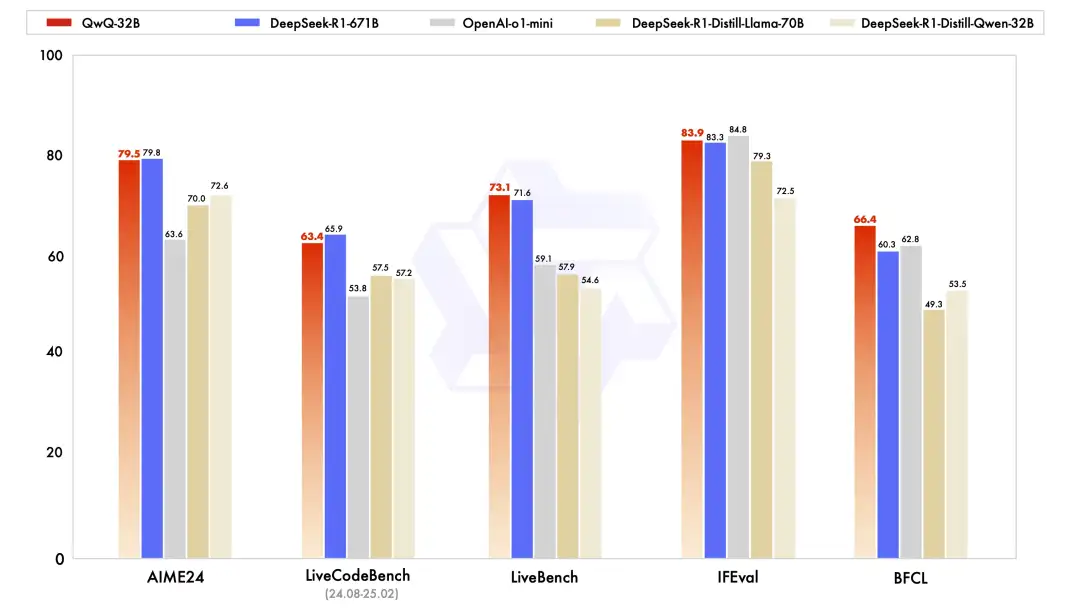

Gestern hat Alibaba Cloud plötzlich einen großen Schritt gewagt und ein neues Schlussfolgerungsmodell, Tongyi Qianwen QwQ-32B, als Open Source veröffentlicht.Bei mehreren wichtigen Benchmarks übertraf es OpenAI-o1-mini mit 32 B-Parametern und war mit der Vollversion von DeepSeek-R1 mit 671 B-Parametern vergleichbar. QwQ-32B bietet nicht nur eine erstaunliche Leistung, sondern reduziert auch die Bereitstellungskosten erheblich, während gleichzeitig eine starke Leistung erhalten bleibt. Es kann auch lokal auf Grafikkarten der Verbraucherklasse eingesetzt werden, was es zu einem Musterbeispiel an Stärke und Kosteneffizienz macht.

Auf technischer Ebene verwendet QwQ-32B eine zweistufige, auf Kaltstart basierende Methode des bestärkenden Lernens. Die erste Phase konzentriert sich auf Mathematik- und Codeaufgaben und verwendet mathematische Prüfer und Code-Sandboxen, um sich auf die Verbesserung der logischen Denkfähigkeit des Modells zu konzentrieren.

In der zweiten Phase wird das traditionelle Belohnungsmodell durch einen Antwortüberprüfungsmechanismus ersetzt. Bei mathematischen Aufgabenstellungen erfolgt eine Rückmeldung auf Basis der Richtigkeit der Ergebnisse. Bei Programmieraufgaben wird eine Echtzeitauswertung durch Testfälle auf dem Server durchgeführt, um die allgemeinen Fähigkeiten zu verbessern. Darüber hinaus integriert QwQ-32B auch agentenbezogene Funktionen, sodass der Denkprozess basierend auf Umgebungsfeedback flexibel angepasst werden kann, was die Autonomie und Anpassungsfähigkeit des Modells erheblich verbessert.

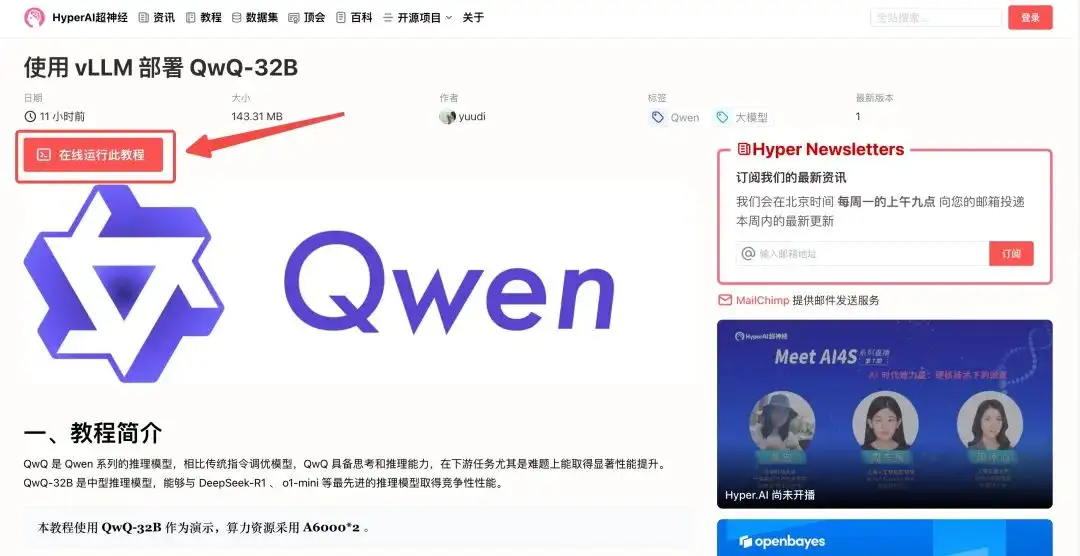

„Verwenden von vLLM zum Bereitstellen von QwQ-32B“ ist jetzt im Abschnitt „Tutorials“ der offiziellen Website von HyperAI verfügbar.Kleine Parameter und große Leistung, die darauf warten, von Ihnen überprüft zu werden!

Adresse des Tutorials:

Demolauf

1. Melden Sie sich bei hyper.ai an, wählen Sie auf der Tutorial-Seite „QwQ-32B mit vLLM bereitstellen“ aus und klicken Sie auf „Dieses Tutorial online ausführen“.

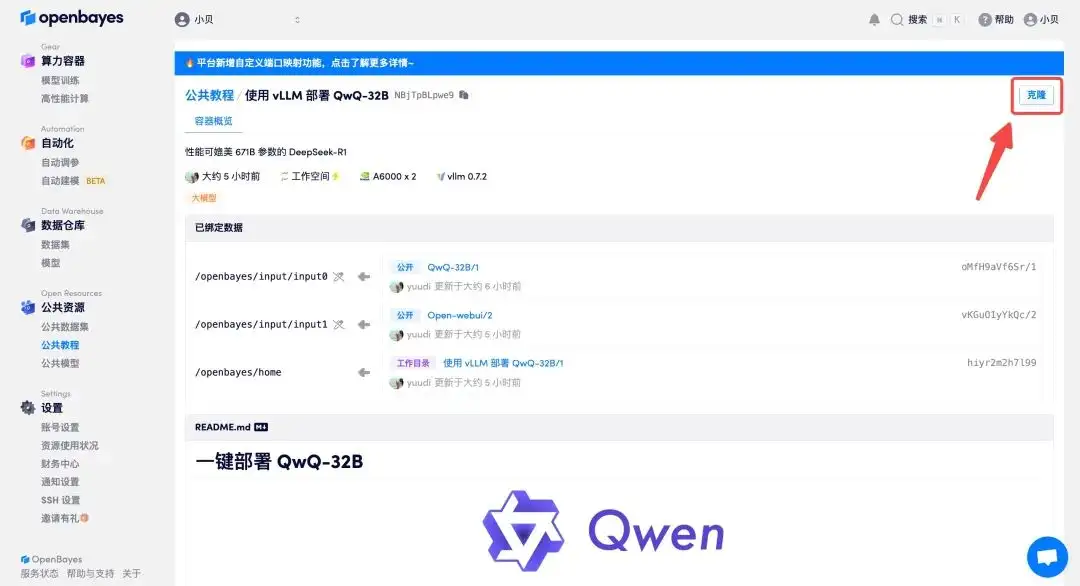

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

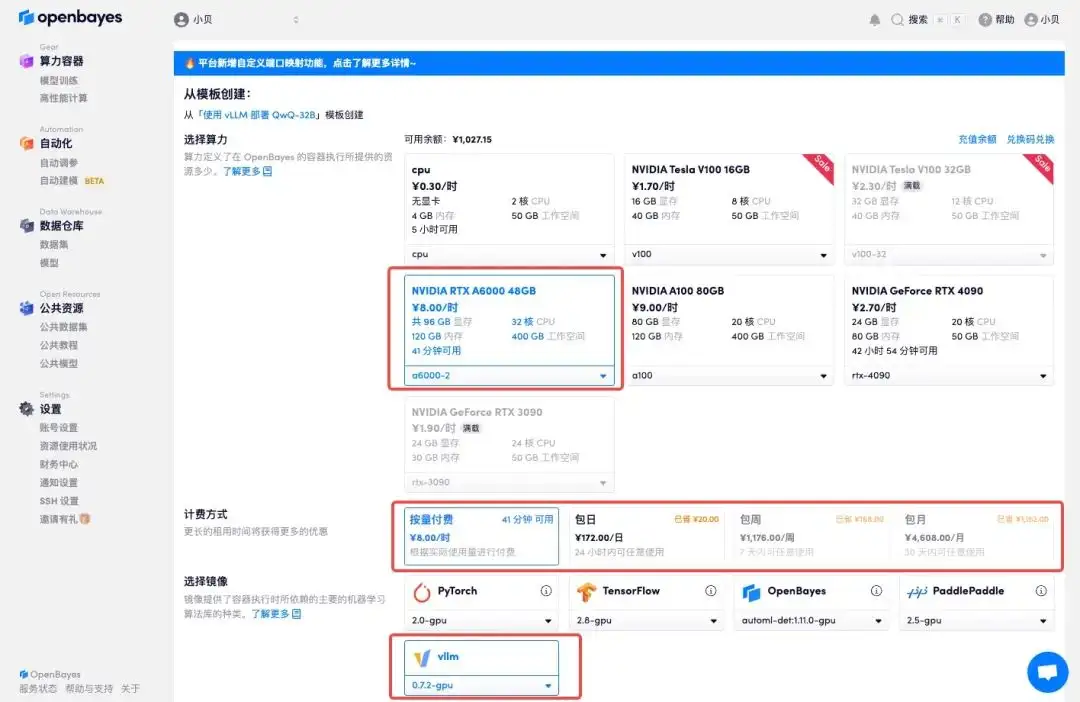

3. Wählen Sie die Bilder „NVIDIA A6000-2“ und „vllm“ aus. Die OpenBayes-Plattform hat eine neue Abrechnungsmethode eingeführt. Sie können je nach Bedarf zwischen „Pay as you go“ oder „Täglich/Wöchentlich/Monatlich“ wählen. Klicken Sie auf „Weiter“. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren, um 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit zu erhalten!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

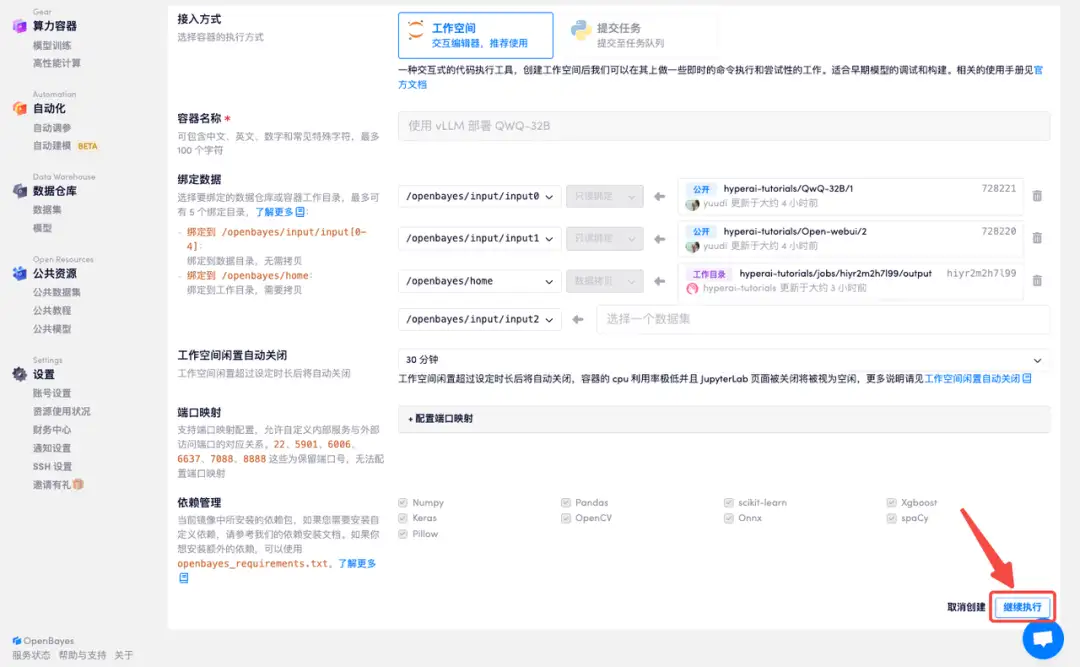

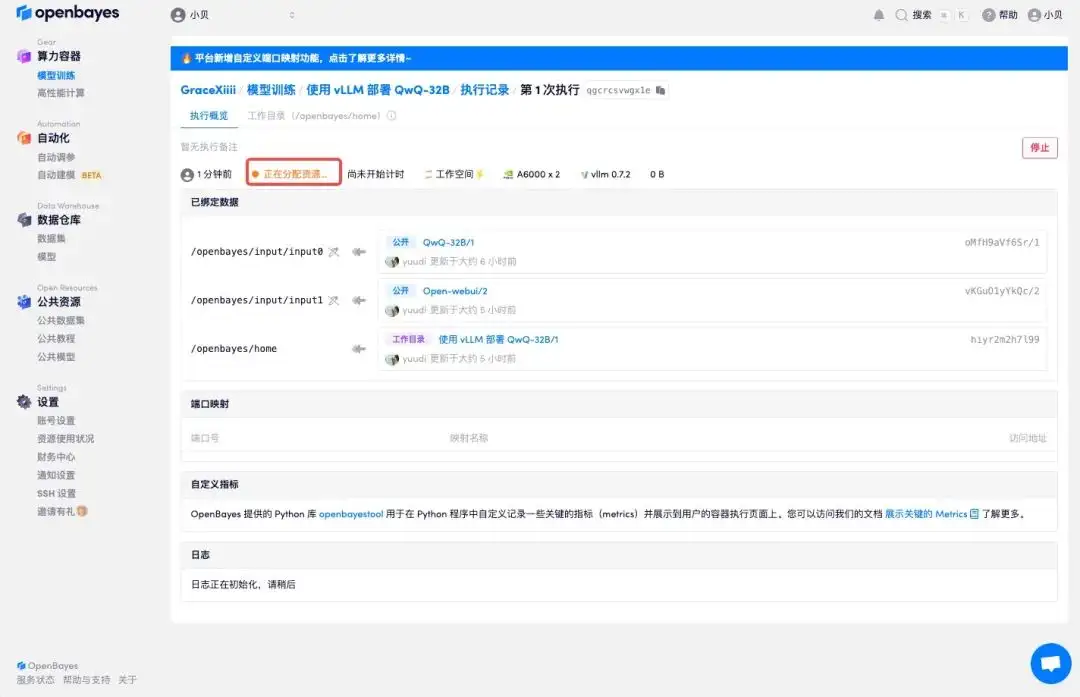

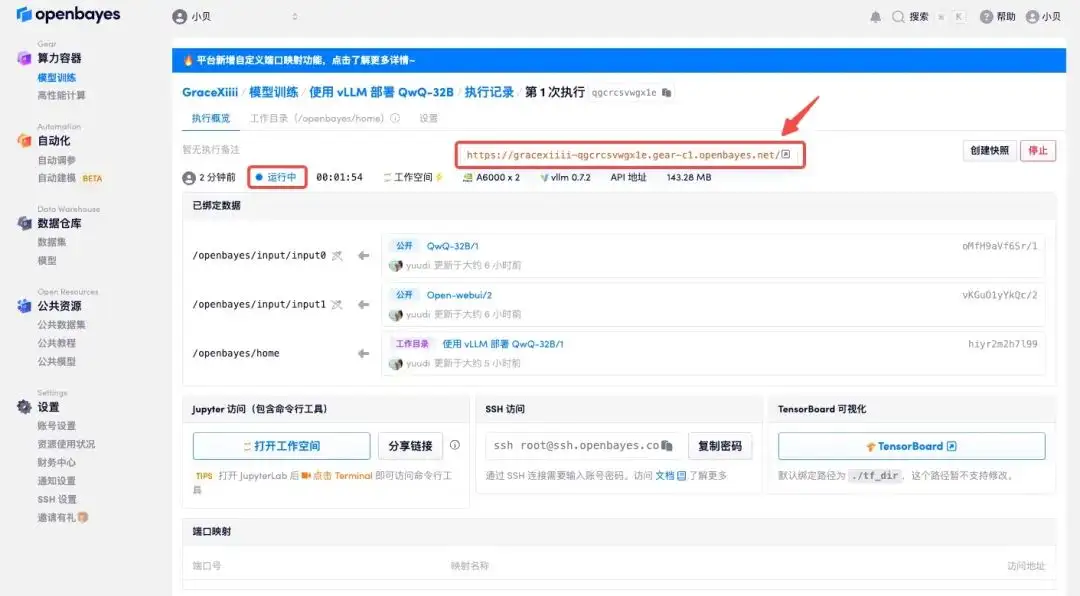

4. Warten Sie, bis die Ressourcen zugewiesen wurden. Der erste Klonvorgang dauert etwa 2 Minuten. Wenn sich der Status in „Läuft“ ändert, klicken Sie auf den Sprungpfeil neben „API-Adresse“, um zur Demoseite zu springen. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresszugriffsfunktion eine Echtnamenauthentifizierung durchführen müssen.

Effektanzeige

1. Im Internet wird viel darüber diskutiert, was besser ist, QwQ-32B oder DeepSeek. Fragen wir QwQ-32B und sehen wir, was es antwortet.

2. Es ist ersichtlich, dass QwQ-32B einen vollständigen Denkprozess demonstriert und objektive Analysen aus mehreren Blickwinkeln liefert.