Command Palette

Search for a command to run...

Der Größte Open-Source-Roboterdatensatz! DeepMind Hat Sich Mit 21 Institutionen Zusammengetan, 60 Datensätze Integriert Und Open X-Embodiment Veröffentlicht Und Damit Die Ära Der Verkörperten Intelligenz eingeläutet.

Kürzlich ging im Internet ein Video viral, in dem ein „Roboterhund als Träger auf dem Berg Tai fungiert“.Dieser „Roboterhund“ kann nicht nur mühelos schwere Lasten tragen, sondern auch die steilen Bergstraßen des Mount Tai „zügig bewältigen“ und den Gipfel vom Fuß des Berges aus in nur zwei Stunden erreichen! Auch der chinesische Vize-Außenminister Hua Chunying lobte ihn: „Der Roboterhund fungiert als Träger auf dem majestätischen Berg Tai und die Technologie kommt der Menschheit zugute.“

Es wird davon ausgegangen, dass die Hauptaufgabe dieses Roboterhundes, der von der Immobilienfirma Taishan Cultural Tourism Group eingeführt wurde, darin besteht, Müll zu beseitigen und Güter zu transportieren. Aufgrund der besonderen Geländebeschaffenheit des malerischen Gebiets um den Mount Tai konnte die Müllbeseitigung in der Vergangenheit nur per Hand durchgeführt werden. In Spitzenzeiten des Passagieraufkommens war es oft unmöglich, den Müll zu beseitigen und abzutransportieren. Der am Test teilnehmende „Roboterhund“ verfügt nicht nur über eine starke Geländeanpassungsfähigkeit, hohe Stabilität und ein hohes Gleichgewichtsvermögen, sondern kann auch Hindernisse problemlos überwinden. Seine Tragfähigkeit kann 120 Kilogramm erreichen, was das Problem der Müllentsorgung lösen und die Arbeitseffizienz verbessern kann.

Google RT-2, NVIDIA GR00T, Abbildung 02-Roboter, Tesla Optimus, Xiaomi CyberOne … In den letzten Jahren ist mit dem Aufkommen von immer mehr Robotern auch die verkörperte Intelligenz, die diese Roboter als Träger nutzt, zu einem heißen Thema geworden.Diese Roboter, die ihre Umgebung wahrnehmen, lernen und mit ihr interagieren und direkt am realen Leben der Menschen teilnehmen können, haben großes Marktpotenzial.

Ob Inspektion, Schweißen, Handhabung, Sortierung und Montage im industriellen Bereich, Haushaltsdienste und Altenpflege im häuslichen Bereich, chirurgische Assistenz und tägliche Pflege im medizinischen Bereich oder Pflanzen, Düngen und Ernten in der Landwirtschaft – die Anwendungsszenarien verkörperter Intelligenz sind breit gefächert und vielfältig.

Obwohl aktuelle Roboter bei bestimmten spezifischen Aufgaben gute Leistungen erbringen, mangelt es ihnen immer noch an Vielseitigkeit, was bedeutet, dass wir für jede Aufgabe, jeden Roboter und sogar jedes Anwendungsszenario ein Modell trainieren müssen. Aufbauend auf erfolgreichen Erfahrungen in Bereichen wie der Verarbeitung natürlicher Sprache und der Computervision können wir Roboter möglicherweise zu allgemeineren Fähigkeiten erziehen, indem wir ihnen ermöglichen, aus umfangreichen und vielfältigen Datensätzen zu lernen. Aber,Vorhandene Robotik-Datensätze konzentrieren sich häufig auf eine einzelne Umgebung, eine Reihe von Objekten oder eine bestimmte Aufgabe. Große und vielfältige Datensätze zur Roboterinteraktion sind schwer zu erhalten.

Als Reaktion darauf hat sich Google DeepMind mit 21 international renommierten Institutionen zusammengetan, darunter der Stanford University, der Shanghai Jiaotong University, NVIDIA, der New York University, der Columbia University, der University of Tokyo, RIKEN, der Carnegie Mellon University, der ETH Zürich und dem Imperial College London, um 60 vorhandene Roboterdatensätze zu integrieren.Erstellt einen offenen, groß angelegten, standardisierten Datensatz zum Roboterlernen – Open X-Embodiment.

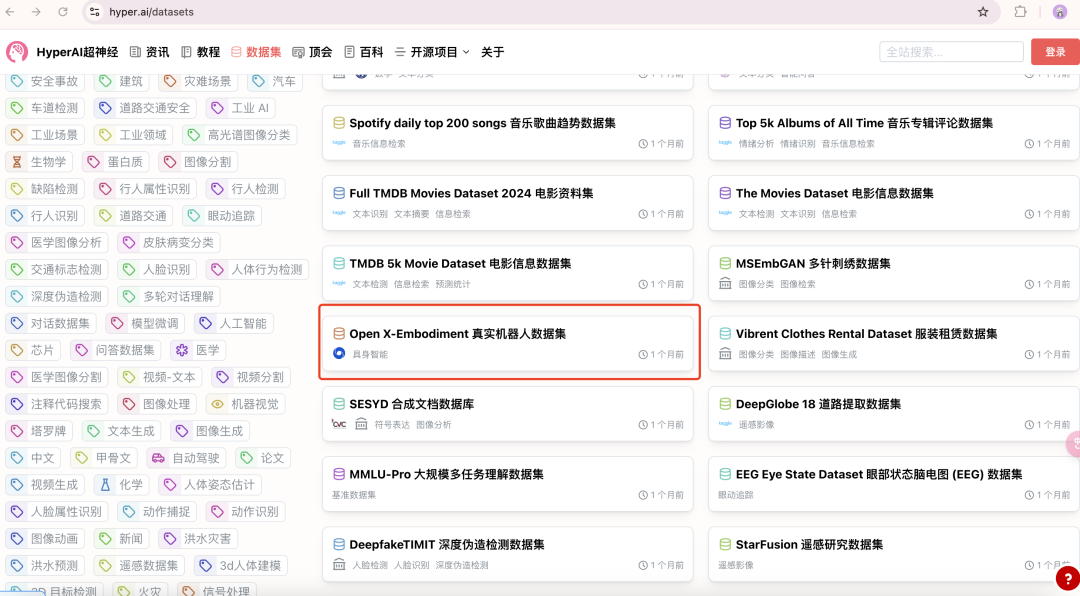

Es wird davon ausgegangen, dass der Open X-Embodiment-Datensatz verschiedene Umgebungen und Roboteränderungen abdeckt und derzeit der Forschungsgemeinschaft zugänglich ist. Um den Benutzern das Herunterladen und Verwenden zu erleichtern, konvertierten die Forscher Datensätze aus verschiedenen Quellen in ein einheitliches Datenformat. Für die Zukunft ist eine Zusammenarbeit mit der Robot-Learning-Community geplant, um gemeinsam das Wachstum dieses Datensatzes voranzutreiben. HyperAI hat auf seiner offiziellen Website den „Open X-Embodiment Real Robot Dataset“ veröffentlicht, der mit einem Klick heruntergeladen werden kann!

Öffnen Sie den X-Embodiment Real Robot Dataset:

https://go.hyper.ai/JAeHn

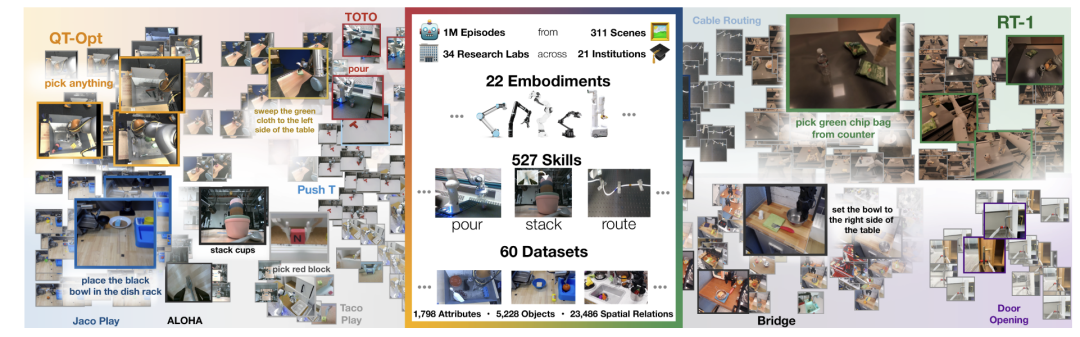

Der bislang größte Open-Source-Robotik-Datensatz

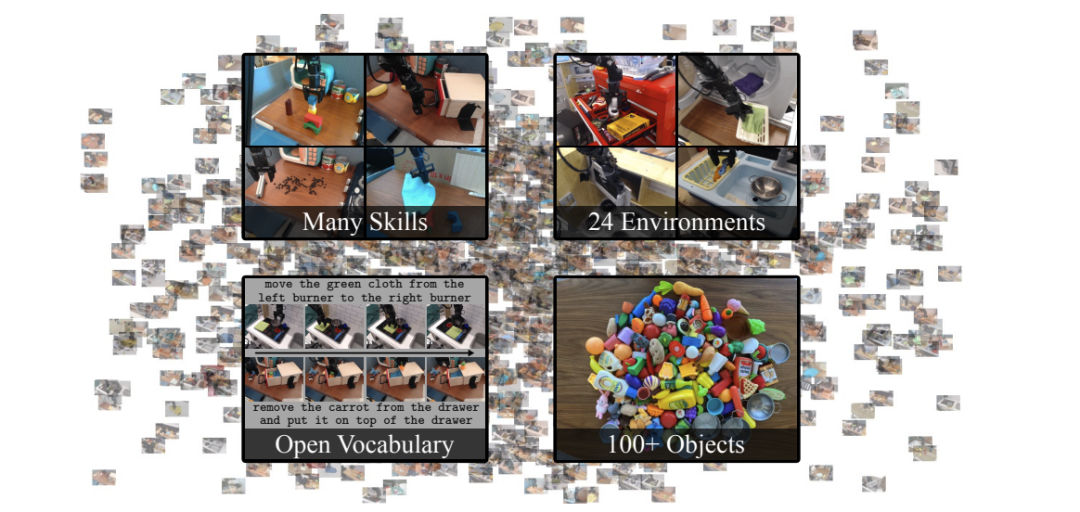

Berichten zufolge handelt es sich bei Open X-Embodiment um den bislang größten Open-Source-Datensatz zu echten Robotern.Es umfasst 22 verschiedene Robotertypen, vom Einarmroboter über den Zweiarmroboter bis zum Vierbeiner, mit insgesamt mehr als 1 Million Roboterbahnen und 527 Fähigkeiten (160.266 Aufgaben). Die Forscher zeigten, dass Modelle, die mit Daten mehrerer Robotertypen trainiert wurden, bessere Leistungen erbrachten als Modelle, die mit Daten nur eines einzigen Robotertyps trainiert wurden.

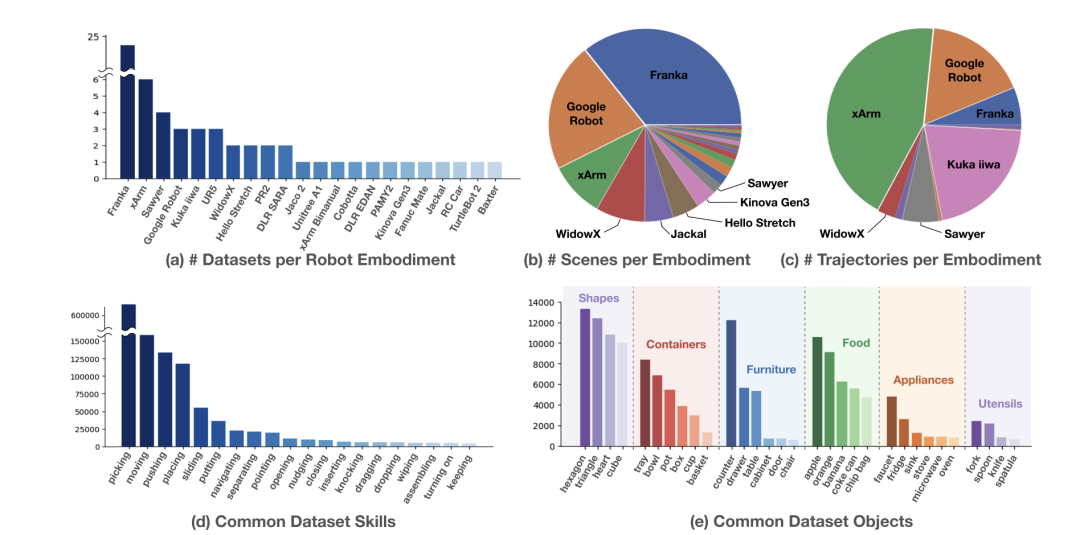

Die Verteilung des Open X-Embodiment-Datensatzes ist in der folgenden Abbildung dargestellt.Abbildung (a) zeigt die Verteilung von 22 Robotermorphologie-Datensätzen, unter denen der Franka-Roboter am häufigsten vorkommt. Abbildung (b) zeigt die Verteilung der Roboter in verschiedenen Szenarien, wobei der Franka-Roboter dominiert, gefolgt vom Google-Roboter. Abbildung (c) zeigt die Verteilung der Trajektorien jeder Robotermorphologie, wobei xArm und Google Robot die größte Anzahl an Trajektorien beitragen. Die Abbildungen (d, e) zeigen jeweils die Fähigkeiten, die der Roboter besitzt und die Objekte, die er verwendet. Zu den Fähigkeiten gehören Aufnehmen, Bewegen, Schieben, Platzieren usw. und zu den Objekten gehören Haushaltsgeräte, Lebensmittel, Geschirr usw., die unterschiedlicher Art sind.

Bündelung der besten institutionellen Ressourcen zur Förderung der breiten Anwendung der Robotertechnologie

Der Open X-Embodiment-Datensatz besteht aus 60 unabhängigen Datensätzen.HyperAI hat speziell für Sie einige Datensätze ausgewählt, die im Folgenden kurz vorgestellt werden:

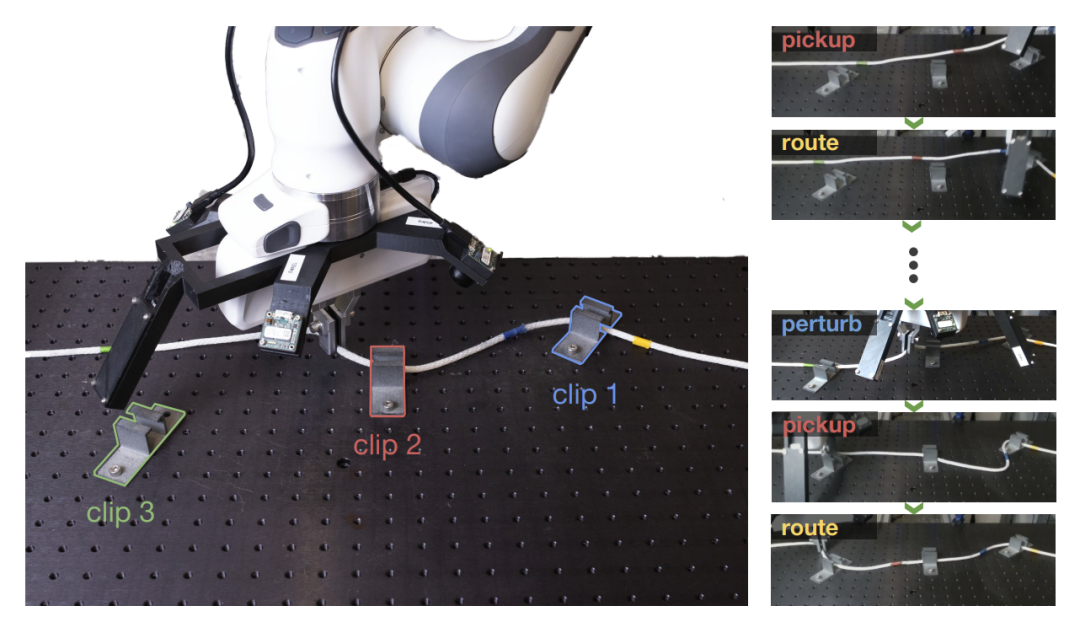

Berkeley Cable Routing – Mehrstufiger Datensatz für die robotergestützte Kabelführungsaufgabe

Der Berkeley Cable Routing-Datensatz wurde von der University of California, Berkeley und dem Forschungsteam von Intrinsic Innovation LLC veröffentlicht. Es ist insgesamt 27,92 GB groß und wird zum Studium mehrstufiger Robotermanipulationsaufgaben verwendet.Wird insbesondere für Kabelführungsaufgaben verwendet.Diese Aufgabe stellt ein komplexes mehrstufiges Robotermanipulationsszenario dar, bei dem der Roboter ein Kabel durch eine Reihe von Klemmen fädeln, verformbare Objekte handhaben, eine visuelle Wahrnehmungsschleife schließen und erweiterte Verhaltensweisen verarbeiten muss, die aus mehreren Schritten bestehen.

Direkte Verwendung:https://go.hyper.ai/igi9x

CLVR Jaco Play-Datensatz Fernbedienungsroboter-Clip-Datensatz

CLVR Jaco Play Dataset ist ein Datensatz, der sich auf den Bereich der ferngesteuerten Roboter konzentriert.Es ist insgesamt 14,87 GB groß, wurde von einem Forschungsteam der University of Southern California und KAIST veröffentlicht und bietet 1.085 Clips des ferngesteuerten Roboters Jaco 2 mit entsprechenden Sprachanmerkungen. Dieser Datensatz ist eine wertvolle Ressource für Wissenschaftler und Entwickler, die in Bereichen wie Roboterfernsteuerung, Verarbeitung natürlicher Sprache und Mensch-Computer-Interaktion arbeiten.

Direkte Verwendung:https://go.hyper.ai/WPxG8

RT-1 Roboteraktion Real World Robot Dataset

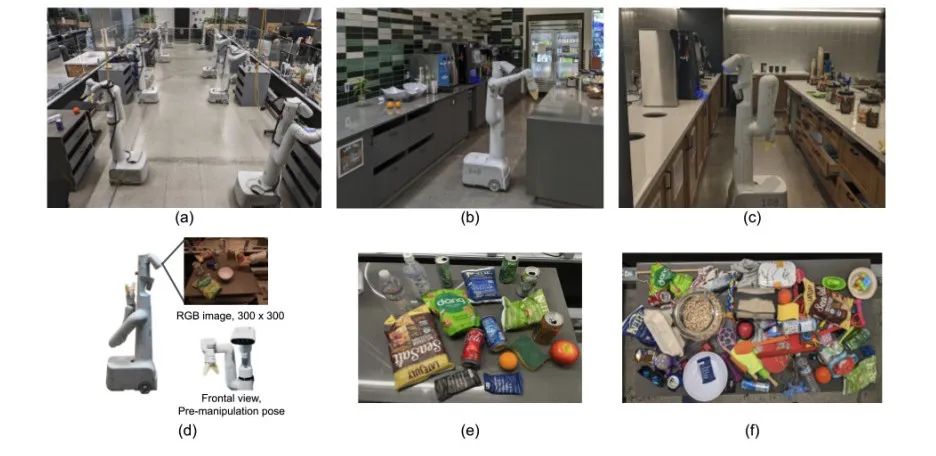

Google-Forscher schlugen das Multitasking-Modell Robotics Transformer (RT-1) vor, das erhebliche Verbesserungen bei der Zero-Shot-Generalisierung auf neue Aufgaben, Umgebungen und Objekte erzielte und eine hervorragende Skalierbarkeit sowie vortrainierte Modelleigenschaften aufwies.

Das RT-1-Modell wurde anhand eines umfangreichen realen Robotik-Datensatzes (RT-1 Robot Action Dataset) trainiert. Dabei kamen 13 EDR-Roboterarme zum Einsatz, die jeweils mit einem 7-DOF-Arm, einem Zwei-Finger-Greifer und einer mobilen Basis ausgestattet waren.In 17 Monaten wurden 130.000 Clips gesammelt.Insgesamt 111,06 GB, jedes Fragment ist mit einer Textbeschreibung der Ausführungsanweisungen des Roboters versehen. Zu den im Datensatz behandelten anspruchsvollen Fertigkeiten gehören das Aufheben und Platzieren von Gegenständen, das Öffnen und Schließen von Schubladen, das Herausnehmen und Einlegen von Gegenständen in Schubladen, das Aufrichten langer und dünner Gegenstände, das Umstoßen von Gegenständen, das Herausziehen von Servietten und das Öffnen von Gläsern.Es werden über 700 Aufgaben mit unterschiedlichsten Objekten abgedeckt.

Direkte Verwendung:https://go.hyper.ai/V9gL0

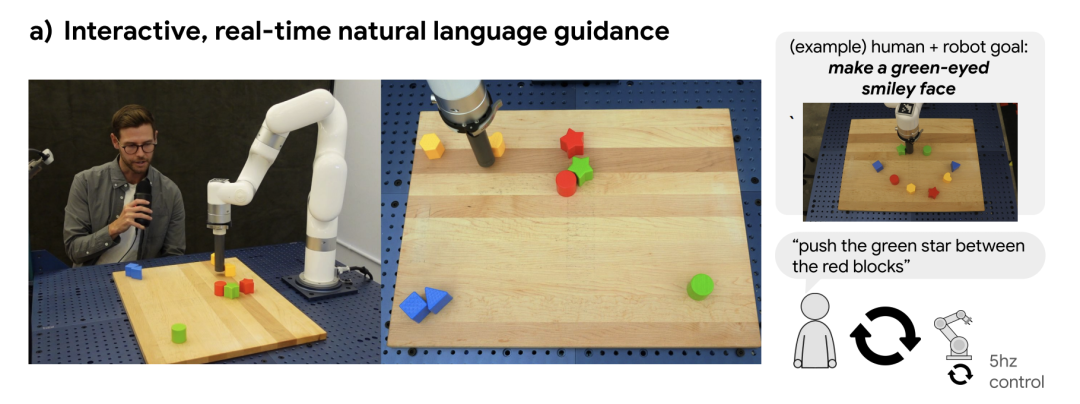

Language-Table Roboter-Sprachbezeichnungs-Trajektorien-Datensatz

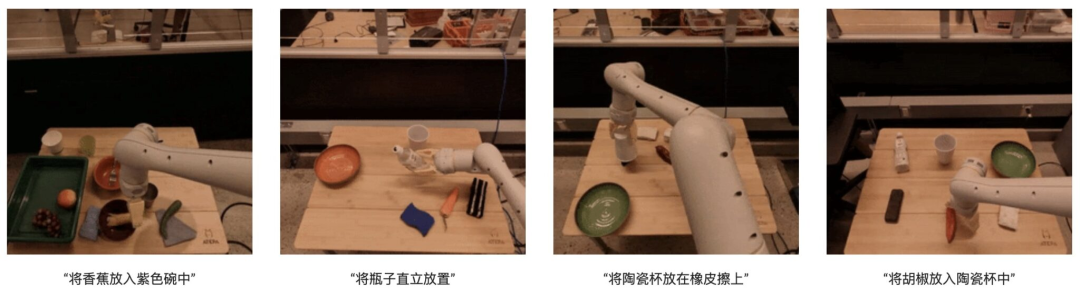

Das Team „Robotics at Google“ hat ein Framework für den Bau von Robotern vorgeschlagen, die mithilfe natürlicher Sprachanweisungen in Echtzeit in der realen Welt interagieren können. Durch Training mit einem Datensatz aus Hunderttausenden sprachlich annotierter Trajektorien stellten die Forscher fest, dass die resultierende Richtlinie zehnmal mehr Anweisungen ausführen konnte als zuvor möglich und so reale audiovisuelle und motorische Fertigkeiten von Anfang bis Ende beschrieb. Die Forscher haben den in ihrer Studie verwendeten Language-Table-Datensatz als Open Source zur Verfügung gestellt.Der Datensatz enthält fast 600.000 Trajektorien mit Sprachbezeichnungen.Wird verwendet, um die Entwicklung fortschrittlicherer, leistungsfähigerer Roboter zu fördern, die mit natürlicher Sprache interagieren können.

Direkte Verwendung:https://go.hyper.ai/9zvRk

BridgeData V2 – Großer Roboterlerndatensatz

UC Berkeley, Stanford University, Google DeepMind und CMU haben gemeinsam den BridgeData V2-Datensatz veröffentlicht, der der Förderung skalierbarer Robotikforschung dient.Enthält 60.096 Robotertrajektorien, die in 24 verschiedenen Umgebungen gesammelt wurden.Darunter sind 24 Umgebungen in 4 Kategorien unterteilt. Die meisten Daten stammen aus verschiedenen Spielzeugküchen mit Spülbecken, Herden, Mikrowellen usw. Die übrigen Umgebungen umfassen verschiedene Schreibtische, Spielzeugwaschbecken, Spielzeugwaschküchen usw. Die im Datensatz enthaltenen Aufgaben sind Aufnehmen und Platzieren, Schieben und Fegen, Öffnen und Schließen von Türen und Schubladen sowie komplexere Aufgaben wie das Stapeln von Bauklötzen, Wäschefalten und Fegen von körnigen Medien, wobei einige Datenschnipsel eine Kombination dieser Fähigkeiten enthalten.

Um die Generalisierungsfähigkeit des Roboters zu verbessern, sammelten die Forscher eine große Menge an Aufgabendaten in verschiedenen Umgebungen mit unterschiedlichen Objekten, Kamerapositionen und Arbeitsbereichspositionierungen.Jede Flugbahn wird von Anweisungen in natürlicher Sprache begleitet, die der Aufgabe des Roboters entsprechen.Die aus diesen Daten gewonnenen Erkenntnisse können auf neue Objekte und Umgebungen angewendet und sogar institutionenübergreifend genutzt werden, was diesen Datensatz zu einer großartigen Ressource für Forscher macht.

Direkte Verwendung:https://go.hyper.ai/mGXA1

BC-Z Roboter-Lerndatensatz

Der BC-Z-Datensatz wurde gemeinsam von Google, Everyday Robots, der University of California, Berkeley und der Stanford University veröffentlicht. Dieser groß angelegte Datensatz zum Roboterlernen soll die Entwicklung des Bereichs des Roboter-Imitationslernens fördern, insbesondere um die Generalisierung von Aufgaben ohne Stichproben zu unterstützen, d. h., um Robotern zu ermöglichen, durch Imitationslernen neue Betriebsaufgaben ohne vorherige Erfahrung auszuführen.

Der Datensatz enthält mehr als 25.877 verschiedene Betriebsaufgabenszenarien und deckt 100 unterschiedliche Aufgaben ab.Diese Aufgaben wurden durch Experten-Teleoperation und geteilte Autonomieprozesse erfasst, an denen 12 Roboter und 7 Bediener beteiligt waren, wodurch sich eine Roboterbetriebszeit von 125 Stunden ergab. Der Datensatz kann zum Trainieren einer 7-DOF-Multitasking-Richtlinie verwendet werden, die so angepasst werden kann, dass bestimmte Aufgaben basierend auf einer verbalen Beschreibung der Aufgabe oder einem Video einer Person, die die Aufgabe ausführt, ausgeführt werden.

Direkte Verwendung:https://go.hyper.ai/MdnFu

Oben sind die von HyperAI in dieser Ausgabe empfohlenen Datensätze. Wenn Sie hochwertige Datensatzressourcen sehen, können Sie uns gerne eine Nachricht hinterlassen oder einen Artikel einreichen, um uns davon zu berichten!

Weitere hochwertige Datensätze zum Download:https://go.hyper.ai/P5Mtc