Command Palette

Search for a command to run...

Llama 3.2 Ist Da, Multimodal Und Open Source! Huang Renxun Ist Der Erste, Der Eine AR-Brille Ausprobiert, Und Der Preis Für Das Quest 3S-Headset Ist Lächerlich Niedrig

Wenn OpenAIs ChatGPT den „100 Model Wars“ auslöste,Die Ray-Ban Meta Smart Glasses von Meta sind zweifellos der Auslöser des „Kriegs der hundert Spiegel“.Seit seinem Debüt auf der Meta Connect 2023 Developer Conference im vergangenen September hat sich Ray-Ban Meta in nur wenigen Monaten über eine Million Mal verkauft, nicht nurMark ZuckerbergEs wurde „Amazing“ genannt und veranlasste große in- und ausländische Unternehmen wie Google, Samsung und ByteDance, in den Markt einzusteigen!

Ein Jahr später stellte Meta auf der Connect Developer Conference erneut ein neues Smart-Glasses-Produkt vor: Orion.Dies ist die erste holografische AR-Brille des Unternehmens.Zuckerberg bezeichnete sie als die fortschrittlichste Brille der Welt, die die Art und Weise verändern werde, wie Menschen in Zukunft mit der Welt interagieren.

Darüber hinaus stellt Meta wie üblich neue Quest-Headset-Produkte auf der Connect-Konferenz vor, und dieses Jahr ist da keine Ausnahme. Angesichts der Veröffentlichung von Meta im letzten Jahr Aufgabe 3 Nutzer bemängeln generell, dass der Preis zu hoch sei.In diesem Jahr hat Meta mit dem Quest 3S ein neues Headset auf den Markt gebracht, das eine ähnliche Leistung wie das Quest 3 bietet, aber günstiger ist.Dieses Headset gilt als das beste Mixed-Reality-Gerät auf dem heutigen Markt und bietet ein hervorragendes Hyper-Reality-Erlebnis.

Natürlich wurde auch das Llama-Modell, eine der mit Spannung erwarteten Kerntechnologien von Meta, auf dieser Pressekonferenz einem umfassenden Update unterzogen.Multimodalität Llama 3.2 kann sowohl Bilder als auch Text verstehen und Mobiltelefone können auch große Modelle ausführen, was seinem Open-Source-Ökosystem weitere Vorteile verleiht.

Metas AR-Traum wird wahr, Orion-Brillen eröffnen eine neue Ära der Interaktion

Im April dieses Jahres veröffentlichte Meta anlässlich des 10-jährigen Jubiläums von Reality Labs einen Artikel, in dem die Entwicklungsgeschichte der Abteilung skizziert und eine Vorschau auf ihr nächstes Kernprodukt gegeben wurde – die erste AR-Brille. Meta sagte, dass Quest 3 den Benutzern eine immersive Interaktion mit digitalen Inhalten in der physischen Welt ermöglicht, Ray-Ban Meta-Brillen den Benutzern ermöglichen, die Funktionalität und Unterhaltung von Meta AI zu genießen, und die neuen AR-Brillen die Vorteile beider Technologien kombinieren werden, um die beste technologische Fusion zu erreichen.

Mit der bevorstehenden Meta Connect 2024 spekulieren immer mehr Stimmen auf dem Markt, dass diese AR-Brille auf dieser Konferenz vorgestellt wird. Wie erwartet,Heute hat Meta seine erste AR-Brille, Orion, herausgebracht.

Zuckerberg sagte, dass Orion sich dafür einsetzt, die Art und Weise zu ändern, wie Menschen mit der Welt interagieren. Es handelt sich um die fortschrittlichste AR-Brille aller Zeiten und ihre Entwicklung dauerte 10 Jahre. Es verfügt über das fortschrittlichste AR-Display, maßgeschneiderte Siliziumchips, Siliziumkarbidlinsen, komplexe Wellenleiter, uLED-Projektoren usw.Eine Kombination von Technologien ermöglicht die Ausführung leistungsstarker AR-Erlebnisse auf einer Brille und verbraucht dabei nur einen Bruchteil der Leistung und des Gewichts eines MR-Headsets.

Einfach ausgedrückt:Diese AR-Brille verwendet eine neue Displayarchitektur.verwendenPico-ProjektorLicht wird in den Wellenleiter projiziert, und dann verschiedene Tiefen und Größen vonHologrammDie Welt wird vor dem Benutzer projiziert und von einer Batterie im Bügel der Brille mit Strom versorgt. Möchte sich der Nutzer beispielsweise mit weit entfernten Freunden treffen, erscheinen diese als Hologramme im Wohnzimmer, als wären sie wirklich da.

Erwähnenswert ist, dass Orion 7 in den Rahmenrand eingelassen hat.Mini-Kameraund Sensoren, kombiniert mit Sprach-, Augen- und Gestenverfolgung, ausgestattet mit einem EMG-Armband, können Benutzer problemlos wischen, klicken und scrollen. Wenn Sie beispielsweise während Ihres morgendlichen Laufs ein Foto aufnehmen möchten, kann Orion den Moment mit nur einem Fingertipp einfrieren. Darüber hinaus können Sie mit nur einem Fingertipp Unterhaltung wie Kartenspiele, Schach oder holografisches Pingpong aufrufen.

Gründer und CEO von Nvidia Jen-Hsun HuangIch kann es kaum erwarten, es auszuprobieren!

Das beste Mixed-Reality-Gerät, Quest 3S, bietet ein hervorragendes Preis-Leistungs-Verhältnis

Nach der Ankündigung des weltweit ersten Mixed-Reality-Headsets Meta Quest 3 auf der Connect-Konferenz im letzten Jahr,Meta hat dieses Jahr eine optimierte Version von Quest 3 herausgebracht – Quest 3S.

Zuckerberg sagte:„Quest 3S bietet nicht nur ein hervorragendes Preis-Leistungs-Verhältnis, sondern ist auch das beste Mixed-Reality-Gerät, das Sie auf dem Markt kaufen können!“Es verfügt über ähnliche Kernfunktionen wie Quest 3, nämlich hochauflösende, vollfarbige Mixed Reality, die es Benutzern ermöglicht, „nahtlos“ zwischen der physischen und virtuellen Welt zu reisen und an einer Reihe von Aktivitäten wie Unterhaltung, Fitness, Spielen und sozialen Erlebnissen teilzunehmen. Der Unterschied besteht darin, dass Quest 3S über verbesserte Linsen und einen optimierten Technologie-Stack, eine optimierte Auflösung und Latenz verfügt und dass die Mixed-Reality-Handverfolgungssoftware eine bessere Leistung bietet.

Die Magie der Mixed Reality besteht darin, dass sie realistischen Raum inMetaverse, wodurch den Benutzern ein immersives Gefühl vermittelt wird und sie frei zwischen verschiedenen Erlebnissen wechseln können. Beispielsweise können Benutzer den Kinomodus wählen, um den Bildschirm auf Kinoniveau zu vergrößern und das beste Kinoerlebnis zu erzielen.

In einer Live-Demonstration zeigte Zuckerberg ein immersives Erlebnis von einer 2D-Mobil-App bis hin zu einem Remote-Desktop-PC, bei dem Benutzer den Bildschirm öffnen und an einer beliebigen Stelle platzieren können, um eine riesigeVirtuelle Anzeige, und erledigen Sie die Arbeit. Er erwähnte, dass Meta mit Microsoft an der Aktualisierung der Remotedesktopfunktion gearbeitet habe und dass es möglicherweise bald möglich sei, eine Verbindung zu Windows 11-Computern herzustellen.

Erwähnenswert ist, dass Meta Quest 3S ein hyperrealistisches Erlebnis zu einem unglaublichen Preis bietet, der bei nur 299,99 $ beginnt und am 15. Oktober erhältlich sein wird. Kaufen Sie diesen Herbst Quest 3S Benutzer erhalten außerdem ein kostenloses VR-Erlebnis für das Spiel Batman: Arkham Shadow.

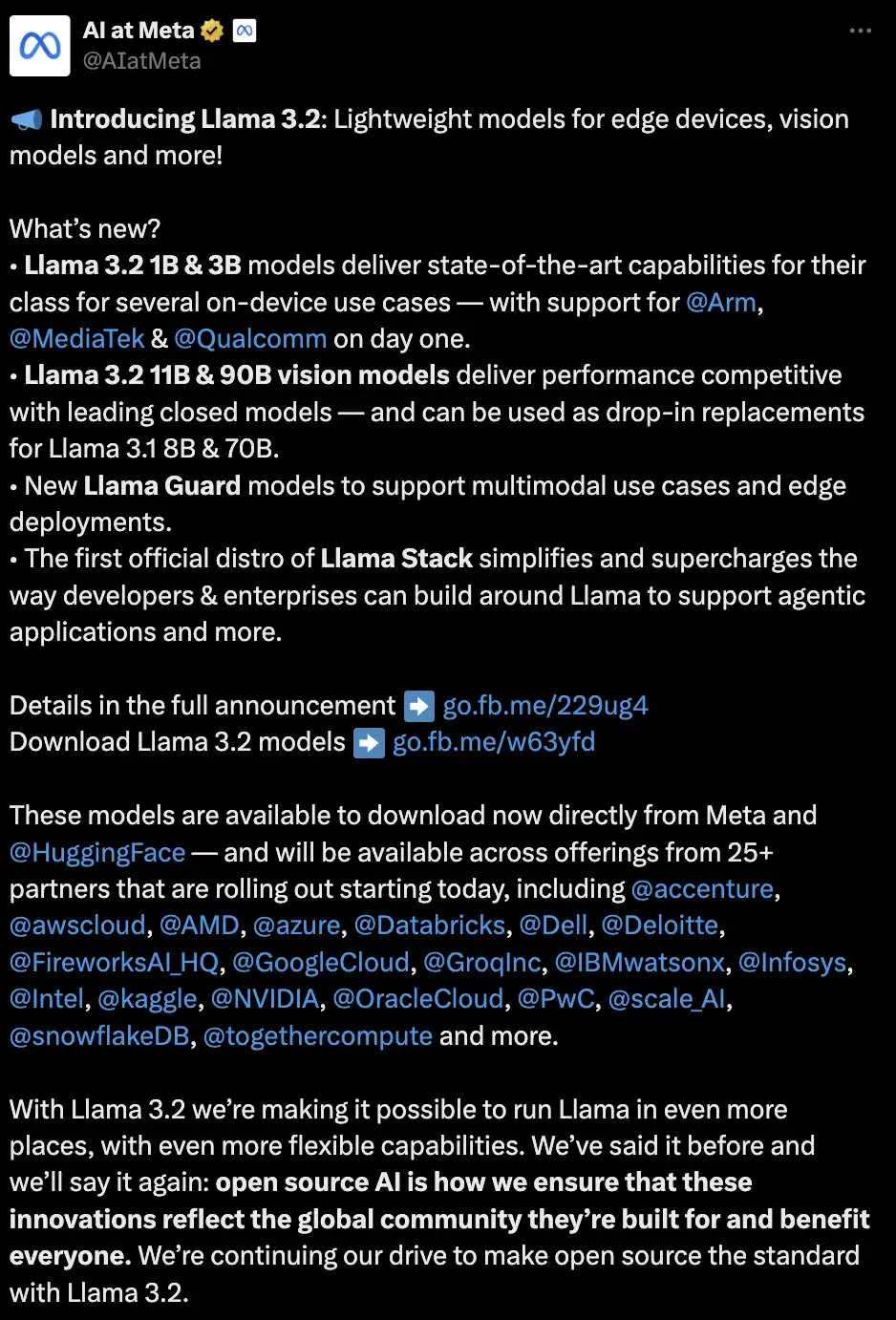

Das erste Llama-Modell zur Unterstützung visueller Aufgaben, multimodal und Open Source

Zusätzlich zur wichtigen Hardware-Version veröffentlichte Zuckerberg auch ein Update für Llama und brachte das Modell Llama 3.2 auf den Markt. Als erstes Llama-Modell, das Sehaufgaben unterstützt, kann Llama 3.2 sowohl Bilder als auch Text verstehen. Dazu gehören kleine und mittelgroße Vision-Modelle (11B und 90B) und leichte Klartextmodelle (1B und 3B), die für Edge- und Mobilgeräte geeignet sind. Beide Kategorien umfassen vortrainierte und hinsichtlich der Anweisungen optimierte Versionen. Es ist erwähnenswert, dass diese Modelle mit unterschiedlichen Spezifikationen über Meta AI ausprobiert werden können.

Bewertung der Modellleistung

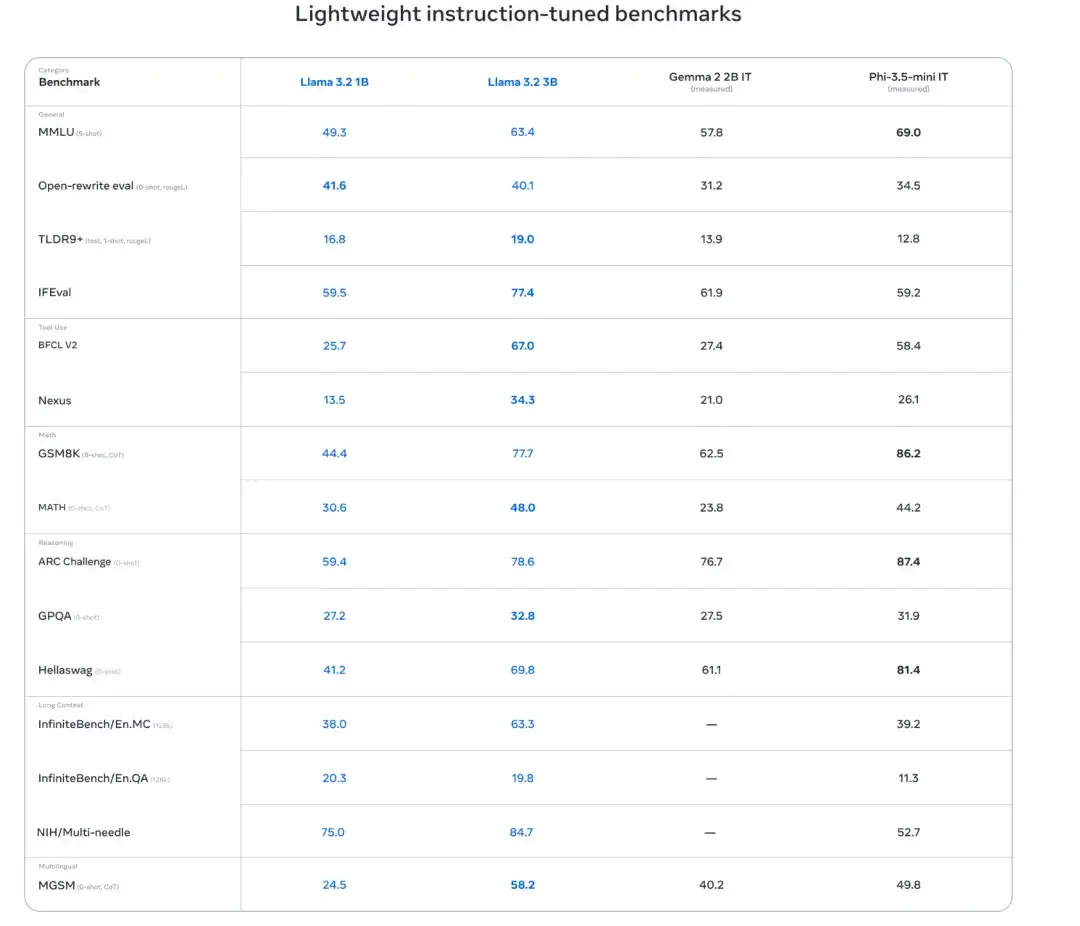

Forscher haben eine sprachübergreifende Umfrage unter mehr als 150Benchmark-DatensätzeBewerten Sie die Modellleistung. Die Ergebnisse zeigen, dass die Modelle Llama 3.2 1B und 3B eine Kontextlänge von 128.000 Token unterstützen. Bei Aufgaben wie dem Befolgen von Anweisungen, Zusammenfassen, sofortigen Umschreiben und der Verwendung von Werkzeugen übertrifft das 3B-Modell die Modelle Gemma 2 2.6B und Phi 3.5-mini, während das 1B-Modell mit dem Gemma-Modell konkurrieren kann.

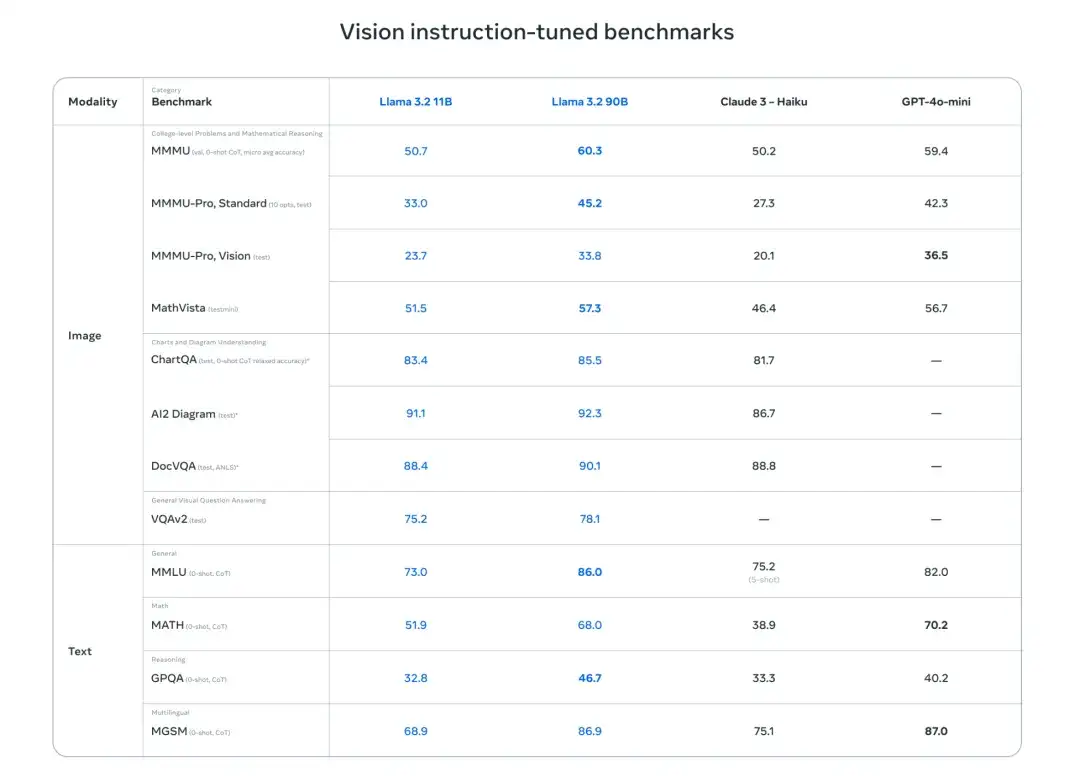

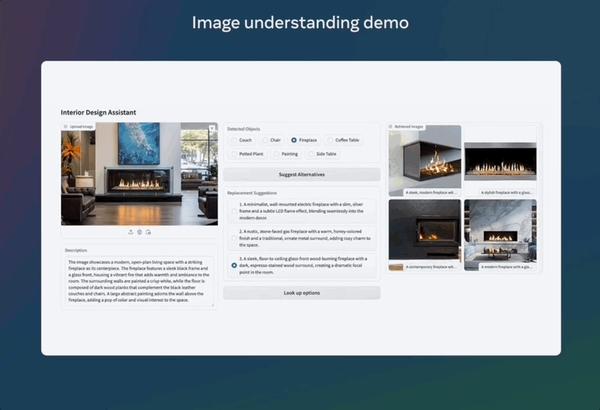

Darüber hinaus bewerteten die Forscher die Leistung des Modells anhand von Benchmarks zum Bildverständnis und visuellen Denken. Die Ergebnisse zeigen, dass die Vision-Modelle Llama 3.2 11B und 90B die entsprechenden Textmodelle nahtlos ersetzen können und bei Bildverständnisaufgaben Closed-Source-Modelle wie Claude 3 Haiku übertreffen.

Leichtgewichtiges Modelltraining

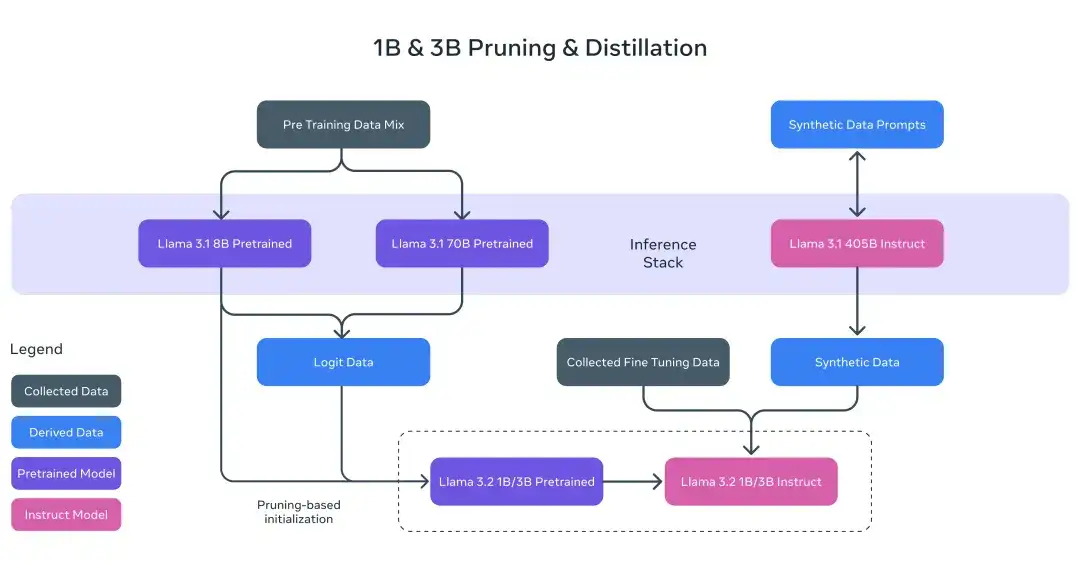

Für die Llama 3.2 1B- und 3B-Modelle verwendeten die Forscher Beschneidungs- und Destillationsmethoden, um effiziente 1B/3B-Modelle aus den 8B/70B-Modellen zu extrahieren.

Insbesondere haben die Forscher das Logit-Datum der 8B- und 70B-Modelle von Llama 3.1 in die Vortrainingsphase integriert und die Ausgaben (Logit-Datum) dieser größeren Modelle als Ziele auf Token-Ebene für strukturiertes Beschneiden verwendet. Nach dem Beschneiden verwendeten die ForscherWissensdestillationum die Leistung des Modells wiederherzustellen.

Visuelles Modelltraining

Der Trainingsprozess von Llama 3.2 ist in mehrere Phasen unterteilt. Beginnen Sie zunächst mit dem vortrainierten Llama 3.1-Textmodell. Als Nächstes fügten die Forscher einen Bildadapter und einen Encoder hinzu und trainierten sie vorab anhand großer Mengen verrauschter (Bild, Text) gepaarter Daten. Anschließend wird es anhand einer mittelgroßen Menge hochwertiger domäneninterner und wissenserweiterter (Bild, Text) gepaarter Daten trainiert.

In den späteren Trainingsphasen verfolgten die Forscher einen ähnlichen Ansatz wie beim Textmodell und verwendeten mehrere Ausrichtungsrunden zur überwachten Feinabstimmung, Ablehnungsstichproben und direkten Präferenzoptimierung. Die Forscher verwendeten das Llama 3.1-Modell zur Generierung synthetischer Daten, filterten und verbesserten Fragen und Antworten für domäneninterne Bilder und verwendeten ein Belohnungsmodell zur Bewertung aller Kandidatenantworten, um so qualitativ hochwertige Feinabstimmungsdaten sicherzustellen.

Darüber hinaus führten die Forscher Daten zur Sicherheitsminderung ein, um ein Modell zu erstellen, das sowohl hochsicher als auch praktisch ist. Schließlich wurde das Modell Llama 3.2 geboren, das sowohl Bilder als auch Text verstehen kann und einen weiteren wichtigen Schritt für das Llama-Modell auf dem Weg zu umfassenderen Agentenfunktionen darstellt.

Lokale Bereitstellungsmodelle sind zeitgemäß und sicher

Die Forscher weisen auf zwei wesentliche Vorteile der lokalen Ausführung des Llama 3.2-Modells hin. Erstens: Was die Reaktionsgeschwindigkeit betrifft, erfolgt die gesamte Verarbeitung lokal, sodass Eingabeaufforderungen und Antworten nahezu augenblicklich erfolgen können.

Zweitens ist es im Hinblick auf Datenschutz und Sicherheit beim lokalen Ausführen des Modells nicht erforderlich, Daten wie Nachrichten und Kalender in die Cloud zu senden, was die Privatsphäre der Benutzer schützt und die Anwendung privater macht. Bei der lokalen Verarbeitung können Anwendungen explizit steuern, welche Abfragen auf dem Gerät verbleiben und welche Abfragen von größeren Modellen in der Cloud verarbeitet werden.

festhaltenOpen SourceUrsprüngliche Absicht: Die Modellbereitstellung ist einfacher und effizienter

Meta hat immer an der ursprünglichen Absicht von Open Source festgehalten. Um den Prozess der Verwendung von Llama-Modellen in verschiedenen Umgebungen (einschließlich Einzelknoten, Bereitstellung vor Ort, Cloud und Geräten) für Entwickler erheblich zu vereinfachen,SuchverbesserungMeta gab bekannt, dass es die ersten offiziellen Llama Stack-Distributionen veröffentlichen wird, die eine Ein-Klick-Bereitstellung von RAG- und Tool-gestützten Anwendungen mit integrierten Sicherheitsfunktionen ermöglichen.

Laut der offiziellen Einführung wird das Modell Llama 3.2 http://llama.com und Hugging Face und bietet sofortige Entwicklungsunterstützung auf Partnerplattformen, darunter AMD, AWS, Databricks, Dell, Google Cloud, Groq, IBM, Intel, Microsoft Azure, NVIDIA, Oracle Cloud, Snowflake und andere.

Als konsequenter Verfechter von Open Source sagte Zuckerberg einmal in einem Gespräch mit Huang Renxun: „Meta hat vom Open-Source-Ökosystem profitiert und Milliarden von Dollar gespart.“ Llama ist zweifellos ein wichtiges Tool zum Aufbau eines Open-Source-Ökosystems. Llama 3.2 erweitert die Funktionalität für visuelle Aufgaben und erreicht Multimodalität, was seinem Open-Source-Ökosystem zweifellos Vorteile bringen wird.