Command Palette

Search for a command to run...

Gemeinsam Veröffentlicht Von CUHK, Tencent Und Anderen! DynamiCrafter: Jedes Bild Kann in Sekundenschnelle in Ein Dynamisches Video Mit Nahtloser Ultra-High-Definition Umgewandelt Werden

Der 1986 auf CCTV-1 ausgestrahlte Film „The Calabash Brothers“ erhielt sofort nach seiner Veröffentlichung großen Beifall und wurde für zahllose in den 1980er und 1990er Jahren Geborene zu einer wertvollen Kindheitserinnerung. Doch dieser Animationsklassiker,Tatsächlich besteht es aus etwa 200.000 von Mitarbeitern gezeichneten Bildern.

Je nach Entwicklung der Handlung wird das Team die Gelenke der Figur zusammenfügen, um eine Pose einzunehmen und das Ganze mit 24 Bildern pro Sekunde auf Video aufzunehmen.Es erzeugt einen visuellen Unterschied für das Publikum.Das heißt, es wird angenommen, dass sich die Figur bewegen kann.

Tatsächlich,Dynamisches Video wird kontinuierlich Bild für Bild abgespielt.Ursprünglich skizzierte man Bilder auf Zeichenpapier und erweckte die Bilder durch schnelles Umblättern des Papiers zum Leben. Später konnten Computer und Kameras mehr als 24 Bilder pro Sekunde speichern und so einen schnellen und kontinuierlichen dynamischen visuellen Effekt erzeugen. Bis heute wurden in der Videotechnologie große Fortschritte bei der Simulation der zufälligen Dynamik natürlicher Szenen (wie Wolken und Flüssigkeiten) oder von Bewegungen in bestimmten Bereichen (wie etwa den Bewegungen des menschlichen Körpers) erzielt.

Unabhängig davon, ob es sich um eine aufgenommene reale Szene oder eine virtuelle Animation bzw. einen Zeichentrickfilm handelt, erfordert die Präsentation dynamischer Videos die Unterstützung durch kontinuierliches Bildmaterial. Um beispielsweise den gesamten Zyklus der Blütenblüte darzustellen, muss man wirklich warten, bis die Blumen blühen, und sie Bild für Bild aufzeichnen.

Das Aufkommen der KI durchbricht diese Einschränkung.Von CUHK, Tencent KI-Labor Das von den beiden Unternehmen gemeinsam auf den Markt gebrachte Modell DynamiCrafter nutzt die Videodiffusionstechnologie, um reale Bewegungsmuster zu simulieren.In Kombination mit Textbefehlen können Sie Bilder in dynamische Videos umwandeln. Es kann fast alle Arten von statischen Bildern verarbeiten, darunter Landschaften, Menschen, Tiere, Fahrzeuge, Skulpturen usw. Die generierten dynamischen Videos sind hochauflösend, superflüssig und nahtlos, und jedes Detail wird genau richtig erfasst!

DynamiCrafter ist in Anwendungsszenarien noch leistungsfähiger. Zu den spezifischen Anwendungsfällen zählen unter anderem:

Unterhaltungsmedien: Erstellen Sie dynamische Hintergründe und Charakteranimationen für Filme, Spiele und Virtual-Reality-Umgebungen.

Kulturelle Bildung: Wandeln Sie historische Fotos in dynamische Formen um, um neue Möglichkeiten der Interaktion mit dem kulturellen Erbe zu bieten. Erstellen Sie Lehrvideos, die komplexe Konzepte durch animierte Bilder erklären. Konvertieren Sie wissenschaftliche Daten oder Modelle in intuitive Dynamiken, um Kommunikationsbarrieren in der wissenschaftlichen Forschung abzubauen.

Social Marketing: Erstellen Sie ansprechende Motion Graphics und kurze Videos für Werbung und Branding in sozialen Medien. Erzählen Sie Geschichten durch bewegte Grafiken und verleihen Sie der Werbung für Bücher und E-Books visuelle Wirkung.

Damit jeder DynamiCrafter besser erleben kann,HyperAI hat das Tutorial „DynamiCrafter AI Video Generation Tool“ veröffentlicht!Dieses Tutorial hat die Umgebung für Sie erstellt. Sie müssen nicht mehr warten, bis das Modell heruntergeladen und trainiert wurde. Klicken Sie einfach auf „Klonen“, um es mit einem Klick zu starten, und schon können flüssige Videos erstellt werden!

Adresse des Tutorials:https://hyper.ai/tutorials/31974

Das obige Tutorial basiert auf einer WebUI, die einfach und benutzerfreundlich ist, jedoch nur eine begrenzte lokale Präzisionssteuerung bietet. ComfyUI basiert auf einer knotenbasierten Schnittstelle und einem knotenbasierten Workflow. Durch das Ändern der Knoten können unterschiedliche Effekte erzielt werden, was dem Benutzer mehr Freiheit und kreativen Raum gibt. daher,HyperAI hat außerdem das Tutorial „ComfyUI DynamiCrafter Image-to-Video Workflow“ veröffentlicht.Spezifische Tutorial-Details finden Sie im nächsten Artikel, der heute von HyperAI veröffentlicht wird.

Demolauf

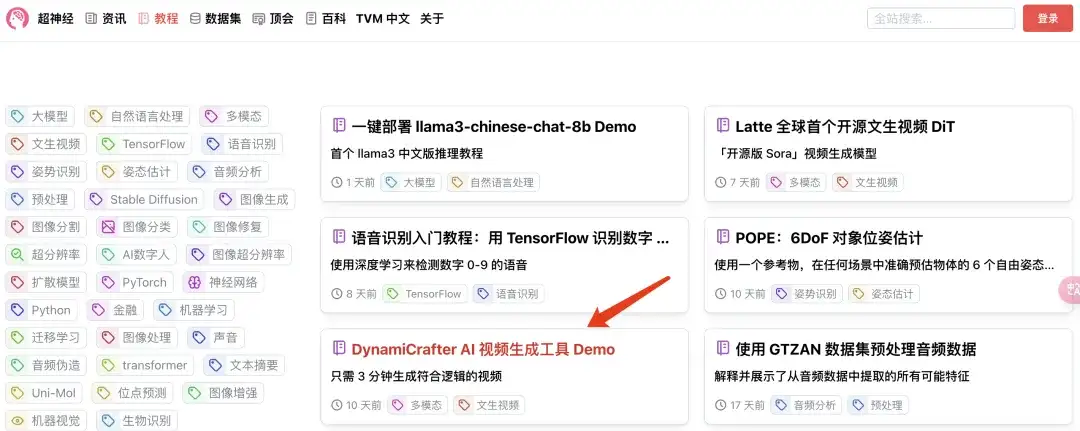

1. Melden Sie sich bei hyper.ai an, wählen Sie auf der Seite „Tutorials“ „Dynamicrafter AI Video Generation Tool“ aus und klicken Sie auf „Dieses Tutorial online ausführen“.

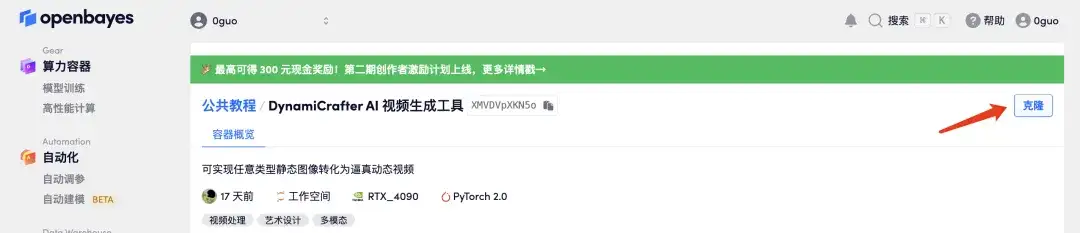

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

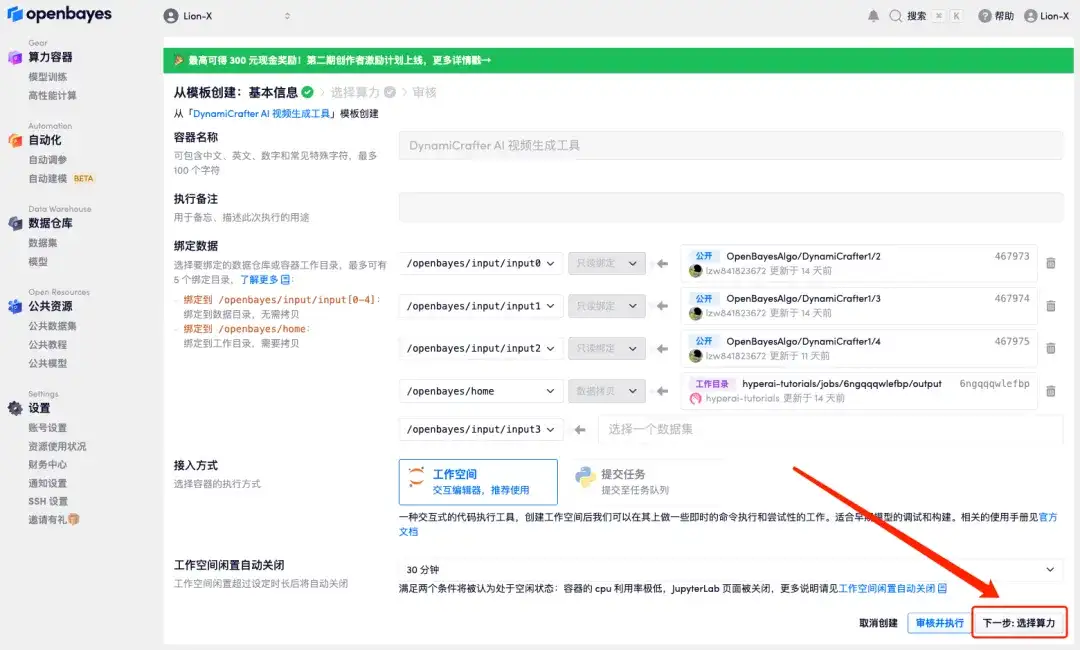

3. Klicken Sie unten rechts auf „Weiter: Hashrate auswählen“.

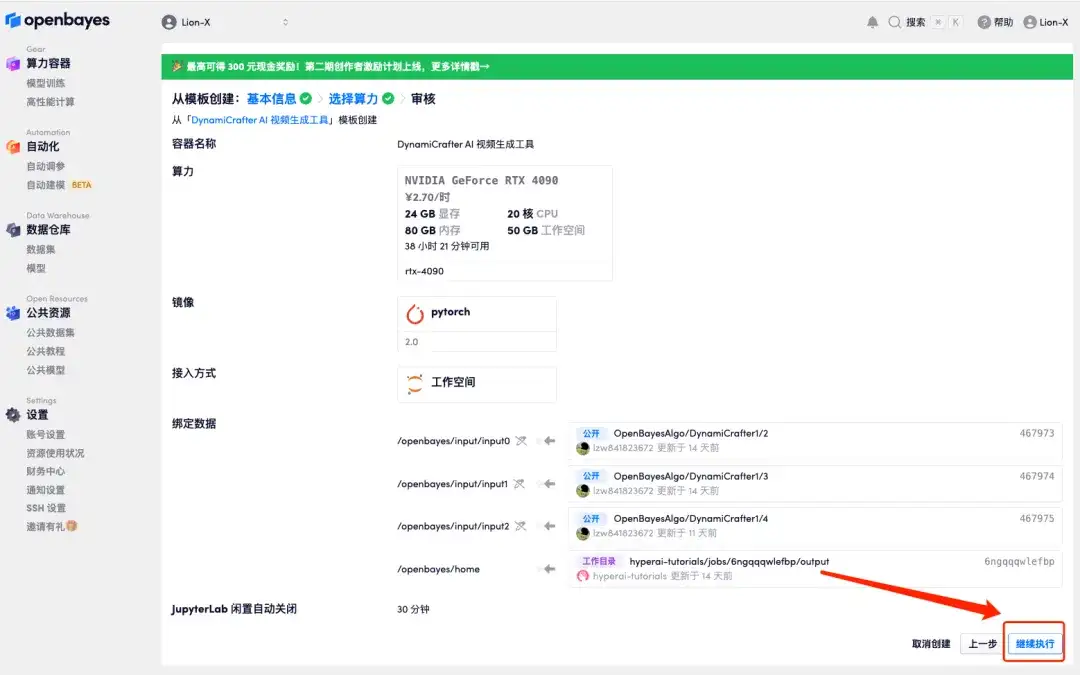

4. Wählen Sie nach dem Sprung „NVIDIA GeForce RTX 4090“ aus und klicken Sie auf „Weiter: Überprüfen“.Neue Benutzer können sich über den unten stehenden Einladungslink registrieren, um 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit zu erhalten!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

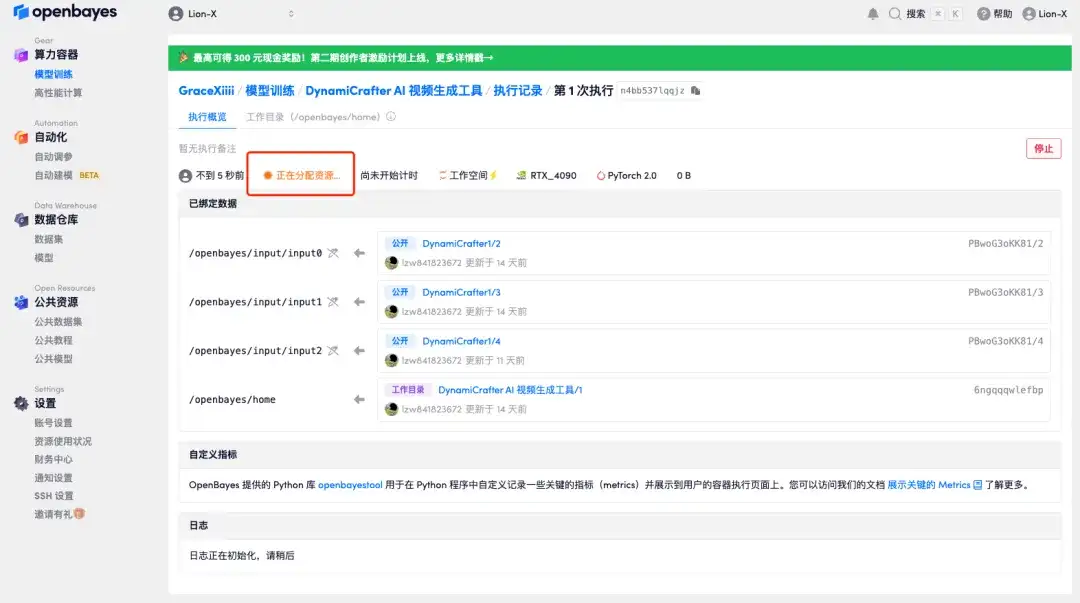

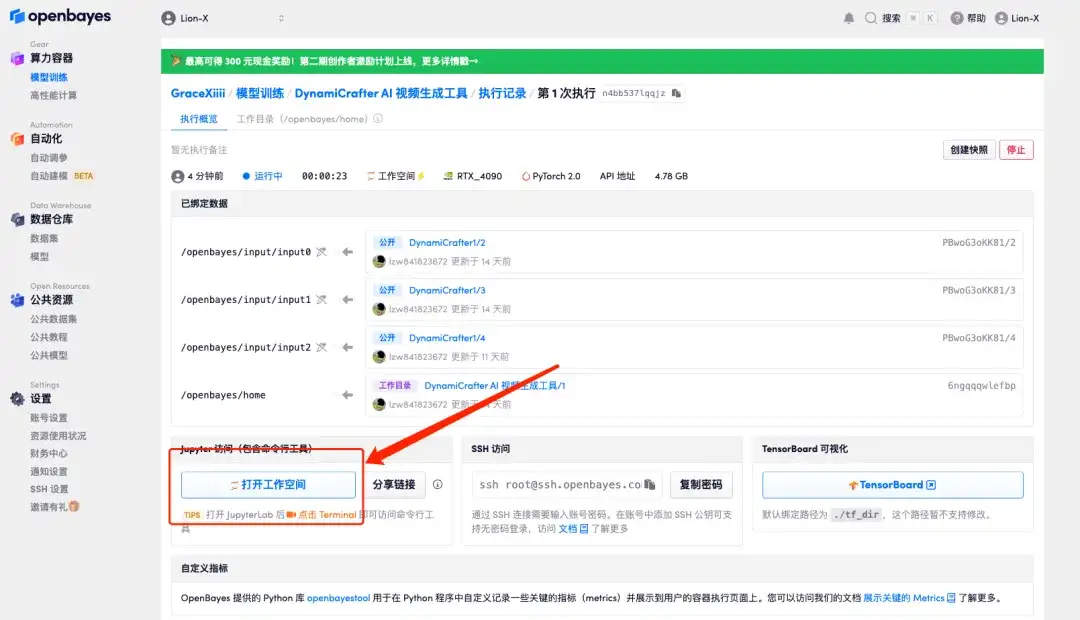

5. Klicken Sie auf „Weiter“ und warten Sie, bis die Ressourcen zugewiesen wurden. Der erste Klonvorgang dauert etwa 3–5 Minuten. Wenn sich der Status in „Läuft“ ändert, klicken Sie auf „Arbeitsbereich öffnen“.

Wenn das Problem länger als 10 Minuten besteht und sich das System immer noch im Status „Ressourcen werden zugewiesen“ befindet, versuchen Sie, den Container zu stoppen und neu zu starten. Wenn das Problem durch einen Neustart immer noch nicht behoben wird, wenden Sie sich bitte an den Kundenservice der Plattform auf der offiziellen Website.

6. Mit diesem Tutorial können Sie die folgenden zwei Effekte erzielen, die im Folgenden nacheinander demonstriert werden:

Erstellen Sie Videos aus Bildern und Textaufforderungen.

Erstellen Sie ein Video mithilfe des Startbilds, des Endbilds und der Eingabeaufforderungswörter.

Generieren Sie Videos aus Bildern und Textaufforderungen

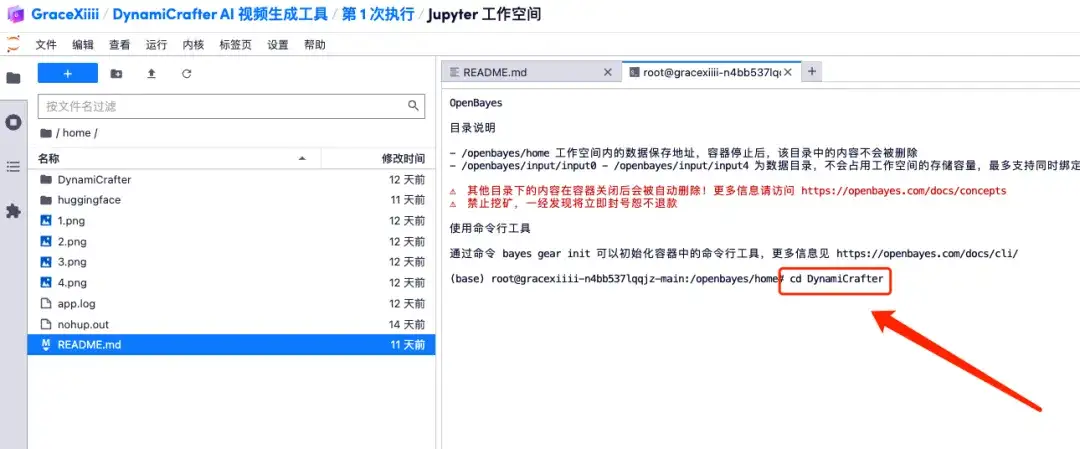

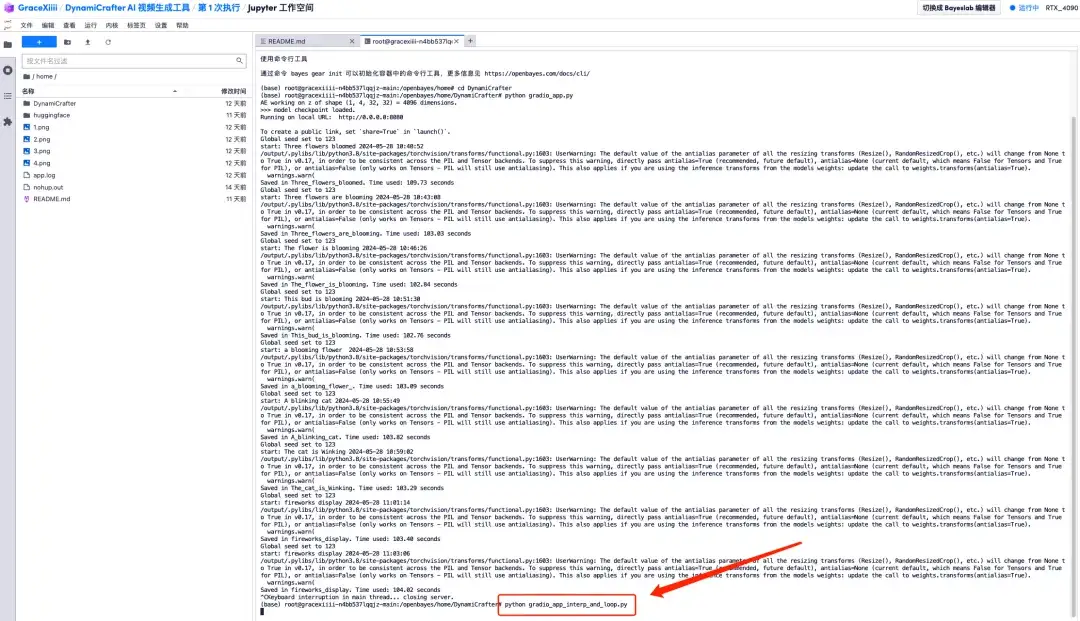

1. Erstellen Sie ein neues Terminal und führen Sie „cd DynamiCrafter“ aus, um zum DynamiCrafter-Verzeichnis zu wechseln.

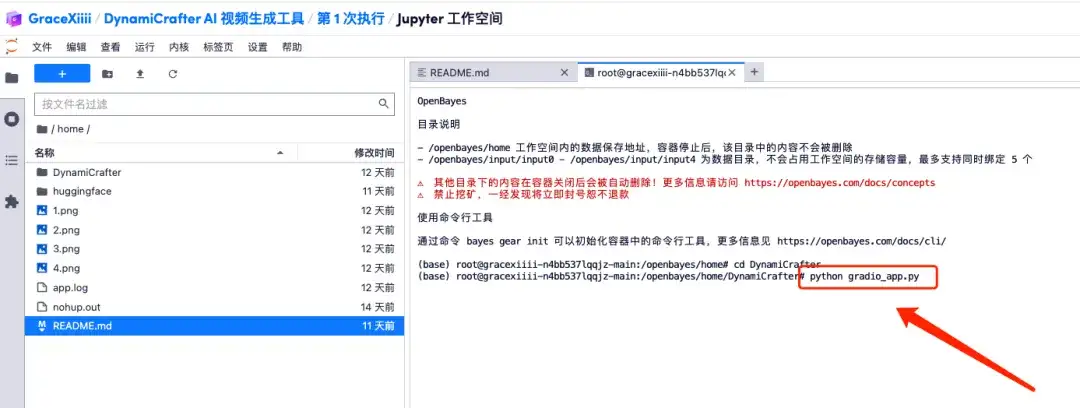

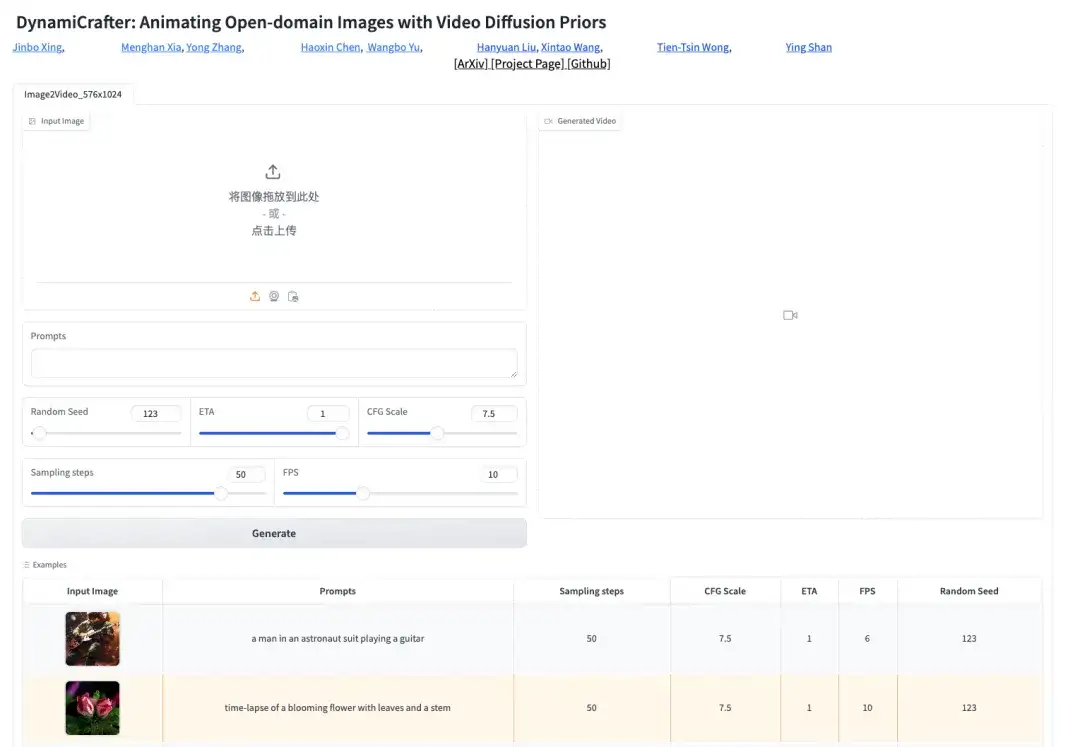

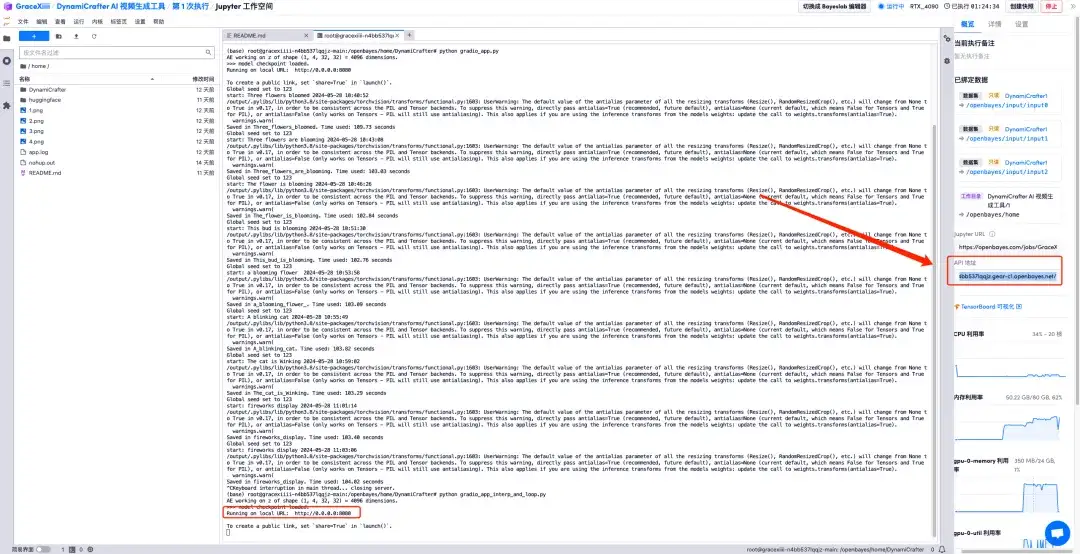

2. Führen Sie den Befehl „python gradio_app.py“ aus und warten Sie einen Moment. Wenn die Befehlszeile erscheint „https://0.0.0.0:8080", kopieren Sie die API-Adresse rechts in die Adressleiste des Browsers, um die Gradio-Schnittstelle zu öffnen.Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresszugriffsfunktion eine Echtnamenauthentifizierung durchführen müssen.

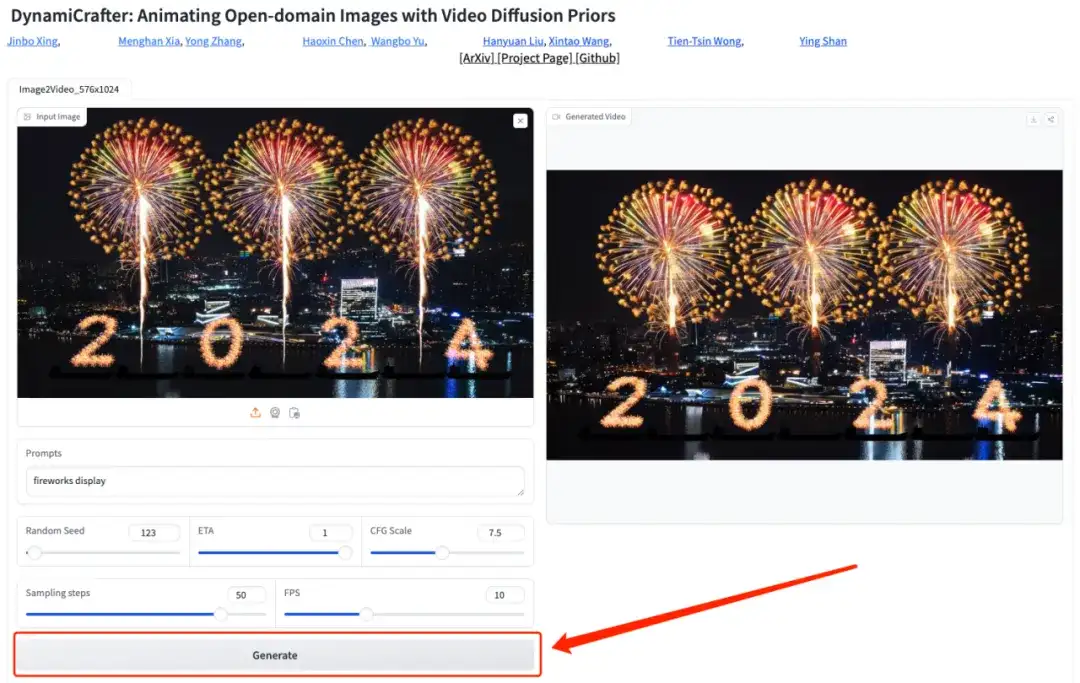

3. Laden Sie nach dem Öffnen der Gradio-Seite ein Foto hoch und fügen Sie eine Textbeschreibung hinzu (z. B. Feuerwerk), klicken Sie auf „Generieren“ und warten Sie einen Moment, bis das Video generiert wird.

Erstellen Sie ein Video mit Startbild, Endbild und Eingabeaufforderungswörtern

1. Kehren Sie zur Terminalschnittstelle zurück, beenden Sie den aktuellen Prozess durch Drücken von „Strg + C“ und führen Sie dann den Befehl „python gradio_app_interp_and_loop.py“ aus.https://0.0.0.0:8080", und öffnen Sie dann die API-Adresse auf der rechten Seite.

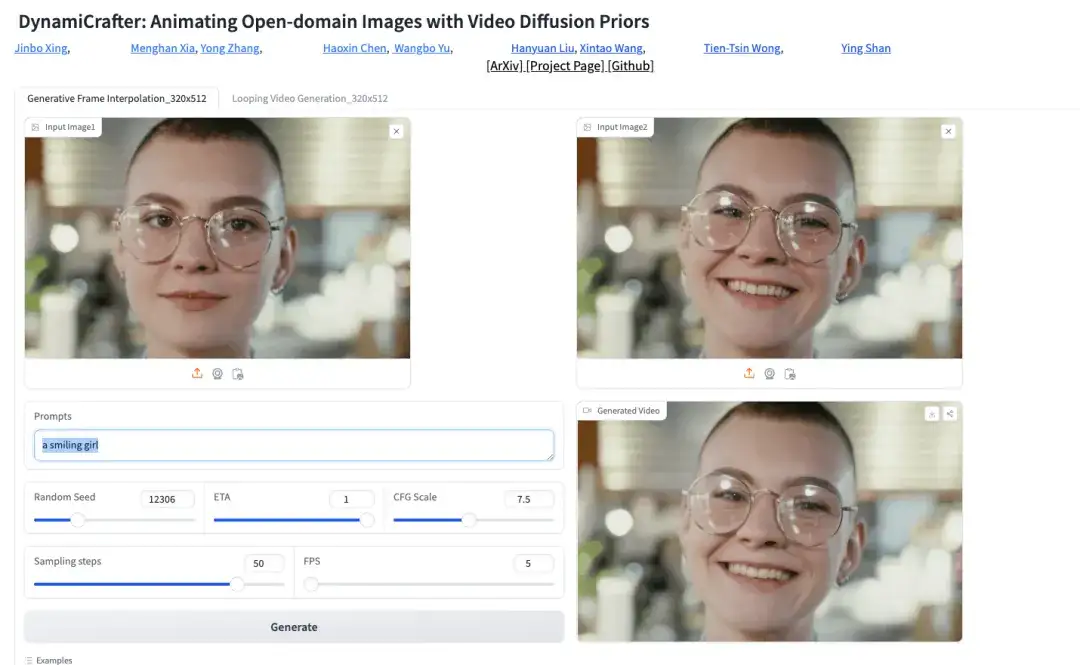

2. Laden Sie auf der Gradio-Seite ein Startbild, ein Endbild und eine Textbeschreibung (z. B. ein lächelndes Mädchen) hoch und klicken Sie auf „Generieren“, um das Video zu generieren.

Derzeit hat die offizielle Website von HyperAI Hunderte ausgewählter Tutorials zum Thema maschinelles Lernen veröffentlicht, die in Form eines Jupyter-Notebooks organisiert sind.

Klicken Sie auf den Link, um nach verwandten Tutorials und Datensätzen zu suchen:https://hyper.ai/tutorials

Das Obige ist der gesamte Inhalt, der dieses Mal vom HyperAI Super Neural Network geteilt wird. Wenn Sie hochwertige Projekte sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um sie uns zu empfehlen!