Command Palette

Search for a command to run...

Online-Tutorial – Ähnlich Wie Soras Technischer Weg! Das Weltweit Erste Open Source Vincent Video DiT-Modell Latte Mit Einem Klick

Seit OpenAI Sora auf den Markt gebracht hat, haben das Konzept des „Vintage-Videos“ und verwandte Anwendungen viel Aufmerksamkeit erregt. Mit der Popularität von Sora,Auch die dahinterstehende Schlüsseltechnologie DiT (Diffusion Transformers) wurde „archäologisch ausgegraben“.

Tatsächlich ist DiT ein Textgraphmodell, das vor zwei Jahren als Open Source veröffentlicht wurde. Seine Entwickler sind Peebles und Xie Saining, wobei Peebles auch einer der Projektleiter von Sora ist.

Bevor das DiT-Modell vorgeschlagen wurde, dominierte Transformer mit seinen leistungsstarken Funktionen zur Merkmalsextraktion und zum Kontextverständnis nahezu den Bereich der natürlichen Sprachverarbeitung. U-Net dominiert mit seiner einzigartigen Architektur und überlegenen Leistung den Bereich der Bilderzeugung und Diffusionsmodelle. Das größte Merkmal von DiT besteht darin, dass es die U-Net-Architektur im Diffusionsmodell durch die Transformer-Architektur ersetzt.Interessanterweise wurde diese Arbeit 2023 von CVPR aufgrund mangelnder Innovation abgelehnt.

Im Vergleich zu U-Net verfügt Transformer über eine bessere Skalierbarkeit. Es kann globale Abhängigkeiten erlernen und Fernabhängigkeitsprobleme in Sequenzdaten durch den Self-Attention-Mechanismus bewältigen. Es bietet große Vorteile bei der Verarbeitung globaler Bildmerkmale. Darüber hinaus wurden mit DiT auf Basis der Transformer-Architektur auch erhebliche Verbesserungen bei der Rechenleistung und den Generierungseffekten erzielt, was die Anwendung der Bildgenerierung im großen Maßstab weiter fördert.

Aufgrund der hohen Struktur und Komplexität von Videodaten ist es jedoch eine Herausforderung, DiT auf den Bereich der Videogenerierung auszuweiten. In diesem ZusammenhangEin Forschungsteam des Shanghai Artificial Intelligence Laboratory hat Ende 2023 das weltweit erste Vinyl-Video DiT:Latte als Open Source veröffentlicht. Als selbst entwickeltes Modell mit ähnlicher Technologie wie Sora kann Latte frei eingesetzt werden.Wer die Videotechnologie von Vincent erkunden möchte, für den bietet die Open Source-Version von Latte zweifellos eine Gelegenheit zum Üben.

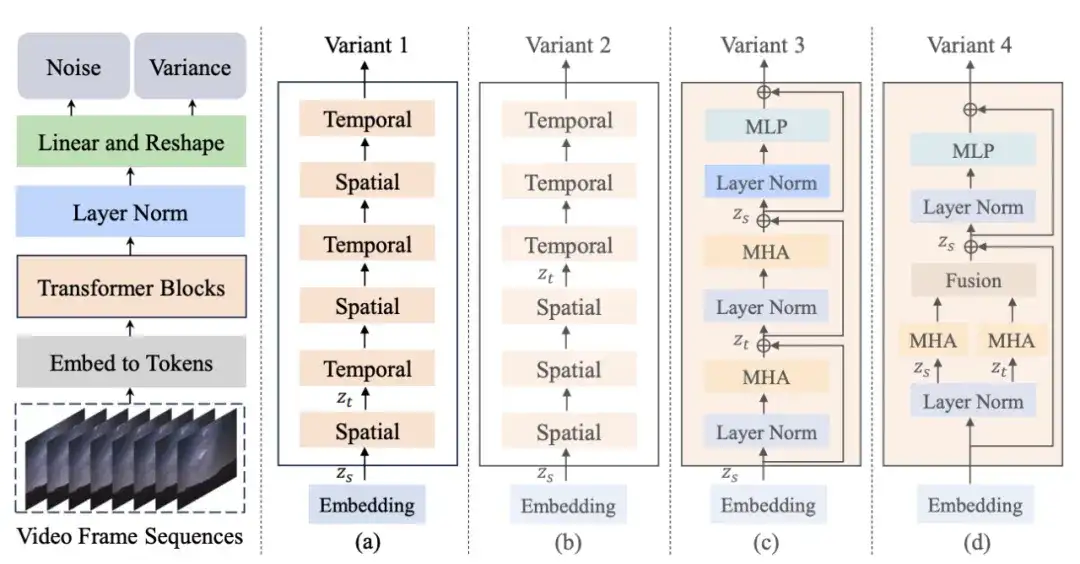

Zunächst kodiert Latte das Eingabevideo mithilfe eines vortrainierten Variational Autoencoders (VAE) in Features im latenten Raum und extrahiert daraus Token. Anschließend werden diese Tokens mit der entsprechenden Transformer-Struktur in einer der oben genannten Varianten kodiert und dekodiert. Während des Generierungsprozesses stellt das Modell basierend auf dem erlernten Rückdiffusionsprozess schrittweise die rauscharme Videobilddarstellung im latenten Raum wieder her und rekonstruiert sie schließlich in kontinuierlichen und realistischen Videoinhalt.

Es ist erwähnenswert, dass das Shanghai Artificial Intelligence Laboratory, das Forschungs- und Entwicklungsteam hinter Latte, mit China Central Radio and Television Station zusammengearbeitet hat, umGemeinsam starteten sie die erste chinesische Wensheng-Video-KI-Animationsserie „Poems of the Thousand Years“, die auf dem CCTV-1 Comprehensive Channel ausgestrahlt wurde.Branchenkenner haben analysiert, dass mit der Einführung der ersten KI-Animation in China die Implementierung kultureller Videoanwendungen in meinem Land voraussichtlich beschleunigt wird. Dies könnte den Produktionsprozess der Film- und Fernsehbranche in Zukunft umgestalten und die revolutionäre Entwicklung der Film- und Fernsehanimationsproduktion, der Spieleentwicklung und des Werbedesigns fördern.

In diesem Zusammenhang, um mehr kreativen Mitarbeitern und Video-Enthusiasten zu helfen, mit dem Technologietrend Schritt zu halten,HyperAI hat das Tutorial „Latte World‘s First Open Source Vincent Video DiT“ veröffentlicht.Dieses Tutorial hat eine Umgebung für Sie erstellt. Sie müssen nicht mehr warten, bis das Modell heruntergeladen und trainiert wurde. Klicken Sie einfach auf „Klonen“, um es mit einem Klick zu starten, und geben Sie Text ein, um sofort ein Video zu generieren!

Adresse des Tutorials:https://hyper.ai/tutorials/32065

Der Editor verwendete den Text „ein Hund mit Sonnenbrille“, um ein Video eines Welpen mit Sonnenbrille zu erstellen. Es sieht ziemlich hübsch aus!

Demolauf

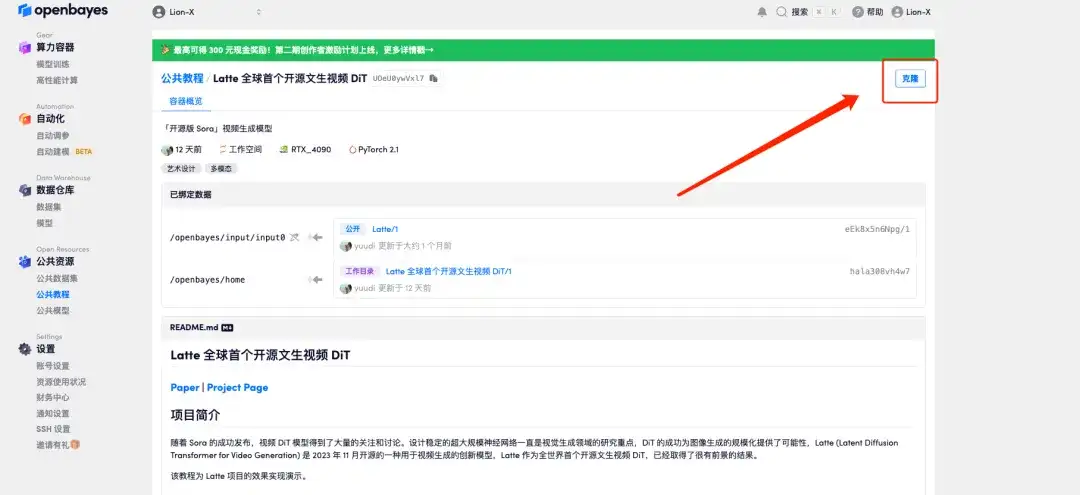

1. Melden Sie sich bei hyper.ai an, wählen Sie auf der Seite „Tutorials“ „Latte World's First Open Source Vinyl Video DiT“ aus und klicken Sie auf „Dieses Tutorial online ausführen“.

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

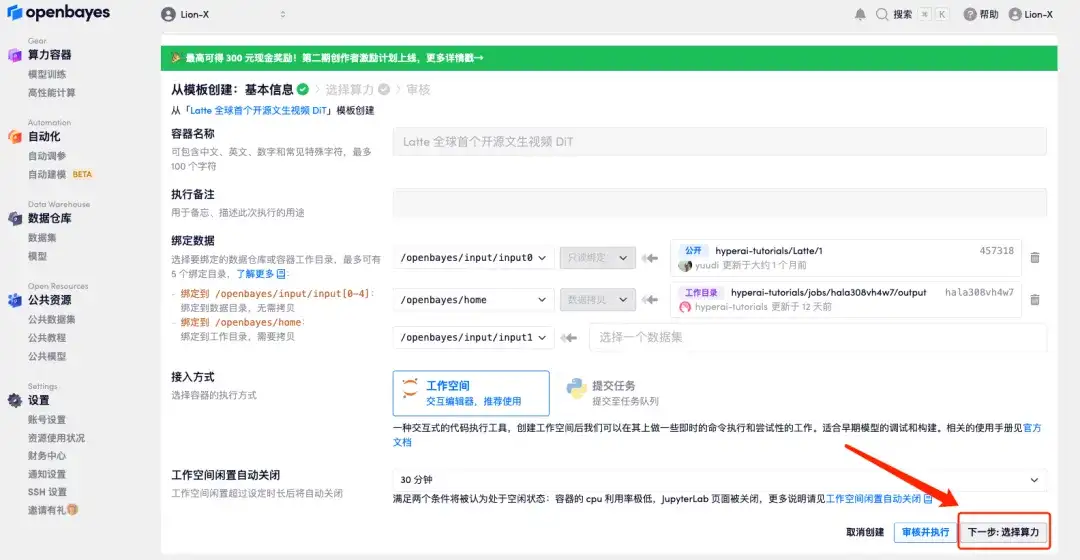

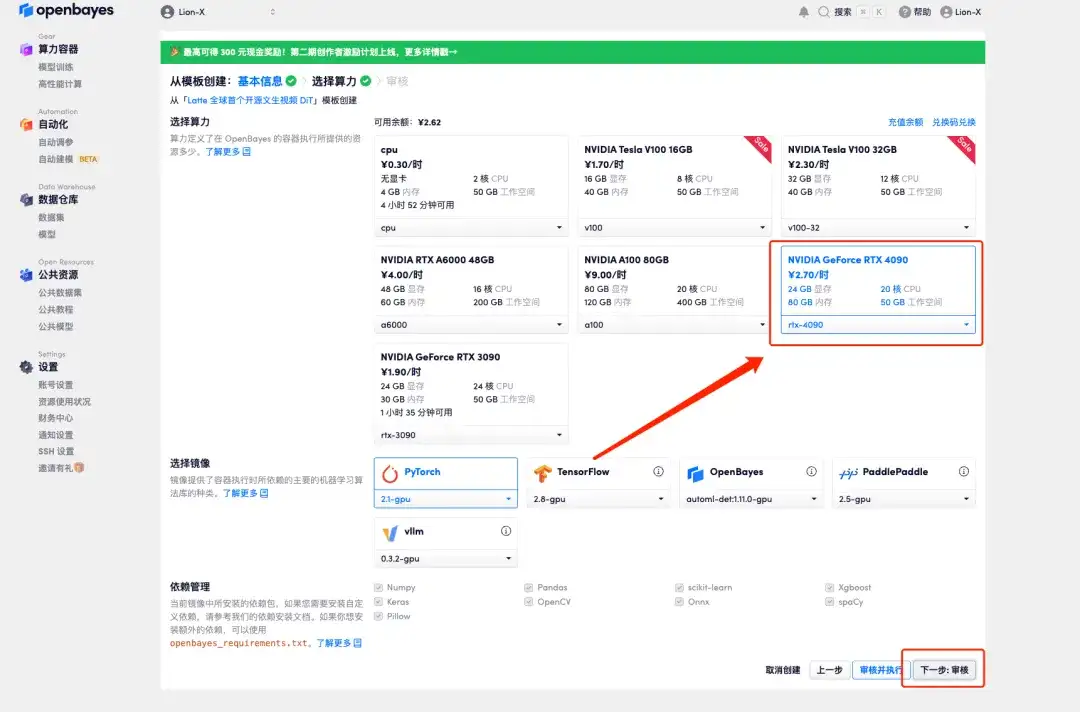

3. Klicken Sie unten rechts auf „Weiter: Hashrate auswählen“.

4. Wählen Sie nach dem Sprung „NVIDIA GeForce RTX 4090“ aus und klicken Sie auf „Weiter: Überprüfen“.Neue Benutzer können sich über den unten stehenden Einladungslink registrieren, um 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit zu erhalten!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

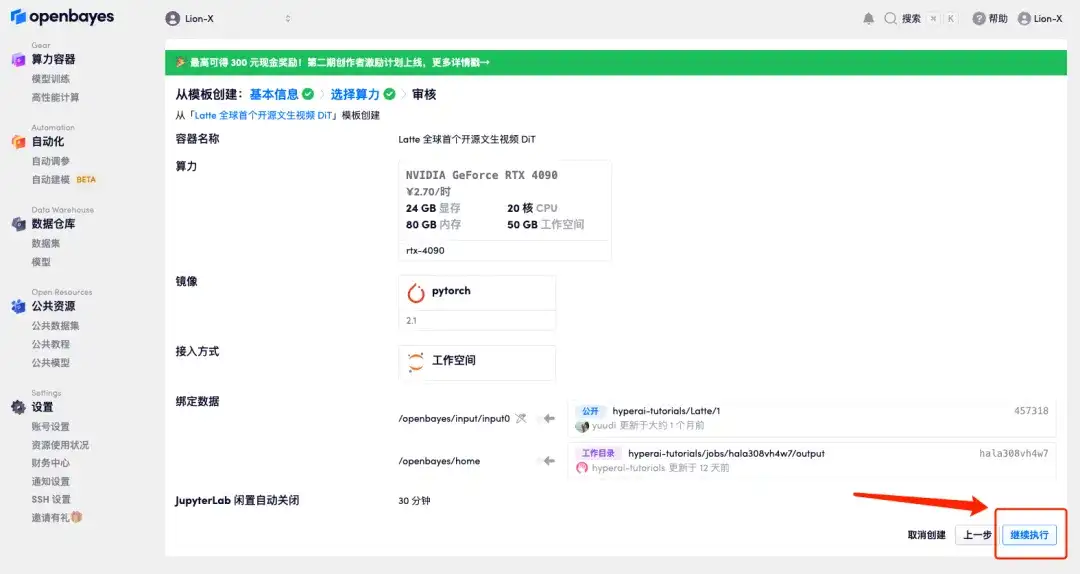

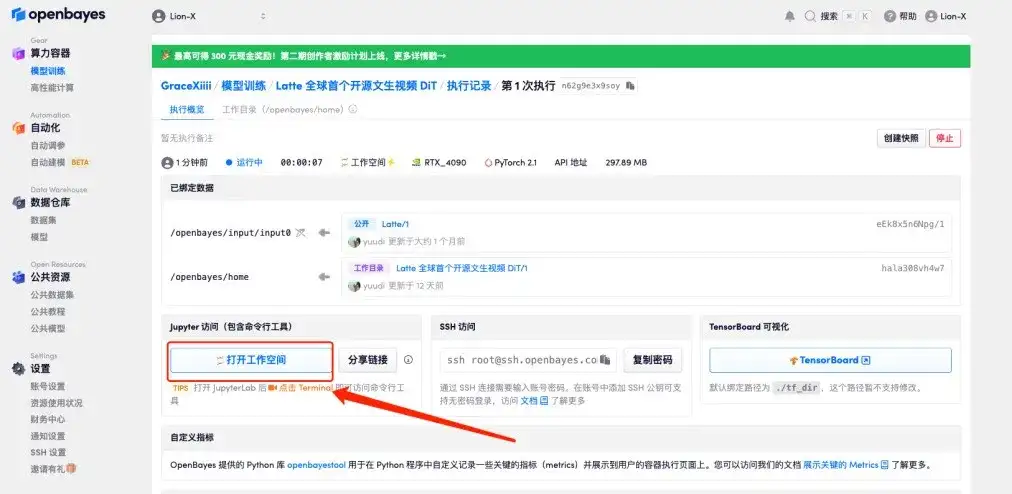

5. Klicken Sie auf „Weiter“ und warten Sie, bis die Ressourcen zugewiesen wurden. Der erste Klonvorgang dauert etwa 3–5 Minuten. Wenn sich der Status in „Läuft“ ändert, klicken Sie auf „Arbeitsbereich öffnen“.

Wenn das Problem länger als 10 Minuten besteht und sich das System immer noch im Status „Ressourcen werden zugewiesen“ befindet, versuchen Sie, den Container zu stoppen und neu zu starten. Wenn das Problem durch einen Neustart immer noch nicht behoben wird, wenden Sie sich bitte an den Kundenservice der Plattform auf der offiziellen Website.

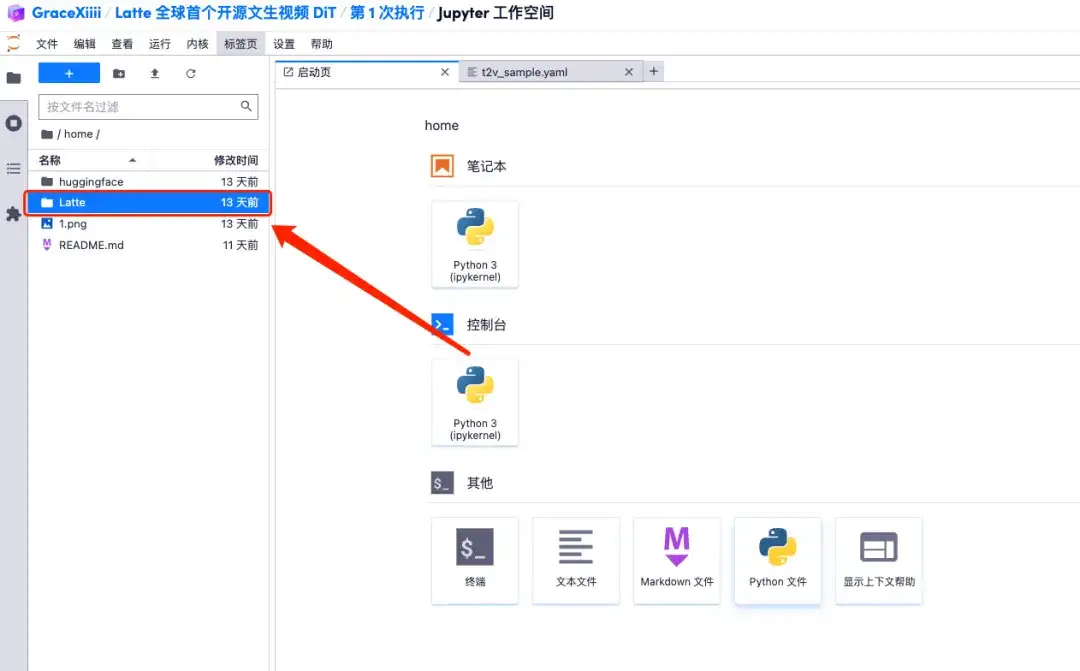

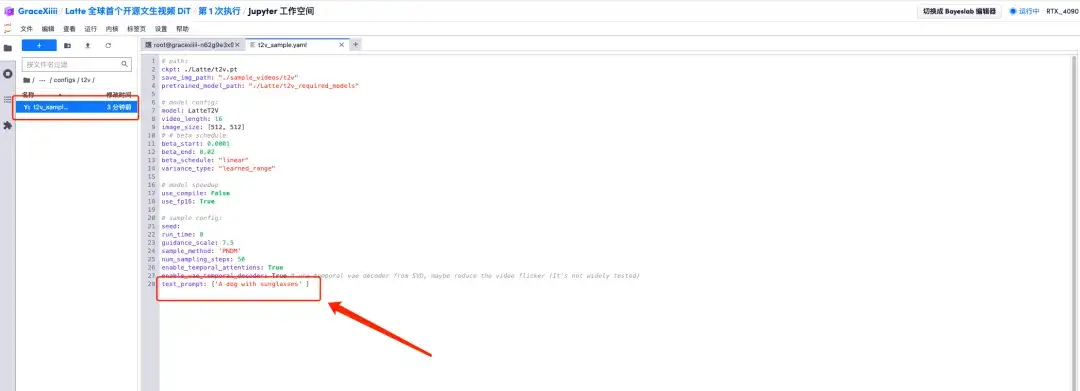

6. Nach dem Öffnen des Arbeitsbereichs öffnen Sie die Konfigurationsdatei home/Latte/configs/t2v/t2v_sample.yaml gemäß dem Pfad im linken Menü, geben unter text_prompt den Prompt „zum Beispiel: ein Hund mit Sonnenbrille“ ein und speichern mit Strg+S.

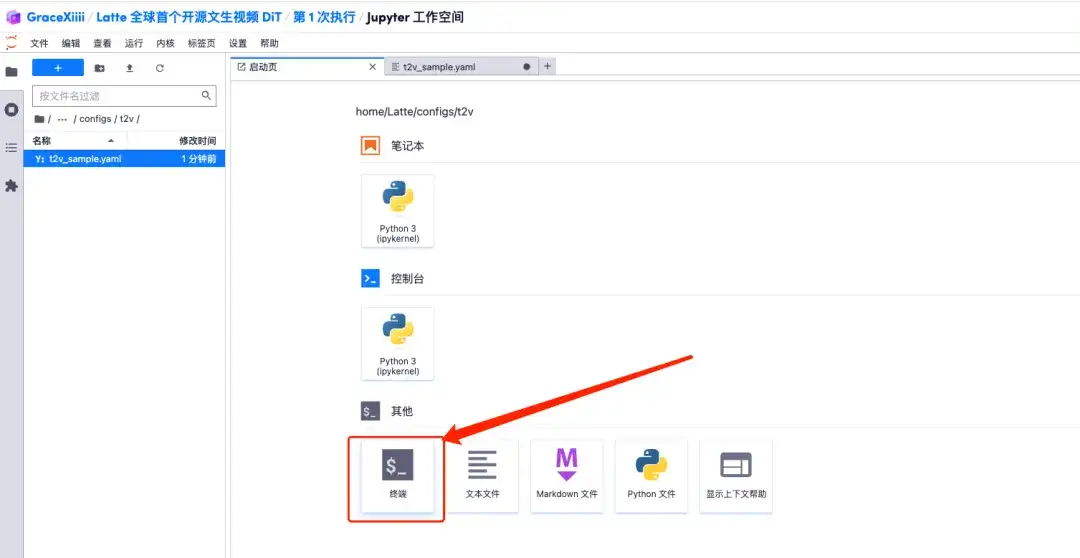

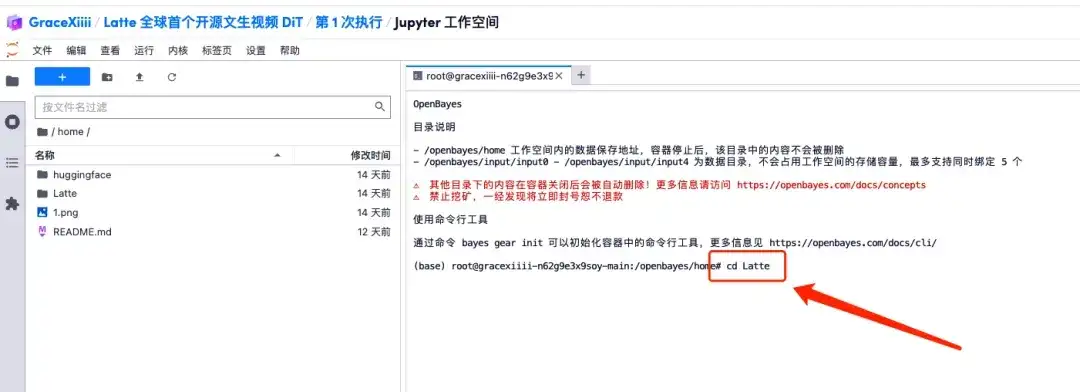

7. Erstellen Sie nach dem Speichern eine neue Terminalseite, geben Sie „cd Latte“ ein und drücken Sie die Eingabetaste, um in das Verzeichnis „Latte“ zu gelangen. Geben Sie „bash sample/t2v.sh“ ein, um ein hochauflösendes Video zu generieren.

Effektanzeige

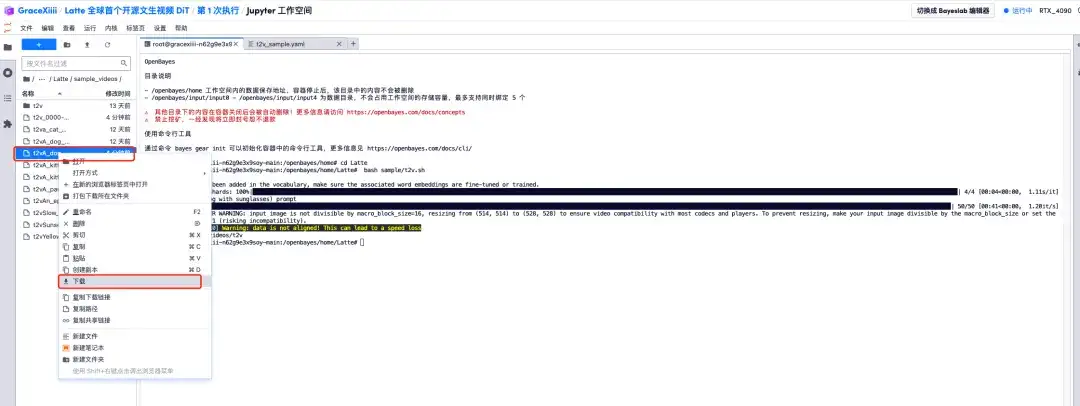

1. Wenn der Fortschrittsbalken 100% anzeigt, öffnen Sie die linke Menüleiste „Latte/sample_videos“, suchen Sie das von uns generierte Video und klicken Sie mit der rechten Maustaste, um es herunterzuladen.Bitte beachten Sie, dass MP4-Videos nicht direkt angesehen werden können und vor der Anzeige heruntergeladen werden müssen.

2. Es wird ein Video von einem Welpen mit Sonnenbrille erstellt!

Derzeit hat die offizielle Website von HyperAI Hunderte ausgewählter Tutorials zum Thema maschinelles Lernen veröffentlicht, die in Form eines Jupyter-Notebooks organisiert sind.

Klicken Sie auf den Link, um nach verwandten Tutorials und Datensätzen zu suchen:https://hyper.ai/tutorials

Das Obige ist der gesamte Inhalt, der dieses Mal vom HyperAI Super Neural Network geteilt wird. Wenn Sie hochwertige Projekte sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um sie uns zu empfehlen! Darüber hinaus haben wir auch eine „Stable Diffusion Tutorial Exchange Group“ eingerichtet. Willkommen, Freunde, treten Sie der Gruppe bei, um verschiedene technische Probleme zu diskutieren und Anwendungsergebnisse auszutauschen ~