Command Palette

Search for a command to run...

GPT-4o Drachentöter-Schock! ChatGPT Ist Eine Multimodale, Interaktive Echtzeitanwendung, Die Für Alle Kostenlos ist. Es Verfügt Über Eine Reibungslose Sprachinteraktion. Das Ist Ein Gewinner.

Anfang Mai wurde bekannt gegeben, dass am 9. eine Suchmaschine veröffentlicht werden würde. Am 11. Mai wurde offiziell angekündigt, dass die Updates für ChatGPT und GPT-4 am 13. Mai um 10 Uhr Ortszeit veröffentlicht werden würden. dann widerlegte Sam Altman persönlich das Gerücht und sagte: „Es ist weder GPT-5 noch eine Suchmaschine“, sondern „eine neue Sache wie Magie“; Anschließend begannen die Internetnutzer, sich anhand verschiedener Hinweise eingehend mit dem Inhalt der Veröffentlichung zu befassen, und schließlich wurden GPT-4.5 und die Anruffunktion von ChatGPT zu beliebten Kandidaten.

Anfangs scherzten einige Internetnutzer, dass Sam Altman versuche, der Google I/O-Konferenz die Show zu stehlen. Doch verglichen mit dem Showdown zwischen Gemini 1.5 und Sora wäre Altman vermutlich nicht bereit gewesen, das Risiko einzugehen, einen Tag vor der jährlichen Google-Konferenz ein Update zu veröffentlichen, wenn es da nicht um „harte Sachen“ gegangen wäre.

Dies ist tatsächlich der Fall. Die scheinbar improvisierte Online-Live-Konferenz von OpenAI war tatsächlich gut vorbereitet.

Sam Altman war bei diesen OpenAI-Frühjahrsupdates nicht anwesend, aber der CTO des Unternehmens, Muri Murati, brachte eine Reihe von Updates mit, darunter:

- GPT-4o

- Die Sprachinteraktionsfunktion von ChatGPT

- Die visuellen Funktionen von ChatGPT

GPT-4o: Voice Buff, kostenlos für alle Benutzer

Seit seiner Veröffentlichung im März 2023 dominiert GPT-4 lange Zeit die Charts. Bei jeder Veröffentlichung eines neuen Modells wird es zum Vergleich präsentiert, was ausreicht, um seine starke Leistung unter Beweis zu stellen. Darüber hinaus ist GPT-4 in diesem Stadium auch eine „Cash Cow“ mit großem kommerziellen Wert für OpenAI und wurde von Musk wiederholt dafür kritisiert, „nicht offen“ zu sein.

Noch wichtiger ist, dass die kostenlose Version von ChatGPT auf Basis von GPT-3.5 angesichts von Metas Open Source Llama, Googles Open Source Gemma und Musks Open Source Grok doppeltem Druck ausgesetzt ist. Da GPT-5 noch nicht erschienen ist, spekulierten viele Internetnutzer, dass OpenAI eine neue Version von GPT-4 als Ersatz für GPT-3.5 veröffentlichen wird.

Wie erwartet hat OpenAI in der heutigen Live-Übertragung eine neue Version, GPT-4o, veröffentlicht, die allen Benutzern kostenlos zur Verfügung steht. Bezahlte Benutzer haben im Vergleich zu kostenlosen Benutzern das fünffache Kapazitätslimit. Das „o“ steht für „omni“, was eine Entwicklung hin zu einer natürlicheren Mensch-Computer-Interaktion impliziert.

Muri Murati, CTO von OpenAI, stellte vor, dass GPT-4o KI-Funktionen auf GPT-4-Niveau bietet und Schlussfolgerungen auf der Grundlage von Sprache, Text und Bild ziehen kann. Es akzeptiert jede Kombination aus Text-, Audio- und Bildeingabe und kann jede Kombination aus Text-, Audio- und Bildausgabe generieren.

Klicken Sie auf den Link, um das GPT-4o-Demonstrationsvideo anzuzeigen:

https://www.bilibili.com/video/BV1PH4y137ch

Vor GPT-4o betrug die durchschnittliche Latenz für Gespräche mit ChatGPT im Sprachmodus 2,8 Sekunden (GPT-3.5) und 5,4 Sekunden (GPT-4). Um das interaktive Erlebnis zu optimieren, hat OpenAI ein neues End-to-End-Modell für Text, Bild und Audio trainiert. Das bedeutet, dass alle Ein- und Ausgaben vom selben neuronalen Netzwerk verarbeitet werden, wodurch der Informationsverlust reduziert wird.

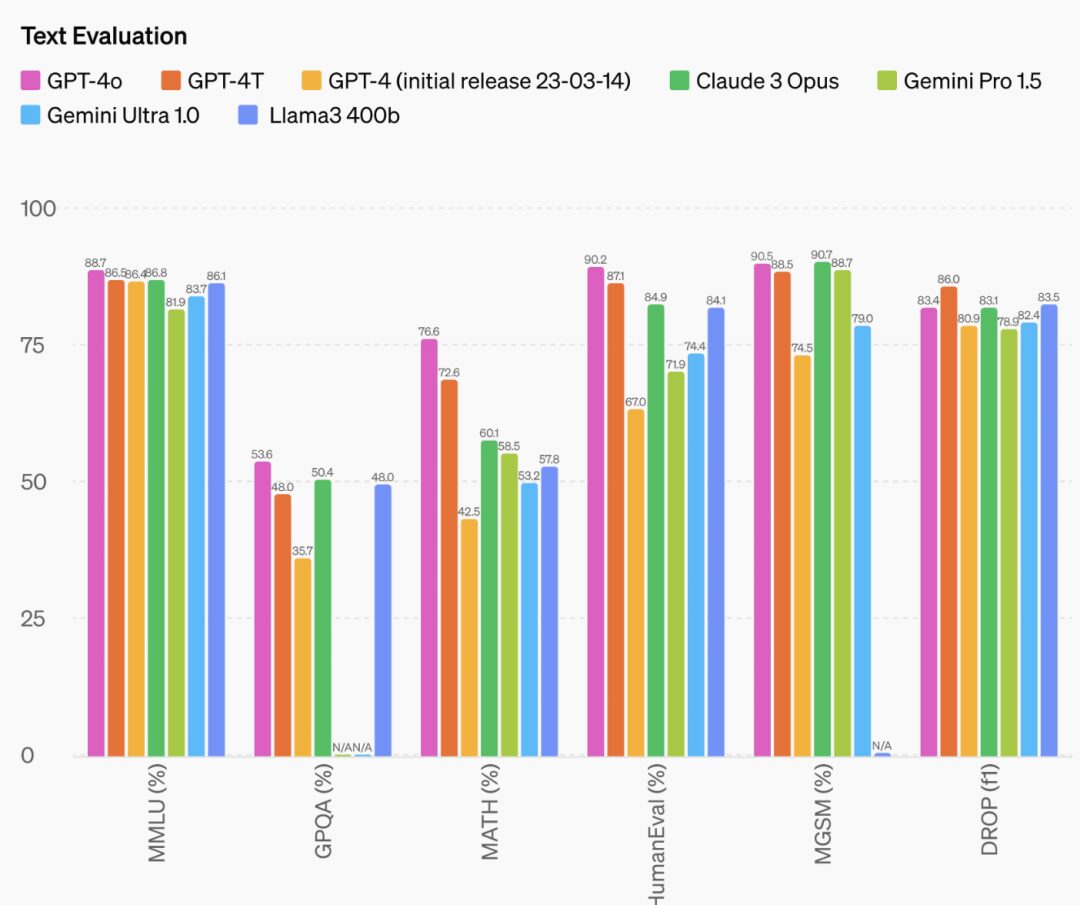

In Bezug auf die Leistung kann GPT-4o innerhalb von 232 Millisekunden auf Audioeingaben reagieren, mit einer durchschnittlichen Reaktionszeit von 320 Millisekunden, was der Reaktionszeit von Menschen in einem Gespräch ähnelt. Darüber hinaus ist die Leistung von GPT-4o bei englischem und Codetext mit der von GPT-4 Turbo vergleichbar und auch bei nicht-englischsprachigem Text ist die Leistung deutlich besser, wodurch die Qualität und Erkennungsgeschwindigkeit in 50 verschiedenen Sprachen verbessert wird. Gleichzeitig ist die API doppelt so schnell, der Preis ist jedoch günstiger als 50%.

Darüber hinaus wurde auch die Denkfähigkeit von GPT-4o erheblich verbessert. Offizielle Daten zeigen, dass GPT-4o einen neuen Highscore von 88,7% in 0-Shot-COT-MMLU (Common Sense Questions) erreicht hat.

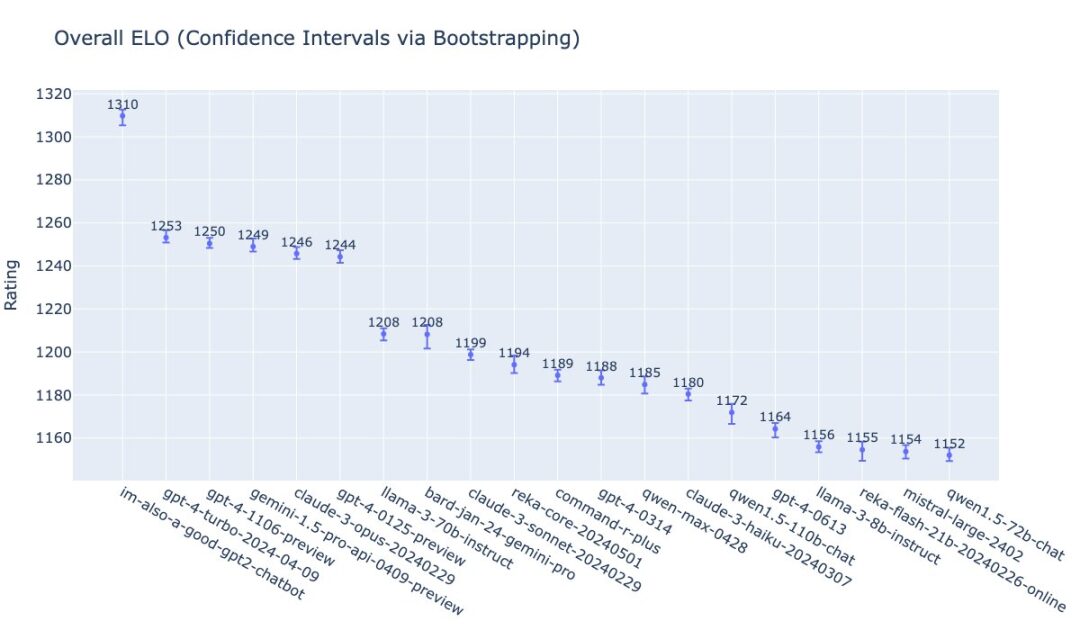

William Fedus von OpenAI hat das Ranking von GPT-4o auf der LMSys-Liste veröffentlicht. Sehr interessant ist auch der Name, den das Team GPT-4o gegeben hat: „Ich bin auch ein guter GPT2-Chatbot.“

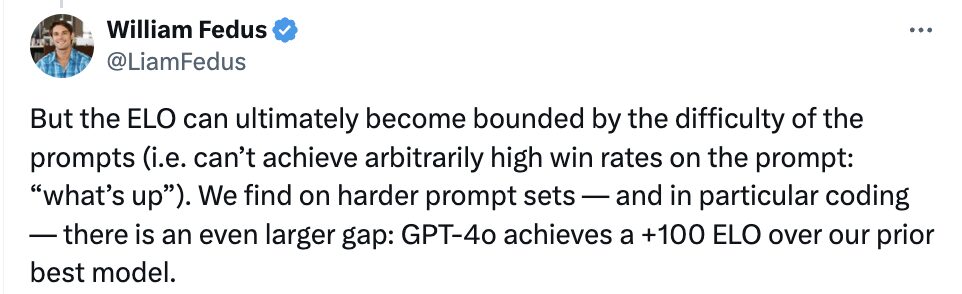

Er führte außerdem aus, dass bei schwierigeren Prompt-Sets, insbesondere bei der Kodierungsfähigkeit, das Niveau von GPT-4o um +100 ELO höher sei als das bisher fortschrittlichste große Modell von OpenAI.

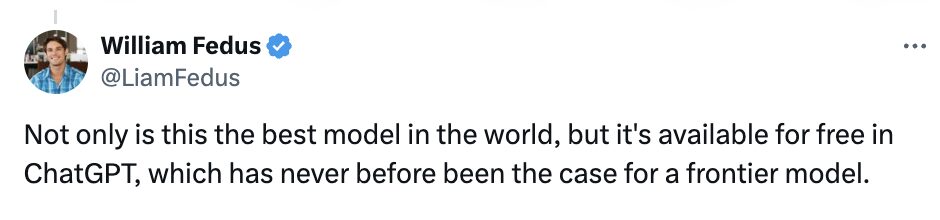

William Fedus erklärte unverblümt, dass GPT-4o nicht nur das beste Modell der Welt sei, sondern auch kostenlos in ChatGPT bereitgestellt werde, was einen Präzedenzfall für hochmoderne Modelle darstelle.

Bis zu einem gewissen Grad kann GPT-4o als Update von OpenAI für seine „Open Source“-Produkte angesehen werden. Zu der wiederholten Kritik, OpenAI sei nicht offen, sagte Sam Altman in seinem Blog auch: „Eine der Missionen von OpenAI besteht darin, den Menschen leistungsstarke Tools für künstliche Intelligenz kostenlos (oder zu einem reduzierten Preis) zur Verfügung zu stellen. Ich bin sehr stolz darauf, dass wir mit ChatGPT das weltweit beste Modell kostenlos anbieten, ohne Werbung oder ähnliches.“

Auch Sam Altman lobte die Leistung von GPT-4o: „Der neue Sprach- (und Video-)Modus ist die beste Computerschnittstelle, die ich je benutzt habe. Er fühlt sich an wie die künstliche Intelligenz in den Filmen; und seine Authentizität überrascht mich immer noch ein wenig. Eine der wichtigsten Änderungen ist die Reaktionszeit und Ausdrucksstärke, die menschliches Niveau erreichen.“

Später postete Altman „her“ auf seinem Account und deutete damit an, dass sein neues Modell die „Her-Ära“ einläuten werde.

Es ist erwähnenswert, dass die Sprachfunktionalität in der GPT-4o-API nicht für alle Kunden verfügbar ist.

OpenAI sagte, dass GPT-4o bei seinem Design die Sicherheit verschiedener Modi durch Techniken wie das Filtern von Trainingsdaten und die Verfeinerung des Verhaltens des Modells durch Nachtraining berücksichtigt. Das Team hat außerdem ein neues Sicherheitssystem zum Schutz der Sprachausgabe entwickelt.

OpenAI erklärte jedoch, dass man in den kommenden Wochen die neuen Audio- und Videofunktionen für GPT-4o zunächst „einer kleinen Gruppe vertrauenswürdiger Partner“ zur Verfügung stellen wolle, und verwies dabei auf das Missbrauchsrisiko.

Die Text- und Bildfunktionen von GPT-4o sind ab heute in ChatGPT verfügbar. In den kommenden Wochen wird OpenAI mit GPT-4o in ChatGPT Plus eine neue Version des Sprachmodells Alpha veröffentlichen. Entwickler können jetzt auch im Text- und im visuellen Modus der API auf GPT-4o zugreifen.

Ihre Ära ist da: ChatGPT emotionale Sprachinteraktion

Bereits im Februar dieses Jahres erwähnte der ehemalige Leiter der OpenAI-Entwicklerbeziehungen, dass die ultimative Form von ChatGPT nicht nur das Chatten sei.

Am 11. Mai sagte Sam Altman in einem Podcast außerdem, dass OpenAI die Qualität der Sprachfunktionen von ChatGPT weiter verbessern und steigern werde, und sagte, dass die Sprachinteraktion ein wichtiger Weg für zukünftige Interaktionsmethoden sei.

Auf der heutigen Pressekonferenz demonstrierte OpenAI auch seine Zwischenergebnisse bei der Verbesserung der Sprachqualität von ChatGPT – die Sprachinteraktion wurde auf Basis von GPT-4o erreicht und die Reaktionsgeschwindigkeit wurde erheblich verbessert.

Insbesondere spiegeln sich die Upgrades und Updates von ChatGPT hauptsächlich in drei Aspekten wider: Echtzeitinteraktion, multimodale Eingabe und Ausgabe sowie Emotionswahrnehmung.

In Bezug auf die Echtzeit-Interaktion kann ChatGPT in der Live-Demonstration nahezu sofort auf alle Fragen des Fragestellers antworten. Wenn der Fragesteller die Antwort von ChatGPT unterbricht, kann diese auch abgebrochen werden. Auf Wunsch des Publikums demonstrierte Muri Murati auch die Echtzeit-Übersetzungsfunktionen von GPT-4o.

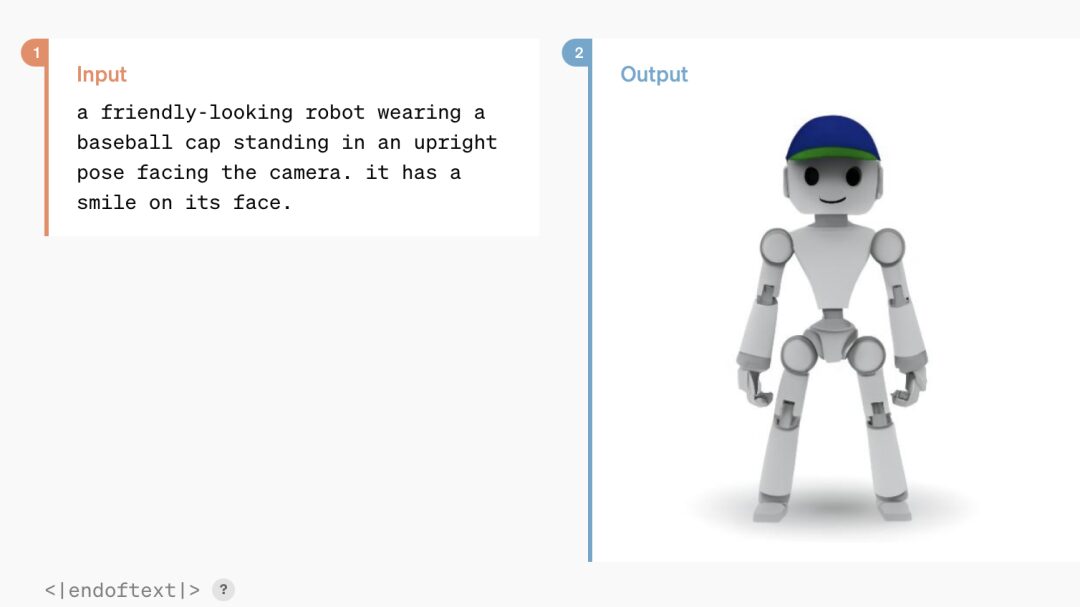

Auf die multimodale Eingabe/Ausgabe muss nicht näher eingegangen werden. ChatGPT basierend auf GPT-4o kann Text-, Sprach- und Bildinformationen erkennen und je nach Bedarf in jeder beliebigen Form antworten.

In Bezug auf Emotionswahrnehmung und emotionales Feedback kann das verbesserte ChatGPT die Gesichtsausdrücke einer Person anhand ihrer Selfies schnell analysieren. Außerdem kann es seinen Tonfall den Anforderungen des Gesprächspartners anpassen, von übertrieben dramatisch bis kalt und mechanisch, und sogar singen, was seine hervorragende Plastizität zeigt.

Muri Murati sagte hierzu: „Wir wissen, dass diese Modelle immer komplexer werden, hoffen aber, dass die interaktive Erfahrung dadurch natürlicher und einfacher wird, sodass Sie sich überhaupt nicht mehr um die Benutzeroberfläche kümmern müssen, sondern sich ganz auf die Zusammenarbeit mit GPT konzentrieren können, die sehr wichtig ist.“

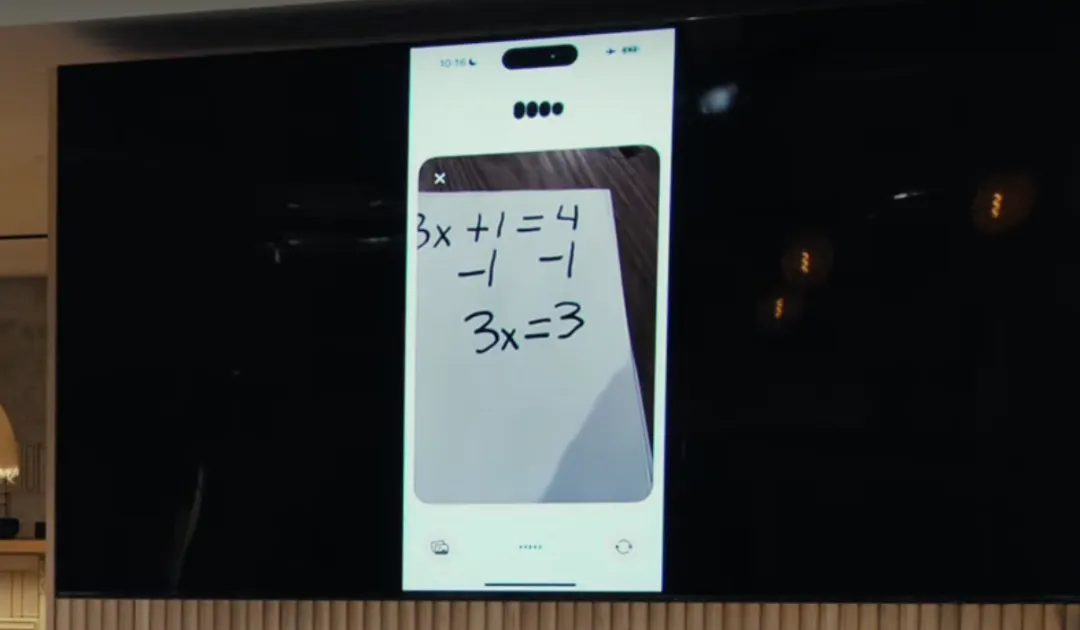

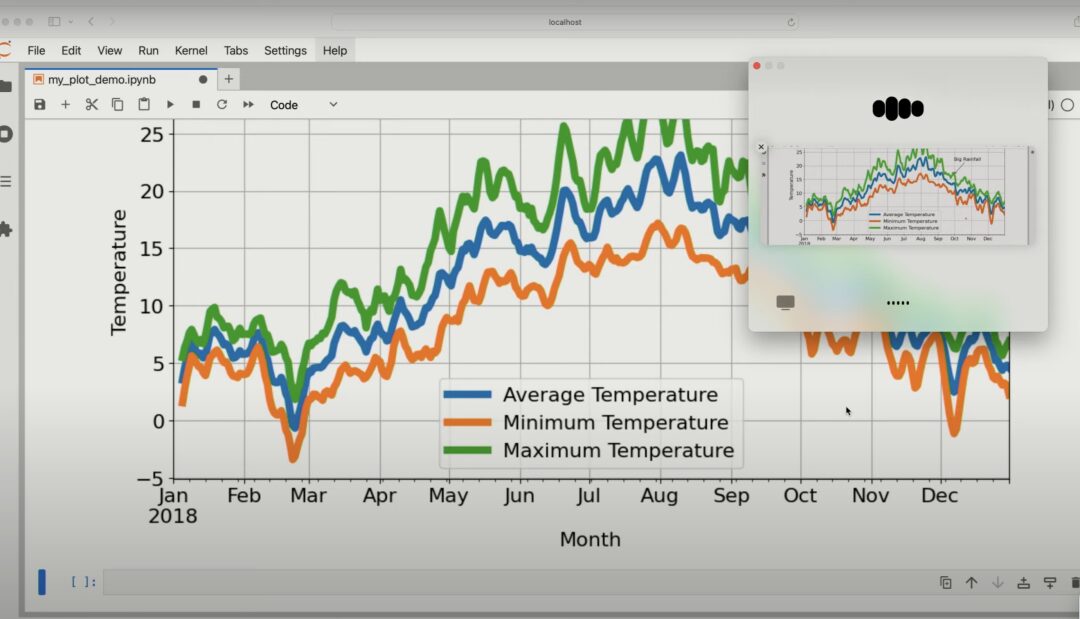

Darüber hinaus verbessert GPT-4o im Hinblick auf die Argumentationsanalyse auch die visuellen Fähigkeiten von ChatGPT. Anhand eines von Ihnen aufgenommenen Fotos kann ChatGPT schnell den Inhalt des Bildes durchsuchen und zugehörige Fragen beantworten, beispielsweise zum Aufnehmen eines Fotos zur Lösung einer Matheaufgabe.

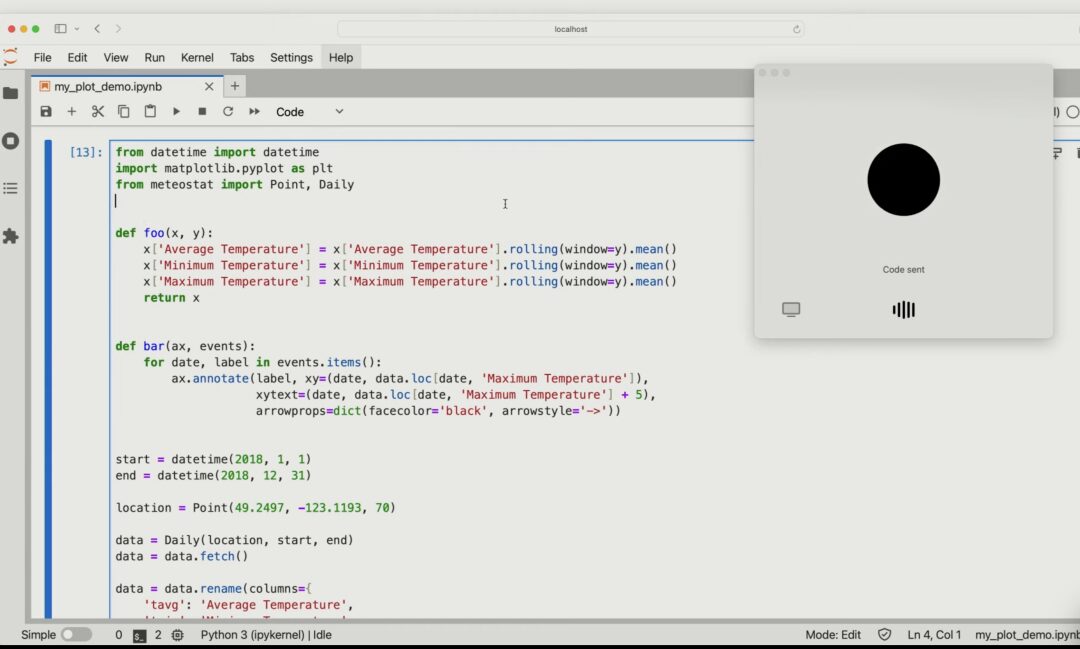

Sie können auch den spezifischen Inhalt des Codes basierend auf dem freigegebenen Codebild beschreiben und analysieren, welche spezifischen Auswirkungen auftreten, wenn eine der Variablen im Code geändert wird.

Geben Sie GPT-4o ein Diagramm und es kann den Inhalt des Diagramms im Detail analysieren.

Dieser innovative Versuch von OpenAI erweitert die Anwendung von ChatGPT auf Sprache, Text und Sehen, was darauf hindeutet, dass die Mensch-Computer-Interaktion in Zukunft natürlicher und reibungsloser sein könnte.

Als Reaktion darauf erklärte OpenAI, dass KI-Sprachassistenten mit visuellen und akustischen Funktionen das gleiche transformative Potenzial hätten wie Smartphones. Theoretisch können sie eine Reihe von Aufgaben erledigen, die den aktuellen KI-Assistenten nicht möglich sind. Sie können beispielsweise als Nachhilfelehrer für Abschlussarbeiten oder Mathematik fungieren, Verkehrsschilder übersetzen und bei der Lösung von Autoproblemen helfen.

Letzte Worte

Seit dem Aufkommen von GPT gilt OpenAI als „Barometer“ der Ära der großen Modelle. Zählen Sie die traditionellen Giganten im Silicon Valley herunter:

- Microsoft hat eine heikle Beziehung zu OpenAI. Das Unternehmen ist nicht nur ein Finanzinvestor, sondern hat das GPT-Modell auch in seinem eigenen Unternehmen implementiert und stellt OpenAI Cloud-Dienste bereit.

- Apple hat in diesem Jahr damit begonnen, seine Investitionen in generative KI zu erhöhen und ein eigenes großes Modell herausgebracht, allerdings begann es spät und es bleibt abzuwarten, ob es die Position von OpenAI erschüttern kann. Gleichzeitig gibt es Berichte, dass Apple bei großen Modellen bereits mit OpenAI und Google kooperiert.

- Als weltweit größter Anbieter von Cloud-Infrastrukturen hat Amazon mit Amazon Titan zwar auch ein eigenes großes Modell auf den Markt gebracht, dies ist jedoch nur ein Teil seines Cloud-Hosting-Dienstes Bedrock. Obwohl Amazon auch in Anthropic investiert hat, scheint es immer noch schwierig zu sein, mit OpenAI zu konkurrieren.

Im Vergleich dazu scheint Google das Unternehmen zu sein, das die größte Hoffnung hat, mit OpenAI konkurrieren zu können. Es verfügt nicht nur über eine tiefgreifende technische Akkumulation (die Transformer-Architektur stammt von Google), sondern auch über ein reichhaltiges Ökosystem, in dem große Modelle ihre Stärke zeigen können.

Leser, die Google verfolgen, werden jedoch möglicherweise feststellen, dass dieser alte Riese im Zeitalter der großen Modelle (Hundekopf, um Leben zu retten) ein wenig vom Körperbau von „Wang Feng“ hat – von Bard und PaLM 2, die in der Leistung GPT-4 unterlegen sind, über die Veröffentlichung des subversiven Meisterwerks Gemini 1.5, das von Sora in den Schatten gestellt wird, bis hin zur für März geplanten Google I/O-Konferenz, die von einer „improvisierten“ Live-Übertragung von OpenAI während der besten Werbezeit in den Schatten gestellt wird …

Erst heute Morgen (14. Mai) hat OpenAI das „beste Modell der Welt“ vorgestellt. Ich frage mich, ob Pichai nach der heutigen Pressekonferenz über Nacht „das Drehbuch ändern“ wird?

Die Antwort wird morgen früh bekannt gegeben. Wir freuen uns auf das Comeback von Google und HyperAI wird weiterhin Berichte aus erster Hand liefern!