Command Palette

Search for a command to run...

Kämpfe Bei Google I/O? OpenAI Wird Einen Tag Im Voraus Live Übertragen, ChatGPT Verfügt Möglicherweise Über Eine Anruffunktion

Im KI-Kreis dürfte es diese Woche sehr lebhaft zugehen.

Am 13. Mai Ortszeit wird OpenAI die Veröffentlichung der Updates für ChatGPT und GPT-4 live übertragen. Am nächsten Tag fand wie geplant die Google I/O statt. Anders als bei der I/O-Konferenz, der jährlichen Veranstaltung von Google, ist die vorübergehende Veröffentlichung von OpenAI dieses Mal ein kleiner Hype. Wie wird sich dieser langjährige „alte Rivale“ dieses Mal verhalten? Lassen Sie uns die Ursprünge der beiden Parteien betrachten und einige gewagte Vermutungen anstellen!

Mehrere Konfrontationsrunden, der Kampf ist in vollem Gange

Seit OpenAI für Furore gesorgt hat, wird Google als „enttäuscht“, „langsamer Start“ und „aufholend“ bezeichnet.Am erkenntniswürdigsten ist der Titel „AI Huangpu Militärakademie“.Es klingt wie ein Lob, aber in Wirklichkeit sind es Googles „Tränen der Bitterkeit“.

Wie wir alle wissen, basiert ChatGPT, das den Grundstein für OpenAI legte, auf der Transformer-Architektur.Transformer ist die von Google im Dokument „Attention Is All You Need“ vorgeschlagene Meilensteinarchitektur.Darüber hinaus tauchten viele ehemalige Google-Chefs in den Danksagungen zur ChatGPT-Release-Oberfläche auf, und anschließend wechselten viele wichtige Google-Mitarbeiter zu OpenAI ... Noch interessanter ist, dass es jedes Mal, wenn Google versucht, „zurückzuschlagen“, zu einigen kleinen Zwischenfällen kommt.

Im Februar 2023 schlug Google Bard zur Lösung von ChatGPT vor.Doch bald nach der Veröffentlichung stellte sich heraus, dass die Demonstration sachliche Fehler enthielt.

Als Antwort auf die Frage: „Was kann ich meinem 9-Jährigen über das James Webb Space Telescope (JWST) und seine Entdeckungen erzählen?“ Bard gab eine Antwort: Das erste Foto eines Exoplaneten wurde vom JWST aufgenommen. Grant Tremblay, Forscher am Harvard-Smithsonian Center for Astrophysics, weist jedoch darauf hin, dass es das Very Large Telescope (VLT) der Europäischen Südsternwarte war, das 2004 das erste Bild eines Exoplaneten machte.

Auf der I/O-Konferenz im Mai 2023 demonstrierte Google die Produkt-Upgrades von Bard.Beispielsweise unterstützt es mehr Sprachen, erkennt Bildinformationen, stellt eine Verbindung zu Google-Anwendungen und einigen externen Anwendungen her usw. Gleichzeitig hat Google auch PaLM2 veröffentlicht, ein mit GPT-4 vergleichbares Produkt, das Verbesserungen in den Bereichen Mathematik, Codierung, Argumentation und natürliche Sprachgenerierung aufweist.

Darauf aufbauend hat das Google Health Research Team auch Med-PaLM 2 entwickelt, das über Funktionen wie das Abrufen medizinischen Wissens und das Entschlüsseln medizinischer Fachbegriffe verfügt. Wie erwartet hat Google seine KI-Funktionen in Büroszenarien wie das Verfassen von Texten und die Erstellung von Tabellenkalkulationen integriert und Google Workspace eingeführt, das hinsichtlich des Modells mit GPT und hinsichtlich der Anwendung mit Microsoft vergleichbar ist.

Anschließend verglichen viele Internetnutzer PaLM 2 mit GPT-4 in verschiedenen Formen, und OpenAI lag wahrscheinlich immer noch vorne.

Im Dezember 2023 veröffentlichte Google Gemini, sein „größtes und leistungsstärkstes“ KI-Modell.Der Demonstrationseffekt ist in der Tat erstaunlich und die High-End-Version kann in der Leistung mit GPT-4 konkurrieren. Allerdings stellte sich heraus, dass das Demonstrationsvideo nachbearbeitet wurde und der Effekt teilweise übertrieben war.

Am 8. Februar 2024 gab Google bekannt, dass Bard offiziell in Gemini umbenannt wird.Der Chatbot Gemini Advanced, der von seinem leistungsstärksten Modell Gemini Ultra angetrieben wird, ist ebenfalls offiziell verfügbar, mit der gleichen „monatlichen Miete“ von 20 $ wie ChatGPT, was wie eine Konkurrenz wirkt. Die wichtigere Bedeutung dieser Veröffentlichung besteht darin, dass Google AI in Gemini vereinheitlicht wird, was sowohl der Modellname als auch der Produktname ist.

Am 16. Februar 2024, nur wenige Tage nach der Veröffentlichung seines leistungsstärksten Geräts Gemini 1.0 Ultra, brachte Google auf einen Schlag Gemini 1.5 auf den Markt.Unter ihnen kann Gemini 1.5 Pro bis zu 1 Million Token mit ultralangem Kontext unterstützen, übertrifft GPT-4 in Bezug auf die Anzahl der Token und erreicht so eine hervorragende Leistung bei Aufgaben wie der Audio- und Videoverarbeitung. Ohne Sora wäre Gemini 1.5 in KI-Kreisen wahrscheinlich noch lange ein heißes Thema.

Nur wenige Stunden nach der Veröffentlichung von Gemini 1.5 veröffentlichte OpenAI das Vincent-Videomodell Sora.Mit seinen beispiellosen Möglichkeiten zur Videogenerierung stand es sofort im Mittelpunkt und das einminütige Demonstrationsvideo stahl Gemini direkt die Show.

In dieser Runde gibt es zwar keinen Vergleich hinsichtlich der Technologie, aber der Sieger ist hinsichtlich der Popularität eindeutig entschieden. Auch OpenAI hat seine Position mit Hilfe von Sora weiter gefestigt.

Wird OpenAI erneut im Rampenlicht stehen?

Es ist erwähnenswert, dass der X-Netizen Jimmy Apples am 1. Mai die Neuigkeit verbreitete:Die Suchmaschine von OpenAI wird möglicherweise am 9. Mai veröffentlicht.Dieser Internetnutzer hat das Veröffentlichungsdatum von GPT-4 einmal genau vorhergesagt. Später sagte er, der Veröffentlichungstermin sei auf den 13. Mai verschoben worden.

Am 8. Mai berichtete Bloomberg außerdem, dass OpenAI intern eine neue Suchmaschine entwickelt, die durch generative KI-Frage-Antwort-Methoden ein neues Suchergebnis bieten wird. Bloomberg sagte, eine der Funktionen der Suchmaschine bestehe darin, dass sie Fragen mithilfe von Text und Bildern beantworten könne. Bloomberg berichtete, dass das Suchprodukt von OpenAI eine Erweiterung seines Flaggschiffprodukts ChatGPT ist und es ChatGPT ermöglicht, Informationen, einschließlich Zitaten, direkt aus dem Internet abzurufen. In früheren Berichten hat The Verge die Neuigkeiten bekannt gegeben.OpenAI wirbt Ingenieure aus der Suchabteilung von Google ab, um die Markteinführung seiner KI-Suchprodukte zu beschleunigen.

Scheint der Schritt von OpenAI, das bereits stabile Suchgeschäft ins Visier zu nehmen, ein wenig wie ein „direkter Angriff auf den Drachen“?

Am 11. Mai twitterte OpenAI jedoch offiziell, dass die Pressekonferenz am 13. nur Updates für ChatGPT und GPT-4 bringen würde, ohne „Suchmaschine“ überhaupt zu erwähnen. Das Datum 13. Mai ist jedoch recht interessant, da Google bereits angekündigt hat, am 14. Mai die Google I/O-Konferenz abzuhalten.

Dann deckte Sam Altman seine Karten direkt auf -Nicht GPT-5, keine Suchmaschine,Aber wir arbeiten ständig an neuen Sachen, von denen wir glauben, dass sie den Leuten gefallen werden! Es ist wie Magie für mich.

Nachdem Sam Altman zwei falsche Antworten entfernt hatte, rätselten die Internetnutzer immer noch begeistert, „was OpenAI veröffentlichen wird“, und es wurden weitere Hinweise enthüllt, darunter auch Sprachinteraktion.

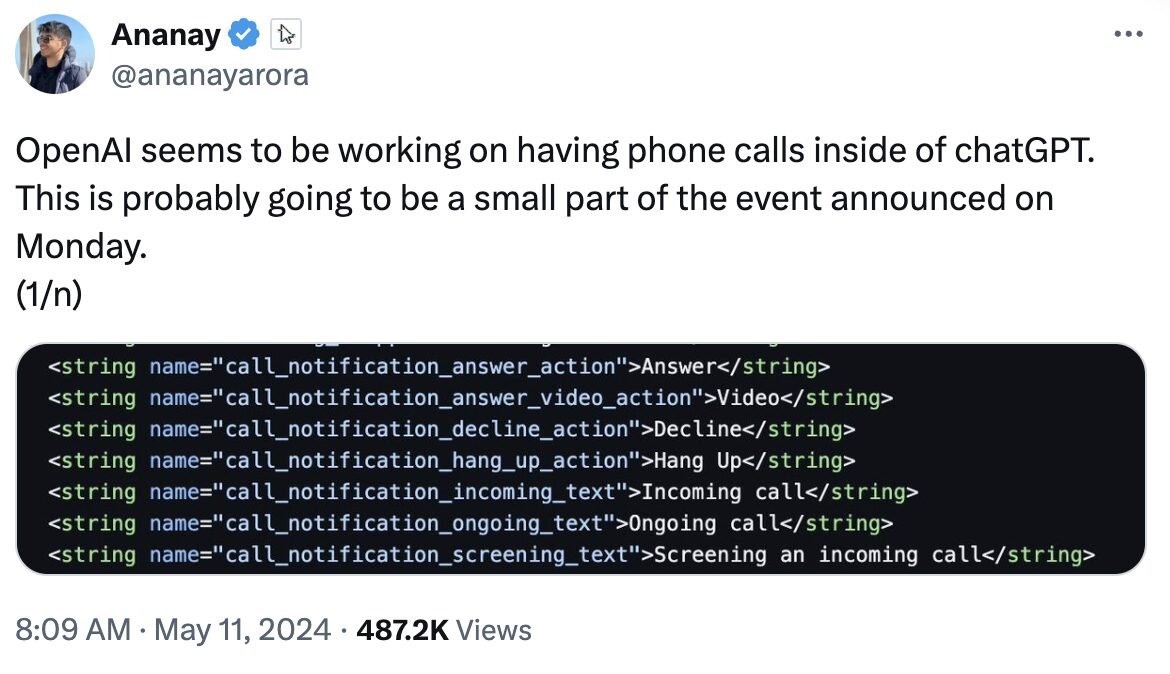

Laut The Information hat OpenAI seinen Benutzern ein neues Modell vorgeführt, das sowohl kommunizieren als auch Objekte erkennen kann und so ein schnelleres und genaueres Bild- und Audioverständnis ermöglicht. Laut The Verge sagte Entwickler Ananay Arora, dass ChatGPT möglicherweise über eine Anruffunktion verfügt. Arora fand auch Beweise dafür, dass OpenAI Server für Audio- und Videokommunikation in Echtzeit bereitstellte.

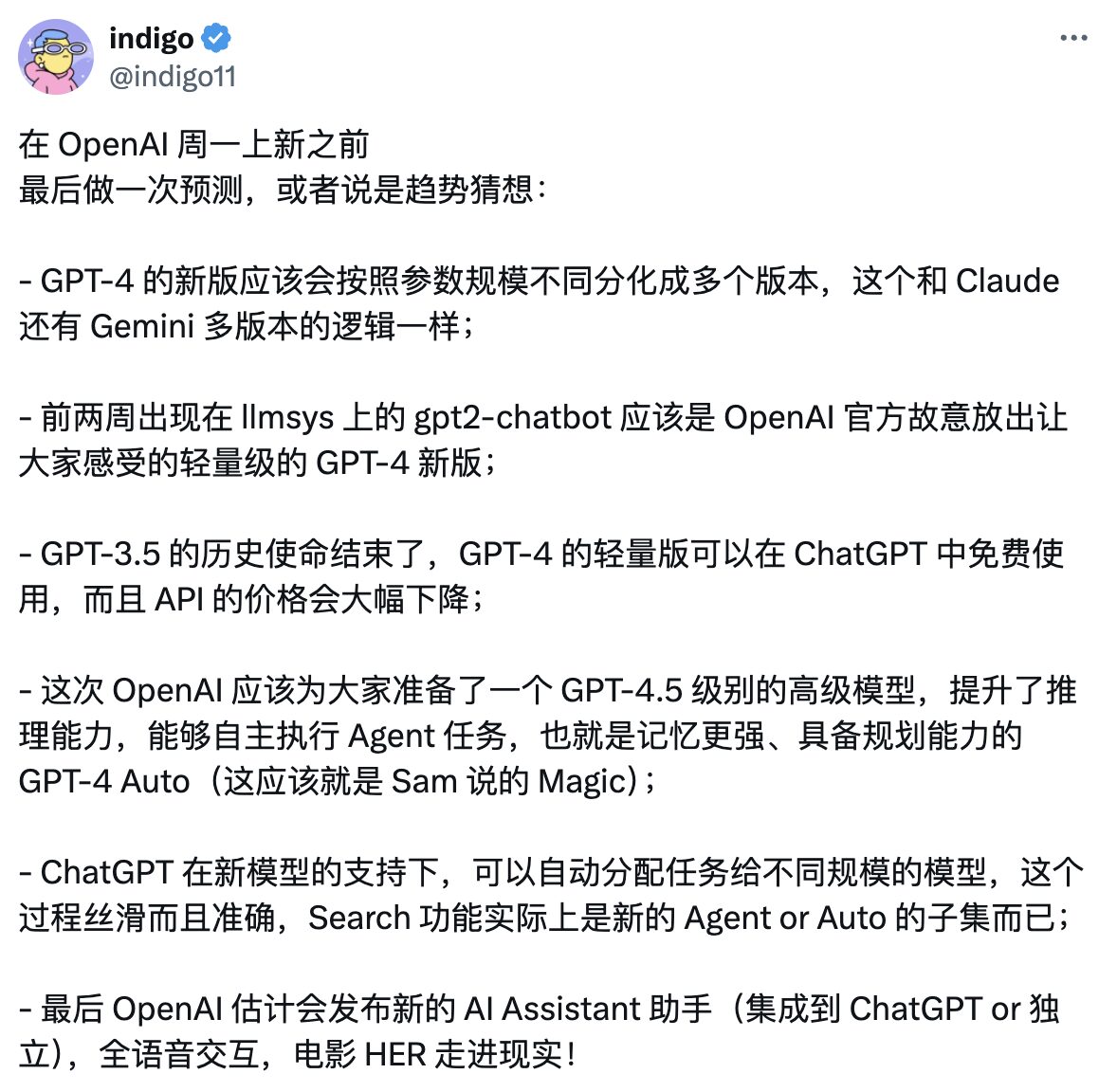

Darüber hinaus veröffentlichte Halliday-Mitbegründer Indigo auf seinem Twitter-Konto (X) eine detailliertere Vorhersage, in der er nicht nur GPT-4.5 erwähnte, sondern auch vorhersagte, dass der neue KI-Assistent von OpenAI die vollständige Sprachinteraktion unterstützen wird.

Aus einer bestimmten Perspektive betrachtet,Obwohl Sam Altman die „Suchmaschine“ dementierte, sagte er nicht, dass er ChatGPT keinen „Such-Buff“ hinzufügen würde.Tatsächlich haben Internetnutzer in letzter Zeit zahlreiche Beweise dafür gefunden, dass OpenAI in das Suchfeld Einzug gehalten hat.

Zuerst verkündete Lior S, ein ehemaliger Mila-Forscher und MIT-Dozent, die Neuigkeiten.Das neueste SSL-Zertifikatsprotokoll von OpenAI zeigt, dass die Subdomäne search.chatgpt.com erstellt wurde.

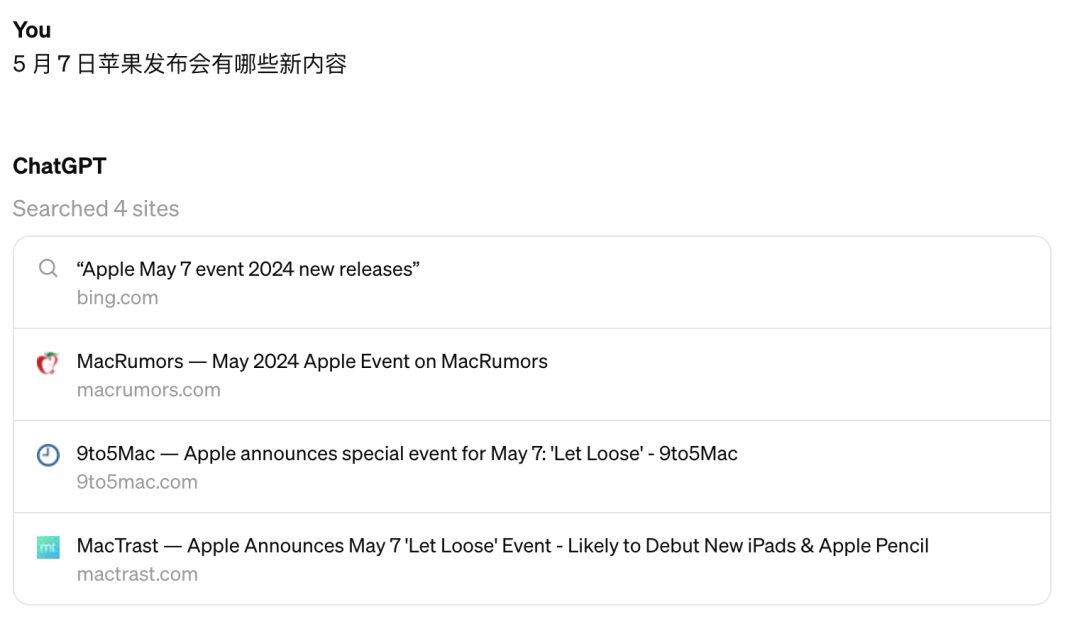

Einige Internetnutzer in China haben den Graustufentest erhalten und „Cyber Zen Heart“ hat die Testergebnisse auf seinem offiziellen Konto veröffentlicht:

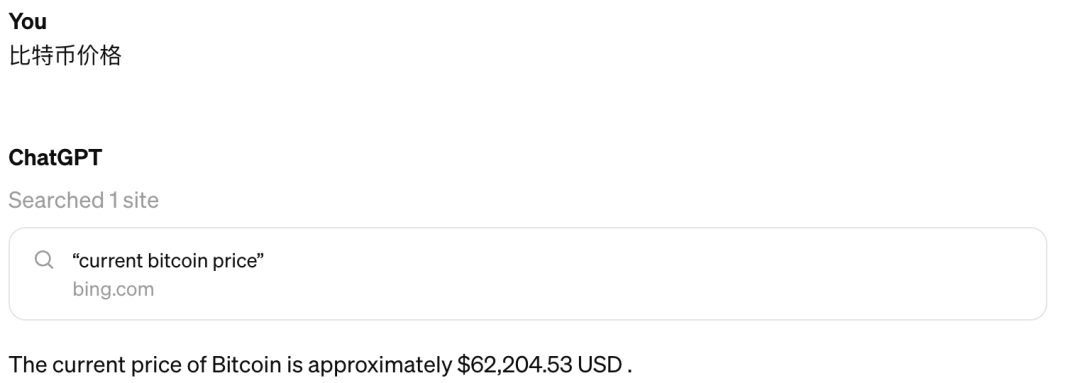

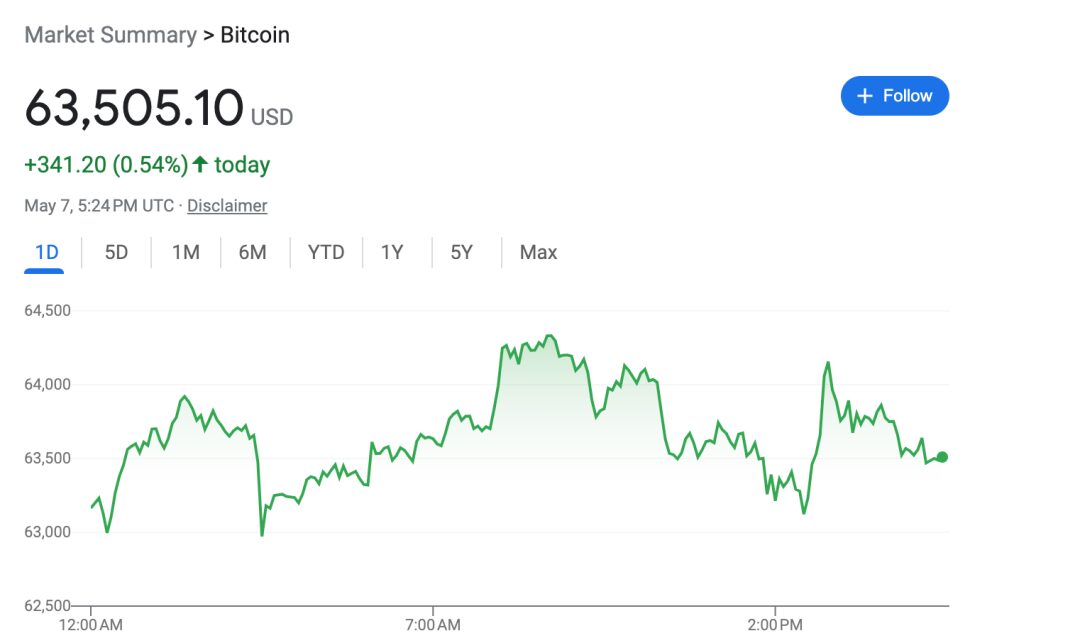

Wie Sie sehen, sind die Antworten von ChatGPT ziemlich genau und laut Cyber Zen Heart ist auch die Antwortgeschwindigkeit akzeptabel. Jedoch,ChatGPT ist nicht gut darin, Echtzeitinformationen zu erhalten.Cyber Zen hat nach Bitcoin-Preisen gesucht und diese mit den bei Google gefundenen Preisen verglichen:

Darüber hinaus hat ein Internetnutzer direkt auf Twitter eine Demo gepostet, die behauptet, die offizielle OpenAI-KI-Suchseite zu sein, die sich jedoch stark von der Graustufen-Testoberfläche unterscheidet:

Derzeit ist noch nicht bekannt, ob das Suchprodukt von OpenAI irgendwann in Form eines Graustufentests der Öffentlichkeit zugänglich gemacht wird. Insgesamt muss es sich nicht nur um Google, sondern auch um Perplexity AI als Konkurrenten behaupten. Genau genommen,In gewisser Weise ist Perplexity AI das Produkt, mit dem OpenAI im Suchgeschäft direkt konkurrieren sollte.

Heute steht dieses KI-Tool, das behauptet, „die erste Konversationssuchmaschine der Welt“ zu sein, im Rampenlicht und hat Unterstützung von Jensen Huang sowie Investitionen von Größen wie Bezos erhalten. Seine Einzigartigkeit liegt in der Kombination von Fragen und Antworten im ChatGPT-Stil und der Linkliste traditioneller Suchmaschinen.

In welcher Form wird OpenAI im KI-Zeitalter am Wettbewerb auf dem Suchmaschinenmarkt teilnehmen? Warten wir ab, ob die Suchfunktion von ChatGPT auf der Pressekonferenz am 13. Mai enthüllt wird.

Kann sich Google I/O ausschließlich auf Gemini verlassen, um die Führung zu übernehmen?

Es bleibt abzuwarten, ob die Pressekonferenz von OpenAI – absichtlich oder unabsichtlich – größere Updates enthüllt, aber ich glaube, Google wird sich die Live-Übertragung auf jeden Fall pünktlich ansehen. Wenn es eine Überraschung gibt, frage ich mich, ob Pichai in der Lage sein wird, schnell zu reagieren und rechtzeitig auf der Google I/O-Konferenz einen Tag später zurückzuschlagen?

Im Vergleich dazu fehlt es der jährlichen Google I/O-Konferenz an einigen Geheimnissen. Die auf der offiziellen Seite der Konferenz angekündigten Schwerpunkte sind: Mobilgeräte, Web, ML/KI und Cloud.

Wie üblich wird der CEO des Unternehmens, Sundar Pichai, in seiner Grundsatzrede Android-Updates, Hardwareprodukte der neuen Generation, Googles neueste Fortschritte und Erfolge im Bereich KI sowie die Integration seiner KI-Funktionen in das gesamte Ökosystem von Google vorstellen.

* Gemini stärkt das gesamte Ökosystem von Google

Es besteht kein Zweifel, dass Gemini das Highlight der diesjährigen Google I/O-Konferenz sein wird. Gemini 1.5, das erst im Februar dieses Jahres aktualisiert wurde, hat die Kontextlänge auf Millionen erhöht und seine Leistung kann bereits mit GPT-4 konkurrieren. Daher besteht der nächste Schritt für Google darin, sich mit der Frage der praktischen Anwendung zu befassen – wie Gemini in seine Such-, Foto- und Videotools, Google Maps und Arbeitsbereichstools wie Gmail und Google Docs integriert werden kann.

Darüber hinaus hat Google seine KI-Funktionen schrittweise in den Google Assistant integriert. Können die leistungsstarken Funktionen von Gemini einen fortschrittlicheren und menschenähnlicheren Sprachassistenten für natürliche Sprache schaffen?

Es ist erwähnenswert, welche Funken Gemini und Googles eigenes Pixel schlagen können, da sie beide Unternehmen besitzen, die sowohl fortschrittliche Großmodelle als auch Hardware-Geschäfte besitzen. Letztes Jahr gab es Berichte, dass auf dem Pixel 9 ein KI-Assistent namens Pixie erscheinen könnte.

Das Pixel 8, das letztes Jahr auf der Google I/O-Konferenz vorgestellt wurde, verfügt bereits über die KI-Funktionen von Google. Es ist mit dem von Google selbst entwickelten Chip-Prozessor Tensor G3 ausgestattet und verfügt über Funktionen wie Audio Magic Eraser, Best Take, Übersetzung und Vorlesen von Webseiten usw. Mit der Best Take-Funktion können beispielsweise mehrere Gruppenfotos miteinander kombiniert und die Gesichtsausdrücke verschiedener Personen aus verschiedenen Bildern ausgewählt werden, um ein perfektes Gruppenfoto zu erstellen.

Wie üblich wird das Pixel 9 auf der diesjährigen Konferenz vorgestellt, es ist in den aktuellen Leaks jedoch nicht zu sehen. Stattdessen erfreute sich Pixel 8a größerer Beliebtheit. Ob die KI-Assistentin Pixie einen Auftritt haben wird, bleibt abzuwarten.

Darüber hinaus verbreiteten ausländische Medien im April dieses Jahres die Nachricht, dass Apple und Google zusammenarbeiten, um Gemini in das iOS-System zu integrieren. Keines der Unternehmen hat die Nachricht offiziell bestätigt. Wenn die Nachricht stimmt, kann man von einer „jahrhundertealten Zusammenarbeit“ zwischen zwei Giganten sprechen, die in vielen Geschäftsbereichen miteinander im Wettbewerb stehen. Ich frage mich, ob Pichai die entsprechenden Neuigkeiten auf der Google I/O-Konferenz bekannt geben wird.

* Android und AR/XR

Als Eckpfeiler von Google ist Android immer ein unverzichtbarer Bestandteil der Google I/O-Konferenz. In diesem Jahr wurde Android 15 vorgestellt; Entwicklervorschauen und erste Betaversionen sind bereits veröffentlicht. Pichai wird in seiner Rede sicherlich auch die wichtigsten Neuerungen des Systems vorstellen. Laut zuvor veröffentlichten Informationen wird auch die auf Android Auto basierende Software Wear OS für Smartautos und Smartwatches eingeführt.

Darüber hinaus berichteten einige Medien, dass Pichai Neuigkeiten über die AR-Software von Google veröffentlichen und die Android XR-Plattform vorstellen werde, die es für Samsung und andere Head-Display-Hersteller entwickelt habe. Berichten aus diesem Jahr zufolge war das AR-Hardware-Team von Googles Entlassungswelle am stärksten betroffen, weshalb einige Medien spekulierten, das Unternehmen habe die Entwicklung eigener AR-Hardware aufgegeben und setze nun voll und ganz auf das OEM-Kooperationsmodell. Mit anderen Worten: Google wird sich auf die Softwareebene konzentrieren.

Neben der Keynote-Rede von Pichai Ge gibt es auf der diesjährigen Google I/O-Konferenz auch mehrere Themenforen, beispielsweise die neuesten Entwicklungen bei Google AI, Neuentwicklungen bei Android, ML-Frameworks für das Zeitalter der generativen KI usw. Es wird jedoch keine Live-Übertragung angeboten. Entsprechendes Videomaterial wird nach der Rede veröffentlicht. HyperAI wird dem Thema KI auch weiterhin Aufmerksamkeit schenken und ausführliche Berichte dazu liefern. Bleiben Sie dran~

Letzte Worte

In der Vergangenheit war die Industrie ein wichtiger Maßstab für die Stärke eines Landes. Heute ist die wissenschaftliche und technologische Stärke auch auf dem Verhandlungstisch angekommen und sogar zu einem Verhandlungsinstrument im Spiel der Großmächte geworden. Besonders da die Popularität großer Models weiterhin hoch ist, erregt jeder Schritt der Giganten des Silicon Valley große Aufmerksamkeit. Ich erinnere mich noch daran, dass OpenAI, Microsoft, Google usw. Ende 2022 immer plötzlich große Updates veröffentlichten und die Internetnutzer ausriefen: Hat sich der KI-Kreis nach dem Aufwachen wieder verändert?

Auch mit Beginn des Jahres 2024 heizt sich der Kampf noch immer auf. Vom Wettrennen auf technischer Ebene bis hin zur Entwicklung von Anwendungsszenarien, von alten Kraftpaketen bis hin zu neuen Einhörnern – die Unternehmen, die den Trend weiterhin dominieren können, müssen diejenigen sein, die über Burggräben verfügen. Und was den Kampf der Großen an der Spitze der Pyramide angeht: Lasst uns alle unsere kleinen Hocker bewegen und dem Kampf zwischen den Göttern zusehen!

Quellen:

1.https://36kr.com/p/2660898993824512

2.https://techcrunch.com/2024/05/09/google-i-o-2024-what-to-expect/

3.https://www.spiceworks.com/tech/tech-general/articles/google-io-2024-expectations

4.https://www.theverge.com/2024/5/11/24154307/openai-multimodal-digital-assistant-chatgpt-phone-calls