Command Palette

Search for a command to run...

Google Veröffentlicht HEAL-Framework, 4 Schritte Zur Bewertung Der Fairness Medizinischer KI-Tools

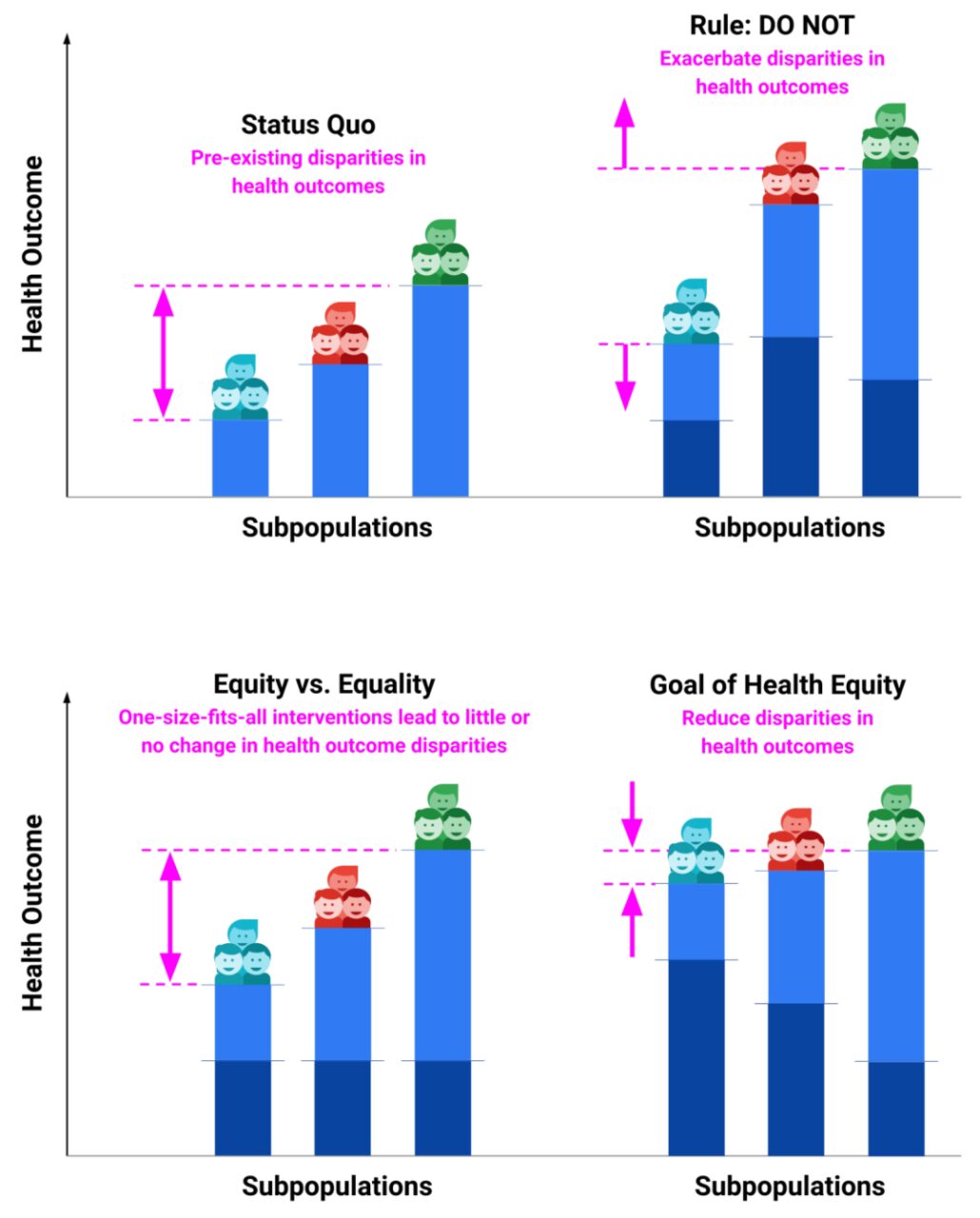

Wenn man sich die Gesunderhaltung als Wettrennen vorstellt, können nicht alle von der gleichen Startlinie aus starten. Manche Menschen können problemlos bis zum Ende laufen und manche Menschen können sofort Hilfe holen, selbst wenn sie stürzen. Manche Menschen stehen jedoch aufgrund ihrer wirtschaftlichen Lage, ihres Wohnorts, ihres Bildungsniveaus, ihrer Rasse oder anderer Faktoren möglicherweise vor größeren Hindernissen.

„Gesundheitsgerechtigkeit“ bedeutet, dass jeder den gleichen Zugang zu den Ressourcen der Gesundheitsversorgung haben sollte, damit er diesen Wettlauf gelassener beenden und eine optimale Gesundheit erreichen kann.Eine unfaire Behandlung bestimmter Gruppen (wie etwa Minderheiten, Menschen mit niedrigem sozioökonomischen Status oder Personen mit eingeschränktem Zugang zur Gesundheitsversorgung) bei der Prävention, Diagnose und Behandlung von Krankheiten kann ihre Lebensqualität und Überlebenschancen erheblich beeinträchtigen. Es besteht kein Zweifel daran, dass eine verstärkte Aufmerksamkeit für die „Gesundheitsgerechtigkeit“ zu einem globalen Konsens werden sollte, um die Ursachen der Ungleichheit stärker anzugehen.

Obwohl maschinelles Lernen, Deep Learning usw. heutzutage im medizinischen Bereich „einige Erfolge erzielt“ haben, haben sie sogar den Schritt aus den Laboren in die klinische Praxis getan. Wenn man die leistungsstarken Fähigkeiten der KI bestaunt, sollte man sich stärker mit der Frage befassen, ob die praktische Anwendung dieser Art neuer Technologien die Ungleichheit der Gesundheitsressourcen verschärfen wird.

*Hellblaue Balken zeigen bereits bestehende gesundheitliche Folgen an

* Dunkelblaue Balken veranschaulichen die Auswirkungen von Interventionen auf bereits bestehende Gesundheitsergebnisse

Zu diesem Zweck hat das Google-Team das HEAL-Framework (The Health Equity Framework) entwickelt, mit dem quantitativ bewertet werden kann, ob auf maschinellem Lernen basierende Gesundheitslösungen „fair“ sind.Mit diesem Ansatz möchte das Forschungsteam sicherstellen, dass neue Gesundheitstechnologien gesundheitliche Ungleichheiten wirksam verringern, anstatt sie unbeabsichtigt zu verschärfen.

HEAL-Framework: 4 Schritte zur Bewertung der Fairness von KI-Tools in der Dermatologie

Das HEAL-Framework besteht aus 4 Schritten:

- Identifizieren Sie Faktoren, die mit Gesundheitsungleichheiten in Zusammenhang stehen, und definieren Sie Leistungskennzahlen für KI-Tools.

- Identifizieren und quantifizieren Sie bereits bestehende gesundheitliche Ungleichheiten

- Leistungstests für KI-Tools

- Messung des Potenzials von KI-Tools zur Priorisierung von Ungleichheiten im Gesundheitswesen

Schritt 1: Identifizieren Sie Faktoren, die mit Gesundheitsungleichheiten in der Dermatologie verbunden sind, und ermitteln Sie Kennzahlen zur Bewertung der Leistung von KI-Tools

Die Forscher wählten die folgenden Faktoren aus – Alter, Geschlecht, Rasse/Ethnie und Fitzpatrick-Hauttyp (FST) – indem sie die Literatur durchsahen und die Datenverfügbarkeit berücksichtigten.

Der FST ist ein System zur Klassifizierung der menschlichen Haut auf Grundlage ihrer Reaktion auf ultraviolette (UV-)Strahlung, insbesondere Sonnenbrand und Bräunung. Die Typen FST I bis FST VI stehen jeweils für ein unterschiedliches Maß an Melaninproduktion in Haut, Augen und Haaren sowie für eine unterschiedliche Empfindlichkeit gegenüber UV-Strahlen.

Darüber hinaus wählten die Forscher die Top-3-Übereinstimmung als Maßstab zur Bewertung der Leistung des KI-Tools. Diese ist definiert als der Anteil der Fälle, in denen mindestens eine der drei wichtigsten von der KI vorgeschlagenen Erkrankungen mit der Referenzdiagnose des dermatologischen Expertengremiums übereinstimmte.

Schritt 2: Identifizieren Sie bestehende „Gesundheitsunterschiede“ in der Dermatologie

Indikatoren für gesundheitliche Ungleichheit sind spezifische Maßnahmen zur Quantifizierung und Beschreibung der Ungleichheit im Gesundheitszustand verschiedener Gruppen. Diese Gruppen werden nach Rasse, wirtschaftlichem Status, geografischem Standort, Geschlecht, Alter, Behinderungsstatus oder anderen sozialen Faktoren unterschieden.

Hier sind einige allgemeine Indikatoren für gesundheitliche Ungleichheiten:

Behinderungsbereinigte Lebensjahre (DALYs): Gibt die Anzahl der Jahre gesunden Lebens wieder, die aufgrund von Krankheit, Behinderung oder vorzeitigem Tod verloren gehen. DALY ist ein zusammengesetzter Indikator, der die Summe der potenziell verlorenen Lebensjahre (YLLs) und der mit Behinderung gelebten Jahre (YLDs) darstellt.

Verlorene Lebensjahre (YLLs): Erwartete Anzahl der durch vorzeitigen Tod verlorenen gesunden Jahre.

Die Forscher führten außerdem eine Unteranalyse zum Thema Hautkrebs durch, um zu verstehen, wie die Leistung des KI-Tools unter Hochrisikobedingungen variierte. Zur Schätzung der gesundheitlichen Folgen für alle Krebsarten verwendeten wir die Kategorien „Nicht-Melanom-Hautkrebs“ und „Malignes Hautmelanom“ der Global Burden of Disease (GBD) sowie die Kategorie „Haut- und Unterhauterkrankungen“ für alle nicht krebsartigen Erkrankungen.

Schritt 3: Messen Sie die Leistung von KI-Tools

Die Top-3-Übereinstimmung wurde durch Vergleich der von der KI vorhergesagten Pathologien mit Referenzdiagnosen in einem Auswertungsdatensatz (Subpopulationen, stratifiziert nach Alter, Geschlecht, Rasse/Ethnie und eFST) gemessen.

Schritt 4: Testen der Leistung von KI-Tools bei der Berücksichtigung gesundheitlicher Ungleichheiten

Um die HEAL-Metrik des KI-Tools für Hautkrankheiten zu quantifizieren, lautet die spezifische Methode wie folgt:

Für jede Teilpopulation sind zwei Eingaben erforderlich:Quantitative Messungen bereits bestehender gesundheitlicher Ungleichheiten und der Leistung von KI-Tools.

Berechnen Sie die inverse Korrelation R zwischen Gesundheitsergebnissen und KI-Leistung über alle Untergruppen hinweg für einen gegebenen Ungleichheitsfaktor (z. B. Rasse/Ethnie). Je größer der positive Wert von R, desto umfassender ist die Berücksichtigung der Gesundheitsgerechtigkeit.

Die HEAL-Metrik des KI-Tools ist wie folgt definiert: p(R > 0), wodurch die Wahrscheinlichkeit geschätzt wird, dass die KI bereits bestehende Gesundheitsunterschiede durch die R-Verteilung von 9.999 Stichproben priorisiert. Ein HEAL-Index von mehr als 50% bedeutet eine höhere Wahrscheinlichkeit, gesundheitliche Gerechtigkeit zu erreichen, während ein HEAL-Index von weniger als 50% eine geringere Wahrscheinlichkeit bedeutet, eine gerechte Leistung zu erzielen.

Überprüfung des KI-Tools für die Dermatologie: Einige Untergruppen müssen noch verbessert werden

Rasse/Ethnie: Der HEAL-Indikator liegt bei 80,5%, was darauf hinweist, dass der Beseitigung der zwischen diesen Untergruppen bestehenden Gesundheitsunterschiede eine hohe Priorität eingeräumt wird.

Geschlecht: Der HEAL-Indikator beträgt 92,1%, was darauf hinweist, dass das Geschlecht bei der Berücksichtigung gesundheitlicher Unterschiede bei der Leistung von KI-Tools eine hohe Priorität hat.

Alter: Der HEAL-Indikator beträgt 0,0%, was auf eine geringe Wahrscheinlichkeit hinweist, dass Gesundheitsunterschieden zwischen Altersgruppen Priorität eingeräumt wird. Für die Krebserkrankung beträgt der HEAL-Index 73,8%, während der HEAL-Index für die Nicht-Krebserkrankung 0,0% beträgt.

Die Forscher führten eine logistische Regressionsanalyse durch, die zeigte, dass das Alter und bestimmte dermatologische Erkrankungen (wie Basalzellkarzinom und Plattenepithelkarzinom) einen erheblichen Einfluss auf die Leistung der KI hatten, während andere Erkrankungen (wie Zysten) weniger genau waren.

Darüber hinaus führten die Forscher eine intersektionale Analyse durch und verwendeten dabei segmentierte Instrumente zur Messung der Gesundheitsergebnisse von GBD, um die HEAL-Analyse auf Alter, Geschlecht und Rasse/Ethnie auszuweiten, mit einem HEAL-Gesamtindex von 17,0%.Indem wir uns speziell auf die Schnittstelle zwischen niedrigen Bewertungen im Gesundheitsbereich und der KI-Leistung konzentrierten, identifizierten wir Untergruppen, deren KI-Tool-Leistung verbessert werden muss. Dazu gehören hispanische Frauen ab 50 Jahren, schwarze Frauen ab 50 Jahren, weiße Frauen ab 50 Jahren, weiße Männer im Alter von 20 bis 49 Jahren und asiatisch-pazifische amerikanische Männer ab 50 Jahren.

Allerdings ist die Verbesserung der Leistung von KI-Tools für diese Gruppen von entscheidender Bedeutung, um gesundheitliche Chancengleichheit zu erreichen.

Mehr als nur Gesundheitsgerechtigkeit: Das umfassendere Bild der Fairness in der KI

Es ist offensichtlich, dass zwischen verschiedenen Rassen-/Ethnie-, Geschlechts- und Altersgruppen erhebliche Ungleichheiten im Gesundheitsbereich bestehen. Insbesondere durch die rasante Entwicklung hochtechnologischer Medizintechnik hat sich das Ungleichgewicht der Gesundheitsressourcen sogar noch verschärft. Bei der Lösung entsprechender Probleme hat die KI noch einen langen Weg vor sich. Man muss jedoch beachten, dass die durch den technologischen Fortschritt verursachte Ungerechtigkeit tatsächlich alle Aspekte des Lebens der Menschen betrifft. So ist beispielsweise die durch die digitale Kluft bedingte Ungleichheit beim Zugang zu Informationen, Online-Bildung und digitalen Diensten spürbar.

Jeff Dean, Leiter von Google AI und ein „Programmiergott“, sagte einmal, dass Google großen Wert auf KI-Fairness legt und viel Arbeit in die Bereiche Daten, Algorithmen, Kommunikationsanalyse, Modellinterpretierbarkeit, Erforschung kultureller Unterschiede und Datenschutz großer Modelle gesteckt hat. Zum Beispiel: * Im Jahr 2019 setzten das Responsible AI Product Review Committee und das Responsible AI Transaction Review Committee von Google Cloud die Entwicklung kreditbezogener KI-Produkte aus, um eine Verschärfung der algorithmischen Ungerechtigkeit oder Voreingenommenheit zu vermeiden. * Im Jahr 2021 überprüfte das Advanced Technologies Review Board die Forschung mit großen Sprachmodellen und kam zu dem Schluss, dass diese mit Vorsicht fortgesetzt werden könne, das Modell jedoch erst offiziell eingeführt werden könne, wenn eine umfassende Überprüfung der KI-Prinzipien durchgeführt worden sei. * Das Google DeepMind-Team hat einmal ein Papier veröffentlicht, in dem es darum ging, „wie man menschliche Werte in KI-Systeme integriert“ und philosophische Ideen in die KI integriert, um ihr dabei zu helfen, soziale Gerechtigkeit herzustellen.

Um die Fairness der KI-Technologie zu gewährleisten, sind künftig Interventionen und Steuerung aus mehreren Blickwinkeln erforderlich, beispielsweise:

* Faire Datenerhebung und -verarbeitung:Stellen Sie sicher, dass Ihre Trainingsdaten Vielfalt beinhalten, einschließlich Menschen unterschiedlichen Geschlechts, Alters, unterschiedlicher Rasse, Kultur und sozioökonomischer Herkunft. Gleichzeitig sollte eine Datenauswahl aufgrund von Verzerrungen vermieden werden, um die Repräsentativität und Ausgewogenheit des Datensatzes sicherzustellen.

* Beseitigung algorithmischer Verzerrungen:Identifizieren und beseitigen Sie während der Modellentwurfsphase proaktiv algorithmische Verzerrungen, die zu unfairen Ergebnissen führen können. Dies kann eine sorgfältige Auswahl der Eingabefunktionen für das Modell oder die Verwendung spezifischer Techniken zur Reduzierung oder Beseitigung von Verzerrungen beinhalten.

* Fairnessbewertung:Fairnessbewertungen sollten vor und nach der Modellbereitstellung durchgeführt werden. Hierzu gehört die Verwendung verschiedener Fairnessmetriken, um die Auswirkungen des Modells auf unterschiedliche Gruppen zu bewerten und auf Grundlage der Bewertungsergebnisse die erforderlichen Anpassungen vorzunehmen.

* Kontinuierliche Überwachung und iterative Verbesserung:Nach der Bereitstellung des KI-Systems sollte seine Leistung in der tatsächlichen Umgebung kontinuierlich überwacht werden, um mögliche Ungerechtigkeitsprobleme umgehend zu erkennen und zu beheben. Dies kann eine regelmäßige Iteration der Modelle erfordern, um sie an Umweltveränderungen und neue soziale Normen anzupassen.

Mit der Entwicklung der KI-Technologie werden die relevanten ethischen Standards sowie Gesetze und Vorschriften weiter verbessert, sodass sich die KI-Technologie in einem gerechteren Rahmen entwickeln kann. Gleichzeitig wird ein stärkerer Fokus auf Diversität und Inklusion gelegt. Dies erfordert die Berücksichtigung der Bedürfnisse und Merkmale verschiedener Gruppen in jedem Aspekt, einschließlich der Datenerfassung, des Algorithmendesigns und der Produktentwicklung.

Auf lange Sicht sollte die wahre Bedeutung der lebensverändernden Wirkung von KI darin liegen, Menschen unterschiedlichen Geschlechts, Alters, unterschiedlicher Rasse, Kultur und sozioökonomischer Herkunft besser zu unterstützen und die durch den Einsatz der Technologie verursachte Ungerechtigkeit zu verringern. Können wir angesichts des zunehmenden öffentlichen Bewusstseins mehr Menschen in die Planung der KI-Entwicklung einbeziehen und Vorschläge zur Entwicklung der KI-Technologie machen, um sicherzustellen, dass die Entwicklung der Technologie im Einklang mit den Gesamtinteressen der Gesellschaft steht?

Der große Plan für Fairness in der KI-Technologie erfordert gemeinsame Anstrengungen aus mehreren Bereichen wie Technologie, Gesellschaft und Recht. Wir müssen sicherstellen, dass die Spitzentechnologie nicht zum Treiber des „Matthäus-Effekts“ wird.