Command Palette

Search for a command to run...

Online-Tutorial | Ein-Klick-Start Der Open-Source-Alternative Sora, Die 450.000 KI-Entwickler Anspricht

Im Jahr 1888 reichte Edison ein Patent für einen „Bewegtbildprojektor“ ein, ein Gerät, das erstmals statische Fotos kontinuierlich abspielte und dabei einen dynamischen Bildeffekt erzeugte und damit den Auftakt zur Entwicklung des Videos bildete.

Rückblickend hat Video die Entwicklung von nichts zu etwas, von Schwarzweiß zu Farbe und von analogen zu digitalen Signalen durchlaufen. In der Vergangenheit umfasste die Videoproduktion mehrere Schritte wie die Erstellung des Skripts/Drehbuchs, das Aufnehmen, den Schnitt, die Synchronisation und das Korrekturlesen. Bis heute folgt alles, von populären Videos auf Kurzvideoplattformen bis hin zu Filmen mit großem Budget, die in den Kinos laufen, diesem langkettigen Produktionsformat.

Mit dem Aufkommen der generativen KI hat in den letzten Jahren auch die Videoproduktion Innovationen hervorgebracht.Seit dem Aufkommen von ChatGPT hat die Fähigkeit der generativen KI zum Textverständnis immer wieder für Überraschungen gesorgt.

Am 26. Februar veröffentlichte OpenAI das Sora-Modell, das durch den Empfang von Textanweisungen bis zu einer Minute Videomaterial generieren kann. Es ist nicht nur in der Lage, lange Texte gut zu verstehen, sondern kann auch reale physikalische Situationen verstehen und simulieren und so komplexe Szenen mit mehreren Charakteren und bestimmten Bewegungsarten generieren, die sowohl logisch als auch realistisch sind.OpenAI hat jedoch nur ein Demonstrationsvideo des Sora-Modells veröffentlicht und der Zugriff darauf wurde nur einer kleinen Anzahl von Forschern und kreativen Menschen gewährt.

Gleichzeitig stehen mittlerweile mehrere Open-Source-KI-generierte Videomodelle zur kostenlosen Nutzung zur Verfügung. Jack-Cui, ein beliebter Upmaster auf Bilibili, stellte in seinem Video-Tutorial vor, dass die derzeit beste Open-Source-KI-Videogenerierungslösung die Kombination aus Stable Diffusion + Prompt Travel + AnimateDiff sei.

Unter diesen ist Stable Diffusion ein „latentes Diffusionsmodell“, das zuerst die ursprünglichen hochdimensionalen Daten (z. B. Bilder) durch den Encoder auf den latenten Raum abbildet, in diesem Raum diffundiert und entrauscht und dann die bereinigten Daten im latenten Raum durch den Decoder wieder in den hochdimensionalen Raum rekonstruiert.Das Endergebnis ist die Generierung eines entsprechenden statischen Bildes gemäß den Textanweisungen.

Im Vergleich zum aktuellen Mainstream-Diffusionsmodell im Bereich der KI-Videogenerierung führt Stable Diffusion eine zusätzliche Kodierungs-Dekodierungsphase ein, die die Anwendung auf hochdimensionale Daten (wie Bilder) in einem niedrigdimensionalen latenten Raum ermöglicht, der wichtige Merkmale der Originaldaten enthält.Verbesserte Effizienz und Generierungsqualität des Modells.

Prompt Travel ist eine AnpassungTextanweisungenAuf diese Weise können Benutzer je nach ihren kreativen Absichten unterschiedliche Schlüsselwörter und Beschreibungen in verschiedenen Zeitleisten des Videos angeben und das KI-Modell anleiten, eine Reihe zusammenhängender und sich ändernder Bilder zu generieren.

Abschließend fügt AnimateDiff eine neu initialisierteBewegungsmodellierungsmodul, und verwenden Sie den Videoclip-Datensatz, um vernünftiges Bewegungsvorwissen zu trainieren. Sobald das Bewegungsmodul trainiert ist, wird es in das textbasierte Graphenmodell eingefügt, wodurch das Modell vielfältige und personalisierte textbasierte Videoclips generieren kann.

Derzeit wurde das Tutorial zur Modellbereitstellung auf der offiziellen HyperAI-Website veröffentlicht und Sie können es mit einem Klick klonen.

https://hyper.ai/tutorials/30038

Das „Stable-Diffusion Online Tutorial“ von Jack-Cui, einem beliebten Upmaster auf Bilibili, lautet wie folgt. In diesem Tutorial lernen Sie Schritt für Schritt, wie Sie KI-Malerei und KI-generierte Videos mit nur einem Klick meistern!

Laut Tutorial hat der Editor erfolgreich verschiedene schöne Bilder und Videos erstellt und die Wirkung ist einfach erstaunlich!

Demolauf

1. Klicken Sie auf „Dieses Tutorial online ausführen“, um zu OpenBayes zu springen und RTX 4090 kostenlos zu erhalten.

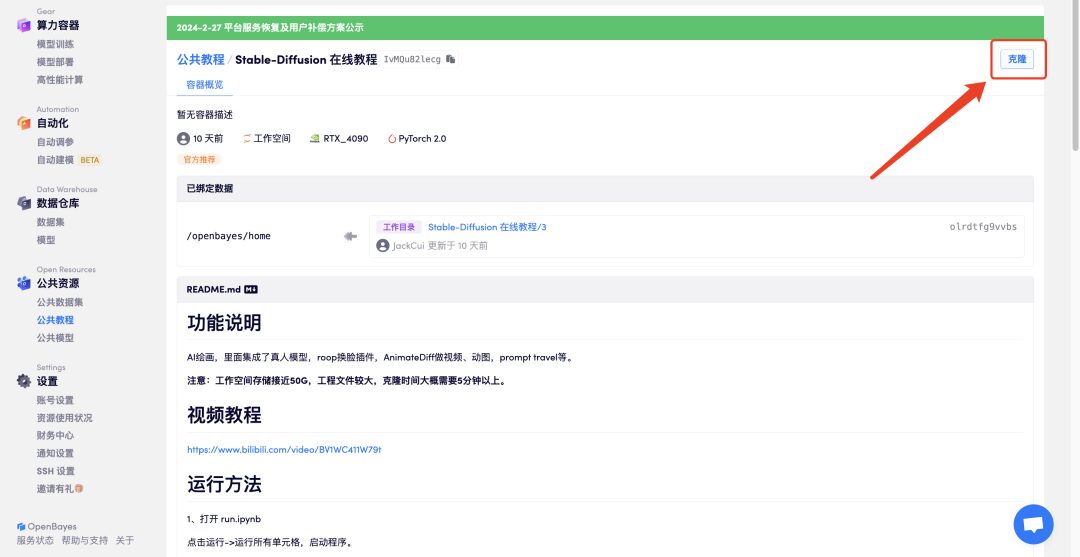

2. Klicken Sie oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

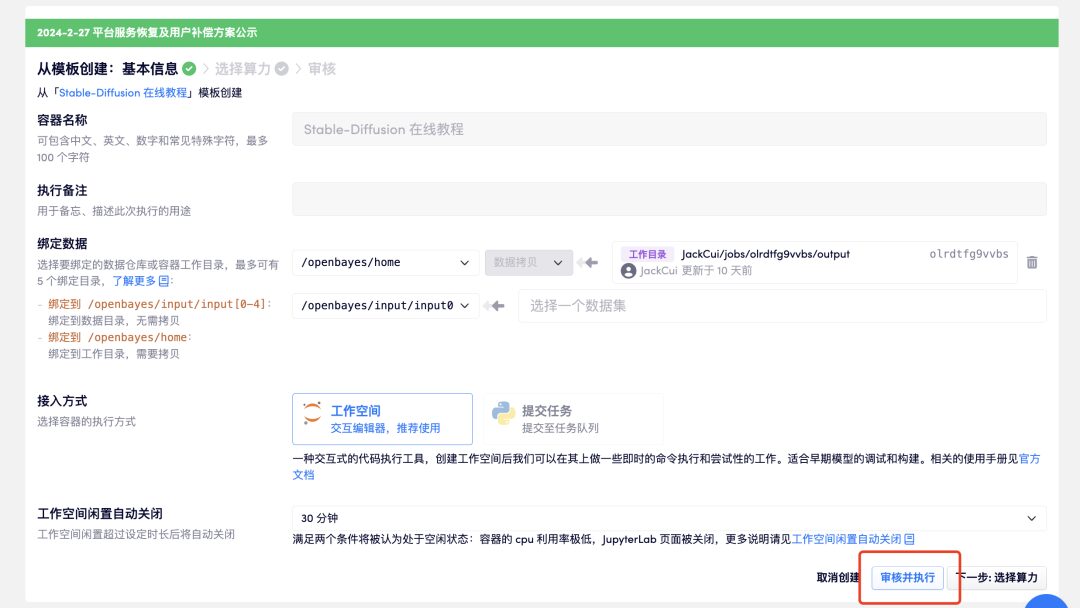

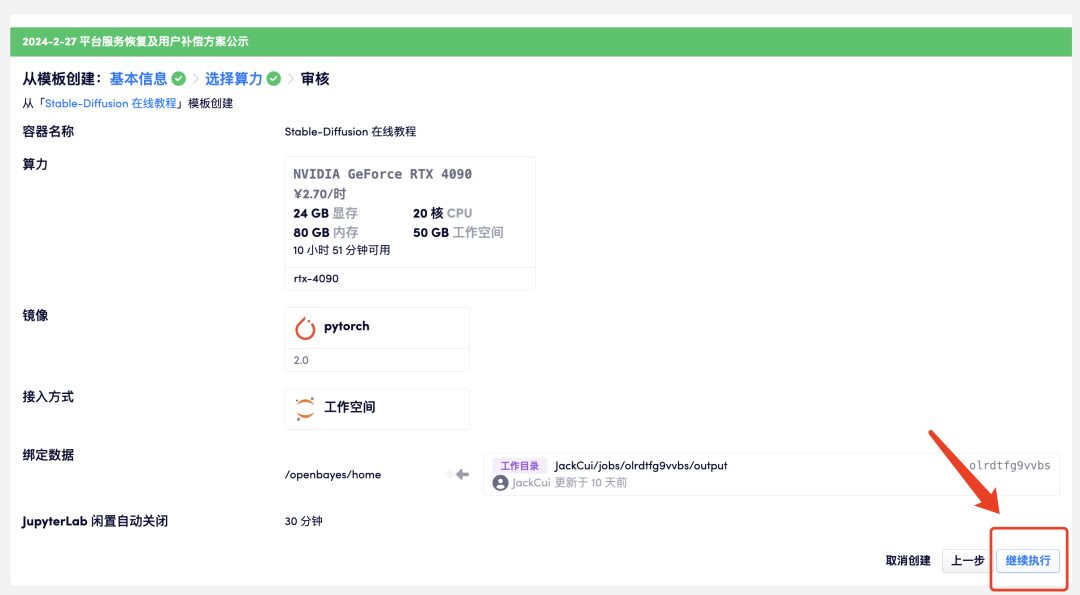

3. Klicken Sie auf „Überprüfen und ausführen“ – „Ausführung fortsetzen“. Es wird empfohlen, RTX 4090 zu verwenden. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren, um 4 Stunden RTX 4090 + 5 Stunden CPU-freie Rechenzeit zu erhalten!

Einladungslink:

https://openbayes.com/console/signup?r=GraceXiii_W8qO

4. Warten Sie einen Moment und klicken Sie auf „Arbeitsbereich öffnen“, wenn sich der Status in „Läuft“ ändert. Der Container enthält eine große Datenmenge. Der erste Start des Containers dauert etwa 8–10 Minuten. Bitte haben Sie Geduld.

Wenn sich der Container länger als 15 Minuten noch im Status „Ressourcen zuweisen“ befindet, können Sie versuchen, den Container anzuhalten und neu zu starten. Wenn das Problem nach dem Neustart immer noch nicht gelöst werden kann, wenden Sie sich bitte an den Kundenservice der Plattform auf der offiziellen Website.

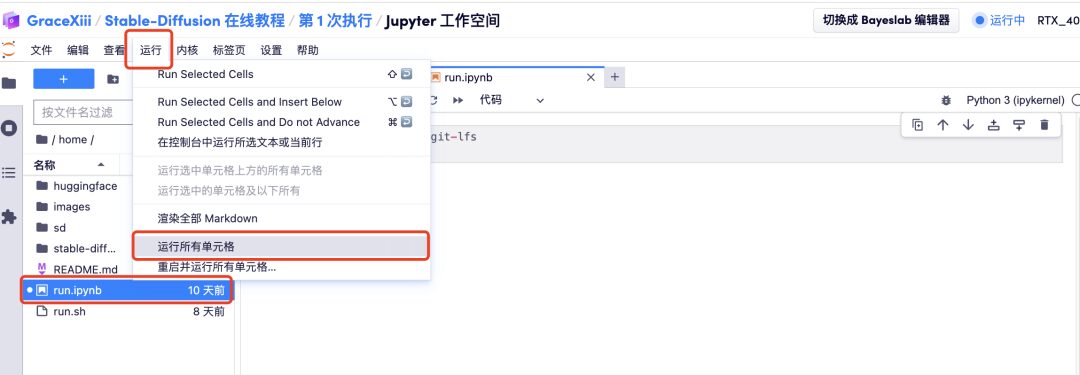

5. Klicken Sie nach dem Öffnen des Arbeitsbereichs links auf „run.ipynb“ und dann über die Schaltfläche „Ausführen“ in der Menüleiste auf „Alle Zellen ausführen“.

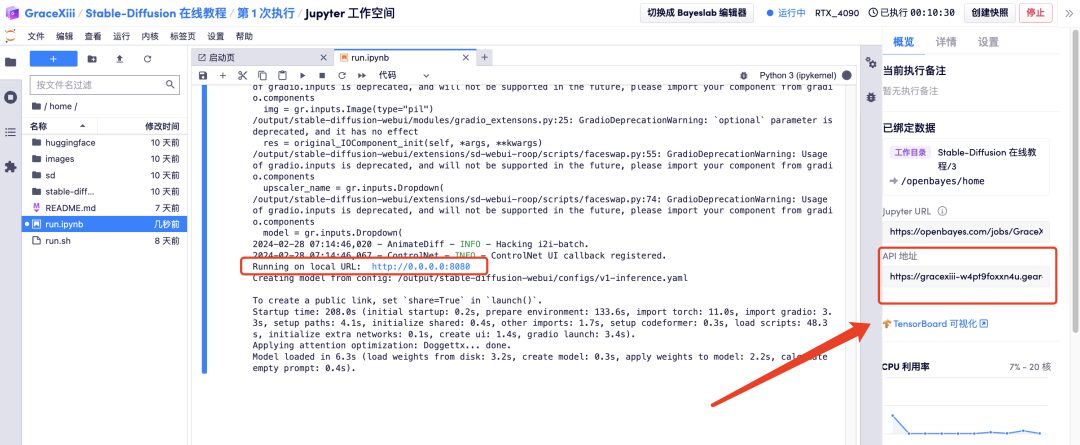

6. Warten Sie einen Moment und öffnen Sie nach der Generierung der lokalen URL die „API-Adresse“ auf der rechten Seite. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresszugriffsfunktion eine Echtnamenauthentifizierung durchführen müssen.

Effektanzeige

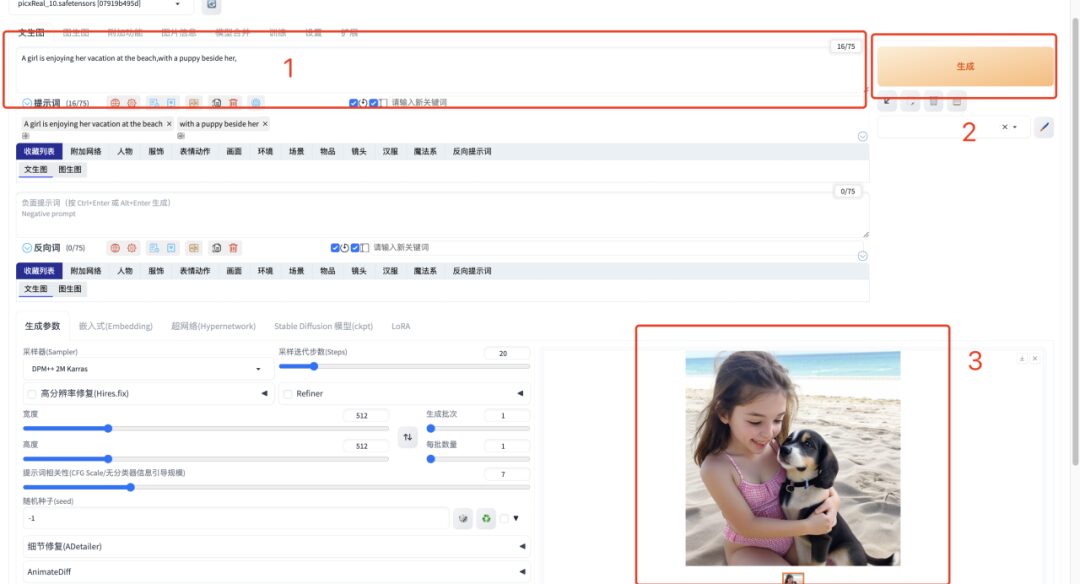

1. Geben Sie nach dem Öffnen der „API-Adresse“ das englische Eingabewort in das Textfeld ein und klicken Sie auf „Generieren“. Die schnelle Bildgenerierung dauert nur 1 Sekunde.

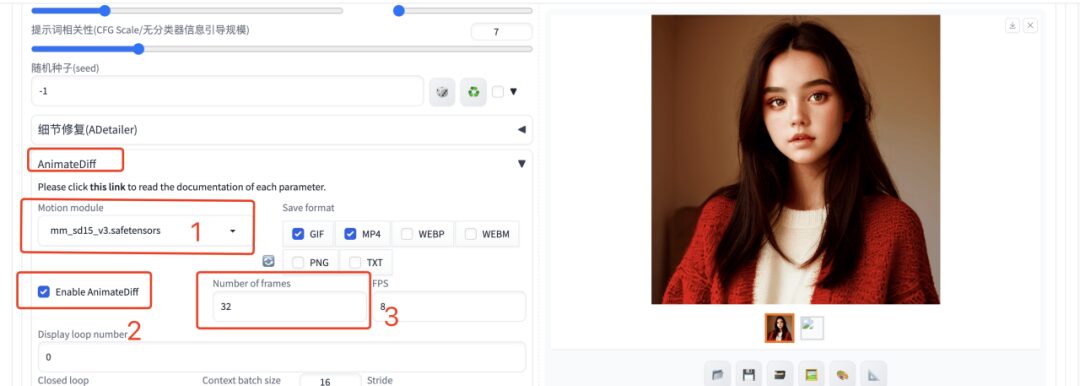

2. Wenn Sie ein Video generieren möchten, müssen Sie das englische Eingabeaufforderungswort eingeben, das Plug-In AnimateDiff auswählen, die Anzahl der generierten Frames mit 32 Frames eingeben und die anderen Parameter als Standard belassen. Warten Sie einen Moment und Sie können das animierte Bild oder Video generieren.

Derzeit hat die offizielle Website von HyperAI Hunderte ausgewählter Tutorials zum Thema maschinelles Lernen veröffentlicht, die in Form eines Jupyter-Notebooks organisiert sind.

Klicken Sie auf den Link, um nach verwandten Tutorials und Datensätzen zu suchen:

Das Obige ist der gesamte Inhalt, den der Herausgeber dieses Mal geteilt hat. Ich hoffe, dieser Inhalt ist für Sie hilfreich. Wenn Sie weitere interessante Tutorials erfahren möchten, hinterlassen Sie uns bitte eine Nachricht mit der Projektadresse. Der Herausgeber erstellt einen individuellen Kurs für Sie und bringt Ihnen das Spielen mit KI bei.

Quellen:

1.https://zhuanlan.zhihu.com/p/627133524

2.https://fuxi.163.com/database/739

3.https://zhuanlan.zhihu.com/p/669814884