Command Palette

Search for a command to run...

AGU Der Vereinigten Staaten Veröffentlicht KI-Anwendungshandbuch Mit Erläuterungen Zu Sechs Wichtigen Richtlinien

Explosive KI-Anwendungen: Risiken und Chancen koexistieren

In den Bereichen Weltraum- und Umweltwissenschaften werden KI-Tools zunehmend für Anwendungen wie Wettervorhersagen und Klimasimulationen, Energie- und Wasserressourcenmanagement und mehr eingesetzt. Man kann sagen, dass wir eine beispiellose Explosion der KI-Anwendungen erleben und dass wir die damit verbundenen Chancen und Risiken sorgfältiger abwägen müssen.

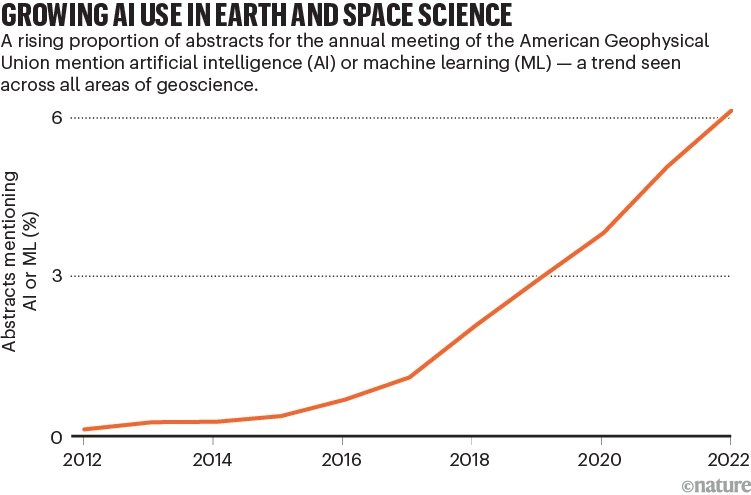

Der Folgebericht der American Geophysical Union (AGU) zeigt außerdem die weit verbreitete Anwendung von KI-Tools.Von 2012 bis 2022 stieg die Zahl der Artikel, in deren Abstracts KI erwähnt wurde, exponentiell an, was ihren enormen Einfluss auf Wettervorhersagen, Klimasimulationen, Ressourcenmanagement und mehr unterstreicht.

Trends bei der Veröffentlichung von Artikeln im Zusammenhang mit KI

Doch obwohl KI enorme Energie freisetzt, bringt sie auch potenzielle Risiken mit sich. Unter anderem können unzureichend trainierte Modelle oder falsch konzipierte Datensätze zu unzuverlässigen Ergebnissen oder sogar zu potenziellem Schaden führen. Wenn beispielsweise Tornadoberichte als Eingabedatensatz vorliegen, können die Trainingsdaten auf dicht besiedelte Gebiete ausgerichtet sein, da dort mehr Wetterereignisse beobachtet und gemeldet werden. Dies kann dazu führen, dass das Modell Tornados in städtischen Gebieten überschätzt und Tornados in ländlichen Gebieten unterschätzt, was zu Schäden führt.

Dieses Phänomen wirft auch wichtige Fragen auf: Wann und in welchem Ausmaß können Menschen der KI vertrauen und mögliche Risiken vermeiden?

Mit Unterstützung der NASA hat die AGU Experten zusammengerufen, um eine Reihe von Richtlinien für die Anwendung künstlicher Intelligenz im Weltraum und in den Umweltwissenschaften zu entwickeln., wobei der Schwerpunkt auf den ethischen und moralischen Problemen liegt, die bei KI-Anwendungen auftreten können. Es beschränkt sich nicht nur auf das spezielle Gebiet der Weltraum- und Umweltwissenschaften, sondern bietet auch Anleitungen für umfassende KI-Anwendungen. Ähnliche Inhalte wurden in „Nature“ veröffentlicht.

Der Artikel wurde in Nature veröffentlicht

Link zum Artikel:

https://www.nature.com/articles/d41586-023-03316-8

Folgen Sie dem offiziellen Konto und antworten Sie mit „Richtlinien“, um das vollständige PDF des Dokuments zu erhalten

Sechs Richtlinien zum Aufbau von Vertrauen

Derzeit stehen viele Menschen der Vertrauenswürdigkeit von KI/ML noch skeptisch gegenüber. Um Forschern/wissenschaftlichen Forschungseinrichtungen dabei zu helfen, Vertrauen in KI aufzubauen, hat die AGU sechs Richtlinien aufgestellt:

Um die ursprüngliche Bedeutung zu bewahren, fügt der Autor die Übersetzung und den Originaltext zusammen.

Leitfaden für Forschende

1. Transparenz, Dokumentation und Berichterstattung

In der KI/ML-Forschung sind Transparenz und umfassende Dokumentation von entscheidender Bedeutung. Es sollten nicht nur Daten und Code bereitgestellt werden, sondern auch die Teilnehmer und die Art und Weise, wie das Problem gelöst wurde, einschließlich des Umgangs mit Unsicherheit und Voreingenommenheit. Transparenz sollte während des gesamten Forschungsprozesses berücksichtigt werden, von der Konzeptentwicklung bis zur Anwendung.

2. Intentionalität, Interpretierbarkeit, Erklärbarkeit, Reproduzierbarkeit und Replizierbarkeit

Bei der Durchführung von Forschung mithilfe von KI/ML ist es wichtig, sich auf Intentionalität, Erklärbarkeit, Reproduzierbarkeit und Reproduzierbarkeit zu konzentrieren. Priorisieren Sie offene wissenschaftliche Methoden, verbessern Sie die Interpretierbarkeit und Reproduzierbarkeit von Modellen und fördern Sie die Entwicklung von Methoden zur Erklärung von KI-Modellen.

3. Risiko, Verzerrung und Auswirkungen

Das Verständnis und der Umgang mit potenziellen Risiken und Verzerrungen in Datensätzen und Algorithmen ist für die Forschung von entscheidender Bedeutung. Durch ein besseres Verständnis der Ursachen von Risiken und Voreingenommenheit sowie durch Methoden zur Erkennung dieser Probleme können negative Folgen effektiver bewältigt und darauf reagiert werden, wodurch der Nutzen für die Öffentlichkeit und die Wirksamkeit maximiert werden.

4. Partizipative Methoden

In der KI/ML-Forschung ist es sehr wichtig, einen integrativen Design- und Implementierungsansatz zu verfolgen. Stellen Sie sicher, dass Menschen aus unterschiedlichen Gemeinschaften, Berufsfeldern und mit unterschiedlichem Hintergrund zu Wort kommen, insbesondere Gemeinschaften, die von der Forschung betroffen sein könnten. Um Inklusivität in der Forschung zu gewährleisten, sind die gemeinsame Wissensproduktion, die Teilnahme an Projekten und die Zusammenarbeit von entscheidender Bedeutung.

Leitfaden für akademische Organisationen (einschließlich Forschungsinstitute, Verlage, Verbände und Investoren)

5. Öffentlichkeitsarbeit, Schulung und führende Praktiken

Akademische Organisationen müssen die Industrie unterstützen und sicherstellen, dass Forscher, Praktiker, Geldgeber und die breitere KI/ML-Community über die ethische Nutzung von KI/ML geschult werden. Wissenschaftliche Gesellschaften, Institutionen und andere Organisationen sollten Ressourcen und Fachwissen bereitstellen, Schulungen zur Ethik im Bereich KI/ML unterstützen und gesellschaftliche Entscheidungsträger über den Wert und die Grenzen von KI/ML in der Forschung aufklären, damit verantwortungsvolle Entscheidungen zur Verringerung der negativen Auswirkungen getroffen werden können.

6. Überlegungen für Organisationen, Institutionen, Verlage, Gesellschaften und Geldgeber

Akademische Organisationen tragen die Verantwortung, bei der Festlegung und Verwaltung von Richtlinien im Zusammenhang mit ethischen Fragen im Zusammenhang mit KI/ML, einschließlich Verhaltenskodizes, Grundsätzen, Berichtsmethoden, Entscheidungsprozessen und Schulungen, die Führung zu übernehmen. Sie sollten Werte artikulieren und Governance-Strukturen entwerfen, einschließlich des Aufbaus einer Unternehmenskultur, um sicherzustellen, dass ethische KI/ML-Praktiken umgesetzt werden. Darüber hinaus ist die Durchsetzung dieser Verantwortlichkeiten in allen Organisationen und Institutionen erforderlich, um sicherzustellen, dass im gesamten Bereich ethische Praktiken umgesetzt werden.

Ausführlichere Beratung zu KI-Anwendungen

1. Achten Sie auf Lücken und Verzerrungen

Achten Sie bei KI-Modellen und -Daten auf Lücken und Verzerrungen. Faktoren wie Datenqualität, Abdeckung und rassistische Voreingenommenheit können die Genauigkeit und Zuverlässigkeit der Modellergebnisse beeinträchtigen, was unerwartete Risiken mit sich bringen kann.

Beispielsweise ist die Abdeckung oder Authentizität von Umweltdaten in einigen Regionen viel besser als in anderen. Regionen mit häufiger Wolkenbedeckung (wie etwa tropische Regenwälder) oder Gebiete mit geringerer Sensorabdeckung (wie etwa die Pole) liefern weniger repräsentative Daten.

Der Umfang und die Qualität der Datensätze begünstigen häufig wohlhabende Gebiete und übersehen benachteiligte Gruppen, darunter Gemeinschaften, die in der Vergangenheit unter Diskriminierung gelitten haben. Diese Daten werden häufig verwendet, um Empfehlungen und Aktionspläne für die Öffentlichkeit, Unternehmen und politische Entscheidungsträger bereitzustellen. Beispielsweise sind dermatologische Algorithmen, die mit Daten weißer Menschen trainiert wurden, bei der Diagnose von Hautläsionen und Ausschlägen bei schwarzen Menschen weniger genau.

Die Institutionen sollten sich auf die Ausbildung von Forschern, die Überprüfung der Genauigkeit von Daten und Modellen und die Einrichtung professioneller Ausschüsse zur Überwachung der Verwendung von KI-Modellen konzentrieren.

2. Entwickeln Sie Möglichkeiten, die Funktionsweise von KI-Modellen zu erklären

Wenn Forscher unter Verwendung klassischer Modelle forschen und Artikel veröffentlichen, erwarten die Leser häufig, dass sie Zugriff auf den zugrunde liegenden Code und die zugehörigen Spezifikationen gewähren. Allerdings sind Forscher bislang nicht explizit dazu verpflichtet, derartige Informationen bereitzustellen, was zu einem Mangel an Transparenz und Erklärbarkeit der von ihnen eingesetzten KI-Tools führt. Dies bedeutet, dass selbst wenn derselbe Algorithmus zur Verarbeitung derselben experimentellen Daten verwendet wird, unterschiedliche experimentelle Methoden die Ergebnisse möglicherweise nicht genau reproduzieren. Daher sollten Forscher in öffentlich veröffentlichten Forschungsergebnissen klar dokumentieren, wie KI-Modelle erstellt und eingesetzt werden, damit andere die Ergebnisse bewerten können.

Die Forscher empfehlen, modellübergreifende Vergleiche durchzuführen und die Datenquellen zur Untersuchung in Vergleichsgruppen aufzuteilen. Die Branche benötigt dringend weitere Standards und Leitlinien, um die Funktionsweise von KI-Modellen zu erklären und zu bewerten, damit die von ihnen erzeugten Ergebnisse mit einem Grad an statistischer Sicherheit ausgewertet werden können, der dem der erzeugten Daten entspricht.

Derzeit arbeiten Forscher und Entwickler an einer Technik namens „Explainable AI“ (XAI), die den Benutzern durch die Quantifizierung oder Visualisierung ihrer Ergebnisse ein besseres Verständnis der Funktionsweise von KI-Modellen vermitteln soll. Bei der kurzfristigen Wettervorhersage können beispielsweise Tools der künstlichen Intelligenz große Mengen von Fernerkundungsbeobachtungsdaten analysieren, die alle paar Minuten erfasst werden, und so die Fähigkeit zur Vorhersage schwerer Wetterkatastrophen verbessern.

Um die Gültigkeit und Nützlichkeit der Prognosen beurteilen zu können, ist eine klare Erklärung, wie die Ergebnisse erreicht wurden, von entscheidender Bedeutung. Wenn es beispielsweise darum geht, die Wahrscheinlichkeit und das Ausmaß von Bränden oder Überschwemmungen vorherzusagen, kann diese Erklärung den Menschen dabei helfen, zu entscheiden, ob sie die Öffentlichkeit warnen oder die Ergebnisse anderer KI-Modelle verwenden sollen. In den Geowissenschaften versucht XAI, Eigenschaften von Eingabedaten zu quantifizieren oder zu visualisieren, um die Modellausgaben besser zu verstehen. Forscher müssen diese Erklärungen überprüfen und ihre Plausibilität sicherstellen.

Künstliche Intelligenz wird zur Auswertung von Umweltbeobachtungen eingesetzt

3. Partnerschaften schmieden und Transparenz fördern

Forscher müssen in jeder Phase auf Transparenz achten: Sie müssen Daten und Codes teilen, weitere Tests in Betracht ziehen, um die Reproduzierbarkeit und Wiederholbarkeit sicherzustellen, Risiken und Verzerrungen in ihren Methoden ansprechen und Unsicherheiten melden. Diese Schritte erfordern eine detailliertere Beschreibung der Methode. Um Vollständigkeit zu gewährleisten, sollten Forschungsteams Experten für die Verwendung verschiedener Datentypen sowie Community-Mitglieder umfassen, die möglicherweise an der Bereitstellung von Daten beteiligt sind oder von den Forschungsergebnissen betroffen sein könnten. Ein KI-basiertes Projekt kombiniert beispielsweise traditionelles Wissen des kanadischen Tharu-Volkes mit Daten, die mithilfe nicht-indigener Methoden gesammelt wurden, um die für die Aquakultur am besten geeigneten Gebiete zu identifizieren. (Siehe go.nature.com/46yqmdr).

Aquakultur-Projektbilder

4. Unterstützung für Datenkuratierung und -verwaltung aufrechterhalten

Die Anforderungen an die Berichterstattung über Daten, Code und Software in interdisziplinären Forschungsfeldern müssen den FAIR-Prinzipien entsprechen: auffindbar, zugänglich, interoperabel und wiederverwendbar. Um Vertrauen in KI und maschinelles Lernen aufzubauen, müssen öffentlich zugängliche Datensätze von nachgewiesener Qualität vorhanden sein, in denen Fehler und Lösungen öffentlich gemacht werden.

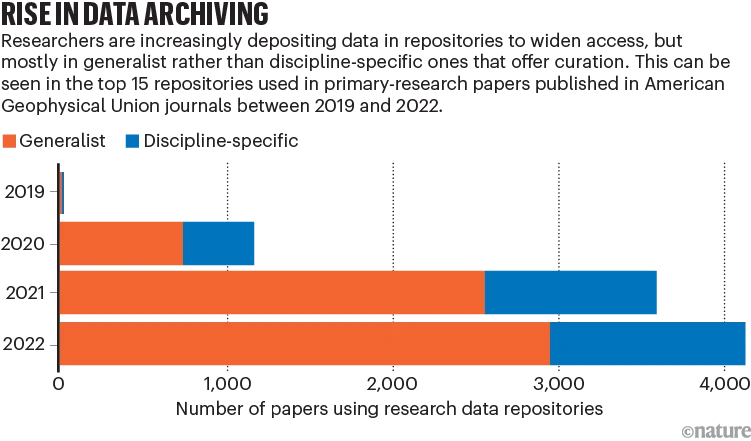

Die aktuelle Herausforderung besteht in der Speicherung von Daten. So kann beispielsweise die weitverbreitete Verwendung gemeinsamer Repositorien zu Metadatenproblemen führen, die sich auf die Verfolgung der Datenherkunft und den automatisierten Zugriff auswirken. Einige fortgeschrittene disziplinäre Forschungsdatenrepositorien bieten Dienste zur Qualitätsprüfung und Informationsergänzung an, dies erfordert jedoch normalerweise Personal- und Zeitaufwand.

Darüber hinaus werden in dem Artikel Probleme wie die Finanzierung von Repositorien, Einschränkungen bei verschiedenen Repositorientypen und die mangelnde Nachfrage nach domänenspezifischen Repositorien erwähnt. Akademische Organisationen, Förderagenturen und andere sollten nachhaltig finanziell in die Unterstützung und Pflege geeigneter Datenspeicher investieren.

Forscher wählen zunehmend gemeinsame Datenspeicher

5. Betrachten Sie die langfristigen Auswirkungen

Wenn wir die weitverbreitete Anwendung künstlicher Intelligenz und maschinellen Lernens in der Wissenschaft untersuchen, müssen wir die langfristigen Auswirkungen im Auge behalten und sicherstellen, dass diese Technologien soziale Unterschiede verringern, das Vertrauen stärken und unterschiedliche Meinungen und Stimmen aktiv einbeziehen können.

Was China zum KI-Einsatz sagt

„Wie man KI nutzt und wie man KI gut nutzt“ ist in den letzten Jahren auch im KI-Bereich meines Landes ein heißes Thema.

In den Augen der beiden diesjährigen Sitzungen ist künstliche Intelligenz einer der aktivsten Bereiche der digitalen Technologieinnovation, wobei generative KI (AIGC), vortrainierte Modelle im großen Maßstab und wissensbasierte KI eröffnen der Branche neue Möglichkeiten, und wir müssen das „Zeitfenster“ für die technologische Entwicklung nutzen.

Lei Jun, Gründer, Vorsitzender und CEO der Xiaomi Group, schlug vor, die wissenschaftliche und technologische Innovationsindustriekette zu fördern und zu unterstützen und die Planung und Gestaltung der bionischen Roboterindustrie voranzutreiben. Beschleunigung der Formulierung von Datensicherheitsstandards für den gesamten Lebenszyklus von Automobilen, um die industrielle Entwicklung zu steuern; Aufbau eines Mechanismus und einer Plattform zum Teilen von Fahrzeugdaten, um das Teilen und die Nutzung von Fahrzeugdaten zu fördern.

360-Gründer Zhou Hongyi hofft, Chinas Kombination „Microsoft + OpenAI“ zu schaffen, die Forschung zur Großmodelltechnologie anzuführen und ein offenes Innovations-Ökosystem für Open-Source-Crowdsourcing zu schaffen.

Der Akademiker Zhang Boli schlug vor, ein großes Sonderprojekt für die biopharmazeutische Herstellung aufzulegen, die Forschung und Entwicklung von Schlüsseltechnologien und -geräten für die intelligente Arzneimittelherstellung zu unterstützen und die Entwicklung biopharmazeutischer Geräte zu fördern.

Man kann erkennen, dass die Vertreter und Mitglieder der beiden Sitzungen dem Bereich der künstlichen Intelligenz sehr optimistisch gegenüberstehen. Wir hoffen auch, dass KI nicht nur die Technologie ermöglicht, sondern auch die Entwicklung von Unternehmen und der Gesellschaft unter den Grundsätzen des Vertrauensaufbaus und der umsichtigen Nutzung besser unterstützen kann.

Quellen:

https://www.nature.com/articles/d41586-023-03316-8

https://doi.org/10.22541/essoar.168132856.66485758/v1