Command Palette

Search for a command to run...

„Walgesichtserkennung“ Ist Jetzt online. Die Universität Von Hawaii Verwendet 50.000 Bilder, Um Das Erkennungsmodell Mit Einer Durchschnittlichen Genauigkeit Von 0,869 Zu Trainieren

Inhalte im Überblick:Durch Gesichtserkennung kann die menschliche Identität gesichert werden. Diese Technologie wurde auf Wale ausgeweitet, was zur „Rückenflossenerkennung“ führte. Bei der „Rückenflossenidentifizierung“ wird eine Bilderkennungstechnologie verwendet, um Walarten anhand ihrer Rückenflossen zu identifizieren. Die herkömmliche Bilderkennung basiert auf Convolutional Neural Network (CNN)-Modellen, die eine große Anzahl von Trainingsbildern erfordern und nur bestimmte einzelne Arten erkennen können. Kürzlich trainierten Forscher der Universität von Hawaii ein Bilderkennungsmodell für mehrere Arten, das bei Walanwendungen gute Ergebnisse erzielte.

Schlüsselwörter:Bilderkennung Wale ArcFace

Autor: daserney

Herausgeber: Huanhuan, Sanyang

Dieser Artikel wurde zuerst auf der öffentlichen HyperAI WeChat-Plattform veröffentlicht~

Wale sind Flaggschifftiere und Indikatororganismen des marinen Ökosystems und haben einen äußerst hohen Forschungswert für den Schutz der marinen ökologischen Umwelt.Bei der herkömmlichen Tieridentifizierung müssen die Tiere vor Ort fotografiert und Zeit und Ort ihres Auftretens aufgezeichnet werden. Es sind viele Schritte erforderlich und der Vorgang ist kompliziert.Besonders zeitaufwändig ist dabei das Bildabgleichen, also das Identifizieren derselben Person auf verschiedenen Bildern.

Eine Studie von Tyne et al. aus dem Jahr 2014. schätzte, dass während einer einjährigen Fang- und Freilassungsstudie von Fleckendelfinen (Stenella longirostris),Der Bildabgleich erforderte mehr als 1.100 Stunden Handarbeit und machte fast ein Drittel der gesamten Projektkosten aus..

Kürzlich verwendeten Forscher, darunter Philip T. Patton von der University of Hawai'i, mehr als 50.000 Fotos (darunter 24 Walarten und 39 Kataloge), um ein Bilderkennungsmodell für mehrere Arten zu trainieren, das auf dem Gesichtserkennungstool ArcFace Classification Head basiert.Das Modell erreichte im Testsatz eine durchschnittliche Präzision (MAP) von 0,869. Unter ihnen lagen die MAP-Werte von 10 Verzeichnissen über 0,95.

Die Forschungsergebnisse wurden in der Fachzeitschrift „Methods in Ecology and Evolution“ unter dem Titel „Ein Deep-Learning-Ansatz zur Fotoidentifizierung zeigt bei zwei Dutzend Walarten eine hohe Leistung“ veröffentlicht.

Die Forschungsergebnisse wurden in Methods in Ecology and Evolution veröffentlicht.

Papieradresse:

https://besjournals.onlinelibrary.wiley.com/doi/full/10.1111/2041-210X.14167

Datensatz: 25 Arten, 39 Kataloge

Dateneinführung

Happywhale und Kaggle haben mit Forschern auf der ganzen Welt zusammengearbeitet, um einen umfangreichen Datensatz zu Walen mehrerer Arten zusammenzustellen. Dieser Datensatz wurde für einen Kaggle-Wettbewerb gesammelt, bei dem die Teams einzelne Wale anhand von Bildern ihrer Rückenflossen/Seitenansichten identifizieren mussten.Der Datensatz enthält 41 Kataloge mit 25 Arten, jeder Katalog enthält eine Art und einige Arten kommen in den Katalogen wiederholt vor.

Im Rahmen der Studie wurden zwei Wettbewerbskataloge entfernt, da einer davon nur 26 Bilder von geringer Qualität zum Trainieren und Testen enthielt und dem anderen Katalog ein Testsatz fehlte.Der endgültige Datensatz enthält 50.796 Trainingsbilder und 27.944 Testbilder, von denen die 50.796 Trainingsbilder 15.546 Identitäten enthalten.Unter diesen Identitäten haben 9.240 (59%) nur ein Trainingsbild und 14.210 (91%) haben weniger als 5 Trainingsbilder.

Datensatz und Codeadresse:

https://github.com/knshnb/kaggle-happywhale-1st-place

Trainingsdaten

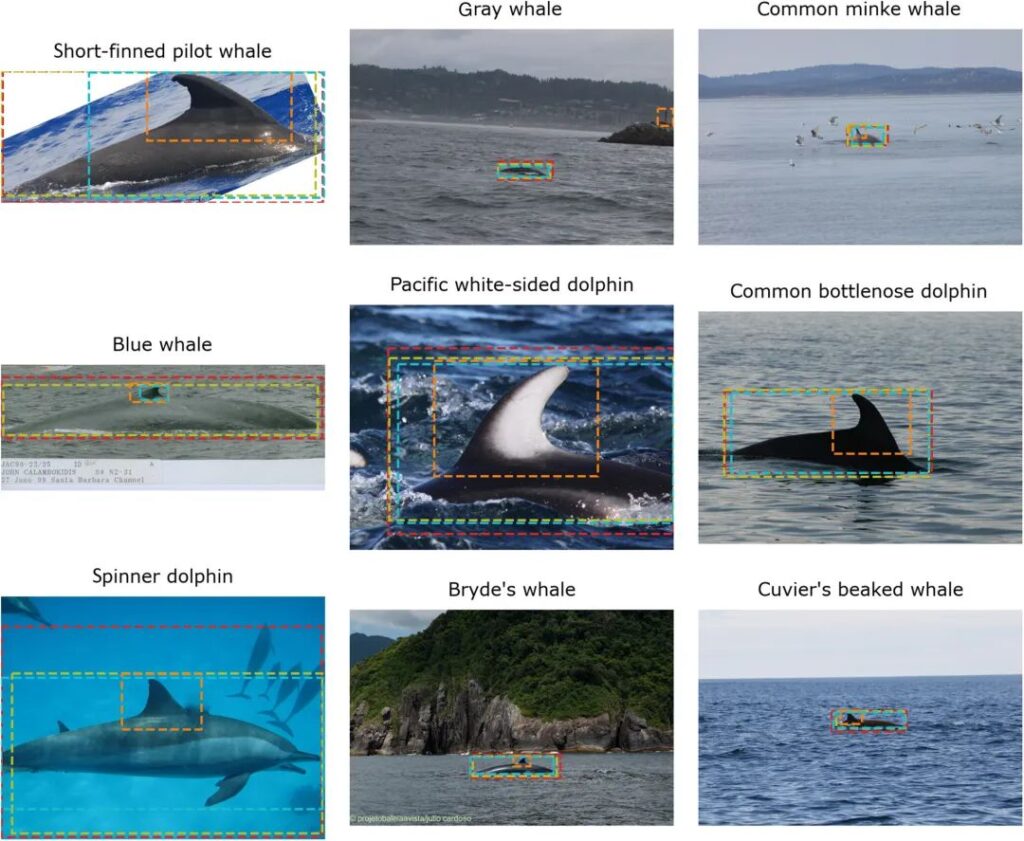

Um das Problem komplexer Bildhintergründe zu lösen, haben einige Teilnehmer Bildzuschneidemodelle trainiert, die Wale in Bildern automatisch erkennen und Begrenzungsrahmen um sie zeichnen können. Wie in der Abbildung unten zu sehen ist,Diese Pipeline umfasst 4 Waldetektoren, die unterschiedliche Algorithmen verwenden, darunter YOLOv5 und Detic.Die Vielfalt der Detektoren erhöht die Robustheit des Modells und ermöglicht eine Datenerweiterung auf der Grundlage experimenteller Daten.

Abbildung 1: Bilder aus 9 Kategorien im Wettbewerbsset und Begrenzungsrahmen, die von 4 Waldetektoren generiert wurden

Die Wahrscheinlichkeit des von jedem Begrenzungsrahmen erzeugten Ausschnitts beträgt: 0,60 für Rot, 0,15 für Olivgrün, 0,15 für Orange und 0,05 für Blau. Nach dem Zuschneiden haben die Forscher die Größe jedes Bildes auf 1024 x 1024 Pixel geändert, um die Kompatibilität mit dem EfficientNet-B7-Backbone sicherzustellen.

Wenden Sie nach der Größenänderung Datenerweiterungstechniken wie affine Transformation, Größenänderung und Zuschneiden, Graustufen, Gaußsche Unschärfe usw. an.Vermeiden Sie ModelleErnsthafte Überanpassung.

Unter Datenerweiterung versteht man die Transformation oder Erweiterung der Originaldaten während des Trainingsprozesses, um die Vielfalt und Menge der Trainingsbeispiele zu erhöhen und so die Generalisierungsfähigkeit und Robustheit des Modells zu verbessern.

Modelltraining: Arten- und Individuenidentifikation

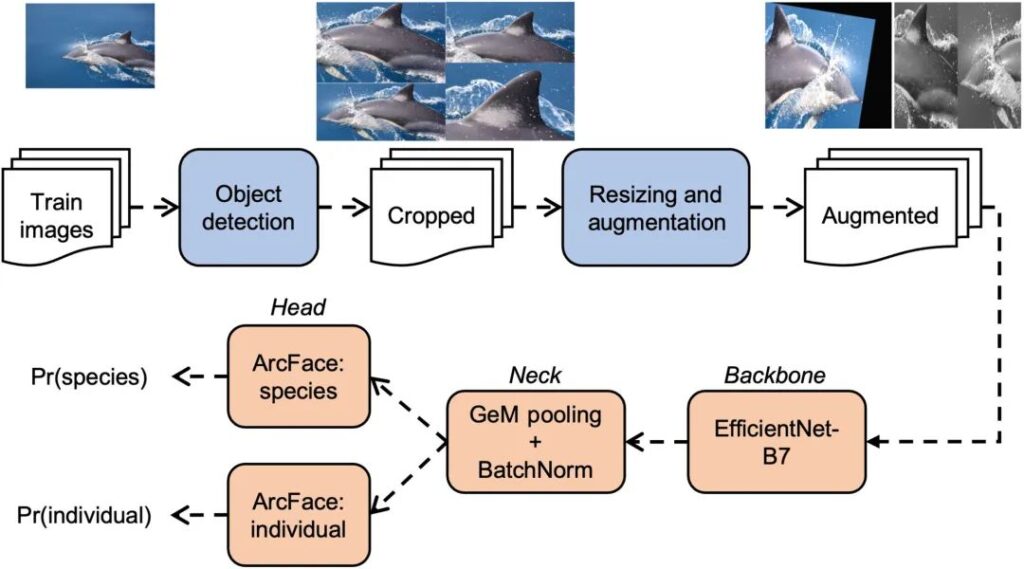

Die folgende Abbildung zeigt den Trainingsprozess des Modells, wie im orangefarbenen Teil dargestellt.Die Forscher unterteilten das Bilderkennungsmodell in drei Teile: Wirbelsäule, Hals und Kopf.

Abbildung 2: Trainingspipeline für das Bilderkennungsmodell mehrerer Spezies

Die erste Zeile der Abbildung zeigt die Vorverarbeitungsschritte (am Beispiel des Bildes des Gemeinen Delfins Delphinus delphis).Ausschnitte werden durch 4 Objekterkennungsmodelle generiert und der Datenerweiterungsschritt generiert zwei Beispielbilder.

Die untere Reihe zeigt die Trainingsschritte für das Bildklassifizierungsnetzwerk.Von der Wirbelsäule über den Nacken bis zum Kopf.

Das Bild geht zunächst durch das Netzwerk in das Backbone.Eine Reihe von Studien im letzten Jahrzehnt haben Dutzende beliebter Backbones hervorgebracht, darunter ResNet, DenseNet, Xception und MobileNet. Bewährt,EfficientNet-B7 bietet die beste Leistung bei der Anwendung im Bereich der Wale.

Backbone nimmt ein Bild auf und verarbeitet es durch eine Reihe von Faltungs- und Pooling-Schichten, um eine vereinfachte 3D-Darstellung des Bildes zu erzeugen. Neck reduziert diese Ausgabe auf einen eindimensionalen Vektor, auch Eigenvektor genannt.

Beide Kopfmodelle wandeln Merkmalsvektoren in Klassenwahrscheinlichkeiten um, nämlich Pr(Art) oder Pr(Individuum).Wird zur Artenidentifizierung bzw. zur individuellen Identifizierung verwendet.Diese Klassifizierungsköpfe werden als subzentrierte ArcFaces mit dynamischen Rändern bezeichnet und sind allgemein auf Bilderkennungsszenarien mehrerer Arten anwendbar.

Versuchsergebnisse: durchschnittliche Genauigkeit 0,869

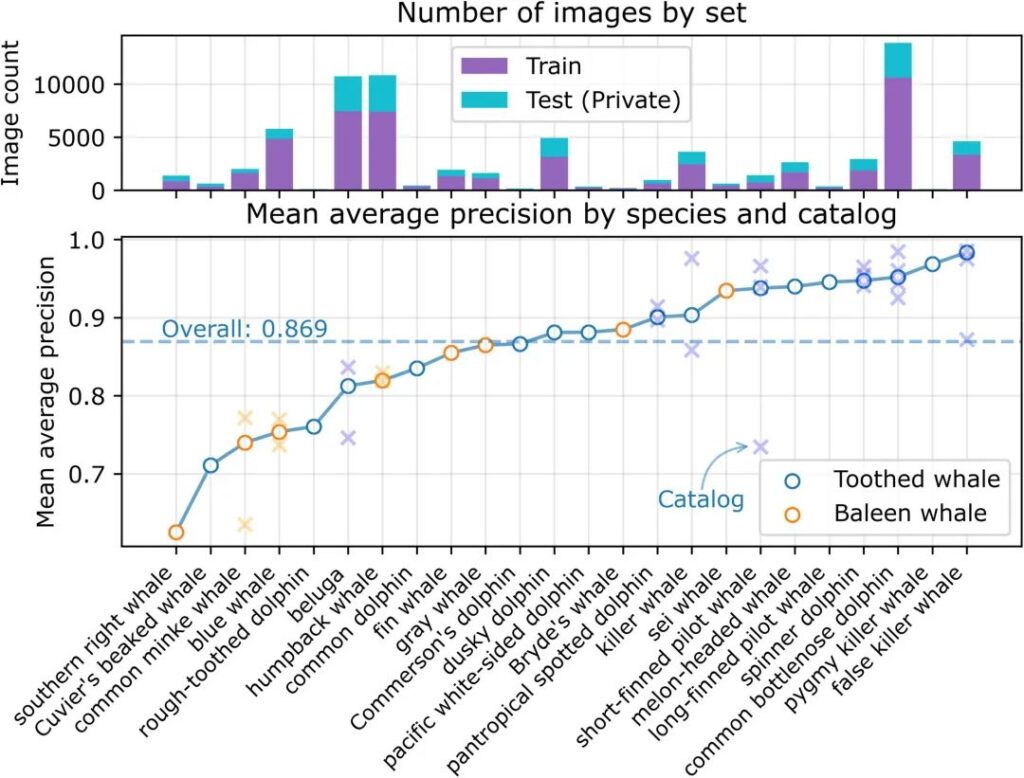

Wir haben eine durchschnittliche Präzision (MAP) von 0,869 für Vorhersagen für 21.192 Bilder im Testsatz (39 Kataloge mit 24 Arten) erhalten.Wie in der folgenden Abbildung gezeigt, variiert die durchschnittliche Präzision je nach Art und ist unabhängig von der Anzahl der Trainings- oder Testbilder.

Abbildung 3: Durchschnittliche Präzision im Testset

Das obere Feld zeigt die Anzahl der Bilder für jede Art nach Zweck (z. B. Training oder Test). Arten mit mehreren Katalogen werden durch x dargestellt.

Die Abbildung zeigt, dass das Modell bei der Identifizierung von Zahnwalen besser abschneidet, bei der Identifizierung von Bartenwalen jedoch schlechter.Nur zwei Bartenwalarten erzielten überdurchschnittliche Ergebnisse.

Es gibt auch Unterschiede in der Modellleistung bei Arten aus mehreren Katalogen.Beispielsweise lagen die MAP-Werte für den Zwergwal (Balaenoptera acutorostrata) zwischen verschiedenen Katalogen bei 0,79 bzw. 0,60. Auch bei anderen Arten wie Weißwalen (Delphinapterus leucas) und Schwertwalen gibt es zwischen den Katalogen große Leistungsunterschiede.

Obwohl die Forscher keinen Grund fanden, diesen Leistungsunterschied auf Verzeichnisebene zu erklären,Sie stellten jedoch fest, dass einige qualitative Indikatoren wie Unschärfe, Einzigartigkeit, Beschriftungsverwechslung, Entfernung, Kontrast und Spritzer die Genauigkeitsbewertung eines Bildes beeinflussen können.

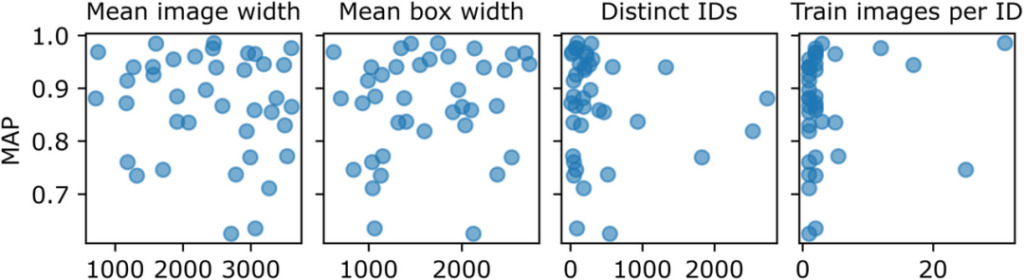

Abbildung 4: Variablen, die Leistungsunterschiede auf Verzeichnisebene beeinflussen können

Jeder Punkt in der Abbildung stellt ein Verzeichnis im Wettbewerbsdatensatz dar, und Pixel stellen das Bild und die Breite des Begrenzungsrahmens dar. Unter „Eindeutige IDs“ wird die Anzahl der unterschiedlichen Personen im Trainingssatz angegeben. Jedoch,Es besteht keine klare Korrelation zwischen dem MAP auf Katalogebene und der durchschnittlichen Bildbreite, der durchschnittlichen Begrenzungsrahmenbreite, der Anzahl der Trainingsbilder, der Anzahl der verschiedenen Personen und der Anzahl der Trainingsbilder pro Person.

Zusammenfassend kamen die Forscher zu dem Schluss, dass bei Verwendung dieses Modells zur Vorhersage die durchschnittliche Genauigkeit von 10 Katalogen, die 7 Arten repräsentieren, höher als 0,95 war und die Leistung besser war als beim herkömmlichen Vorhersagemodell, was weiter zeigt, dass die Verwendung dieses Modells Individuen korrekt identifizieren kann.Darüber hinaus fassten die Forscher während des Experiments 7 Punkte zur Walforschung zusammen:

- Die Rückenflossenidentifizierung war am erfolgreichsten.

- Verzeichnisse mit weniger ausgeprägten Einzelfunktionen schnitten schlecht ab.

- Die Bildqualität ist wichtig.

- Es kann schwierig sein, Tiere anhand ihrer Farbe zu identifizieren.

- Arten, deren Merkmale weit vom Trainingssatz abweichen, erzielen ein schlechtes Ergebnis.

- Die Vorverarbeitung bleibt eine Hürde.

- Abweichungen in der Tiermarkierung können die Leistung des Modells beeinträchtigen.

Happywhale: eine Citizen-Science-Plattform für die Walforschung

Happywhale, das in der Datensatzeinführung dieses Artikels erwähnt wird, ist eine öffentliche Wissenschaftsplattform zum Teilen von Walbildern.Ziel ist es, große Datensätze freizugeben und einen schnellen Abgleich von Lichtbildausweisen zu ermöglichen.und die Schaffung eines wissenschaftlichen Forschungsengagements für die Öffentlichkeit.

Offizielle Website-Adresse von Happywhale:

Happywhale wurde im August 2015 gegründet. Sein Mitbegründer Ted Cheeseman ist ein Naturforscher, der in Monterey Bay, Kalifornien, aufgewachsen ist. Er liebt die Walbeobachtung seit seiner Kindheit und ist viele Male in die Antarktis und nach Südgeorgien gereist.Er verfügt über mehr als 20 Jahre Erfahrung in der Antarktisforschung und im Polartourismusmanagement.

Ted Cheeseman, Mitbegründer von Happywhale

Im Jahr 2015 verließ Ted nach 21 Jahren Arbeit Cheesemans‘ Ecology Safaris (ein Ökotourismusunternehmen, das 1980 von Teds Eltern, ebenfalls Naturforscher, gegründet wurde) und schloss sich dem Happywhale-Projekt an. Sammeln Sie wissenschaftliche Daten, um unser Verständnis und den Schutz der Wale zu verbessern.

In nur wenigen JahrenHappywhale.com hat sich zu einem der größten Beitragszahler im Bereich der Walforschung entwickelt.Neben der großen Anzahl von Bildern zur Walidentifizierung bieten sie auch viele Einblicke in das Verständnis der Migrationsmuster der Wale.

Referenzlinks:

[1]https://baijiahao.baidu.com/s?id=1703893583395168492

[2]https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0086132

[3]https://phys.org/news/2023-07-individual-whale-dolphin-id-facial.html#google_vignette

[4]https://happywhale.com/about

Dieser Artikel wurde zuerst auf der öffentlichen HyperAI WeChat-Plattform veröffentlicht~