Command Palette

Search for a command to run...

Veranstaltungsvorschau | 2023 Ist Ein Treffen Von TVM · Beijing Station geplant. Auf Welchen Der 5 Vorträge Freuen Sie Sich Am Meisten?

Inhalte im Überblick:Der zweite Stopp des Offline-Treffens Meet TVM 2023 ist für den 17. Juni geplant! Dieses Mal haben wir 5 Vorträge geplant und freuen uns darauf, Sie alle in Zhongguancun, Peking, zu treffen!

Schlüsselwörter:Compiler Offline-Event 2023MeetTVM

Dieser Artikel wurde zuerst auf der öffentlichen HyperAI WeChat-Plattform veröffentlicht~

Am 4. März fand in Shanghai erfolgreich die erste Offline-Veranstaltung von 2023 Meet TVM statt. Mehr als 100 Ingenieure, die sich mit der Entwicklung von KI-Compilern beschäftigen und die Entwicklung von TVM verfolgen, trafen sich in Wujiaochang zu ausführlichen und hitzigen Diskussionen und Austauschen.

Lesen Sie vorherige Artikel:Veranstaltungsrückblick | 2023 Meet TVM traf sich erstmals in Shanghai, mehr als 100 Ingenieure diskutierten die Gegenwart und Zukunft der maschinellen Lernkompilierung

Nach mehr als drei Monaten ist das mit Spannung erwartete und lang ersehnte Offline-Treffen in Peking endlich da!Wir haben fünf erfahrene KI-Compiler-Experten eingeladen, um ihre Erfahrungen anhand von Anwendungsfällen und Best Practices in realen Szenarien mit dem Publikum zu teilen.

Informationen zur Veranstaltung „Meet TVM Beijing 2023“

⏰ Zeit:17. Juni (Samstag) 14:00-18:00

📍 Ort:Garage Cafe, Haidian West Street Nr. 48, Bezirk Haidian

👬 Anzahl der Personen:100 (begrenzte Plätze, bitte melden Sie sich so früh wie möglich an)

🙌🏻 Melden Sie sich an:Scannen Sie den untenstehenden QR-Code, um sich zu registrieren (wählen Sie eine der beiden Optionen: Aktivitätslinie oder Hunderterraster)

Aktive Zeile:Scannen Sie den QR-Code, um zur Veranstaltungsregistrierung zu gelangen

Baige-Aktivitäten:Scannen Sie den QR-Code, um zur Baige-Eventregistrierung zu gelangen

Scannen Sie den QR-Code und notieren Sie „TVM Beijing“, um der Veranstaltungsgruppe beizutreten

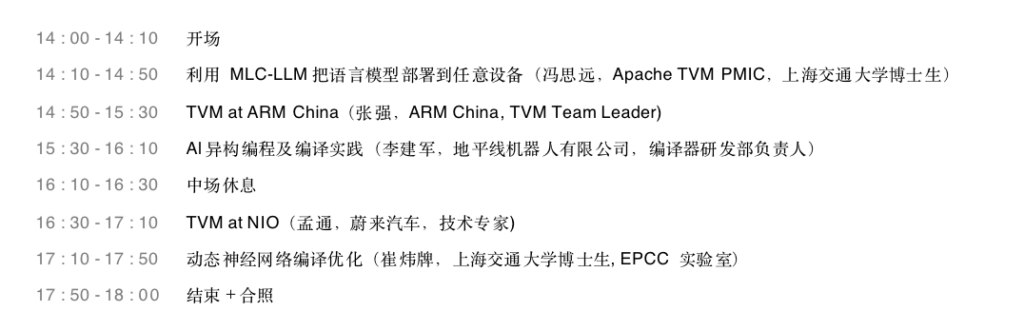

📝 Zeitplan:

Klicken Sie auf das Bild, um die vollständige Tagesordnung anzuzeigen

Kurze Vorstellung der Gäste und Inhalte

Thema teilen:Stellen Sie Sprachmodelle mit MLC-LLM auf jedem Gerät bereit

Inhalt:Im Bereich der generativen KI und der großen Sprachmodelle (LLMs) wurden erhebliche Fortschritte erzielt. Diese verfügen über bemerkenswerte Fähigkeiten und das Potenzial, viele Bereiche grundlegend zu verändern. Derzeit erfordern die meisten dieser Modelle eine hohe Rechenleistung und einen hohen Speicherbedarf und können nicht auf PCs, Mobiltelefonen und kleineren Endgeräten eingesetzt werden. MLC-LLM optimiert Ausführungsgeschwindigkeit und Speicherbedarf durch Kompilierungstechnologie, ermöglicht die Bereitstellung von LLMs auf der Clientseite und bietet eine neue Infrastruktur für die anschließende Entwicklung von Sprachmodellen.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Herausforderungen bei der Bereitstellung großer Modelle

2. Die Rolle der Machine Learning Compilation (MLC)-Technologie in großen Modellszenarien

3. Technische Details hinter MLC-LLM

Thema teilen:TVM bei ARM China

Inhalt:Mit der rasanten Entwicklung von KI-Anwendungen werden auf Edge-Geräten verschiedene NPU-Chips verwendet, um KI-Anwendungen zu beschleunigen. Die schnelle Anpassung an verschiedene Frameworks und Betriebssysteme für maschinelles Lernen ist zu einem schwierigen Problem geworden. Durch die Integration seiner eigenen Toolchain mit TVM hat ARM China mehrere praktische Funktionen wie Graph-Splitting und automatische heterogene Ausführung realisiert und hilft Kunden so, KI-Anwendungen schnell auf dem ARM China Zhouyi NPU-Chip bereitzustellen.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Einführung in die ARM China Zhouyi NPU

2. Implementierung der Graphenaufteilung und automatischen heterogenen Ausführung basierend auf dem BYOC-Framework

3. Aufbau und Verwendung des TVM RPC-Systems

4. TVM-Release-Lösung in kommerzieller Qualität

5. So finden Sie schnell Probleme mit der Modellgenauigkeit

Thema teilen:Heterogene KI-Programmierung und Kompilierungspraxis

Inhalt:KI-Chips entwickeln sich ständig in Richtung eng gekoppelter Heterogenität. Chip-Programmierbarkeit und Leistungsoptimierung sind zentrale Probleme, die die Branche zu lösen versucht. Bei diesem Austausch werden hauptsächlich einige der Praktiken von Horizon in den Bereichen KI-Kompilierungsoptimierung, Programmierbarkeit usw. vorgestellt und einige Schlüsselthemen werden ausführlich mit allen besprochen.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Evolutionstrend der KI-Chiparchitektur

2. Einige praktische Erfahrungen mit der KI-Kompilierungsoptimierung

3. Einige Untersuchungen zur Programmierbarkeit von KI-Chips

Thema teilen:TVM bei NIO

Inhalt:Der Bereich des autonomen Fahrens ist ein Bereich, in dem Herausforderungen und Chancen nebeneinander bestehen. Angesichts der ständigen Produktneuheiten und der immer höheren Anforderungen der Benutzer an das Fahrerlebnis sind herkömmliche KI-Engines nicht in der Lage, komplexe Produktproduktionslinien effizient und sicher zu unterstützen. Wir haben NIOs eigenen KI-Compiler auf Basis von TVM entwickelt, der einige häufige Probleme im Bereich des autonomen Fahrens löste und eine systematische Lösung und technische Architektur bildete. Dieses Mal werden drei Ingenieure von NIO, Meng Tong, Chen Xi und Wang Lulu, Einzelheiten zu den beteiligten Technologien und Architekturen mitteilen.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Besondere Anforderungen an die Modellerstellung und -freigabe im Bereich des autonomen Fahrens

2. So verwenden Sie TVM, um eine kollaborative Optimierung zwischen verschiedenen Systemen/Ökosystemen des maschinellen Lernens durchzuführen

3. Maßgeschneiderte quantitative Lösungen für Anwendungsszenarien des autonomen Fahrens

4. So verwenden Sie die Funktionen von TVM zum Erstellen einer leistungsstarken Inferenzmaschine

Thema teilen:Optimierung der Kompilierung dynamischer neuronaler Netzwerke

Inhalt:Dynamische neuronale Netzwerke weisen gegenüber statischen neuronalen Netzwerken wichtige Vorteile hinsichtlich Genauigkeit, Rechenleistung und Anpassungsfähigkeit auf. Allerdings konzentrieren sich vorhandene Deep-Learning-Frameworks und -Compiler hauptsächlich auf die Optimierung statischer Netzwerke mit deterministischer Ausführung und verpassen so Optimierungsmöglichkeiten in dynamischen Netzwerken. Der Schlüssel zur Optimierung eines dynamischen Netzwerks liegt in der Verfolgung der durch das Netzwerk fließenden Daten. In diesem Vortrag stellen wir unsere Arbeit zur dynamischen Kompilierung neuronaler Netzwerke vor.

Sehen Sie sich diese Sharing-Sitzung an und erfahren Sie:

1. Der Schlüssel zur Optimierung der dynamischen Netzwerkkompilierung: Datenverfolgung auf Subtensorebene

2. Bessere Darstellung dynamischer neuronaler Netzwerke

3. Möglichkeiten zur dynamischen Kompilierungsoptimierung in neuronalen Netzwerken

Vorstellung der Organisatoren und Partner

Als Organisator dieser Veranstaltung, MLC.AI Community (https://mlc.ai/) wurde im Juni 2022 gegründet. Unter der Leitung von Chen Tianqi, dem Haupterfinder von Apache TVM und einem bekannten jungen Wissenschaftler auf dem Gebiet des maschinellen Lernens, startete das Team den MLC-Onlinekurs, der systematisch die Schlüsselelemente und Kernkonzepte der Kompilierung maschinellen Lernens vorstellte.

Im November 2022 werden wir mit den gemeinsamen Anstrengungen der Freiwilligen der MLC.AI-CommunityDas erste vollständige chinesische TVM-Dokument wurde veröffentlicht und erfolgreich auf der offiziellen HyperAI-Website gehostet.Darüber hinaus bietet es inländischen Entwicklern, die an der Kompilierung von maschinellem Lernen interessiert sind, die Infrastruktur (Dokumentation), um auf eine neue Technologie zuzugreifen und sie zu erlernen.

Im Jahr 2023 wird die Community in vielen Städten des Landes die Aktivitätsreihe „2023 Meet TVM“ starten und Unternehmen und Community-Partner zur Teilnahme an der gemeinsamen Gestaltung einladen.

MLC-Onlinekurse:https://mlc.ai/

Chinesische TVM-Dokumentation:https://tvm.hyper.ai/

HyperAI ist Chinas führende Community für künstliche Intelligenz und Hochleistungsrechnen.Wir setzen uns dafür ein, inländischen Entwicklern hochwertige öffentliche Ressourcen im Bereich der Datenwissenschaft zur Verfügung zu stellen.Bisher wurden inländische Downloadknoten für mehr als 1.200 öffentliche Datensätze bereitgestellt, mehr als 300 Abfragen zu Begriffen aus den Bereichen künstliche Intelligenz und Hochleistungsrechnen unterstützt, die komplette chinesische TVM-Dokumentation gehostet und in Kürze werden mehrere grundlegende und beliebte Tutorials veröffentlicht.

Besuchen Sie die offizielle Website:https://orion.hyper.ai/

OpenBayes Bayesian Computing ist ein führender inländischer Anbieter von Hochleistungsrechnerdiensten. Durch die Integration klassischer Software-Ökosysteme und Modelle des maschinellen Lernens in heterogene Chips der neuen Generation bietet es schnellere und benutzerfreundlichere Data-Science-Computing-Produkte für Industrieunternehmen und die wissenschaftliche Forschung an Universitäten. Seine Produkte werden von Dutzenden großer Industrieszenarien oder führenden wissenschaftlichen Forschungsinstituten übernommen.

Besuchen Sie die offizielle Website:https://openbayes.com/

Garage Coffee ist eine Plattform, die Unternehmer zusammenbringt. Basierend auf einem Café bietet es Start-ups eine umfassende Investitions- und Finanzierungslösung aus einer Hand und hilft Projektbeteiligten dabei, schnell Geld aufzutreiben und eine schnelle Entwicklung zu fördern. Gleichzeitig bietet es hochwertige Mehrwertdienste wie Unternehmensberatung, Ressourcenvermittlung, Werbung und Berichterstattung und hilft Investoren dabei, schnell gute Projekte zu entdecken, bietet eine Grundlage für ihre Erstinvestitionen, Folgeinvestitionen, Ressourcenausbeute, Erfahrungsausbeute usw. und fördert die kollaborative Entwicklung zwischen mehrstufigen Investorengruppen.

Aktive Zeile:Scannen Sie den QR-Code, um zur Veranstaltungsregistrierung zu gelangen

Baige-Aktivitäten:Scannen Sie den QR-Code, um zur Baige-Eventregistrierung zu gelangen

Scannen Sie den QR-Code und notieren Sie „TVM Beijing“, um der Veranstaltungsgruppe beizutreten

In Anbetracht der Größe des Veranstaltungsortes dieser Veranstaltung,Wir haben nur 100 Plätze für Sie freigegeben.Um sich einen Platz zu sichern, empfiehlt es sich, sich möglichst frühzeitig anzumelden.

Die Veranstaltungsreihe „Meet TVM“ Q2 2023 findet am 17. Juni in Peking statt. Wir sehen uns dort!

Dieser Artikel wurde zuerst auf der öffentlichen HyperAI WeChat-Plattform veröffentlicht~