Command Palette

Search for a command to run...

AGB 2023 | "Leather Swordsman" Huang Renxun Spricht Über Die Top 5 Der KI, Wissenschaftliches Rechnen, Generative KI Und Omniverse Stehen Auf Der Liste

Von Super Neuro

Inhalte im Überblick:Am 21. März um 23:00 Uhr Pekinger Zeit hielt NVIDIA-Gründer und CEO Jensen Huang eine Grundsatzrede auf der GTC 2023 und stellte die neuesten Entwicklungen in den Bereichen generative KI, Metaverse, große Sprachmodelle, Cloud Computing und anderen Bereichen vor.

Schlüsselwörter:NVIDIA Jen-Hsun Huang AGB 2023

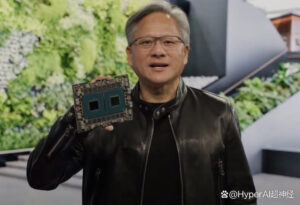

„Verpassen Sie nicht diesen entscheidenden Moment in der KI“, was auf Chinesisch „Verpassen Sie nicht den entscheidenden Moment der KI“ bedeutet. Am 21. März 2023 um 23:00 Uhr Pekinger Zeit hielt „Leather Swordsman“ Huang Xiaoming auf der GTC 2023 eine Grundsatzrede zum gleichen Thema und sagte „Dies wird unser bisher wichtigster AGB sein.“Der offizielle Twitter-Account von NVIDIA hat außerdem die AI Wave Top 5 der diesjährigen GTC veröffentlicht. Was ist die Wahrheit? Werfen wir einen Blick auf die wichtigsten Ankündigungen der diesjährigen Keynote. Suchbild bearbeiten

Suchbild bearbeiten

KI-Wellen-Top 5

Stichwort 1: Generative KI

Die Technologie der generativen KI liefert die grundlegenden Muster und Strukturen von Lerndaten, um neue Inhalte wie Bilder, Audio, Code, Text, 3D-Modelle usw. zu generieren. Professionelle Tools für generative KI können die Produktivität der Entwickler steigern und auch für Benutzer von Nutzen sein, die mit der Technologie weniger vertraut sind. Der Cloud-Dienst NVIDIA AI Foundations und NVIDIA Piccasso wurden auf der GTC 2023 angekündigt.

KI-Technologie revolutioniert die Erstellung von 3D-Inhalten. Auf der GTC 2023Jensen Huang kündigte die Einführung einer neuen Version der Omniverse Audio2Face-Anwendung im Bereich der generativen KI an.

Suchbild bearbeiten Omniverse Audio2Face-Effekt

Suchbild bearbeiten Omniverse Audio2Face-Effekt

Omniverse Audio2Face nutzt künstliche Intelligenz, um 3D-Künstlern die schnelle Erstellung realistischer Gesichtsanimationen aus Audiodateien zu ermöglichen und so den normalerweise zeitaufwändigen und mühsamen manuellen Prozess zu vermeiden. Audio2Face bietet jetzt eine Vorschau der Unterstützung für Mandarin-Chinesisch sowie eine verbesserte Lippensynchronisationsqualität, eine robustere Unterstützung mehrerer Sprachen und neue vortrainierte Modelle.

Die erste Generation eines generativen KI-Supercomputersystems für die Pharmaindustrie wird eingeführt

Das japanische Unternehmen Mitsui & Co. gab die Entwicklung von Tokyo-1 bekannt, einem Supercomputersystem auf Basis von NVIDIA DGX. Tokyo-1 ist das weltweit erste Supercomputersystem mit generativer KI für die Pharmaindustrie und wird zur Erforschung molekulardynamischer Simulationen und generativer KI-Modelle eingesetzt.Das Projekt soll in der zweiten Hälfte des Jahres 2023 online gehen und von Xeureka, einer Tochtergesellschaft von Mitsui & Co., betrieben werden. Xeureka hofft, mit Tokyo-1 die seit langem bestehenden Probleme der schleppenden Arzneimittelentwicklung in der japanischen Pharmaindustrie zu lösen.

Tokyo-1 basiert auf NVIDIA DGX H100 und die erste Phase umfasst 16 NVIDIA DGX H100-Systeme, die jeweils mit 8 NVIDIA H100 Tensor Core GPUs ausgestattet sind. Xeureka wird den Systemumfang weiter ausbauen und japanischen Industriekunden Knotenverbindungsfunktionen bereitstellen, darunter Molekulardynamiksimulation, Training großer Sprachmodelle, Quantenchemie und KI-Generierung molekularer Strukturen für potenzielle Arzneimittelinnovationen. Gleichzeitig können Benutzer von Tokyo-1 über NVIDIA BioNeMo auch Arzneimittelforschung und -dienste anbieten.

Stichwort 2: Digitale Biologie

NVIDIA hat eine Reihe generativer KI-Cloud-Dienste zur Anpassung KI-basierter Modelle veröffentlicht, um die Forschung in Bereichen wie Proteine und Therapeutika, Genomik, Chemie, Biologie und Molekulardynamik zu beschleunigen.

Generative KI-Modelle können potenzielle Arzneimittelmoleküle schnell identifizieren und in einigen Fällen chemische Verbindungen oder proteinbasierte Therapeutika von Grund auf neu entwickeln. Diese Modelle werden anhand großer Datensätze kleiner Moleküle, Proteine sowie DNA- und RNA-Sequenzen trainiert und können die dreidimensionale Struktur eines Proteins vorhersagen sowie bestimmen, wie gut ein Molekül an ein Zielprotein andockt. Suchbild bearbeiten

Suchbild bearbeiten

Der neue BioNeMo™-Cloud-Service beschleunigt die Arzneimittelentwicklung für das Training und die Inferenz von KI-Modellen.Es ermöglicht Forschern, generative KI-Anwendungen anhand ihrer eigenen Daten zu optimieren und die KI-Modellinferenz direkt im Browser auszuführen oder über neue Cloud-APIs problemlos in vorhandene Anwendungen zu integrieren.

Zu den Cloud-Diensten von BioNeMo gehören vortrainierte KI-Modelle, die Forschern bei der Erstellung von KI-Pipelines für die Arzneimittelentwicklung helfen und derzeit von biopharmazeutischen Unternehmen wie Evozyne und Insilico Medicine für die Arzneimittelentwicklung verwendet werden.

Zu den neuen generativen KI-Modellen, die mit den Diensten von BioNeMo verbunden sind, gehören:

* MegaMolBART-Modell für generative Chemie

* ESM1nv-Proteinsprachenmodell

* OpenFold-Modell zur Vorhersage der Proteinstruktur

* AlphaFold2-Proteinstrukturvorhersagemodell

* DiffDock Diffusionsgenerierungsmodell für molekulares Docking

* ESMFold-Modell zur Vorhersage der Proteinstruktur

* ESM2-Proteinsprachenmodell

* MoFlow-Modell für generative Chemie

* ProtGPT-2 Ein Sprachmodell zur Generierung neuer Proteinsequenzen

Stichwort 3: Lebenslauf

CV-CUDA ist eine Open-Source-GPU-Beschleunigungsbibliothek für Cloud-basiertes Computersehen, die Unternehmen dabei helfen soll, durchgängige, KI-basierte Computersehen- und Bildverarbeitungs-Pipelines auf GPUs aufzubauen und zu skalieren. Suchbild bearbeiten

Suchbild bearbeiten

Die visuelle Suchmaschine Bing von Microsoft nutzt KI und Computer Vision, um Bilder im Web zu suchen

(Das Bild zeigt das Hundefutter im Suchbild)

CV-CUDA verlagert Vor- und Nachbearbeitungsschritte von der CPU auf die GPU und verarbeitet so bei gleicher Arbeitslast viermal so viele Streams auf einer einzigen GPU – und das zu einem Viertel der Kosten des Cloud Computing.

Die CV-CUDA-Bibliothek bietet Entwicklern mehr als 30 leistungsstarke Computer-Vision-Algorithmen.Enthält native Python-APIs und Zero-Copy-Integration mit Machine-Learning-Frameworks wie PyTorch, TensorFlow2, ONNX und TensorRT und bietet so einen höheren Durchsatz, geringere Rechenkosten und einen geringeren CO2-Fußabdruck als Cloud-KI-Dienste.

Seit der Alpha-Version von CV-CUDA haben mehr als 500 Unternehmen über 100 Anwendungsfälle erstellt.

Stichwort 4: Autonome Maschinen

Im Jahr 2021 schlug NVIDIA cuOpt vor, eine Echtzeit-Routenoptimierungssoftware, die Unternehmen die Möglichkeit bietet, sich an Echtzeitdaten anzupassen. cuOpt optimiert Lieferrouten durch die Analyse von Milliarden möglicher Bewegungen pro Sekunde.

cuOpt ist heute das Zentrum eines florierenden Partner-Ökosystems, zu dem Systemintegratoren und Dienstleister, Anbieter von Logistik- und Transportsoftware, Experten für Optimierungssoftware und Anbieter von Standortdiensten gehören. cuOpt stellte drei Rekorde im Li & Lim-Abhol- und Liefer-Benchmark auf, einer von Li und Lim vorgeschlagenen Sammlung von Benchmarks zur Messung der Effizienz von Routen.

Suchbild bearbeiten

Suchbild bearbeiten

Für den Li & Lim-Benchmark haben Forscher vor zwei Jahrzehnten die beste Route ausgearbeitet, Algorithmen zum Festlegen und Neufestlegen der berühmtesten Lösungen der Welt erfunden und frühere Gewinner haben sich darauf konzentriert, kleine Anpassungen an früheren Routen vorzunehmen. Die von cuOpt erstellte Route unterscheidet sich von den Routen früherer Gewinner. cuOpt bietet eine 7,2-fache Verbesserung gegenüber der zuvor aufgezeichneten Verbesserung des Benchmarks und eine 26,6-fache Verbesserung gegenüber dem vorherigen State-of-the-Art-Ergebnis.

Stichwort 5: Conversational AI

Unternehmen aller Branchen möchten interaktive Avatare nutzen, um digitale Erlebnisse zu verbessern. Ihre Erstellung ist jedoch ein komplexer und zeitaufwändiger Prozess, der die Anwendung fortschrittlicher Modelle künstlicher Intelligenz erfordert, die Benutzer sehen, hören, verstehen und mit ihnen kommunizieren können. Suchbild bearbeiten

Suchbild bearbeiten

Um diesen Prozess zu vereinfachen,NVIDIA bietet Entwicklern über die Omniverse Avatar Cloud Engine (ACE) Echtzeitlösungen für künstliche Intelligenz.Dies ist eine Cloud-native Microservices-Suite für die End-to-End-Entwicklung interaktiver Avatare. NVIDIA verbessert sich ständig und stellt den Benutzern die Tools zur Verfügung, die sie benötigen.Entwerfen und implementieren Sie ganz einfach eine Vielzahl von Avataren, von interaktiven Chatbots bis hin zu intelligenten digitalen Menschen.

AT&T plant, Omniverse ACE und Tokkio AI-Avatar-Workflows zu verwenden, um virtuelle Assistenten für den Kundendienst und die Helpdesks der Mitarbeiter zu erstellen, anzupassen und bereitzustellen. AT&T entwickelt in Zusammenarbeit mit Quantiphi, einem der Servicebereitstellungspartner von Nvidia, interaktive Avatare, die rund um die Uhr Support in allen Regionen und in den jeweiligen Landessprachen bieten können. Dies hilft dem Unternehmen, Kosten zu senken und gleichzeitig seinen Mitarbeitern weltweit ein besseres Arbeitsumfeld zu bieten. Neben dem Kundenservice plant AT&T auch, digitale Menschen für verschiedene Anwendungsfälle im gesamten Unternehmen aufzubauen und zu entwickeln.

Neben den oben genannten fünf Schlüsselwörtern in der Keynote gibt es noch einige weitere Dinge, die bei GTC 2023 erwähnenswert sind:Huang Renxuns „Online-Verkäufe“ Grace-Superchip, Superchip.

Grace CPU: Wegbereiter für Energieeinsparungen

In tatsächlichen Tests weist der Grace CPU-Superchip bei gleichem Umfang wichtiger CPU-Anwendungen im Rechenzentrum eine doppelt so hohe Leistung auf wie der x86-Prozessor. Dies bedeutet, dass das Rechenzentrum das Doppelte des Spitzenverkehrs bewältigen oder die Stromkosten halbieren kann.

Drei wichtige CPU-Innovationen:

* In einem einzigen Chip verbindet die Grace-CPU 72 Arm Neoverse V2-Kerne mit ultraschnellem Fabric und bietet eine Fabric-Bandbreite von 3,2 TB/s, einen Standarddurchsatz.

* Verbindung zweier Chips zu einem Superchip-Paket mithilfe der NVIDIA NVLink-C2C-Verbindung, die eine Bandbreite von 900 GB/s bietet.

* Die Grace-CPU ist die erste Rechenzentrums-CPU, die LPDDR5X-Speicher in Serverqualität verwendet. Dies bietet bis zu 50% Speicherbandbreite zu ähnlichen Kosten und 1/8 der Leistung eines typischen Serverspeichers, in einer kompakten Größe und mit der doppelten Dichte typischer kartenbasierter Speicherdesigns. Suchbild bearbeiten

Suchbild bearbeiten

Lao Huangs Live-Show Grace Superchip

Der Test ergab, dassIm Vergleich zu den führenden x86-CPUs im Rechenzentrum mit gleichem Stromverbrauch bietet die Grace-CPU:

* Microservices sind 2,3-mal schneller;

* Die Geschwindigkeit der speicherintensiven Datenverarbeitung wurde um das Zweifache erhöht;

* Die numerische Strömungsdynamik ist jetzt 1,9-mal schneller.

NVIDIA: Der Motor der KI-Welt

Seit Ende letzten Jahres hat ChatGPT generative KI und große Sprachmodelle in den Vordergrund gerückt. Aus Huang Renxuns Sicht hat ChatGPT eine neue Ära eingeläutet. Der „iPhone-Moment“ der KI, aber in der heutigen Keynote-Liveübertragung gab er auch zu „Die beeindruckenden Fähigkeiten der generativen KI haben bei Unternehmen ein Gefühl der Dringlichkeit geweckt, ihre Produkte und Geschäftsmodelle neu zu konzipieren.“Es ist ersichtlich, dass NVIDIA begonnen hat, mehrdimensionale Durchbrüche zu erzielen, vom KI-Training bis zur Bereitstellung, von Halbleitern bis zu Softwarebibliotheken, von Systemen bis zu Cloud-Diensten usw.

Derzeit umfasst das globale NVIDIA-Ökosystem 4 Millionen Entwickler, 40.000 Unternehmen und 14.000 Startups in NVIDIA Inception.Wie Huang Renxun in einem Interview mit CNBS am Vorabend von GTC 2023 sagte, möchte NVIDIA ein solches Unternehmen werden:

Aufgrund unserer Arbeit könnten wir das kaum Mögliche möglich machen, oder wir könnten etwas, das viel Energie verbraucht, sehr energieeffizient machen, oder wir könnten etwas, das viel Geld kostet, erschwinglicher machen.

-- über--