Command Palette

Search for a command to run...

GPT-4 Zielt Auf Multimodalität Ab, Mit Google PaLM-E in Der Vergangenheit. Wird Sich Die KI-Landschaft Ändern?

Inhalte im Überblick:GPT-4 war wie eine Atombombe, die am 14. März den gesamten Technologiekreis zur Detonation brachte. Im Zentrum dieser nuklearen Explosion zeigte das mit großer Spannung erwartete GPT-4 seine Muskeln, während am Rande der nuklearen Explosion Google und andere Götter neidisch zusahen und ständig aktiv wurden.

14. März, Eastern Time,OpenAI hat das groß angelegte multimodale Modell GPT-4 eingeführt. GPT-4 ist die Technologie hinter ChatGPT und Bing AI-Chatbots. OpenAI sagte, dass GPT-4 Bild- und Texteingaben akzeptieren und Textinhalte ausgeben kann, obwohl seine Fähigkeiten in vielen realen Szenarien nicht so gut sind wie die des Menschen.Allerdings hat es bei einer Reihe professioneller und akademischer Benchmarks eine Leistung auf menschlichem Niveau erreicht.

GPT-4 ist plötzlich gelandet: Drei Funktionen erregten Aufmerksamkeit

Dieses Update von GPT-4 enthält drei wichtige neue Funktionen, die erheblich verbessert wurden:Die Texteingabebeschränkung wurde verbessert und es verfügt über die Fähigkeit zur Bilderkennung sowie über stärkere Denkfähigkeiten.

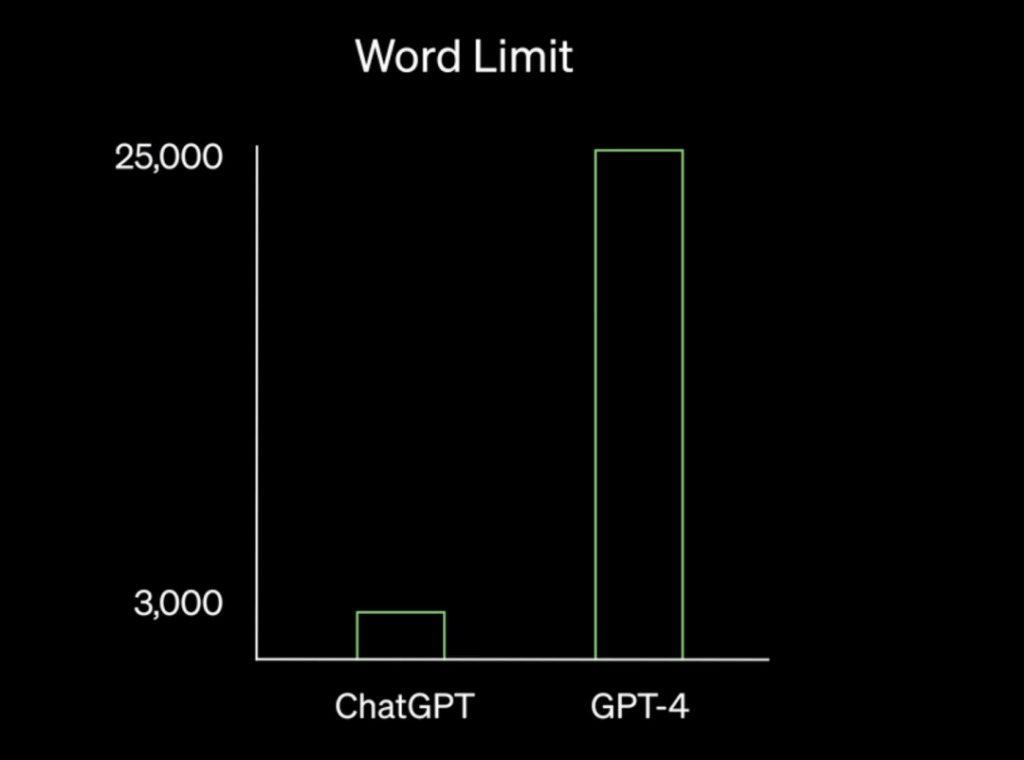

Längere und umfangreichere Inhalte

Laut OpenAIGPT-4 ist in der Lage, Texte mit mehr als 25.000 Wörtern zu verarbeiten. Medium-Autor Michael King sagte, dass diese Funktion die Erstellung von längeren Inhalten wie Artikeln und Blogs ermöglicht, was Unternehmen und Einzelpersonen Zeit und Ressourcen sparen kann.

Darüber hinaus ermöglicht die Verarbeitung großer Textmengen durch GPT-4 längere Gespräche, sodass KI-Chatbots in Branchen wie dem Dienstleistungssektor detailliertere und aufschlussreichere Antworten auf Kundenanfragen geben können. Gleichzeitig ermöglicht diese Funktion auch eine effiziente Dokumentensuche und -analyse und ist somit ein nützliches Tool für Branchen wie Finanzen, Recht und Gesundheitswesen.

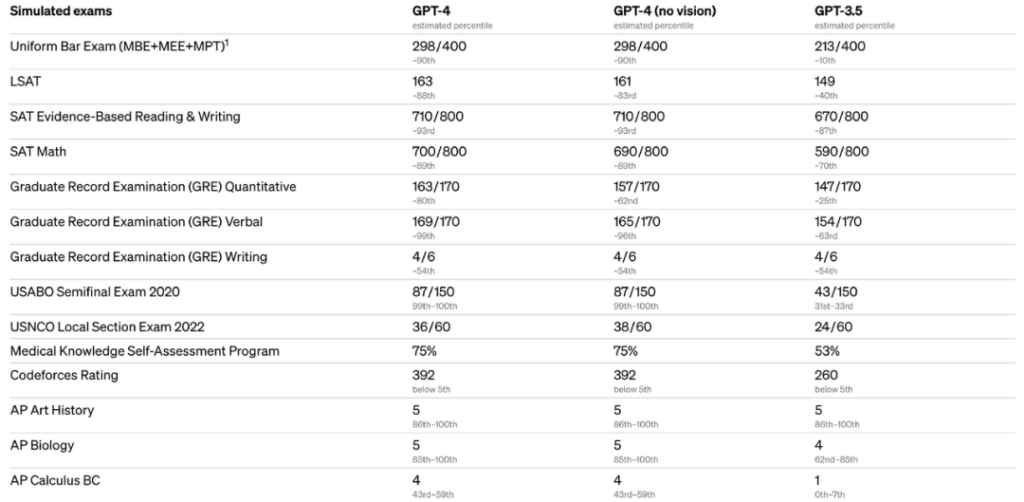

Mehr Denkfähigkeit

OpenAI sagte, dass die von GPT-4 generierten Antworten weniger Fehler aufweisen und 40% genauer sind als GPT-3.5. Gleichzeitig gibt es beim Chatten keinen großen Unterschied zwischen GPT-3.5 und GPT-4, aber wenn die Aufgabe komplex genug ist, ist GPT-4 zuverlässiger, kreativer und kann subtilere Anweisungen verarbeiten als GPT-3.5. Es wird berichtet, dass GPT-4 an einer Vielzahl von Benchmarktests teilgenommen hat.Darunter sind Kandidaten, die im Uniform Bar Exam, LSAT und anderen Prüfungen mehr als 88% erreicht haben.

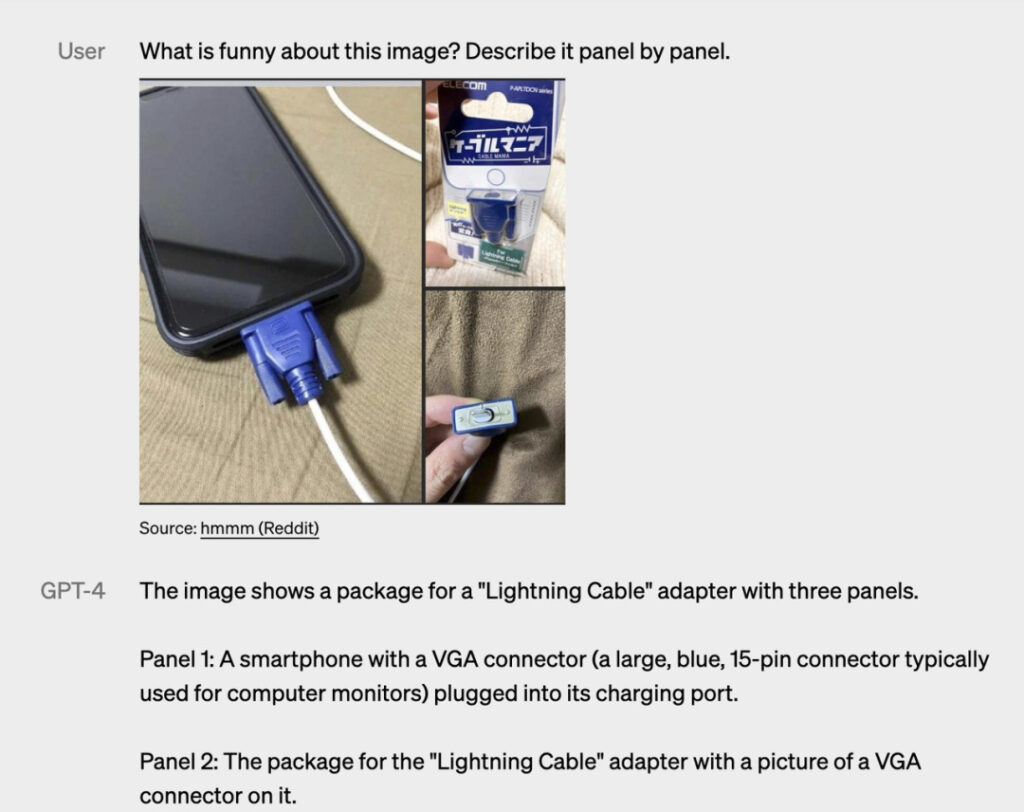

Tolles neues Feature: Multimodalität

Neben besseren Antwortfähigkeiten,Ein weiteres herausragendes Merkmal von GPT-4 ist, dass es Eingaben in Form von Text und Bildern akzeptieren kann.Bildtypen können Fotos, Diagramme, Screenshots usw. sein. Beispielsweise das folgende Beispiel:

Frage: Was ist an diesem Bild lustig? Beschreiben Sie es Punkt für Punkt.

GPT-4-Antwort: Das Bild zeigt einen „Lightning Cable“-Adapter mit drei Bildern.

Abbildung 1: Ein Smartphone mit einem VGA-Anschluss (ein großer, blauer 15-poliger Anschluss, der häufig bei Computermonitoren verwendet wird), der an den Ladeanschluss angeschlossen ist.

Abbildung 2: Die Verpackung des Adapters „Lightning Cable“ mit der Abbildung eines VGA-Anschlusses.

Abbildung 3: Eine Nahaufnahme des VGA-Anschlusses mit einem kleinen Lightning-Anschluss am Ende (zum Aufladen von iPhones und anderen Apple-Geräten).

Der Humor dieses Bildes entsteht durch die Absurdität, einen großen, veralteten VGA-Stecker in einen kleinen, modernen Smartphone-Ladeanschluss zu stecken.

Bitte beachten Sie, dass diese Funktion noch in der Forschervorschauversion enthalten ist.Es ist nicht für die Öffentlichkeit zugänglich.OpenAI hat noch nicht bekannt gegeben, wann es geöffnet wird.

„Es ist nicht perfekt“

Bei der Einführung der neuen Funktionen von GPT-4 räumte OpenAI auch einige seiner Einschränkungen ein. Wie bei früheren Versionen von GPT,GPT-4 weist immer noch Probleme auf, wie etwa soziale Vorurteile, Halluzinationen und feindselige Aufforderungen.Mit anderen Worten: GPT-4 ist derzeit nicht perfekt. OpenAI sagte jedoch auch, dass man hart daran arbeite, diese Probleme zu lösen.

Multimodale Modelle: Google übernimmt die Führung beim Servieren von Vorspeisen

Obwohl die Multimodalität ein Highlight von GPT-4 ist, muss gesagt werden, dassGPT-4 ist nicht das einzige multimodale Modell.

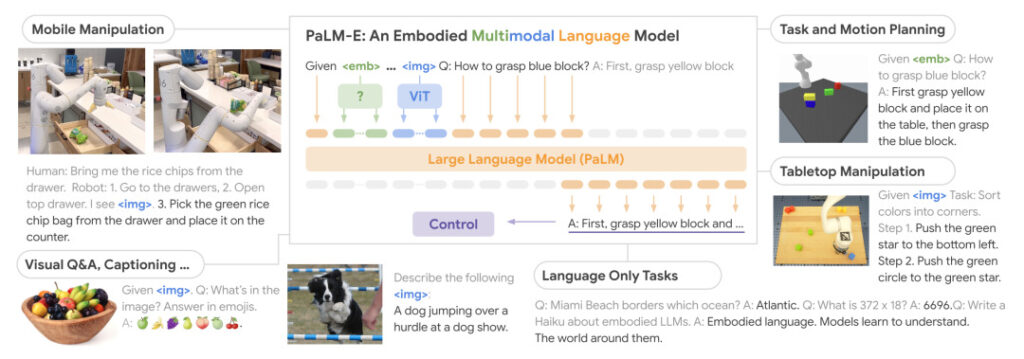

Der Microsoft-KI-Technikexperte Holger Kenn stellte das sogenannte multimodale Modell vor, das nicht nur Text in Bilder, sondern auch in Audio und Video übersetzen kann. Anfang dieses MonatsGoogle hat das größte visuelle Sprachmodell der Geschichte veröffentlicht – PaLM-E (Pathways Language Model with Embodied),Ein eingebettetes multimodales Sprachmodell für die Robotik. PalM-E integriert das 540B PaLM-Sprachmodell und das 22B ViT-Visualmodell und verfügt somit über 562B Parameter.

Die Forscher führten ein End-to-End-Training für mehrere Aufgaben durch, darunter Roboterbetriebsregeln, visuelle Fragenbeantwortung und Bildbeschriftung. Die Auswertungsergebnisse zeigten, dass das Modell verschiedene Denkaufgaben effektiv lösen kann und einen „positiven Transfer“ auf unterschiedliche Beobachtungsmodalitäten und mehrere Entitäten aufweist. Das Modell ist nicht nur auf Roboteraufgaben trainiert, sondern schneidet auch bei visuell-sprachlichen Aufgaben gut ab.

Wenn im Demonstrationsbeispiel ein Mensch den Befehl „Gib mir die Kartoffelchips aus der Schublade“ gibt, kann PaLM-E einen Aktionsbefehl für einen mit einem Roboterarm ausgestatteten Roboter generieren und die Aktion ausführen. Dies geschieht durch die Analyse der Daten der Roboterkamera, ohne die Szene vorab zu verarbeiten.

PaLM-E verleiht dem Roboter nicht nur die oben genannten Fähigkeiten, sondern ist auch selbst ein visuelles Sprachmodell, das Geschichten anhand von Bildern erzählen oder Fragen basierend auf dem Inhalt der Bilder beantworten kann.

Ist das multimodale Modell gleichbedeutend mit der Veröffentlichung des iPhone?

Es scheint, als sei im gesamten KI-Bereich ein Wettrüsten in vollem Gange. Angesichts der explosionsartigen Popularität von ChatGPT hat Google Bard dringend freigegeben, um weiter voranzukommen. Vor Kurzem schlug das Unternehmen erneut zurück, indem es seine eigene API für große Sprachmodelle, die „PaLM API“, öffnete und außerdem das Tool MakerSuite herausbrachte, mit dem Entwickler schnell KI-Programme erstellen können.

Obwohl OpenAI-CEO Sam Altman in einem Interview vor kurzem noch ein Geheimnis über den Veröffentlichungstermin von GPT-4 machte und behauptete: „Wir wollen sicherstellen, dass es bei der Veröffentlichung sicher und verantwortungsvoll ist“, ist das plötzliche Auftauchen von GPT-4Es ist unvermeidlich, dass darüber spekuliert wird, ob das Unternehmen aufgrund der ständigen Gegenangriffe und Einkreisungen durch Giganten wie Google gezwungen ist, sein Tempo zu beschleunigen.

Es ist erwähnenswert, dass Sam im Interview auch einen Punkt erwähnte.Die nächste Evolutionsstufe der künstlichen Intelligenz ist die Einführung multimodaler Großmodelle.„Ich denke, das wird ein großer Trend. Allgemeiner gesagt werden diese leistungsstarken Modelle eine der wirklich neuen Technologieplattformen sein, die wir seit der Erfindung des Mobiltelefons nicht mehr hatten.“

Ob die Blockbuster-Veröffentlichung von GPT-4 den offiziellen Beginn der Ära multimodaler Modelle markiert, bleibt abzuwarten, aber seine leistungsstarken Funktionen haben bei vielen Entwicklern und sogar bei normalen Menschen die Sorge ausgelöst, ob sie dadurch ersetzt werden. Als Antwort auf diese Frage können vielleicht die öffentlichen Äußerungen von Microsoft-Deutschland-Chefin Marianne Janik vor einigen Tagen dienen. Sie glaubt, dass die aktuelle Entwicklung der KI mit der Entstehung des iPhones vergleichbar ist. Gleichzeitig machte sie auch klar, dassEs geht nicht darum, Arbeitsplätze zu ersetzen, sondern darum, wiederkehrende Aufgaben anders als bisher zu erledigen.

「Der Wandel wird dazu führen, dass sich traditionelle Arbeitsmodelle ändern, aber wir sollten auch erkennen, dass dieser Wandel viele neue Möglichkeiten mit sich bringt und daher spannende neue Karrieren entstehen werden."

Referenzlinks:

[1]https://openai.com/research/gpt-4

[2]https://venturebeat.com/ai/openai-releases-highly-anticipated-gpt-4-model-in-surprise-announcement/

[3] https://palm-e.github.io/

[4]https://medium.com/@neonforge