Command Palette

Search for a command to run...

DeepMind Veröffentlicht DreamerV3, Einen Allgemeinen Reinforcement-Learning-Algorithmus, Der Sich Selbst Beibringen Kann, Diamanten Aufzuheben

Minecraft wird nicht nur von Menschen gespielt. Das bekannte KI-Technologieunternehmen DeepMind hat auch eine spezielle KI zum Spielen von Minecraft entwickelt!

Inhalte im Überblick:Reinforcement Learning ist ein interdisziplinäres Produkt, dessen Kern darin besteht, eine automatische und kontinuierliche Entscheidungsfindung zu erreichen. In diesem Artikel werden die neuesten Forschungs- und Entwicklungsergebnisse von DeepMind vorgestellt: DreamerV3, ein allgemeiner Algorithmus, der den Anwendungsbereich des bestärkenden Lernens erweitert. Schlüsselwörter:Allgemeiner DeepMind-Algorithmus für bestärkendes Lernen

Am 12. Januar, Pekinger Zeit, postete DeepMinds offizieller Twitter-Account:Offiziell angekündigter Dreamer V3,Dies ist der erste allgemeine Algorithmus, der im Spiel „Minecraft“ Diamanten von Grund auf sammeln kann, ohne auf menschliche Daten zurückzugreifen, und damit eine weitere wichtige Herausforderung im Bereich der KI löst.

Reinforcement Learning ist ein Problem hinsichtlich der Skalierbarkeit, und für seine Entwicklung werden allgemeine Algorithmen benötigt

Durch bestärkendes Lernen können Computer Aufgaben durch Interaktion lösen. So besiegt beispielsweise AlphaGo Menschen im Go-Spiel oder OpenAI Five menschliche Amateurspieler in Dota 2.

Um den Algorithmus jedoch auf neue Anwendungsszenarien anzuwenden, wie etwa den Übergang von Brettspielen zu Videospielen oder Roboteraufgaben,Von Ingenieuren wird verlangt, dass sie kontinuierlich spezialisierte Algorithmen entwickeln.Wie beispielsweise kontinuierliche Kontrolle, spärliche Belohnungen, Bildeingaben und räumliche Umgebungen.

Dies erfordert viel Fachwissen und Rechenressourcen, um die Algorithmen zu optimieren.Dies behindert die Erweiterung des Modells erheblich. Die Entwicklung allgemeiner Algorithmen, die neue Domänen ohne Feinabstimmung erlernen und beherrschen können, ist zu einem wichtigen Mittel geworden, um den Anwendungsbereich des bestärkenden Lernens zu erweitern und Entscheidungsprobleme zu lösen.

Als Ergebnis entstand DreamerV3, gemeinsam entwickelt von DeepMind und der Universität Toronto.

DreamerV3: Ein allgemeiner Algorithmus basierend auf einem Weltmodell

DreamerV3 ist ein allgemeiner und skalierbarer Algorithmus, der auf dem Weltmodell basiert.Es kann unter der Voraussetzung fester Hyperparameter auf eine Vielzahl von Domänen angewendet werden und ist besser als spezialisierte Algorithmen.

Zu diesen Domänen gehören kontinuierliche und diskrete Aktionen, visuelle Eingaben und Eingaben mit niedriger Dimension, 2D- und 3D-Welten, unterschiedliche Datenbudgets, Belohnungshäufigkeiten und Belohnungsskalen usw.

DreamerV3 besteht aus 3 neuronalen Netzwerken, die gleichzeitig auf der Grundlage wiederholter Erfahrungen trainiert werden, ohne Gradienten zu teilen:

1. Weltmodell:Vorhersage zukünftiger Ergebnisse potenzieller Aktionen

2. Kritiker:Bestimmen Sie den Wert jedes Falles

3. Schauspieler: Erfahren Sie, wie Sie wertvolle Situationen ermöglichen

Wie in der obigen Abbildung gezeigt, kodiert das Weltmodell den sensorischen Input in eine diskrete Darstellung zt. zt wird durch ein Sequenzmodell mit einem wiederkehrenden Zustand ht vorhergesagt und es wird eine Aktion bei gegeben. Die Eingabe wird in ein Lernsignal und dann in eine Formdarstellung rekonstruiert.

Der Akteur und der Kritiker lernen aus der vom Weltmodell vorhergesagten abstrakten Darstellungsbahn.

Um sich besser an domänenübergreifende Aufgaben anzupassen,Diese Komponenten müssen sich an unterschiedliche Signalstärken anpassen und die Bedingungen zwischen ihren Zielen robust ausbalancieren.

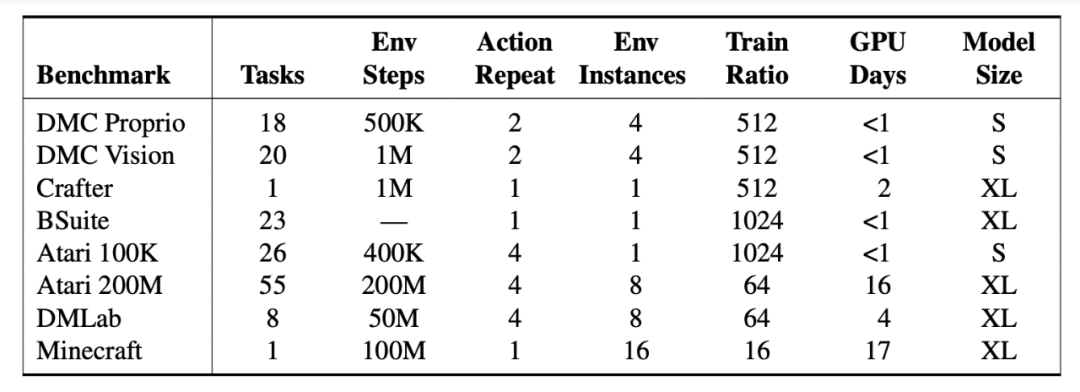

Ingenieure testeten DreamerV3 an mehr als 150 Aufgaben mit festen Parametern und verglichen sie mit den besten in der Literatur aufgeführten Methoden. Die Experimente zeigten, dass DreamerV3 eine hohe Vielseitigkeit und Skalierbarkeit für Aufgaben in verschiedenen Bereichen aufweist.

DreamerV3 erzielte in 7 Benchmarks hervorragende Ergebnisse und etablierte neue SOTA-Levels bei der kontinuierlichen Kontrolle von Status und Image, BSuite und Crafter.

Allerdings weist DreamerV3 noch gewisse Einschränkungen auf.Wenn die Umgebungsschritte beispielsweise weniger als 100 Millionen betragen, kann der Algorithmus nicht wie menschliche Spieler in allen Szenen Diamanten aufnehmen, sondern nur gelegentlich.

Auf den Schultern von Riesen stehen und die Entwicklungsgeschichte der Dreamer-Familie Revue passieren lassen

Erste Generation: Träumer

Veröffentlichungszeit:Dezember 2019

Beteiligte Institutionen:Universität Toronto, DeepMind, Google Brain

Papieradresse:https://arxiv.org/pdf/1912.01603.pdf

Einführung in den Algorithmus:

Dreamer ist ein Agent für bestärkendes Lernen, der langfristige Aufgaben anhand von Bildern lösen kann, indem er nur latente Vorstellungskraft verwendet.

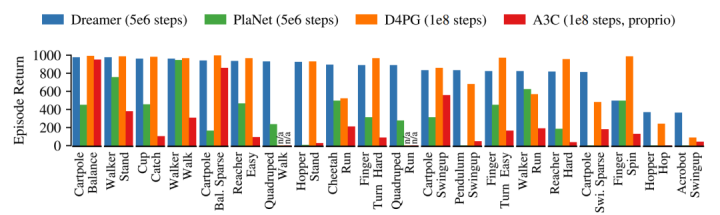

Es verwendet das Weltmodell, um ein effizientes Verhaltenslernen auf der Grundlage der Rückpropagation von Modellvorhersagen zu erreichen. Bei 20 anspruchsvollen visuellen Steuerungsaufgaben übertraf Dreamer die vorherrschenden Methoden hinsichtlich Dateneffizienz, Rechenzeit und Endleistung.

Dreamer übernimmt die Dateneffizienz von PlaNet und übertrifft gleichzeitig die asymptotische Leistung des besten modellfreien Agenten zu dieser Zeit. Nach 5×106 Umgebungsschritten erreichte Dreamers durchschnittliche Leistung bei jeder Aufgabe 823, während die von PlaNet nur 332 betrug. Der höchste modellfreie D4PG-Agent erreichte nach 108 Schritten 786.

Zweite Generation: DreamerV2

Veröffentlichungszeit:Oktober 2020

Beteiligte Institutionen:Google Research, DeepMind, Universität Toronto

Papieradresse:https://arxiv.org/pdf/2010.02193.pdf

Einführung in den Algorithmus:

DreamerV2 ist ein Agent für bestärkendes Lernen, der Verhaltensweisen aus Vorhersagen in einem kompakten latenten Raum eines Weltmodells lernt.

Hinweis: Das Weltmodell verwendet diskrete Darstellungen und wird getrennt von der Richtlinie trainiert.

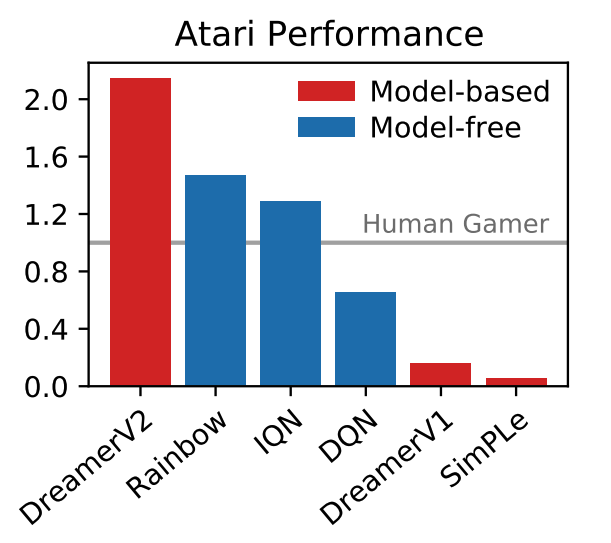

DreamerV2 ist der erste Agent, der bei 55 Aufgaben des Atari-Benchmarks eine Leistung auf menschlichem Niveau erreicht, indem er Verhaltensweisen von einem separat trainierten Weltmodell lernt. Mit dem gleichen Rechenbudget und der gleichen Echtzeit erreicht DreamerV2 200 Millionen Frames und übertrifft damit die endgültige Leistung der Top-Single-GPU-Agenten IQN und Rainbow.

Darüber hinaus eignet sich DreamerV2 auch für Aufgaben mit kontinuierlichen Aktionen. Es lernt ein komplexes Weltmodell eines humanoiden Roboters und löst die Probleme des Stehens und Gehens nur durch Pixeleingabe.

Twitter-Nutzer sind führend bei der Verwendung von Memes im Kommentarbereich

Über die Geburt von DreamerV3 machten viele Internetnutzer auch im Kommentarbereich von DeepMinds Twitter Witze.

Befreie die Menschheit und musst nie wieder Minecraft spielen.

Hören Sie auf, Spielchen zu spielen, und tun Sie etwas Reales! @DeepMind und CEO Demis Hassabis

Der ultimative BOSS von „Minecraft“, der Enderdrache, zittert.

In den letzten Jahren ist das Spiel „Minecraft“ in den Fokus der Forschung zum bestärkenden Lernen gerückt und es wurden bereits viele internationale Wettbewerbe rund um das Sammeln von Diamanten in „Minecraft“ abgehalten.

Die Lösung dieser Herausforderung ohne menschliche Daten gilt allgemein als Meilenstein der künstlichen Intelligenz.Aufgrund der Hindernisse, die sich aus den spärlichen Belohnungen, der schwierigen Erkundung und den langen Zeitspannen in dieser prozedural generierten Open-World-Umgebung ergeben, müssen bisherige Methoden auf menschlichen Daten oder Tutorials basieren.

DreamerV3 ist der erste Algorithmus, der sich das Sammeln von Diamanten in Minecraft von Grund auf selbst beigebracht hat.Es erweitert den Anwendungsbereich des bestärkenden Lernens weiter.Wie die Internetnutzer bereits gesagt haben, ist DreamerV3 bereits ein ausgereifter allgemeiner Algorithmus. Es ist Zeit zu lernen, wie Sie Monster selbst verbessern und töten und gegen den ultimativen BOSS, den Enderdrachen, kämpfen!

Originallink anzeigen:DeepMind veröffentlicht DreamerV3, einen allgemeinen Reinforcement-Learning-Algorithmus, der sich selbst beibringen kann, Diamanten aufzuheben

Folgen Sie HyperAI, um mehr über interessante KI-Algorithmen und -Anwendungen zu erfahren. Wir aktualisieren die Tutorials auch regelmäßig, also lasst uns gemeinsam lernen und uns verbessern!