Junge Menschen mit einem gewissen Maß an wissenschaftlicher Bildung müssen nicht einmal auf diese Schlagzeilen klicken, um zu wissen, dass es sich um Gerüchte oder Übertreibungen handelt. Dennoch kursieren diese Artikel täglich wild in den WeChat-Gruppen und Freundeskreisen der Generation unserer Eltern.

Insbesondere für Eltern ist es schwierig, die Quelle und Authentizität von Nachrichten in der virtuellen Welt zu bestimmen. Solange in einem Artikel komplexe wissenschaftliche Erkenntnisse oder unbekannte wissenschaftliche Institutionen erwähnt werden oder auch nur patriotische oder sentimentale Anstiftungen enthalten sind, besteht eine größere Wahrscheinlichkeit, dass die Leser durch die Gerüchte verwirrt werden und sich sogar an deren Verbreitung beteiligen.

Viele Plattformen versuchen mit allen Mitteln, einen Mechanismus zur Widerlegung von Gerüchten zu etablieren. In der Vergangenheit bestand dieser Mechanismus hauptsächlich aus Beschwerden und manueller Überprüfung, aber in Form einer manuellen Überprüfung ist er immer noch ein Tropfen auf den heißen Stein.

Das gleicheDie Welt, das gleiche Gerücht

Dieses Problem besteht auch in den Vereinigten Staaten. Das in China gebräuchliche „Gerücht“ wird im Englischen oft mit „Rumor“ übersetzt. Tatsächlich bedeutet dieses Wort Hörensagen oder Hörensagen. Strengere Nachrichtenorganisationen übersetzen es möglicherweise als „Falsches Gerücht“, was so viel bedeutet wie falsches Hörensagen.

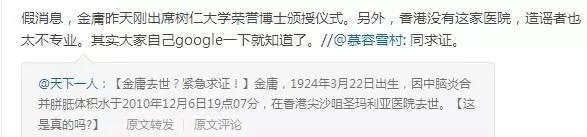

Interessanterweise stellten wir fest, dass sich die Gerüchtemacher auf der ganzen Welt für Nachrichten über den Tod von Prominenten entschieden, als wir verglichen, welche Arten von Gerüchten sich am wahrscheinlichsten am weitesten verbreiten.

Nachrichten mithilfe von KI bereinigen

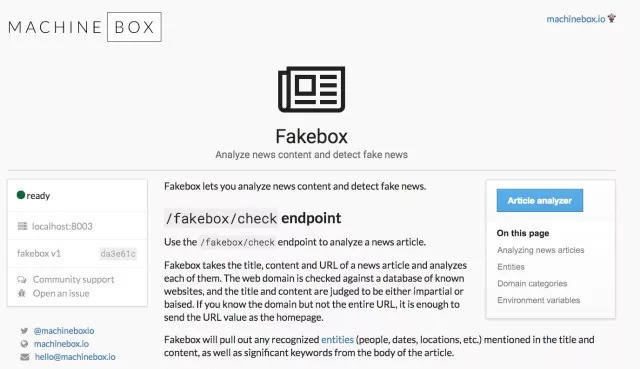

In den USA nutzte ein Ingenieur namens Aaron Edell KI, um einen „FakeBox-Fake-News-Detektor“ zu entwickeln. Obwohl die Genauigkeitsrate relativ hoch ist, ist der Inhalt im englischen Kontext nicht für das chinesische System geeignet. Zweitens besteht für eine kommerzielle Nutzung noch viel Verbesserungsbedarf. Sein Forschungsprozess wird jedoch für Fachleute, die sich mit ähnlicher Forschung beschäftigen, mit Sicherheit von großem Referenzwert sein.

Der Designprozess des „FakeBox Fake News Detector“ verlief nicht immer reibungslos. Der wichtigste Wendepunkt für seinen Erfolg bestand darin, dass er sein Ziel von der Beurteilung falscher Nachrichten auf die Beurteilung echter Nachrichten änderte – die Wahrheit bleibt immer gleich, während Illusionen vielfältig sind.

Im Folgenden ist seine Gedankenreise beim Entwurf von FakeBox beschrieben:

Frage 1: Wie definiert man Fake News?

Die erste Schwierigkeit, auf die ich stieß, war ziemlich unerwartet.Nachdem ich einige Fake News untersucht hatte, stellte ich fest, dass nicht alle Fake News falsch sind, manche Nachrichten übertrieben und manche unbestätigt sind. Tatsächlich sollten Fake News in verschiedene Typen unterteilt werden: offensichtliche Fehler, halbwahre und halbfalsche Nachrichten, reine Pseudowissenschaft, Fake-News-Kommentare usw.

Daher müssen Fake News gründlich geprüft und Stück für Stück eliminiert werden.

Erstes Experiment: Lösung des Problems mit einem Sentimentanalysemodell

Zu Beginn habe ich selbst ein kleines Tool erstellt, das mithilfe eines Crawlers Artikeltitel, Beschreibungen, Autoren und Inhalte erfasst und die Ergebnisse an das Sentimentanalysemodell gesendet hat. Ich habe ein Textfeld verwendet, das sehr praktisch ist, da es eine schnelle Rückmeldung der Ergebnisse ermöglicht. Für jeden Artikel vergibt Textbox eine Punktzahl. Eine Punktzahl über 5 ist positives Feedback und eine Punktzahl unter 5 ist negatives Feedback. Ich habe außerdem einen kleinen Algorithmus erstellt, um die Bewertungen für Titel, Inhalt, Autor usw. des Textes separat zu berechnen und sie dann zu addieren, um sicherzustellen, dass die Bewertung umfassend und integriert ist.

Anfangs funktionierte es einwandfrei, aber nachdem ich den 7. oder 8. Artikel getestet hatte, funktionierte es nicht mehr. Dieser Designprototyp kommt dem von mir vorgestellten Gerüchteerkennungssystem jedoch sehr nahe.

Doch das Ergebnis war ein Misserfolg.

Zweites Experiment: Probleme lösen mit NLP-Modellen

Mein Freund David Hernandez empfahl mir, das Modell anhand des Textes selbst zu trainieren. Ich habe versucht, die Merkmale von Fake News zu verstehen, etwa Website-Quellen und Autorennamen, um zu sehen, ob ich schnell einen Datensatz zum Trainieren eines Modells erstellen könnte.

Wir haben einige Tage damit verbracht, eine große Anzahl unterschiedlicher Datensätze zu sammeln, die für das Trainieren von Modellen nützlich erschienen. Wir dachten, der Datensatz sei groß genug, aber tatsächlich wurde der Inhalt des Datensatzes von Anfang an nicht richtig klassifiziert, da einige als „gefälscht“ oder „irreführend“ gekennzeichnete Websites manchmal echte Artikel enthalten oder nur den Inhalt anderer Websites weiterleiten, sodass die Ergebnisse nicht optimal sind.

Ich begann, jeden Artikel selbst zu lesen und verbrachte viel Zeit mit der Verarbeitung der Daten. Obwohl dieser Prozess sehr schwierig war, begann ich, als ich diese falschen, bösartigen und sogar gewalttätigen Nachrichten dieser Tage sah, an der Zivilisation zu zweifeln, die das Internet fördert. Ich hoffte aber auch, dass mehr Menschen bessere Werkzeuge nutzen könnten, um zu verhindern, dass sie durch Gerüchte vergiftet werden. Nachdem ich die manuelle Überprüfung eingeführt hatte, erreichte der Datensatz im Test eine Genauigkeit von etwa 70 %.

Allerdings weist diese Methode einen fatalen Mangel auf. Nachdem wir versucht hatten, Artikel außerhalb des Datensatzes stichprobenartig zu überprüfen, konnten wir die Authentizität der Informationen immer noch nicht korrekt bestimmen.

Es ist also immer noch fehlgeschlagen.

Das dritte Experiment: Suchen Sie nicht nach Fake News als Datensatz, sondern nach echten Nachrichten

Der Wendepunkt für den Erfolg dieser Angelegenheit war ein Vorschlag von David, der mich wachrüttelte: Er meinte, der Schlüssel zur Verbesserung der Genauigkeit könne in der Vereinfachung des Problems liegen. Vielleicht geht es uns nicht darum, Fake News zu erkennen, sondern echte Nachrichten. Weil echte Nachrichten leichter zu kategorisieren sind – Artikel enthalten ausschließlich Fakten und wichtige Punkte ohne große zusätzliche Erklärungen und es gibt zahlreiche Quellen, die die Echtheit der Nachrichten bestätigen. Also begann ich wieder, Daten zu sammeln.

Ich teile Nachrichten nur in zwei Kategorien ein: real und nicht real. Als unwahr gelten Satire, Meinungsbeiträge, Fake News und andere Artikel, die nicht rein sachlich verfasst sind.

Diesmal ist uns dies mit einer Genauigkeit von über 95 % gelungen.

Das Modell namens Fakebox weist jedem Artikel eine Punktzahl zu. Eine sehr niedrige Punktzahl könnte bedeuten, dass der Artikel gefälscht, ein Meinungsbeitrag, eine Satire oder etwas anderes ist. Und Fakebox verfügt auch über einen Satz REST-APIs, Sie können es in jede Umgebung integrieren oder auf Docker bereitstellen.

Allerdings hat es immer noch einen Nachteil: Wenn der Artikel zu kurz ist oder hauptsächlich aus Meinungen oder Zitaten anderer Personen besteht, kann es schwierig sein zu beurteilen, ob er wahr oder falsch ist.

Fakebox ist also nicht die endgültige Lösung, aber Aaron Edell Ich hoffe, dass dieses Modell für Artikel hilfreich ist, die als wahr oder falsch identifiziert werden müssen.