Google hat vor Kurzem eine intelligente Zeichensoftware namens Auto Draw auf den Markt gebracht. Wie der Name schon sagt, kann die Software automatisch zeichnen. Sie können nach Belieben eine Skizze in der Software zeichnen und diese dann automatisch ähnliche Bilder für Ihre Auswahl zusammenstellen. Dies ist eine sehr einfache Software für künstliche Intelligenz, die der Handschrifteingabefunktion eines Mobiltelefons sehr ähnlich ist.

Zeichen-Cheats?

Gleichzeitig entwickelten Ali Eslami und mehrere andere Wissenschaftler eine intelligentere Zeichensoftware mit bionischem Denken und der Fähigkeit, selbstständig zu lernen. Was diese Software kann: Nach Bereitstellung eines Bildes kann sie eine „Kopie“ zeichnen. Der entscheidende Punkt ist der Zeichenvorgang, d. h., die Software hat die Fähigkeit, Bilder zu zeichnen, anstatt sie einfach wie ein Scanner zu scannen und auszugeben.

Im Folgenden sind die Forschungs- und Entwicklungsideen der Wissenschaftler aufgeführt:

Inspiration:

Wir haben festgestellt, dass Menschen mehr als nur die Oberfläche der Dinge sehen. Wenn wir beispielsweise ein Gebäude sehen, staunen wir nicht nur über die Komplexität des Designs, sondern schätzen auch die handwerkliche Ausführung der Konstruktion. Diese Fähigkeit, das Wesentliche durch Phänomene zu erkennen, ist ein wichtiger Grund dafür, warum die menschliche Intelligenz der anderer Arten überlegen ist. Daher hoffen wir, eine Software zu entwickeln, die so intelligent ist wie der Mensch oder das menschliche Denken nachahmt. Wenn wir uns beispielsweise ein Gemälde ansehen, hoffen wir, dass die Software „verstehen“ kann, wie das Porträt gezeichnet ist, und nicht nur die Pixel des Porträts unterscheiden kann.

Vorbereitung: Ausrüstung

Wir haben die Software mit denselben Zeichenwerkzeugen ausgestattet und festgestellt, dass sie automatisch zwischen den unterschiedlichen Konstruktionsweisen von Zahlen, Personen und Porträts unterscheiden kann. Das Wichtigste dabei ist, dass dies durch autonomes Lernen ohne Training mit einem Datensatz erreicht wird. Dies steht im krassen Gegensatz zu anderen Programmen, die aus einem Datensatz lernen müssen, was zeitaufwändig sein kann.

Ingenieur-Design-Ideen

Schritt 1: Softwaregrundlagen für Deep Reinforcement Learning

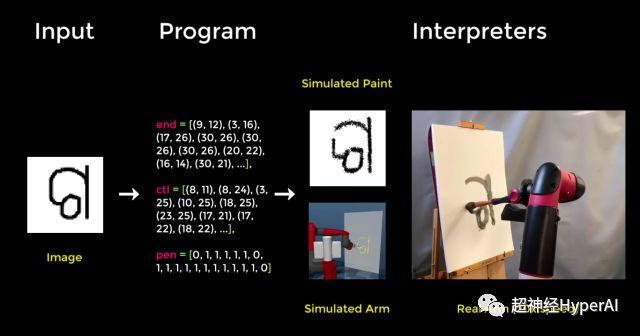

Wir haben zunächst eine Deep-Reinforcement-Learning-Software für die Interaktion mit einem Computer-Malprogramm entwickelt: Zeichnen Sie mit einem elektronischen Stift auf einem digitalen Tablet und ändern Sie Pinselgröße, Druck und Farbe nach Belieben. Da sie jedoch nicht trainiert sind, sind die Striche, die sie zeichnen, alle zufällig und die Gesamtstruktur ist nicht zu erkennen. Um dieses Problem zu lösen, haben wir beschlossen, einen Belohnungs- und Bestrafungsmechanismus einzuführen, um die Produktion wertvollerer Bilder zu fördern.

Schritt 2: Upgrade des Diskriminator-Neuronalen Netzwerks

Anschließend haben wir ein neuronales Netzwerk namens Diskriminator entwickelt, um festzustellen, ob ein Bild von einer Software gezeichnet wurde oder ein echtes Foto ist. Wenn das von der Software gezeichnete Bild als echtes Foto beurteilt wird, wird die Software „belohnt“. Tatsächlich besteht die „Belohnung“ der Software darin, dass sie gelernt hat, den Diskriminator zu täuschen. Dies ähnelt der Methode, die vom vorherigen neuronalen Netzwerk GANS (Generative Adversarial Networks) verwendet wurde. Der Unterschied besteht jedoch darin, dass GAN Pixel direkt ausgibt, während unseres Bilder ausgibt, nachdem die Software mit der realen Bildumgebung interagiert hat.

Schritt 3: Training mit MNIST- und OMNIGLOT-Datensätzen

In der ersten Reihe von Experimenten wurde die Software darauf trainiert, Bilder von Ziffern zu erzeugen, die denen im MNIST-Datensatz ähneln. Durch den Versuch, Bilder zu erzeugen, die den Diskriminator täuschten, lernte die Software, den Pinsel so zu steuern, dass er sich an den Stil verschiedener Ziffern anpasste. Dies wird oft als visuelle Programmiertechnologie bezeichnet.

Schritt 4: Verbreitung in realen Personendatensätzen

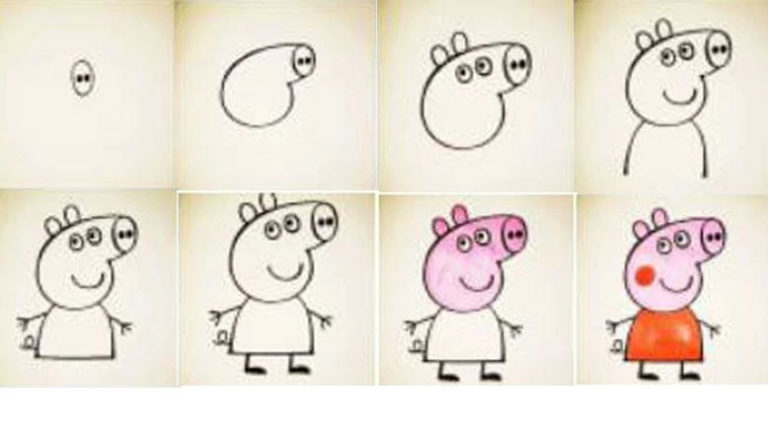

Wir trainieren die Software auch mit bestimmten Bildern, indem wir sie bitten, „kopierte“ Bilder zu generieren. Anschließend lassen wir den Diskriminator bestimmen, ob das „kopierte“ Bild von der Software generiert wurde und ob es eine Kopie des Originalbilds ist. Je schwieriger die Unterscheidung, desto größer die „Belohnung“ (desto mehr lernt die Software). Entscheidend ist, dass in der Software eine Bewegungssequenz gespeichert ist, die den simulierten Pinsel steuert. Dies bedeutet, dass das während der Simulation Gelernte auf andere ähnliche Umgebungen angewendet werden kann, beispielsweise auf einen Roboterarm, um eine reale Person zu simulieren. Die Video-Screenshots sind wie folgt:

Hinzu kommt, dass das Framework auf reale Datensätze erweitert werden kann. Beim Training zum Zeichnen der Gesichtsausdrücke von Prominenten kann die Software die Hauptmerkmale des Gesichts erfassen: Form, Ton, Frisur, genau wie ein Straßenkünstler mit nur wenigen Strichen ein Porträt skizziert.

Zu wissen, was etwas ist und warum es so ist, ist eine Fähigkeit, die der Mensch leicht besitzt und häufig nutzt. In dieser Studie ist es uns gelungen, der Software zu ermöglichen, zu „verstehen“, wie ein Gemälde gezeichnet wurde, nachdem sie es gesehen hat.Während dieser Zeit lernte ich auch visuelle Programmiertechniken und wie man Ursache-Wirkungs-Beziehungen prägnant ausdrückt.

Obwohl es sich hierbei nur um eine kleine Studie handelt, sind Folgetechnologien dieser Art von wesentlicher Bedeutung, um der künstlichen Intelligenz menschenähnliche kognitive, generalisierende, analytische und kommunikative Fähigkeiten zu verleihen. Obwohl es unmöglich ist, Designer kurzfristig zu ersetzen, und es sogar unmöglich ist, irgendeinen der „Adobe-Familien-Buckets“ zu ersetzen, lässt sich nicht leugnen, dass uns das Aufkommen automatischer Zeichensoftware tatsächlich ein weiteres interessantes und vielversprechendes Anwendungsszenario der künstlichen Intelligenz eröffnet hat.