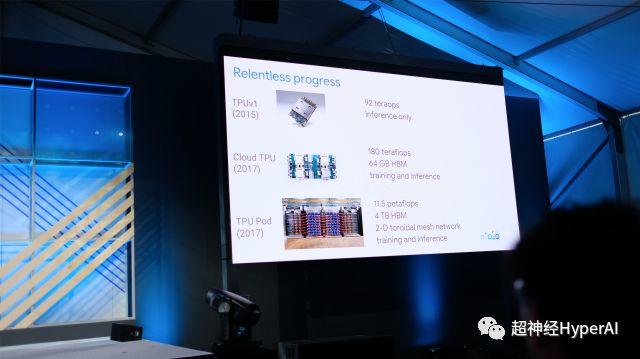

Bei der Eröffnung von Google 2018 stellte Sundar Pichai kurz die Fähigkeit von Google vor, künstliche Intelligenz zur Teilnahme an Diagnose und Behandlung sowie zur Verarbeitung von Audio und Video einzusetzen. Wie erwartet vergab er den C-Platz der gesamten Konferenz an TPU – diesen von Google für Deep Learning entwickelten Tensorprozessor, der sich zu Googles stärkster Kraft im Bereich der künstlichen Intelligenz entwickelt hat.

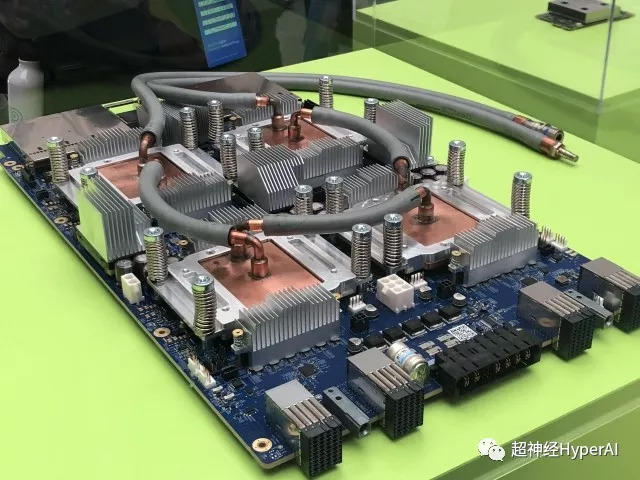

TPUv3 weist im Vergleich zu TPUv2, das letztes Jahr veröffentlicht wurde, aber noch nicht öffentlich verfügbar ist, eine deutlich verbesserte Leistung auf. Seine maximale Rechenleistung ist achtmal so hoch wie die der Version 2.0. Die Leistungssteigerung hat allerdings auch ihren Preis. Aufgrund der enormen Zunahme der Wärmeentwicklung waren die Ingenieure gezwungen, den Heizkörper durch ein Messingrohr zu ersetzen. Wie zu erwarten war, gab Sundar Pichai auch zu, dass die Kühllösung für diese TPU-Generation eine Flüssigkeitskühlung ist.

Die maximale Rechenleistung von TPUv2 beträgt 180 Tflops mit 64 GB HBM-Cache, was die Trainingsfähigkeit im Vergleich zur TPU der ersten Generation erhöht. Zak Stone, der Sprecher des TPU-Themas im Zweigstellenlokal, demonstrierte den Trainingsprozess mehrerer Modelle mit Tensor2Tensor und die Leistung war in der Tat sehr beeindruckend. Als Antwort auf die Fragen von Zak Stone nach dem Meeting erkundigte sich Super Neuro nach der Anpassungsfähigkeit von TPU an andere Entwicklungsframeworks. Leider kann TPU, wie erwartet, nur TensorFlow-bezogene Toolchains unterstützen und unterstützt keine anderen Entwicklungsframeworks, allen voran Pytorch. Zak erwähnte auch, dass das Open-Source-Projekt Tensor2Tensor sehr schnell voranschreitet (Sehr schnell).

Frank Chen, ein Google-Ingenieur am selben Ort, sagte gegenüber Super Neuro, dass die Version 3.0 der TPU einen „leichten Anstieg“ des Stromverbrauchs aufweise. Gleichzeitig kommunizieren die TPU-Pods im Computerraum über hochgradig angepasste Kabel miteinander und nicht über Glasfaserlösungen wie Infinity Band. Die ausreichende Bandbreite und der Cache verbessern die Leistungsfähigkeit des gesamten Clusters, bringen aber natürlich auch eine gewisse Belastung für den Energieverbrauch mit sich. Auf die Frage, ob Entwicklern noch in diesem Jahr Zugriff auf Version 3.0 gewährt werden könne, lächelte er unnatürlich und sagte: „Das hoffe ich.“

Hallo, bei welchem Dienst gibt es noch keine Verzögerung? Aber warten Sie: Wenn 3.0 nicht sofort verwendet werden kann, wann wird TPUv2 dann ohne Beantragung eines Kontingents verfügbar sein? Zak Stone sagte, dass alle Entwickler, deren Bewerbungen auf eine Überprüfung warten, sofort eine E-Mail erhalten und die Erlaubnis zur Nutzung des Dienstes erhalten würden, sobald er ins Büro zurückkehrt.

Hoffen wir, dass Zak sofort loslegen kann und bald wieder an seinen Schreibtisch zurückkehrt.

Historische Artikel (zum Lesen auf das Bild klicken)

Google I/O, bekannt als „Frühlingsfest-Gala für Programmierer“

Welche großen Killer wurden freigelassen? 》

„Die Japaner haben seltsame Ideen und selbst ihre KI-Arbeit ist nicht seriös.“

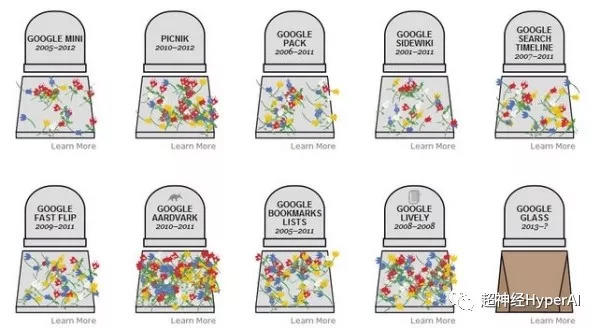

„Eine detaillierte Liste der fehlgeschlagenen Produkte, die bei Google I/O veröffentlicht wurden“》