Command Palette

Search for a command to run...

Super SloMo: Verwendung Neuronaler Netzwerke Zur Erstellung Von Super-Zeitlupe

Um die Probleme des Einfrierens und der Ungleichmäßigkeit von Videos zu lösen, wurde die Methode der Videointerpolation entwickelt. Die von NVIDIA vorgeschlagene Super-SloMo-Methode ist vielen Methoden weit voraus. Bei einem mit gewöhnlicher Ausrüstung aufgenommenen Video kann es „fantasievoll“ ein Zeitlupenvideo mit hoher Bildrate produzieren. Mit diesem magischen Tool wird die Schwelle zur Videoproduktion weiter gesenkt.

Heutzutage streben die Menschen nach immer höheren Videobildraten, da Videos mit hoher Bildrate flüssiger sind und das Seherlebnis der Menschen erheblich verbessern können.

Auch die Bildrate der mit bestehenden Kameras aufgenommenen Videos wurde kontinuierlich von 25 FPS (Frames Per Second) auf 60 FPS und dann auf 240 FPS und noch mehr verbessert.

Allerdings erfordert Kameraausrüstung mit hoher Bildfrequenz einen enormen Speicherbedarf und ist teuer, sodass sie sich noch nicht großer Beliebtheit erfreut. Um Videos mit hoher Bildrate ohne professionelle Ausrüstung zu erhalten, wurde die Videointerpolationstechnologie entwickelt.

NVIDIAs KI-Methode „Gehirnergänzung“ Super SloMo ist vielen Videointerpolationstechnologien weit voraus, auch wenn die Bildrate nur 30-Frame-Videos können mit Super SloMo auch auf 60 Frames, 240 Frames oder sogar mehr erweitert werden.

Vor- und Nachteile herkömmlicher Frame-Einfügungsmethoden

Um Super SloMo besser zu verstehen, werfen wir zunächst einen Blick auf die bestehende, traditionellere Videointerpolationstechnologie.

Frame-Sampling

Beim Frame-Sampling werden Keyframes als Kompensationsframes verwendet. Sein Wesen besteht darin, die Anzeigezeit jedes Schlüsselbilds zu verlängern, was dem Nichteinfügen von Bildern entspricht. Außer einer höheren Bildrate und einer größeren Dateigröße bei gleicher Videoqualität wird dadurch keine Verbesserung der visuellen Wahrnehmung erreicht.

Vorteil:Die Frame-Abtastung verbraucht weniger Ressourcen und ist schnell.

Mangel:Dies kann dazu führen, dass das Video nicht sehr flüssig aussieht.

Frame-Mixing

Beim Frame Blending geht es, wie der Name schon sagt, darum, die Transparenz des vorherigen und nächsten Keyframes zu erhöhen und sie dann in einen neuen Frame einzublenden, um die Lücke zu füllen.

Vorteil:Berechnen Sie, wie lange es dauern wird.

Mangel:Die Wirkung ist nicht gut. Da das ursprüngliche Schlüsselbild einfach durchscheinend gemacht wird, entsteht eine offensichtlich unscharfe Szene, wenn der Umriss des bewegten Objekts das vorherige und das nächste Bild überlappt, was die Glätte des visuellen Effekts des Videos nur geringfügig verbessert.

Bewegungskompensation

Das Prinzip der Bewegungskompensation (MEMC) besteht darin, anhand der Differenz zwischen zwei Bildern die Blöcke mit Bewegung in horizontaler und vertikaler Richtung zu finden, den Bewegungstrend der Bildblöcke zu analysieren und dann die Zwischenbilder zu berechnen.

MEMC wird hauptsächlich in Fernsehern, Monitoren und Mobilgeräten verwendet, um die Videobildrate zu verbessern und den Zuschauern ein flüssigeres Seherlebnis zu bieten.

Vorteil:Reduzieren Sie Bewegungsunschärfe, schwächen Sie Bildnachzieheffekte und Geisterbilder ab und verbessern Sie die Bildschärfe.

Mangel:Wenn der Hintergrund des bewegten Objekts komplex ist, tritt der Fehler der Objektrandbewegung auf.

Optische Flussmethode

Die Methode des optischen Flusses ist eine wichtige Richtung in der Computer-Vision-Forschung. Es leitet die Bewegungsbahn der Pixel anhand der oberen und unteren Frames ab und generiert automatisch neue leere Frames. Es ähnelt in gewisser Weise der Berechnungsmethode für Bewegungsunschärfe.

Vorteil:Das Bild ist flüssiger und die Verzögerung ist weniger spürbar.

Mangel:Die Berechnung ist umfangreich und zeitaufwändig; Es ist lichtempfindlich und neigt bei starken Lichtveränderungen zu Bildfehlern.

Super SloMo: KI-Interpolationsmethode, ein Klassiker in der Branche

Auf der Computer-Top-Konferenz CVPR 2018 veröffentlichte NVIDIA ein Papier „Super SloMo: Hochwertige Schätzung mehrerer Zwischenbilder für die Videointerpolation“In dem Artikel wurde Super SloMo vorgeschlagen, was in der Branche große Aufmerksamkeit erregte.

Adresse des Artikels: https://arxiv.org/pdf/1712.00080.pdf

Super SloMo unterscheidet sich von herkömmlichen Methoden. Es verwendet tiefe neuronale Netzwerke, um die Frame-Interpolation zu implementieren. Die Grundidee ist:Verwenden Sie zum Training eine große Anzahl normaler Videos und Zeitlupenvideos und lassen Sie das neuronale Netzwerk dann lernen, basierend auf normalen Videos qualitativ hochwertige Super-Zeitlupenvideos zu generieren.

Die vom Super SloMo-Team vorgeschlagene Methode,Sein gesamtes Framework basiert auf zwei vollständig faltenden neuronalen Netzwerken U-Net.

Zunächst wird ein U-Net verwendet, um den bidirektionalen optischen Fluss zwischen benachbarten Eingabebildern zu berechnen. Diese optischen Flüsse werden dann bei jedem Zeitschritt linear angepasst, um den bidirektionalen optischen Fluss der Zwischenbilder anzunähern.

Um das Problem der Bewegungsgrenzartefakte zu lösen, wird ein weiteres U-Net verwendet, um den ungefähren optischen Fluss zu verbessern und die flexible Sichtbarkeitskarte vorherzusagen. Abschließend werden die beiden Eingangsbilder verzerrt und linear zu einem Zwischenbild zusammengefügt.

Darüber hinaus hängen die Parameter des optischen Flussberechnungsnetzwerks und des Interpolationsnetzwerks von Super SloMo nicht vom spezifischen Zeitschritt des interpolierten Frames ab (der Zeitschritt wird als Eingabe für das Netzwerk verwendet). Daher kann es Frames in jedem Zeitschritt zwischen zwei Frames parallel interpolieren und so die Einschränkungen vieler Einzelbild-Interpolationsmethoden durchbrechen.

Die Autoren sagen, dass die Generierung von 7 Zwischenbildern mit einer Auflösung von 1280 x 720 mit ihrem nicht optimierten PyTorch-Code auf einer einzelnen NVIDIA GTX 1080Ti- und Tesla V100-GPU nur 0,97 Sekunden bzw. 0,79 Sekunden dauert.

Um das Netzwerk zu trainieren,Die Autoren haben mehrere 240-fps-Videos von YouTube und Handkameras gesammelt. Insgesamt wurden 1100 Videosegmente gesammelt, die aus 300.000 unabhängigen Videobildern mit einer Auflösung von 1080 × 720 bestehen.Diese Videos decken ein breites Spektrum an Szenen ab, von drinnen bis draußen, von statischen Kameras bis zu dynamischen Kameras, von alltäglichen Aktivitäten bis zu Profisport.

Das Modell wurde dann anhand anderer Datensätze überprüft und die Ergebnisse zeigten, dass diese Studie die Leistung bestehender Methoden bei diesen Datensätzen erheblich verbesserte.

Folgen Sie dem Tutorial, um Super SloMo mit einem Klick zu erreichen

Obwohl die Autoren dieses NVIDIA-Dokuments den Datensatz und den Code noch nicht veröffentlicht haben, gibt es in der Öffentlichkeit Experten. Ein Benutzer namens avinashpaliwal hat auf GitHub seine eigene PyTorch-Implementierung von Super SloMo als Open Source veröffentlicht und die Ergebnisse sind fast dieselben wie im Dokument beschrieben.

Die Projektdetails lauten wie folgt:

Da das Training und Testen des Modells auf PyTorch 0.4.1 und CUDA 9.2 erfolgt, ist die Installation dieser beiden Softwareprogramme unbedingt erforderlich. Darüber hinaus benötigen Sie eine NVIDIA-Grafikkarte.

Darüber hinaus kann das Modell nicht direkt mithilfe von Videos trainiert werden, sodass Sie zusätzlich ffmpeg installieren müssen, um Frames aus dem Video zu extrahieren. Nachdem alle Vorbereitungen abgeschlossen sind, können Sie den Adobe 240fps-Datensatz zum Training herunterladen.

Sie müssen diese jedoch nicht vorbereiten, Sie können ein leiser „Frager“ sein und Super SloMo mit einem Klick erreichen.

Wir haben das entsprechende Tutorial auf der Container-Service-Plattform für die Rechenleistung von Machine Learning im Inland gefunden (https://openbayes.com). Von Datensätzen über Codes bis hin zur Rechenleistung ist alles vorhanden, sodass auch ein Anfänger problemlos loslegen kann.

Link zum Tutorial:

https://openbayes.com/console/openbayes/containers/xQIPlDQ0GyD/overview

Tutorial-Benutzerhandbuch

Registrieren Sie sich zunächst und melden Sie sich bei https://openbayes.com/ im Menü „Öffentliche Ressourcen“ an. 「Öffentliches Tutorial」, wählen Sie dieses Tutorial aus——„Implementierung einer Super-SloMo-Super-Zeitlupenkamera in PyTorch“.

Die Beispielanzeigedatei im Tutorial ist Super-SloMo.ipynb. Durch Ausführen dieser Datei wird die Umgebung installiert und der Super-Zeitlupeneffekt der endgültigen interpolierten Frames angezeigt.

Sie können auch Ihr eigenes Videomaterial verwenden und lightning-dick-clip.mp4 im unten generierten Code in Ihren Videodateinamen ändern.

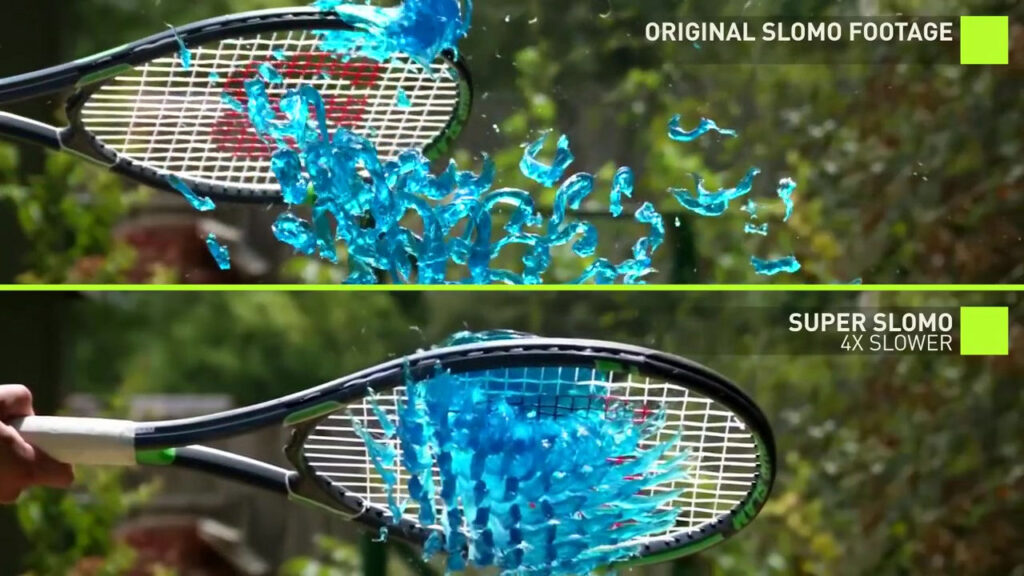

Das Attribut „scale“ wird verwendet, um die Geschwindigkeit des generierten Videos zu steuern. Wenn der Wert beispielsweise auf 4 eingestellt ist, erfolgt eine 4-fache Zeitlupe.

Code generieren:

!python3 'Super-SloMo/eval.py' \ 'lightning-dick-clip.mp4' \ --checkpoint='/openbayes/input/input0/SuperSloMo.ckpt' \ --output='output-tmp.mp4' \ --scale=4print('Done')Videoformatcode konvertieren:

!ffmpeg -i output-tmp.mp4 -vcodec libx264 -acodec aac output.mp4In diesem Tutorial wurde ein Videoclip aus dem Internet verwendet, um eine Super-SloMo-Interpolation durchzuführen, und es wurden die folgenden Ergebnisse erzielt:

Derzeit bietet die Plattform auch jede Woche kostenlose vGPU-Nutzungszeit an. Jeder kann es problemlos ausfüllen, also probieren Sie es jetzt aus!

Quellen:

Papier: https://arxiv.org/pdf/1712.00080.pdf

Projekthomepage: http://jianghz.me/projects/superslomo/

https://zhuanlan.zhihu.com/p/86426432