Command Palette

Search for a command to run...

Das Huake-Team Hat Den Benchmark-Datensatz Für Die Segmentierung Verdeckter Videoinstanzen Von OVIS Veröffentlicht

Die Instanzsegmentierung kann in verschiedenen Anwendungsszenarien umfassend eingesetzt werden. Als wichtige Forschungsrichtung im Bereich der Computervision ist es auch sehr schwierig und herausfordernd. Aufgrund der Okklusion in vielen Szenen wird die Instanzsegmentierung jedoch zu einem schwierigen Problem. Kürzlich haben Forscher der Huazhong-Universität, von Alibaba und anderen Institutionen einen groß angelegten Datensatz zur Segmentierung verdeckter Videoinstanzen (OVIS) vorgeschlagen, um dieses Problem zu lösen.

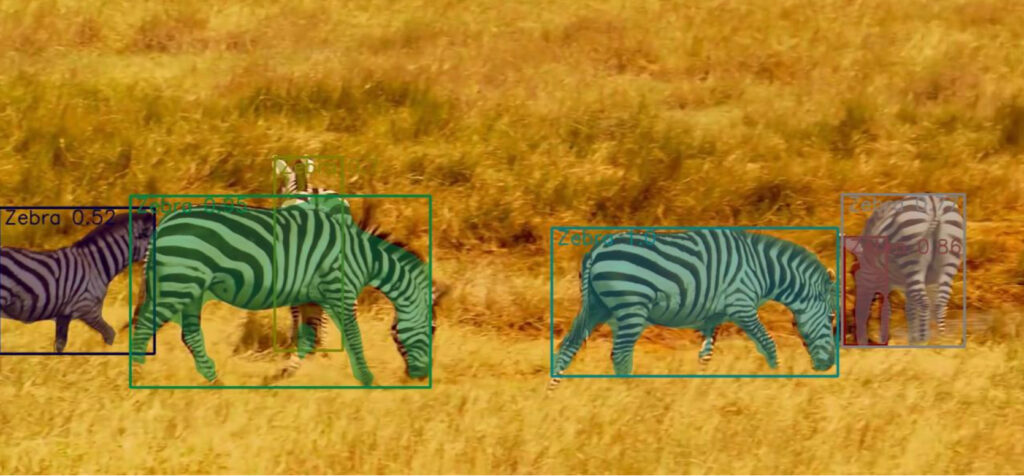

In der Computervision ist die Objekterkennung das Kernproblem und die Instanzsegmentierung gilt als die schwierigste Aufgabe bei der Objekterkennung. Bei der Instanzsegmentierung werden die Pixel eines Objekts basierend auf der Zielerkennung segmentiert.

Objekte blockieren sich oft gegenseitig, was für Ingenieure zu einem Problem geworden ist. Wenn wir Menschen verdeckte Objekte sehen, können wir sie durch Erfahrung oder Assoziation identifizieren.

Ist es also mithilfe der Computervision möglich, verdeckte Objekte wie Menschen genau zu identifizieren? Im Forschungsthema der Instanzsegmentierung war die Lösung der durch Okklusion verursachten Störungen schon immer eine wichtige Forschungsrichtung.

Um dieses Problem zu lösen, haben Teams der Huazhong University of Science and Technology, Alibaba, der Cornell University, der Johns Hopkins University und der Oxford University,Es wird ein umfangreicher Datensatz OVIS (Occluded Video Instance Segmentation) zur Segmentierung verdeckter Videoinstanzen gesammelt, der zum gleichzeitigen Erkennen, Segmentieren und Verfolgen von Instanzen in verdeckten Szenen verwendet werden kann.

Dies ist nach dem Google YouTube-VIS-Datensatz der zweite groß angelegte Datensatz zur Segmentierung verdeckter Videoinstanzen.

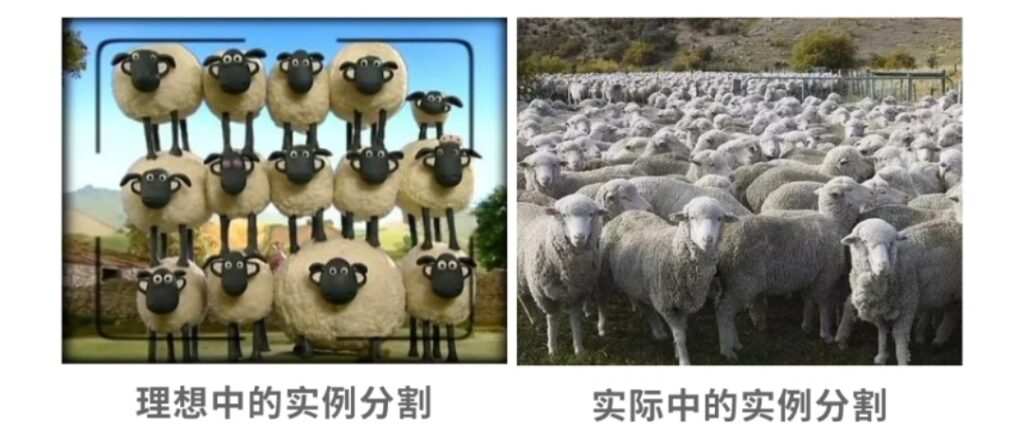

OVIS: Geboren aus 901 stark beeinträchtigten Videos

Bei allem, was wir in unserem täglichen Leben sehen, gibt es nur sehr wenige Objekte, die isoliert erscheinen, und es kommt zu einer mehr oder weniger starken Verdeckung. Untersuchungen zeigen jedoch, dass das menschliche Sehsystem im Falle einer Okklusion immer noch die tatsächlichen Grenzen des Zielobjekts erkennen kann, für das Computer-Vision-System stellt dies jedoch ein großes Problem dar, nämlich das Problem der Segmentierung verdeckter Videoinstanzen.

Um dieses Problem weiter zu erforschen und zu lösen, versuchten Teams der Huazhong University of Science and Technology, Alibaba und anderer Institutionen, ein besseres Modell auf Grundlage des ursprünglichen Open-Source-Algorithmus zur Instanzsegmentierung zu entwickeln.

Um diese Arbeit zu erledigen, sammelte das Team zunächst den OVIS-Datensatz, der speziell für die Segmentierung von Videoinstanzen in verdeckten Szenen entwickelt wurde. In einem kürzlich veröffentlichten Artikel《Segmentierung verdeckter Videoinstanzen》Dieser Datensatz wird ausführlich vorgestellt.

Adresse des Artikels: https://arxiv.org/pdf/2102.01558.pdf

Um diesen Datensatz zu sammeln,Das Team sammelte insgesamt fast 10.000 Videos und wählte schließlich 901 Clips mit starker Okklusion, viel Bewegung und komplexen Szenen aus. Jedes Video hatte mindestens zwei Zielobjekte, die sich gegenseitig verdeckten.

Die meisten Videos haben eine Auflösung von 1920×1080 und eine Dauer zwischen 5s und 60s. Sie führten eine hochwertige Annotation mit einer Dichte von einem Frame pro fünf Frames durch und erhielten schließlich den OVIS-Datensatz.

OVIS enthält insgesamt 296.000 hochwertige Maskenanmerkungen von 5223 Zielobjekten.Im Vergleich zum vorherigen Google Youtube-VIS-Datensatz mit 4883 Zielobjekten und 131.000 Masken verfügt OVIS offensichtlich über mehr Zielobjekte und Maskenanmerkungen.

Allerdings verwendet OVIS tatsächlich weniger Videos als YouTube-VIS, da die Philosophie des Teams längere Videos bevorzugt, um langfristige Tracking-Funktionen zu ermöglichen. Die durchschnittliche Videodauer und die durchschnittliche Instanzdauer von OVIS betragen 12,77 s bzw. 10,55 s, während die von YouTube-VIS 4,63 s bzw. 4,47 s betragen.

Um die Aufgabe der Segmentierung verdeckter Videoinstanzen anspruchsvoller zu gestalten, hat das Team eine bestimmte Anzahl von Videosegmenten geopfert und längere und komplexere Videos kommentiert.

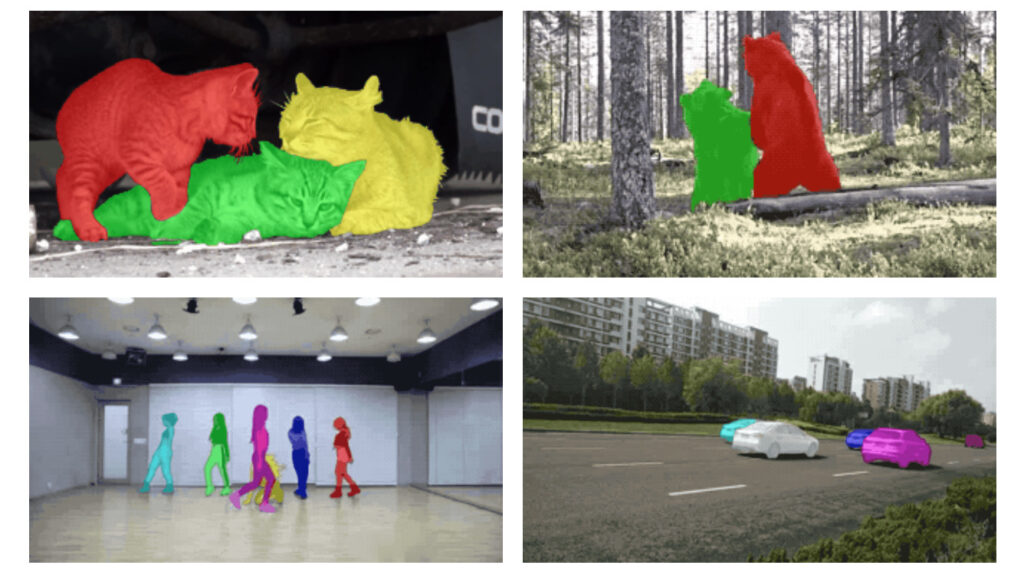

Der OVIS-Datensatz enthält 25 gängige Kategorien des Lebens.Wie in der Abbildung unten gezeigt, umfassen die spezifischen Kategorien: Menschen, Fische, Fahrzeuge, Pferde, Schafe, Zebras, Kaninchen, Vögel, Geflügel, Elefanten, Motorräder, Hunde, Affen, Boote, Schildkröten, Katzen, Kühe, Papageien, Fahrräder, Giraffen, Tiger, Große Pandas, Flugzeuge, Bären und Eidechsen.

Diese Kategorien wurden auf Grundlage der folgenden drei Überlegungen ausgewählt:

- Diese Ziele sind häufig in Bewegung und sind eher stark verdeckt.

- Sie kommen im Leben sehr häufig vor.

- Diese Kategorien überschneiden sich weitgehend mit derzeit gängigen groß angelegten Datensätzen zur Bildinstanzsegmentierung (wie MS COCO, LVIS, Pascal VOC usw.), sodass Forscher problemlos Modelle migrieren und Daten wiederverwenden können.

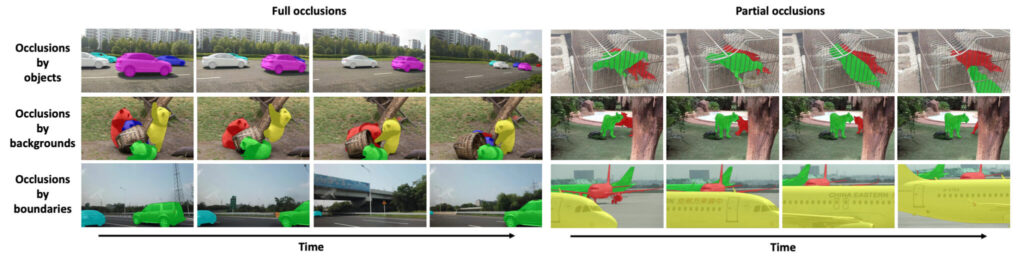

Im Vergleich zu anderen früheren VIS-DatensätzenDas auffälligste Merkmal des OVIS-Datensatzes ist, dass ein großer Teil der Objekte aufgrund verschiedener Faktoren stark verdeckt ist.Daher ist OVIS ein effektives Testfeld zur Bewertung von Videoinstanzsegmentierungsmodellen, die mit starken Verdeckungen zu tun haben.

Um den Schweregrad der Okklusion zu quantifizieren, schlug das Team einen Indikator vor, die mittlere Bounding-Box-Overlap-Rate (mBOR), um den Grad der Okklusion grob widerzuspiegeln. mBOR bezieht sich auf das Verhältnis der Fläche der überlappenden Begrenzungsrahmen zur Fläche aller Begrenzungsrahmen im Bild. Aus der Parametervergleichsliste können wir ersehen, dass OVIS eine stärkere Okklusion aufweist als YouTube-VIS.

Die Details des OVIS-Datensatzes lauten wie folgt:

Segmentierung verdeckter Videoinstanzen

Datensatz zur Segmentierung von Okklusionsvideoinstanzen

Datenquelle:《Segmentierung verdeckter Videoinstanzen》

Enthaltene Menge:5223 Zielobjekte, 296.000 Masken

Anzahl der Typen:25 Typen

Datenformat:Rahmen: jpg; Kommentar: Json

Videoauflösung:1920 × 1080 Datengröße:12,7 GB

Downloadadresse:https://orion.hyper.ai/datasets/14585

OVIS schlägt einen höheren Maßstab für die Segmentierung von Videoinstanzen vor

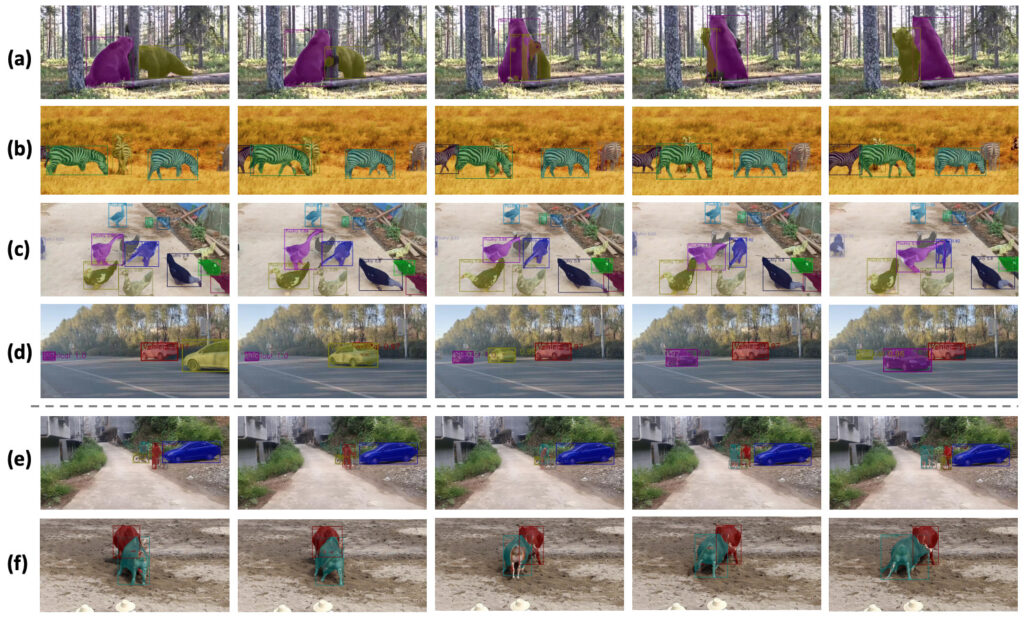

Der OVIS-Datensatz ist zufällig in 607 Trainingsvideos, 140 Validierungsvideos und 154 Testvideos unterteilt. Das Team führte eine umfassende Evaluierung von fünf vorhandenen Open-Source-Videoinstanzsegmentierungsalgorithmen auf OVIS durch, die auch als Benchmark für die Basisleistung des OVIS-Datensatzes dienten.

Die Ergebnisse der Auswertung sind in der folgenden Tabelle dargestellt:

Im Vergleich zu YouTube0-VIS ist die Leistung der fünf Algorithmen FEELVOS, IoUTracker+, MaskTrack R-CNN, SipMask und STEm-Seg auf OVIS um mindestens 50% gesunken.Beispielsweise sinkt der AP von SipMask von 32,5 auf 12,1, während der von STEm-Seg von 30,6 auf 14,4 sinkt. Diese Ergebnisse erinnern die Forscher daran, dem Problem der Segmentierung von Videoinstanzen weitere Aufmerksamkeit zu widmen.

Darüber hinaus verbesserte das Team die Leistung des ursprünglichen Algorithmus durch die Verwendung eines Kalibrierungsmoduls erheblich.Das von ihm entwickelte CMaskTrack R-CNN hat den AP des ursprünglichen Algorithmus MaskTrack R-CNN um 2,6 von 12,6 auf 15,2 verbessert, und CSipMask hat den AP von SipMask um 2,9 von 12,1 auf 15,0 verbessert.

In Abbildung (c) oben, in einer Szene mit vielen Enten, hat die Methode des Teams fast alle Enten korrekt erkannt und verfolgt, aber die Erkennung der äußersten linken Ente im zweiten Bild ist fehlgeschlagen. In einem späteren Bild wurde die Ente jedoch erneut verfolgt, was zeigt, dass das Modell des Teams zeitliche Hinweise gut erfasste.

Das Team bewertete seine vorgeschlagenen Algorithmen CMaskTrack R-CNN und CSipMask anhand des YouTube-VIS-Datensatzes weiter und die Ergebnisse zeigten, dass sie die ursprünglichen Methoden in Bezug auf AP übertrafen.

Zukünftige Anwendungen: Videopanorama-Segmentierung, synthetische Okklusionsdaten

Das Team sagte, dass die Grundleistung häufig verwendeter Videosegmentierungsalgorithmen bei OVIS viel geringer sei als bei YouTube-VIS, was darauf hindeute, dass Forscher in Zukunft mehr Energie in die Verarbeitung verdeckter Videoobjekte investieren sollten.

Darüber hinaus erforschte das Team Möglichkeiten zur Lösung von Okklusionsproblemen durch die Nutzung zeitlicher Kontexthinweise. In Zukunft wird das Team den experimentellen Ansatz von OVIS in Szenarien zur Segmentierung von Videoobjekten in unbeaufsichtigten, halbüberwachten oder interaktiven Umgebungen formalisieren. Darüber hinaus ist es auch wichtig, OVIS auf die Videopanoramasegmentierung auszuweiten (Hinweis: Bei der Videopanoramasegmentierung geht es sowohl um die semantische Segmentierung des Hintergrunds als auch um die Instanzsegmentierung des Vordergrunds, was ein neuer Trend im Bereich der Instanzsegmentierung ist).

Darüber hinaus sind synthetische Okklusionsdaten ein Bereich, den das Team weiter erforschen muss. Das Team ist davon überzeugt, dass der OVIS-Datensatz weitere Forschungen zum Verständnis von Videos in komplexen und vielfältigen Szenarien anstoßen wird.

Diese Technologie wird künftig eine wichtige Rolle bei der Trennung von Charakteren und Hintergründen in Spezialeffekten, Kurzvideos und Live-Übertragungen in Film und Fernsehen spielen.

Quellen:

Adresse des Artikels: https://arxiv.org/pdf/2102.01558.pdf

Offizielle Website des Projekts: http://songbai.site/ovis/

Google YouTube-VIS-Datensatz: