Command Palette

Search for a command to run...

Über PyTorch Und TensorFlow Hinaus Hat Dieses Inländische Framework Etwas

Es gibt bereits so viele Deep-Learning-Frameworks, warum brauchen wir OneFlow? Im Bereich des maschinellen Lernens hat Yuan Jinhui eine langfristigere Vision als jeder andere bei 90%.

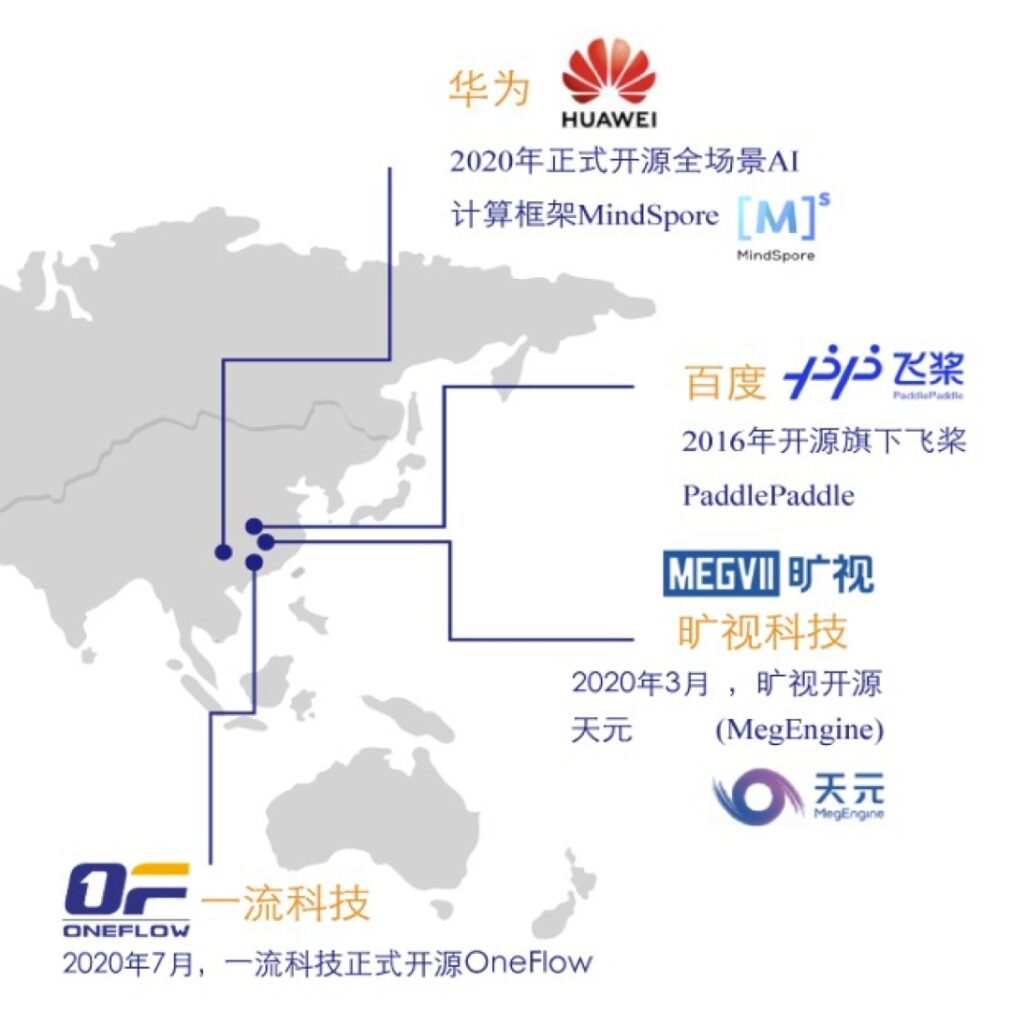

Im Bereich Deep Learning nehmen Mainstream-Frameworks wie PyTorch und TensorFlow zweifellos den größten Teil des Marktanteils ein. Sogar ein Unternehmen auf dem Niveau von Baidu hat viel Personal und Ressourcen aufgewendet, um PaddlePaddle in den Mainstream zu bringen.

In einem solchen ressourcendominierten, auf Raubtiere fokussierten Wettbewerbsumfeld entstand ein inländisches Startup für ein Deep-Learning-Framework namens OneFlow.

Es zeichnet sich durch die Verarbeitung groß angelegter Modelle aus und hat in diesem Jahr seinen gesamten Quellcode und seine experimentellen Vergleichsdaten auf GitHub als Open Source veröffentlicht.

Unweigerlich stellen sich Fragen:Ist OneFlow, eine neue Architektur, die sich gut zum Lösen großer Modelltrainingsprobleme eignet, notwendig? Ist die Effizienz von Deep-Learning-Frameworks so wichtig? Ist es für Startups möglich, sich von der Konkurrenz abzuheben?

Wir haben die Gelegenheit der Open-Source-Jahreskonferenz CosCon 20 genutzt, um Yuan Jinhui, CEO von Yili Technology, zu interviewen und die Geschichte hinter den mehr als 1.300 Tagen und Nächten und Hunderttausenden von Codezeilen zu erfahren, an denen er und seine Ingenieure gearbeitet haben.

Egal wie viele Heiligenscheine Sie haben, Sie müssen bei der Gründung eines Unternehmens immer einen Schritt nach dem anderen machen

Im November 2016 schrieb Yuan Jinhui die erste Version des Designkonzepts von OneFlow in einem Bürogebäude in der Nähe der Tsinghua-Universität. Zu diesem Zeitpunkt hatte Yuan Jinhui gerade bei Microsoft Research Asia (MSRA) gekündigt, wo er fast vier Jahre lang gearbeitet hatte.

„Ehemaliger MSRA-Mitarbeiter“ ist nicht der einzige Spitzname, der mit Yuan Jinhui in Verbindung gebracht wird. Nach seinem Abschluss an der Xidian-Universität im Jahr 2003 wurde ihm die Fakultät für Informatik der Tsinghua-Universität zur Fortsetzung seines Doktoratsstudiums empfohlen.Er studierte bei Professor Zhang Bei, einem Mitglied der Chinesischen Akademie der Wissenschaften und einem der Gründer der chinesischen KI-Disziplin.

Nach seinem Abschluss an der Tsinghua-Universität im Jahr 2008 wechselte Yuan Jinhui zu NetEase und 360 Search. Das von ihm entwickelte Hawkeye-System wird von der chinesischen Nationalmannschaft als tägliches Trainingshilfssystem verwendet. Darüber hinaus konzentrierte er sich während seiner Zeit bei MSRA auf groß angelegte Plattformen für maschinelles Lernen.Wir haben außerdem den weltweit schnellsten Algorithmus und das schnellste System zum Trainieren von Themenmodellen entwickelt: LightLDA.Wird im Online-Werbesystem von Microsoft verwendet.

LightLDA wurde 2014 eingeführt. Nur zwei Jahre später stellte Yuan Jinhui, der eine einzigartige Vision hatte, eine kühne Vermutung auf:Mit zunehmenden Geschäftsanforderungen und -szenarien werden verteilte Deep-Learning-Frameworks, die das Training großer Modelle effizient bewältigen können, nach Hadoop und Spark unweigerlich zum Kern der Infrastruktur im Zeitalter der Datenintelligenz.

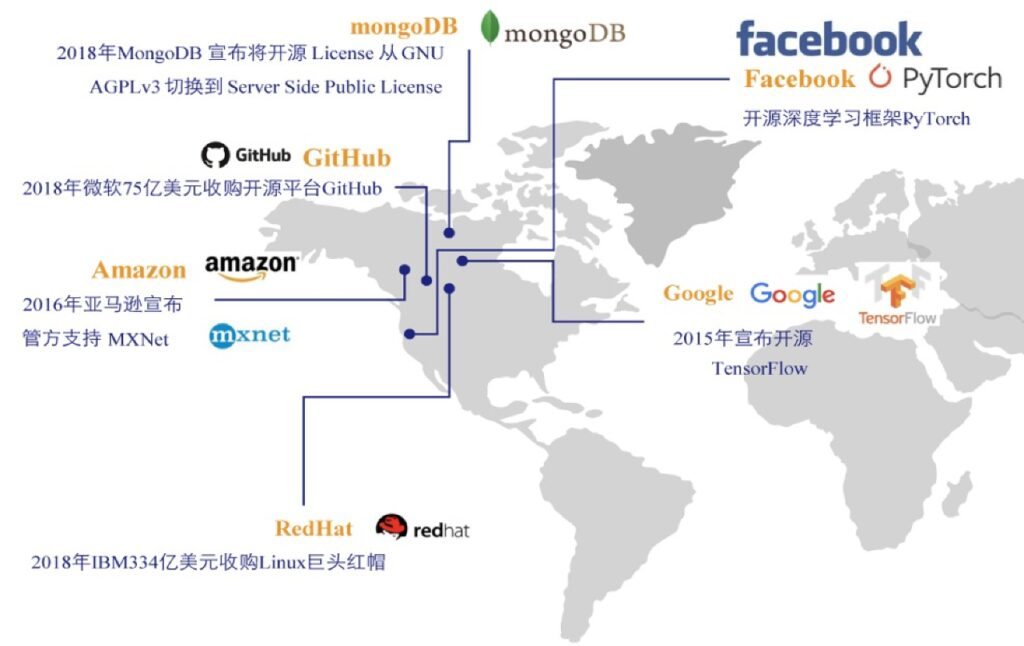

Allerdings wurden die damals gängigen Deep-Learning-Frameworks alle von großen Unternehmen wie Google, Amazon und Facebook entwickelt, und selbst in China war die Situation ähnlich.Dies liegt daran, dass die Entwicklung eines Deep-Learning-Frameworks nicht nur enorme Forschungs- und Entwicklungskosten erfordert, sondern – was noch wichtiger ist – die Fähigkeit, Einsamkeit zu ertragen und auf einen langwierigen Krieg vorbereitet zu sein. Daher wagt es kein Startup, sich auf diesem Gebiet zu versuchen.

Die bestehenden Deep-Learning-Frameworks sind bereits in vollem Gange. Wenn ein Startup ein neues Framework entwickelt, werden die Benutzer es kaufen? Der handlungsorientierte Yuan Jinhui wagt nicht nur zu denken, er wagt auch zu handeln.

Als er die erste Codezeile für OneFlow eintippte, hatte er die detaillierte Implementierungsstrategie noch nicht durchdacht, geschweige denn die perfekte Geschäftslogik. Seine Idee ist einfach und doch komplex.Wir möchten ein Produkt herstellen, das Entwickler gerne verwenden.

Eine Gruppe von Genies + 21 Monate, die erste Version von OneFlow wird gestartet

Im Januar 2017 gründete Yuan Jinhui Yiliu Technology, versammelte über 30 Ingenieure und startete den offiziellen „Teamkampf“ von OneFlow. Obwohl jeder mit den Schwierigkeiten gerechnet hatte, übertrafen die vielen Schwierigkeiten, die im Verlauf der Entwicklung auftraten, die Erwartungen des Teams.

Die Technologie des Deep-Learning-Frameworks ist sehr komplex und OneFlow verwendet eine brandneue technische Architektur ohne Vorbildcharakter. Allein bis das technische Konzept funktionierte, dauerte es fast zwei Jahre.

Im Herbst 2018 trat die Entwicklung erstklassiger Technologie in ihre schwierigste Phase ein. Die Produktentwicklung hat sich verzögert, die Geduld und das Vertrauen einiger Mitarbeiter sind erschöpft und die nächste Finanzierungsrunde des Unternehmens war voller Wendungen, sodass die Moral und das Vertrauen des Teams vor großen Herausforderungen stehen.

In Startup-Kreisen gibt es ein Sprichwort namens „18-Monats-Fluch“. Es besagt, dass sich die Mentalität des Startup-Teams ändert und es die Geduld verliert, wenn es anderthalb Jahre lang keine Hoffnung und kein positives Feedback gibt. Yuan Jinhui erkannte, dass er nicht länger warten konnte.OneFlow muss so schnell wie möglich in realen Szenarien eingesetzt werden, um allen zu zeigen, dass die Innovation von OneFlow tatsächlich wertvoll ist, und so positives Feedback zu erzeugen.

Im September 2018, nach 1 Jahr und 9 Monaten Forschung und Entwicklung,Yuan Jinhui und sein Team haben die Closed-Source-Version von OneFlow herausgebracht.Zu diesem Zeitpunkt war OneFlow noch nicht Open Source und es gab Probleme unterschiedlichen Ausmaßes, aber die offizielle Veröffentlichung des Produkts gab den Teammitgliedern endlich Ruhe.

Konzentrieren Sie sich auf groß angelegte Schulungen, und die Effizienz ist viel besser als bei ähnlichen Frameworks

Im November 2018 hatte First-Class Technology Glück. Google hat das leistungsstärkste natürliche Sprachmodell BERT eingeführt und damit eine neue Ära der NLP eingeläutet. Dies bestätigt Yuan Jinhuis Vorhersage.Neue Architekturen, die für die Bewältigung groß angelegter Schulungen geeignet sind, sind notwendig und unerlässlich.

bald,Erstklassige Technologieingenieure unterstützten das verteilte Training von BERT-Large basierend auf OneFlow.Dies war zu diesem Zeitpunkt auch das einzige Framework, das verteiltes BERT-Large-Training unterstützte, wobei die Leistung und Verarbeitungsgeschwindigkeit die vorhandenen Open-Source-Frameworks bei weitem übertraf.

OneFlow wurde über Nacht berühmt, was First-Class Technology auch die Gelegenheit bot, die erste Gruppe führender Internet-Unternehmensbenutzer zu gewinnen. Überraschenderweise,Damals wählte Yuan Jinhui einen äußerst zurückhaltenden Weg, da er „mit dem Produkt immer noch nicht zufrieden“ war.

Von der Veröffentlichung der Closed-Source-Version im September 2018 bis zur offiziellen Open-Source-Veröffentlichung im Juli 2020 verbrachte Yuan Jinhui weitere 22 Monate damit, OneFlow zu verfeinern.Er und sein Team optimierten das klassische Modell weiter und lösten dabei unerwartete Probleme.Yuan Jinhui ist der Ansicht, dass er OneFlow nicht so leicht auf den Tisch bringen wird, selbst wenn die Produktdokumentation nicht gut gemacht ist.

Am 31. Juli 2020 wurde OneFlow auf GitHub offiziell als Open Source veröffentlicht.Dieses Open-Source-Framework, das für das Trainieren groß angelegter Modelle bekannt ist, ist zum zweiten Mal ins Rampenlicht getreten und veranschaulicht perfekt das Sprichwort: Effizienz ist König.

Schnellere Trainingsgeschwindigkeit, höhere GPU-Auslastung, höheres Beschleunigungsverhältnis mehrerer Maschinen, niedrigere Betriebs- und Wartungskosten und einfachere Benutzererfahrung.Fünf leistungsstarke Vorteile ermöglichen es OneFlow, sich schnell an verschiedene Szenarien anzupassen und rasch zu expandieren. Yuan Jinhui und sein Team haben bei der Verfolgung und Optimierung der Leistung von OneFlow den Höhepunkt erreicht.

Vor Kurzem hat OneFlow die Version v0.2.0 veröffentlicht.Es wurden bis zu 17 neue Leistungsoptimierungen hinzugefügt.Dies verbessert die automatische Trainingsgeschwindigkeit mit gemischter Präzision von CNN und BERT erheblich.

Das Entwicklungsteam hat außerdem ein Open-Source-Projekt namens DLPerf ins Leben gerufen, das die experimentelle Umgebung, die experimentellen Daten und die reproduzierbaren Algorithmen vollständig als Open Source bereitstellt.Der Durchsatz und das Beschleunigungsverhältnis von OneFlow und mehreren anderen Mainstream-Frameworks auf den ResNet50-v1.5- und BERT-Basismodellen wurden in derselben physischen Umgebung (4 V100 16G x8-Maschinen) bewertet.

Die Ergebnisse zeigen, dass der Durchsatz von OneFlow sowohl auf einer einzelnen Maschine und einer einzelnen GPU als auch auf mehreren Maschinen und mehreren GPUs deutlich höher ist als bei anderen Frameworks. Damit ist es das schnellste Framework für das Training von ResNet50-v1.5- und BERT-basierten Modellen auf gängigen Flaggschiff-Grafikkarten (V100 16G).Die OneFlow ResNet50-v1.5 AMP-Einzelkarte ist 80% schneller als NVIDIAs stark optimiertes PyTorch und 35% schneller als TensorFlow 2.3.

Der konkrete Evaluierungsbericht kann unter folgendem Link abgerufen werden:

https://github.com/Oneflow-Inc/DLPerf

Zweifeln begegnen und eine „Minderheit“ auf der Strecke werden

Tatsächlich wurde OneFlow seit seiner Einführung ziemlich oft in Frage gestellt.„Spät einsteigen und wenig Wohnraum haben“, lautet die vorherrschende Meinung.Yuan Jinhui zeigte diesbezüglich eine außergewöhnliche Gelassenheit.

Seiner Meinung nach ist das Deep-Learning-Framework eine neue Sache und sowohl die Technologie als auch die Branche befinden sich in der Anfangs- bzw. Mittelphase, so dass es keine Frage eines frühen oder späten Einstiegs ist. Bevor die Technologie konvergiert,Produkte mit hoher Leistung, hoher Benutzerfreundlichkeit und benutzerfreundlichem Wert werden von den Benutzern bevorzugt.

Die Vorstellung, dass es weniger Wohnraum gäbe, ist völlig falsch.Open Source ermöglicht einen fairen Wettbewerb zwischen den Produkten kleiner und großer Unternehmen.Hervorragende neue Frameworks stellen autoritäre Frameworks in Frage, was eines der Kernelemente des Open-Source-Geistes ist.

Zweifel haben die Entwicklung von OneFlow nicht behindert. Im Gegenteil,Yuan Jinhui und sein Team beschleunigten das Upgrade und die Verbesserung von OneFlow, indem sie die Leistung aktualisierten und optimierten, die Entwicklerdokumentation sortierten und Community-Feedback sammelten …Diese Bemühungen und die Beharrlichkeit haben mehr Benutzer zu OneFlow geführt, darunter auch einige der anfänglichen „Skeptiker“.

Auf der COSCon‘20 China Open Source-Jahreskonferenz hielt Yuan Jinhui eine Präsentation mit dem Titel „Evolution von Deep Learning-Trainingssystemen“.Der nächste Entwicklungsplan von OneFlow wurde allen Entwicklern vorgestellt. Neben dem Beharren auf Effizienz an erster Stelle und der kontinuierlichen Leistungsoptimierung,Das Entwicklungsteam arbeitet außerdem hart daran, die Lern- und Migrationskosten der Benutzer zu senken.Derzeit sind die Kosten für die Migration von PyTorch-Benutzern zu OneFlow bereits recht gering, da die Benutzeroberflächen beider Systeme nahezu identisch sind und auch die Kosten für die Konvertierung trainierter Modelle zu OneFlow gering genug sind.

Objektiv betrachtet hinkt OneFlow in puncto Vollständigkeit und Benutzerfreundlichkeit immer noch hinter TensorFlow und PyTorch her. OneFlow zeichnet sich jedoch durch hohe Effizienz, gute Skalierbarkeit und verteilte Benutzerfreundlichkeit aus.Es eignet sich sehr gut für die Gesichtserkennung im großen Maßstab, für Werbeempfehlungssysteme im großen Maßstab und für Modelltrainingsszenarien mit riesigen Modellparametern wie GPT-3.

Am Ende des Interviews machte Herr Yuan Jinhui keinen Hehl aus seinem Talentwunsch. Er sagte, dass OneFlow Ingenieure für maschinelles Lernen und Deep Learning rekrutiert und sich über Menschen mit Fachwissen sehr freut, die sich diesem dynamischen und siegreichen Team anschließen möchten.

-- über--