Command Palette

Search for a command to run...

5 Milliarden Aufrufe, 17 Millionen Menschen Nahmen an Den "Transformation Comics" Teil, Das Douyin-Team Nahm Ein Interview Mit CSDN An

In den letzten Jahren erfreuten sich verschiedene Anwendungen zur Fotobearbeitung, Verschönerung und für Spezialeffekte großer Beliebtheit bei den Benutzern. Vor Kurzem waren Douyins neue Spezialeffekte zur „Verwandlung in Comics“ wieder ein heißes Thema. Welche Schlüsseltechnologien stecken hinter der explosionsartigen Popularität?

Herausgeber: NeuroXiaoxi

Der Inhalt wurde aus CSDN und ByteFan zusammengestellt (Link am Ende des Artikels).

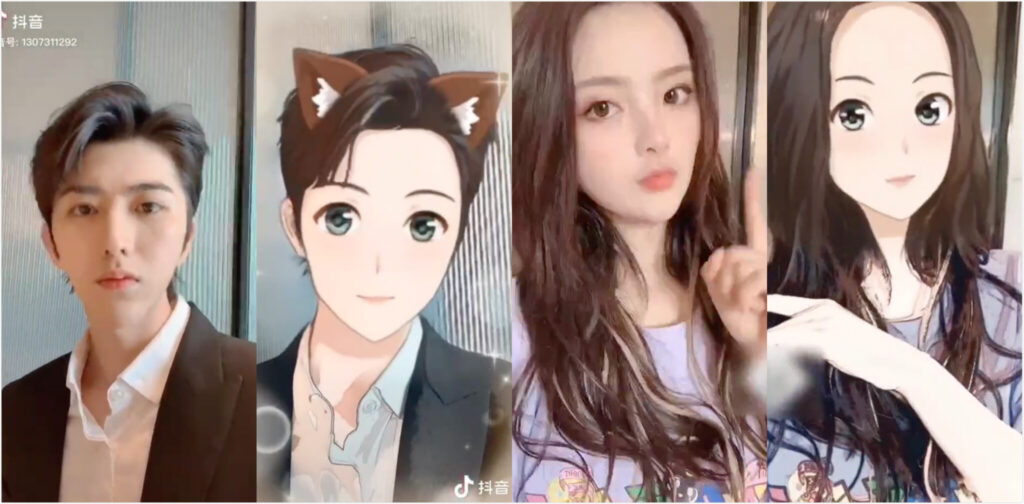

In letzter Zeit ist der Spezialeffekt „Verwandlung in Comics“ auf TikTok populär geworden und jeder, vom Passanten bis zum Prominenten, kann nicht anders, als ihn auszuprobieren.

In nur einer Sekunde können Sie sich selbst in der zweidimensionalen Welt sehen, mit großen, wässrigen Augen und heller Haut, voller Energie.

Bis jetzt haben mehr als 17,7 Millionen Benutzer auf Douyin Videos mit den Spezialeffekten „Transformation in Comics“ erstellt und diese Videoserie hat 5,67 Milliarden Aufrufe gesammelt.

Inspiration von vor einem Jahr: Mit GAN zum Durchbruch

Obwohl dieser Spezialeffekt einfach anzuwenden ist und die Transformation nur eine Sekunde dauert, ist der Erfolg tatsächlich das Ergebnis langfristiger Forschung und Entwicklung sowie der Verfeinerung durch das Douyin-Videoteam.

Im Jahr 2018 hat ByteDance ein spezielles Imaging-Team gegründet.Es unterstützt die Verfeinerung der gesamten Produktreihe, einschließlich Tik Tok, Volcano und Qingyan, einschließlich der langfristigen Erforschung des Gameplays im Stil realer Personen, und ist bestrebt, kontinuierlich Spezialeffekte zu erstellen, die die Benutzer beeindrucken.

Das Technologiemedium CSDN hat das entsprechende Team so schnell wie möglich interviewt und wir haben einen Teil davon zitiert:

Die Inspiration für das diesmal gestartete Projekt „Transformation Comics“ kam von einem Brainstorming-Meeting vor etwa einem Jahr.

Ich habe während einer Brainstorming-Sitzung gelernt,Dabei kam die Idee auf, „einen realen Menschen in Sekundenschnelle in ein Cartoon-Gesicht zu verwandeln“.Die Idee begeisterte das Team.

Tu, was du sagst. Im September 2019 holte das Douyin-Videoteam schnell Kollegen aus Forschung und Entwicklung, Design und anderen Bereichen zur gemeinsamen Unterstützung hinzu.

Die Haupttechnologie, die bei den von TikTok dieses Mal eingeführten Comic-Transformations-Spezialeffekten verwendet wird, ist immer noch GAN, aber es gibt auch einige Unterschiede im Vergleich zur Vergangenheit.Das Team hat neue Versuche auf GAN-Basis hinzugefügt.

Tatsächlich verglich Douyins Echtzeit-Comic-Spezialeffekte vor der endgültigen Technologieauswahl eine große Anzahl von Technologiemethoden der aktuellen Generation, darunter Methoden zum Erstellen von Comics wie Ugatit und Methoden für andere Aufgaben wie MUNIT.

Die Forschung ergab jedoch, dassEs gibt einige Probleme mit den aktuellen GANs, die für Aufgaben wie Comic-Generierung und Stilübertragung verwendet werden.

Erstens ist das Training instabil. Zweitens kann selbst eine kleine Anpassung der Hyperparameter erhebliche Auswirkungen auf die Ergebnisse haben. Darüber hinaus kann es leicht zu einem Problem des Verschwindens von Gradienten kommen.

In diesem ZusammenhangDouyins Verbesserungsplan besteht darin, mehrere Verluste auszuprobieren, darunter WGAN, LSGAN usw.Da es bislang jedoch noch kein Patentrezept gibt, ist es notwendig, die Veränderungen der Gradienten während des Experiments zu überwachen.

Das technische Team von Douyin sagte außerdem, dass es bei der Erforschung der Comic-Videotechnologie bei den ersten Versuchen auf viele Rückschläge gestoßen sei. Bei den ersten Voruntersuchungen unterschied sich die Ausgabeversion erheblich von der Bildversion und die Leistung entsprach nicht den Standards.

Nach mehreren unbefriedigenden Versuchen begannen im Team Zweifel an der Machbarkeit von Echtzeit-Comics zu kommen.

Doch glücklicherweise hat nach mehreren Fehlversuchen jemand in seiner Zusammenfassung der Erfahrung auf den Schlüssel hingewiesen:Die bisherigen Modelle hatten eine einheitliche Struktur und die Vor- und Nachteile der verschiedenen Modelle waren nicht völlig konsistent.

Dann,Das technische Team probierte die Methode des Modellgrafting aus, bei der verschiedene Module zum Zusammenfügen neuer Modelle verwendet wurden, was die Qualität der Comic-Generierung erheblich verbesserte.

Nachdem die Qualitätsstandards erfüllt waren, wurde das Modell durch Berechnung der Wichtigkeit jeder Schicht getrimmt und schließlich die Struktur des Echtzeitmodells festgelegt.

Das Performance-Produktteam beteiligt sich auch an der Leistungsoptimierung des Modells, fasst die quantitative Beziehung zwischen Parametern und Effekten zusammen und optimiert das Modell durch Feinabstimmung der Parameter. Schließlich war dieses Hitprodukt geboren.

Bei der Echtzeittransformation in Comics gibt es viele Schwierigkeiten. Wie kann man sie überwinden?

Einer der attraktivsten Aspekte von „Transformation Comics“ ist die Transformation in Echtzeit.

Worin besteht also im Vergleich zur statischen Bildverarbeitung die Schwierigkeit, eine Echtzeit-Comic-Verarbeitung zu erreichen, insbesondere auf Mobiltelefonen?

Das technische Team von Douyin sagte, dass die Echtzeitverarbeitung von Videocomics immer noch ziemlich schwierig sei, zum Beispiel:

- Erstens muss die Rechenkomplexität des Modells selbst sehr gering sein. Um einen guten komischen Effekt mit begrenztem Rechenaufwand zu erzielen, ist es notwendig, den Wert jeder Operation voll auszunutzen.

- Zweitens verfügt Douyin über eine große Anzahl von Benutzern und die Leistung der von den Benutzern verwendeten Modelle variiert stark, sodass speziell komplexe und maßgeschneiderte Strategien zur Modellbereitstellung entwickelt werden müssen.

Um den Anforderungen der Benutzer auf verschiedenen Ebenen gerecht zu werden, hat Douyin eine komplexe Modellverteilungsstrategie entwickelt und eine maßgeschneiderte Modellverteilung realisiert, die letztendlich den erfolgreichen Start von Echtzeit-Comics sicherstellte und die Anforderungen von Echtzeit-Comics hinsichtlich Wirkung und Leistung erfüllte.

Auch,Die Spezialeffekte der Tik Tok-Comics verwenden ByteNN, die selbst entwickelte Inferenz-Engine von ByteDance.Diese Inferenz-Engine, die für die schnelle Implementierung von Edge-Side-Algorithmen konzipiert ist, unterstützt nicht nur die allgemeinen Rechenkapazitäten von CPU und GPU, sondern nutzt auch die Beschleunigungsfunktionen der NPU/DSP-Hardware des Herstellers voll aus und stellt so sicher, dass Echtzeit-Comics die riesige Benutzerbasis von TikTok stabil unterstützen können.

Natürlich bietet der aktuelle Algorithmus für diese Echtzeit-Comic-Effekte für einige spezielle Szenarien noch Optimierungspotenzial. In nachfolgenden Iterationen werden wir sowohl vom Modell selbst als auch von der Inferenz-Engine ausgehen, um den Modelleffekt zu verbessern und gleichzeitig die Inferenzleistung zu optimieren.

ByteDance Imaging Team: Comic-Filter müssen sowohl realistisch als auch schön sein

In den letzten Jahren sind nach und nach Spezialeffekte wie Comic- und handgemalte Stile aufgetaucht.Das schwierige Problem, vor dem das Team steht, besteht darin, aus der Masse hervorzustechen und ein Hit zu werden.

Laut Da Peng vom Imaging-Team von ByteDance ist das Wichtigste:Ziel ist es, bei den Nutzern für Überraschung und Resonanz zu sorgen.

Einerseits das Spezialeffekt-Team von "Transformation Comics"Es erreicht sowohl „Ähnlichkeit“ als auch „Schönheit“.Auf der anderen Seite, durch kontinuierliche Verbesserung der Technologie,Es werden Echtzeit-Transformationseffekte von Tausenden von Gesichtern für Tausende von Menschen erzielt.

Yu Chen vom Projektteam sagte: „Wir haben zwei Hauptmerkmale definiert: ‚exquisite Schönheit‘ und ‚extreme Ähnlichkeit‘. Wir müssen die Eigenschaften des Benutzers vollständig beibehalten und das Bild wie die reale Person aussehen lassen, während wir gleichzeitig die einzigartige künstlerische Schönheit von Comics erzeugen.“

Darüber hinaus kombinierte das Team die Stärken der Bilder japanischer, chinesischer und koreanischer Comics, um die endgültige Version der Comics zu entwerfen, und ihre Ästhetik fand breite Anerkennung.

In Bezug auf das Gameplay hat das Team schließlich 6 kreative Requisiten ausgewählt, wie etwa gleitende Hände, Nicken und andere Transformationsmethoden, um das interaktive Erlebnis zu verbessern und die Bedürfnisse von Benutzern unterschiedlichen Alters, Niveaus und mit unterschiedlichen Vorlieben zu berücksichtigen.

GAN: Eine wichtige Wunderwaffe im Bereich der Bilderzeugung

Lassen Sie uns über die Basistechnologie dieses Erfolgsprodukts sprechen – GAN (Generative Adversarial Networks).

In den letzten Jahren lief die Forschung auf Basis von GAN auf Hochtouren. Bei der Untersuchung von Ergebnissen zur Bilderzeugung und -konvertierung kommt fast immer die GAN-Technologie zum Einsatz.

Im Jahr 2014 veröffentlichten Ian Goodfellow und sein Team ein Papier mit dem Titel „Generative Adversarial Networks“, in dem sie ein Deep-Learning-Modell namens GAN entwickelten.

Die Hauptstruktur des GAN-Modells umfasst den Generator G (Generator) und den Diskriminator D (Diskriminator).Das Training dieses Modells erfolgt im Zustand eines konfrontativen Spiels.

Unter Verwendung der Idee des konfrontativen Spiels besteht das Ziel des Generators G während des Trainingsprozesses darin, möglichst realistische Bilder zu erzeugen, um den Diskriminator D zu täuschen. Das Ziel von D besteht darin, zu versuchen, die von G erzeugten Bilder von den realen Bildern zu unterscheiden. Auf diese Weise stellen G und D einen dynamischen „Spielprozess“ dar.

Was ist das Endergebnis des Spiels? Das heißt, unter idealen Bedingungen kann G Bilder erzeugen, die „real“ genug sind, um für real gehalten zu werden.

Einfach ausgedrückt ist G wie ein Fälscher eines Kunstwerks, der alles Mögliche versucht, den Diskriminator D zu täuschen und am Ende ein Werk erhält, bei dem sich das Original nur schwer von der Fälschung unterscheiden lässt.

Man kann sagen, dass die Anwendung von GAN in den letzten Jahren sehr umfangreich war. Wird beispielsweise zum Generieren von Anime-Charakteren verwendet:

Bildkonvertierung mit CycleGAN:

StyleGAN, 2018 von NVIDIA vorgeschlagen, generiert gefälschte Porträts:

Quellen:

https://mp.weixin.qq.com/s/lLfp8F6G2uHxYpCMCF1Tmw

https://mp.weixin.qq.com/s/WeZD__I7Y98Fg18pEZ9L9g

-- über--