Command Palette

Search for a command to run...

M2RAG-Benchmark-Datensatz Zur Multimodalen Bewertung

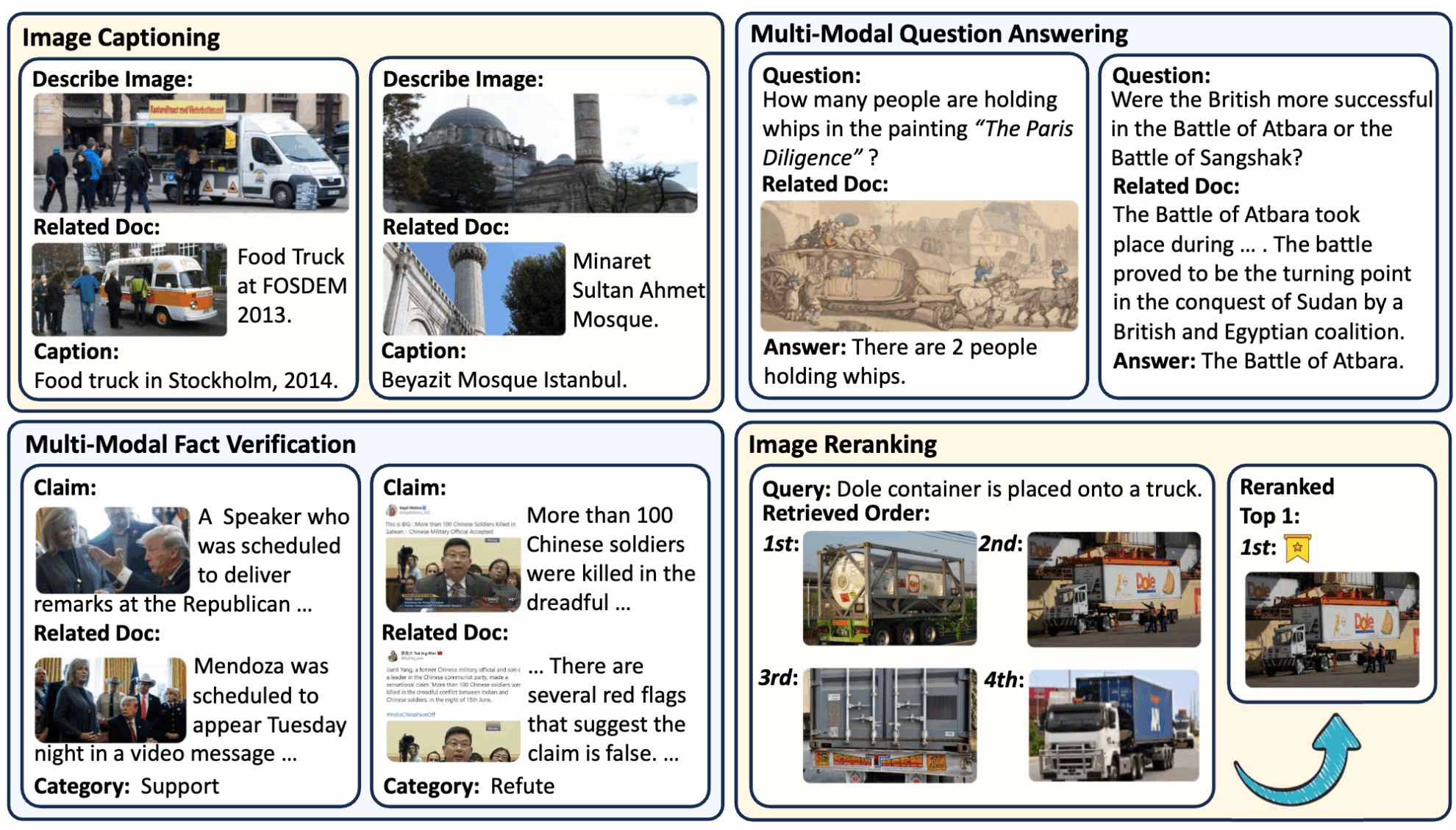

M2RAG ist ein multimodaler Datensatz zur Bewertung der Fähigkeiten multimodaler Large Language Models (MLLMs) in multimodalen Abrufszenarien. Ziel ist es, die Fähigkeit von MLLMs zu bewerten, multimodales Dokumentwissen bei Aufgaben wie Bildbeschreibung, multimodaler Fragebeantwortung, Faktenüberprüfung und Neubewertung von Bildern zu nutzen. Die relevanten Papierergebnisse sindBenchmarking der Retrieval-Augmented Generation in multimodalen Kontexten".

Dieser Datensatz kombiniert Bild- und Textdaten, um Aufgaben zur Informationsbeschaffung und -generierung in realen Szenarien zu simulieren, beispielsweise bei der Analyse von Nachrichtenereignissen und der visuellen Beantwortung von Fragen. Der Schwerpunkt liegt auf der Bewertung der Fähigkeit von MLLMs, abgerufenes Dokumentwissen in multimodalen Kontexten zu verwenden, einschließlich des Verständnisses von Bildinhalten, der Schlussfolgerung von Bild-Text-Assoziationen und der Beurteilung von Fakten.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.