Command Palette

Search for a command to run...

MINT-1T Text-Bild-Paar Multimodaler Datensatz

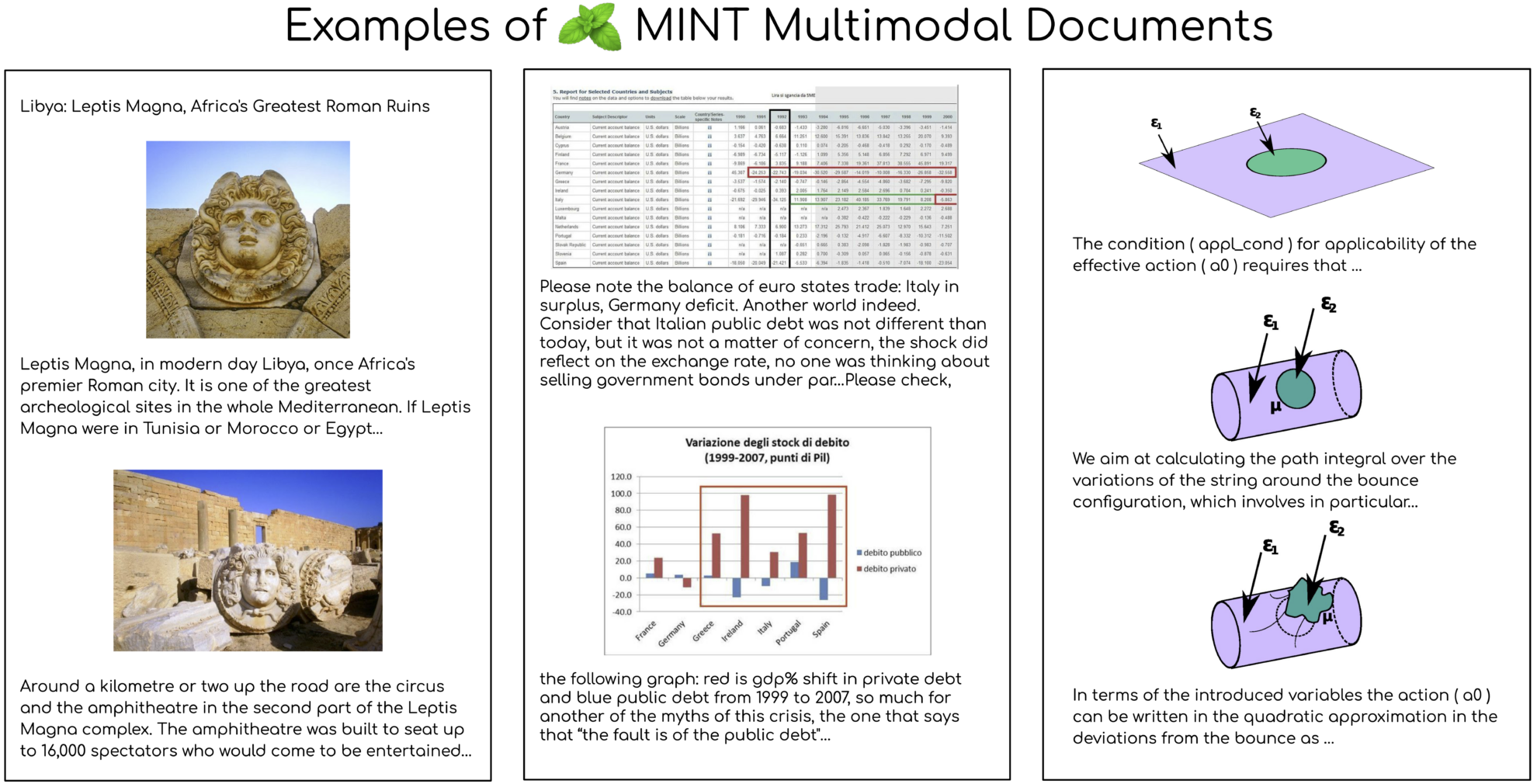

Der MINT-1T-Datensatz ist ein multimodaler Datensatz, der 2024 gemeinsam von Salesforce AI und mehreren Institutionen als Open Source bereitgestellt wurde. Sein Umfang wurde erheblich erweitert und umfasst nun eine Billion Text-Tags und 3,4 Milliarden Bilder. Damit ist er zehnmal so groß wie der bisher größte Open-Source-Datensatz. Die relevanten Papierergebnisse sind "MINT-1T: Skalierung multimodaler Open-Source-Daten um das Zehnfache: Ein multimodaler Datensatz mit einer Billion TokenDer Aufbau dieses Datensatzes folgt den Grundprinzipien von Umfang und Vielfalt. Er umfasst nicht nur HTML-Dokumente, sondern auch PDF-Dokumente und ArXiv-Artikel. Diese Vielfalt verbessert die Abdeckung wissenschaftlicher Dokumente erheblich. Die Datenquellen von MINT-1T sind vielfältig und umfassen unter anderem Webseiten, wissenschaftliche Artikel und Dokumente, die bisher in multimodalen Datensätzen nicht vollständig genutzt wurden.

In Bezug auf Modellexperimente schneidet das auf MINT-1T vortrainierte multimodale Modell XGen-MM bei den Benchmarks zur Bildbeschreibung und visuellen Fragebeantwortung gut ab und übertrifft den bisherigen führenden Datensatz OBELICS. Durch Analysen hat MINT-1T erhebliche Verbesserungen hinsichtlich Umfang, Datenquellenvielfalt und Qualität erzielt, insbesondere bei PDF- und ArXiv-Dokumenten, die eine deutlich größere Durchschnittslänge und eine höhere Bilddichte aufweisen. Darüber hinaus zeigen die Ergebnisse der Themenmodellierung von Dokumenten durch das LDA-Modell, dass die HTML-Teilmenge von MINT-1T eine breitere Domänenabdeckung aufweist, während sich die PDF-Teilmenge hauptsächlich auf die Bereiche Wissenschaft und Technologie konzentriert.

MINT-1T zeigt dank der Beliebtheit dieser Bereiche in ArXiv- und PDF-Dokumenten eine hervorragende Leistung bei zahlreichen Aufgaben, insbesondere in den Bereichen Wissenschaft und Technologie. Die kontextbezogene Lernleistung der Modelle wird anhand unterschiedlicher Beispielzahlen bewertet. Die auf MINT-1T trainierten Modelle übertreffen das Basismodell OBELICS bei allen Beispielzahlen. Die Veröffentlichung von MINT-1T stellt Forschern und Entwicklern nicht nur einen großen multimodalen Datensatz zur Verfügung, sondern bietet auch neue Herausforderungen und Möglichkeiten für das Training und die Evaluierung multimodaler Modelle.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.