Command Palette

Search for a command to run...

MMEvalPro Multimodaler Benchmark-Evaluierungsdatensatz

Datum

Größe

Veröffentlichungs-URL

Paper-URL

Tags

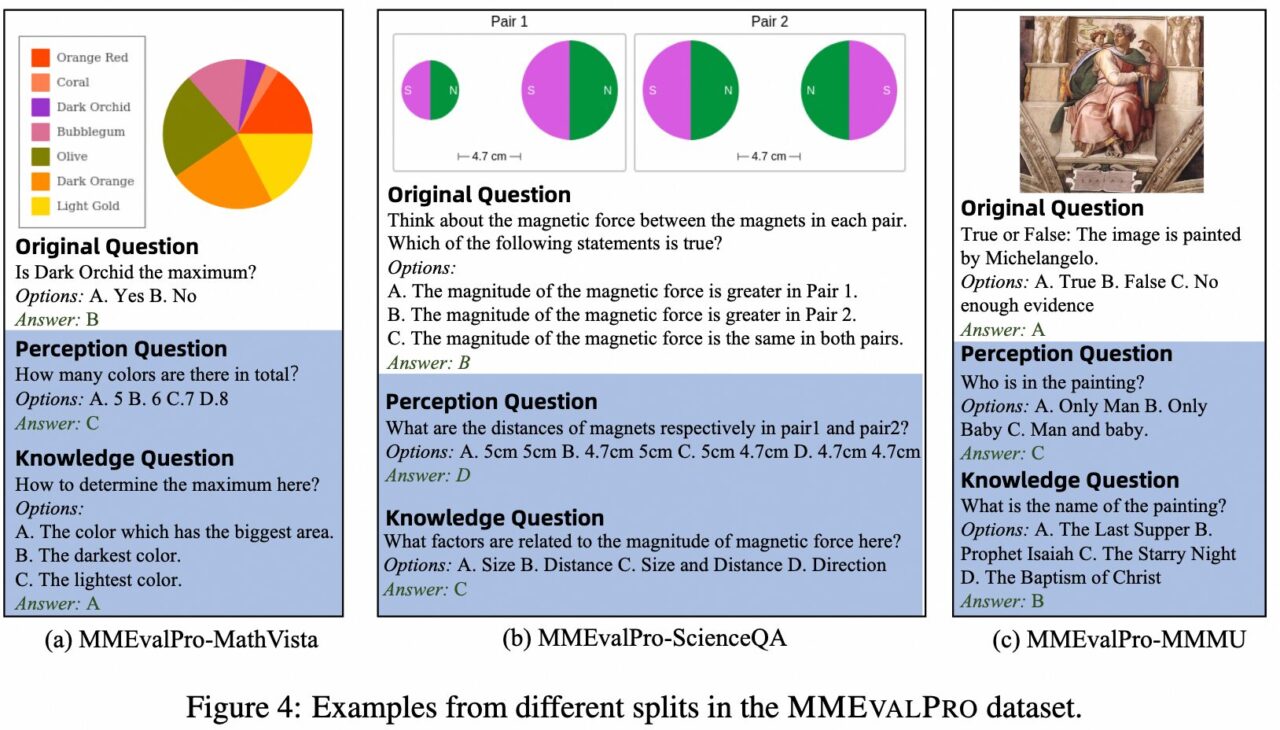

MMEvalPro ist ein Bewertungsbenchmark für multimodale Großmodelle (LMMs), der 2024 von einem Forschungsteam der Peking-Universität, der Chinesischen Akademie der Medizinischen Wissenschaften, der Chinesischen Universität Hongkong und Alibaba vorgeschlagen wurde. Ziel ist es, eine zuverlässigere und effizientere Bewertungsmethode bereitzustellen und die Probleme bestehender multimodaler Bewertungsbenchmarks zu lösen. Vorhandene Benchmarks weisen bei der Bewertung von LMMs systematische Verzerrungen auf, und selbst große Sprachmodelle (LLMs) ohne visuelle Wahrnehmung können bei diesen Benchmarks eine nicht triviale Leistung erzielen, was die Glaubwürdigkeit dieser Bewertungen untergräbt. MMEvalPro verbessert bestehende Bewertungsmethoden durch das Hinzufügen von zwei „Ankerfragen“ (einer Wahrnehmungsfrage und einer Wissensfrage) und bildet so ein „Fragentripel“, das verschiedene Aspekte des multimodalen Verständnisses eines Modells testet.

Das wichtigste Bewertungsmaß von MEvalPro ist die „echte Genauigkeit“. Dabei muss das Modell alle Fragen in einem Triplett richtig beantworten, um eine Punktzahl zu erhalten. Der Prozess umfasst mehrere Überprüfungs- und Qualitätsprüfungsphasen, um sicherzustellen, dass die Fragen klar, relevant und anspruchsvoll sind. Der endgültige Benchmark enthält 2.138 Fragentripel, also insgesamt 6.414 verschiedene Fragen zu unterschiedlichen Themen und Schwierigkeitsgraden.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.