Command Palette

Search for a command to run...

Multimodaler, Selbstanweisender, Multimodaler Benchmark-Datensatz

Datum

Größe

Veröffentlichungs-URL

Paper-URL

Lizenz

CC BY-SA 4.0

Tags

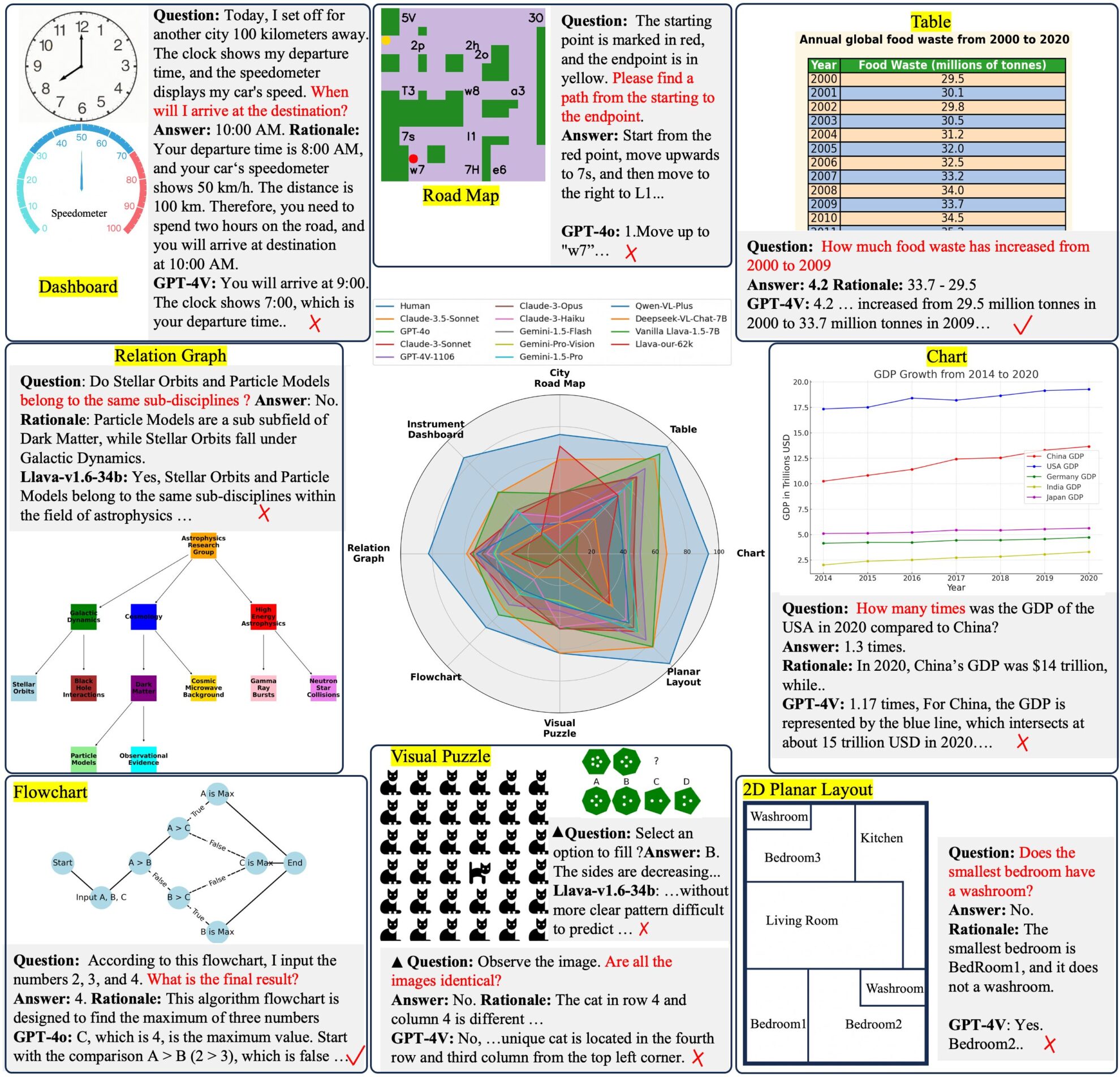

Dieser Datensatz wurde 2024 gemeinsam von der Zhejiang-Universität, dem Institut für Software der Chinesischen Akademie der Wissenschaften, der ShanghaiTech University und anderen Institutionen veröffentlicht. Die entsprechenden Ergebnisse des Papiers lauten:Multimodaler Selbstunterricht: Unterricht zu synthetischen abstrakten Bildern und visuellem Denken unter Verwendung eines Sprachmodells".

Der Datensatz enthält insgesamt 11.193 abstrakte Bilder mit relevanten Fragen und deckt 8 Hauptkategorien ab, darunter Dashboards, Roadmaps, Diagramme, Tabellen, Flussdiagramme, Beziehungsdiagramme, visuelle Rätsel und 2D-Grundrisse, sowie weitere 62.476 Daten zur Feinabstimmung des Modells.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.