Command Palette

Search for a command to run...

MMVP-Datensatz Zur Multimodalen Bewegungserfassung

Datum

Größe

Veröffentlichungs-URL

MMVP (Multimodal MoCap Dataset with Vision and Pressure Sensors) ist ein multimodaler Motion-Capture-Datensatz, der Bild- und Drucksensoren kombiniert und gemeinsam von der Beihang-Universität, der Tsinghua-Universität und der Nanjing-Universität entwickelt wurde.

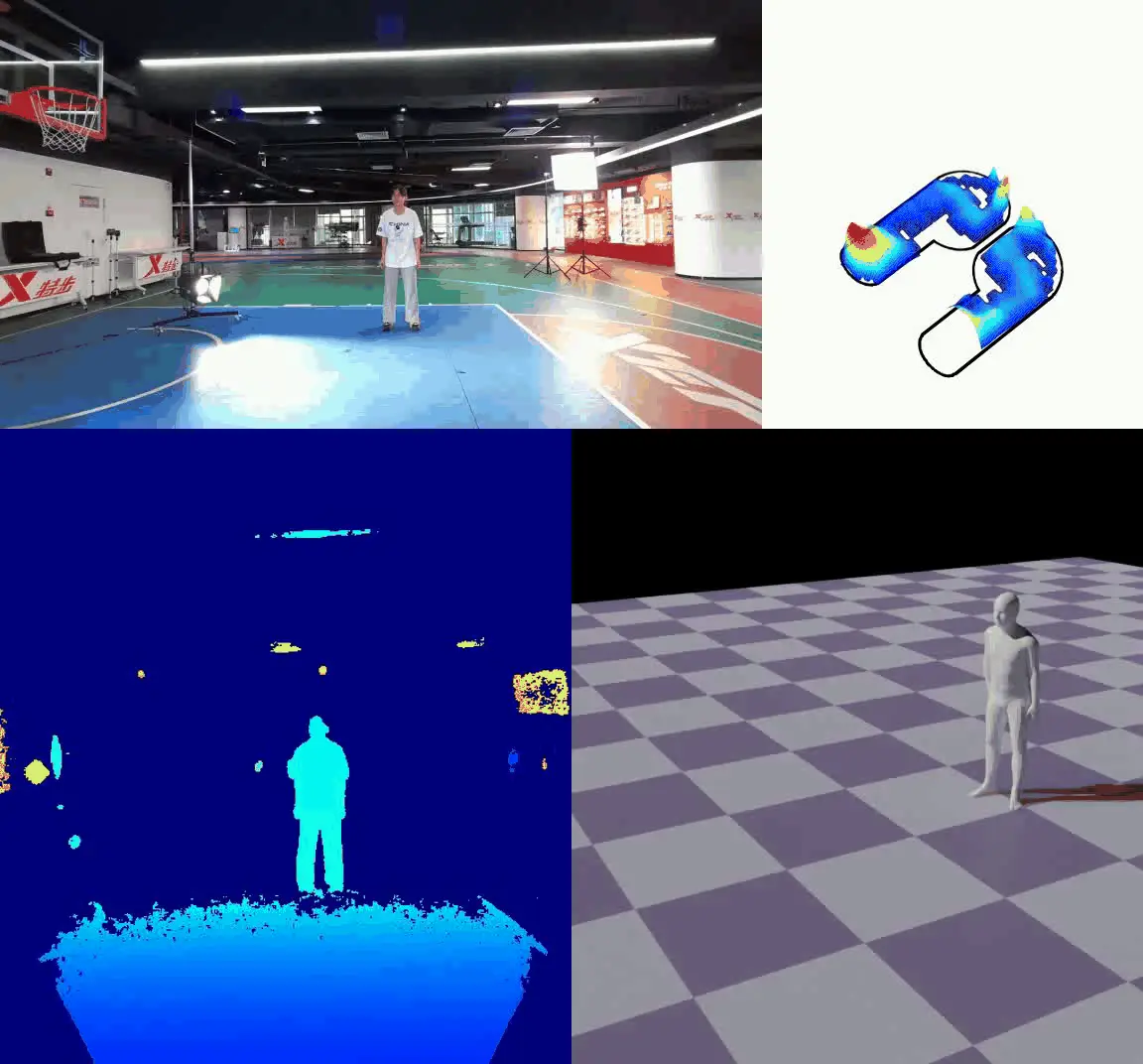

Der Datensatz enthält eine große Bandbreite schneller menschlicher Bewegungen wie Laufen, Seilspringen, Standweitsprung usw. Insgesamt wurden mehr als 44.000 Frames synchronisierter RGBD-Frames und Druckdaten von 16 Probanden gesammelt. Die Forscher verwendeten die Azure Kinect-Kamera, um RGBD-Videos mit einer Frequenz von 30 Bildern pro Sekunde aufzuzeichnen, und nutzten Xsensor-Druckeinlagen, um Daten zum Fußsohlendruck mit einer Rate von bis zu 150 Bildern pro Sekunde zu erfassen. Durch die manuelle Synchronisierung der beiden Datenströme und deren Kombination mit Deep-Learning-Algorithmen wie FPP-Net und CLIFF erreichten sie eine detaillierte Verarbeitung und Analyse der Daten. Dieser Datensatz stellt eine neue Datenquelle für die Forschung zur Erfassung menschlicher Bewegungen auf der Grundlage von Sicht- und Drucksensoren dar und kann den Fortschritt auf diesem Gebiet fördern.

beschreiben: Der MMVP-Benchmark (Multimodal Visual Patterns) konzentriert sich auf die Identifizierung von „CLIP-blinden Paaren“ – Bilder, die CLIP trotz offensichtlicher visueller Unterschiede als ähnlich betrachtet. MMVP vergleicht die Leistung modernster Systeme, einschließlich GPT-4V, anhand von neun grundlegenden visuellen Modalitäten. Es verdeutlicht die Herausforderungen, denen sich diese Systeme bei der Beantwortung einfacher Fragen gegenübersehen, was häufig zu fehlerhaften Antworten und halluzinogenen Interpretationen führt.

- Inhaltstyp: Bilder (CLIP-blinde Paare)

- Menge: 300 Bilder

- Datenquelle: Abgeleitet von ImageNet-1k und LAION-Aesthetics

- Methoden der Datenerhebung: Identifizierung von CLIP-Blindpaaren durch vergleichende Analyse

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.