Command Palette

Search for a command to run...

vLLM+Open WebUI 部署 Phi-4-mini-flash-reasoning

一、教程简介

Phi-4-mini-flash-reasoning 是由 Microsoft 团队发布的轻量级开源模型,基于合成数据构建,专注于高质量、密集推理数据,并进一步微调以获得更高级的数学推理能力。该模型属于 Phi-4 模型系列,支持 64K token 上下文长度,采用解码器-混合-解码器架构,结合注意力机制和状态空间模型(SSM),在推理效率方面表现出色。相关论文成果为 Decoder-Hybrid-Decoder Architecture for Efficient Reasoning with Long Generation 。

本教程采用资源为单卡 RTX 4090 。项目提示词支持中英文。

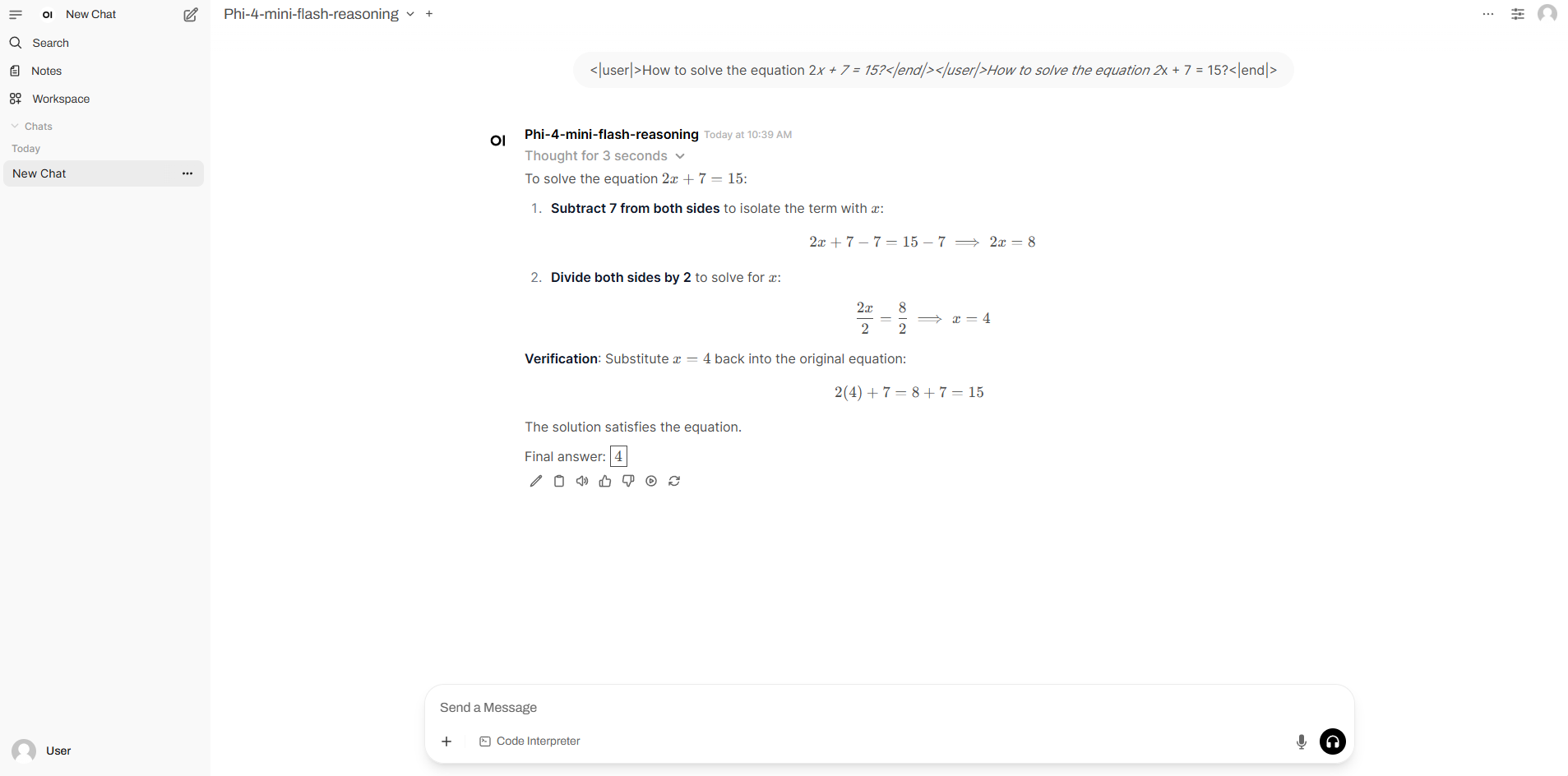

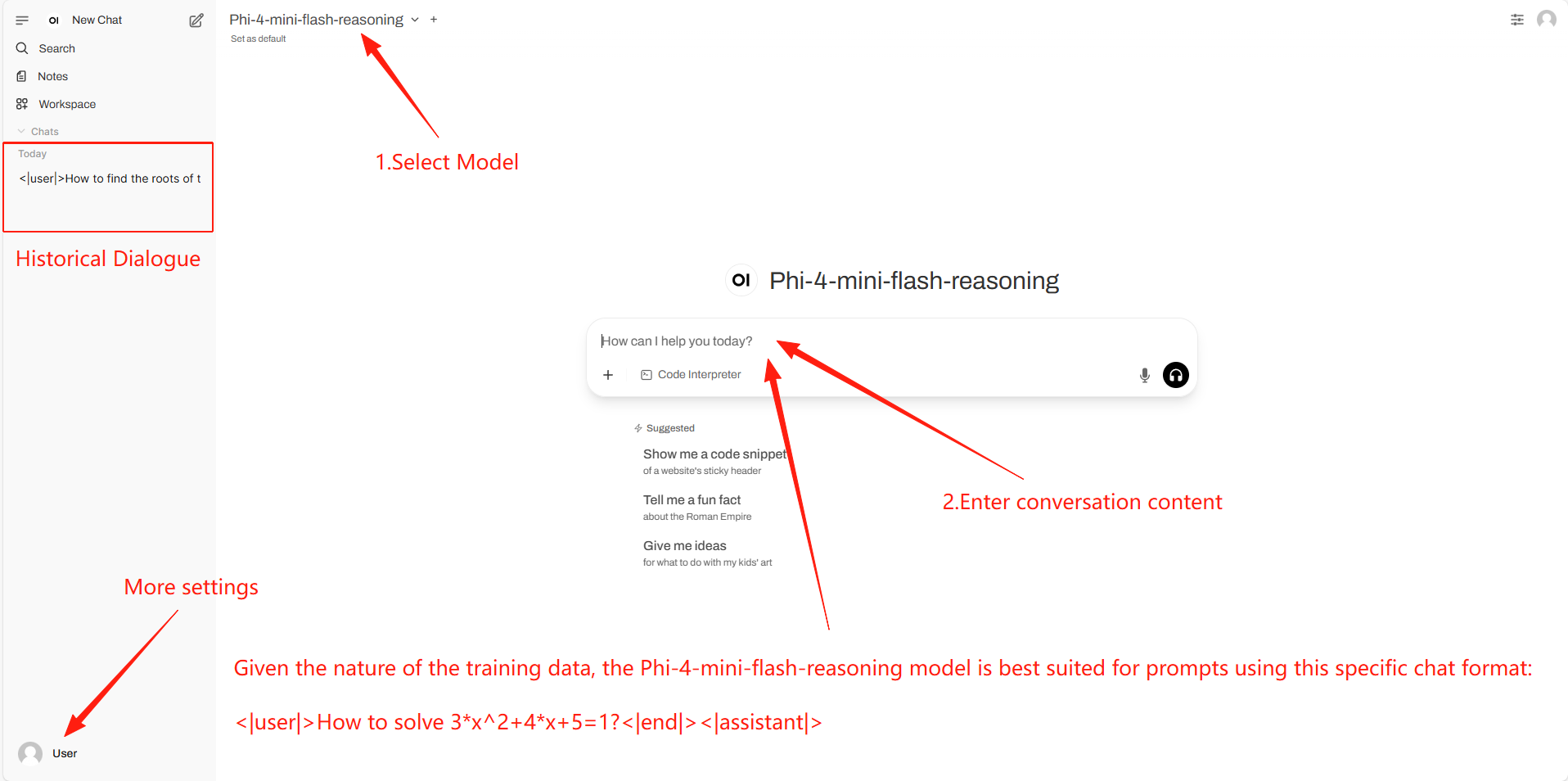

二、项目示例

三、运行步骤

1. 启动容器后点击 API 地址即可进入 Web 界面

2. 使用步骤

若未显示「模型」,这表示模型正在初始化,由于模型较大,请等待约 1-3 分钟后刷新页面。

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

引用信息

本项目引用信息如下:

@software{archscale2025, title={ArchScale: Simple and Scalable Pretraining for Neural Architecture Research}, author={Liliang Ren and Zichong Li and Yelong Shen}, year={2025}, url={https://github.com/microsoft/ArchScale} }@article{ren2025decoder,

title={Decoder-Hybrid-Decoder Architecture for Efficient Reasoning with Long Generation},

author={Liliang Ren and Congcong Chen and Haoran Xu and Young Jin Kim and Adam Atkinson and Zheng Zhan and Jiankai Sun and Baolin Peng and Liyuan Liu and Shuohang Wang and Hao Cheng and Jianfeng Gao and Weizhu Chen and Yelong Shen},

journal={arXiv preprint arXiv:2507.06607},

year={2025}

}