Command Palette

Search for a command to run...

Self Forcing 实时视频生成

一、教程简介

Self Forcing 是由 Xun Huang 团队于 2025 年 6 月 9 日提出,是一种用于自回归视频扩散模型的全新训练范式。它解决了长期存在的曝光偏差问题,即基于真实上下文训练的模型必须在推理过程中生成基于自身不完美输出的序列。与之前基于真实上下文帧对未来帧进行去噪的方法不同,Self Forcing 通过在训练期间执行带有键值(KV)缓存的自回归 rollout,将每帧的生成条件设定为先前自生成的输出。该策略通过视频级别的整体损失函数实现监督,该损失函数直接评估整个生成序列的质量,而非仅仅依赖于传统的逐帧目标函数。为了确保训练效率,采用了少步扩散模型和随机梯度截断策略,从而有效地平衡了计算成本和性能。进一步引入了一种滚动键值缓存机制,以实现高效的自回归视频外推。大量实验表明,他们的方法能够在单个 GPU 上实现亚秒级延迟的实时流视频生成,同时达到甚至超越速度明显较慢且非因果扩散模型的生成质量。相关论文成果为 Self Forcing: Bridging the Train-Test Gap in Autoregressive Video Diffusion 。

本教程采用资源为单卡 RTX 4090 。

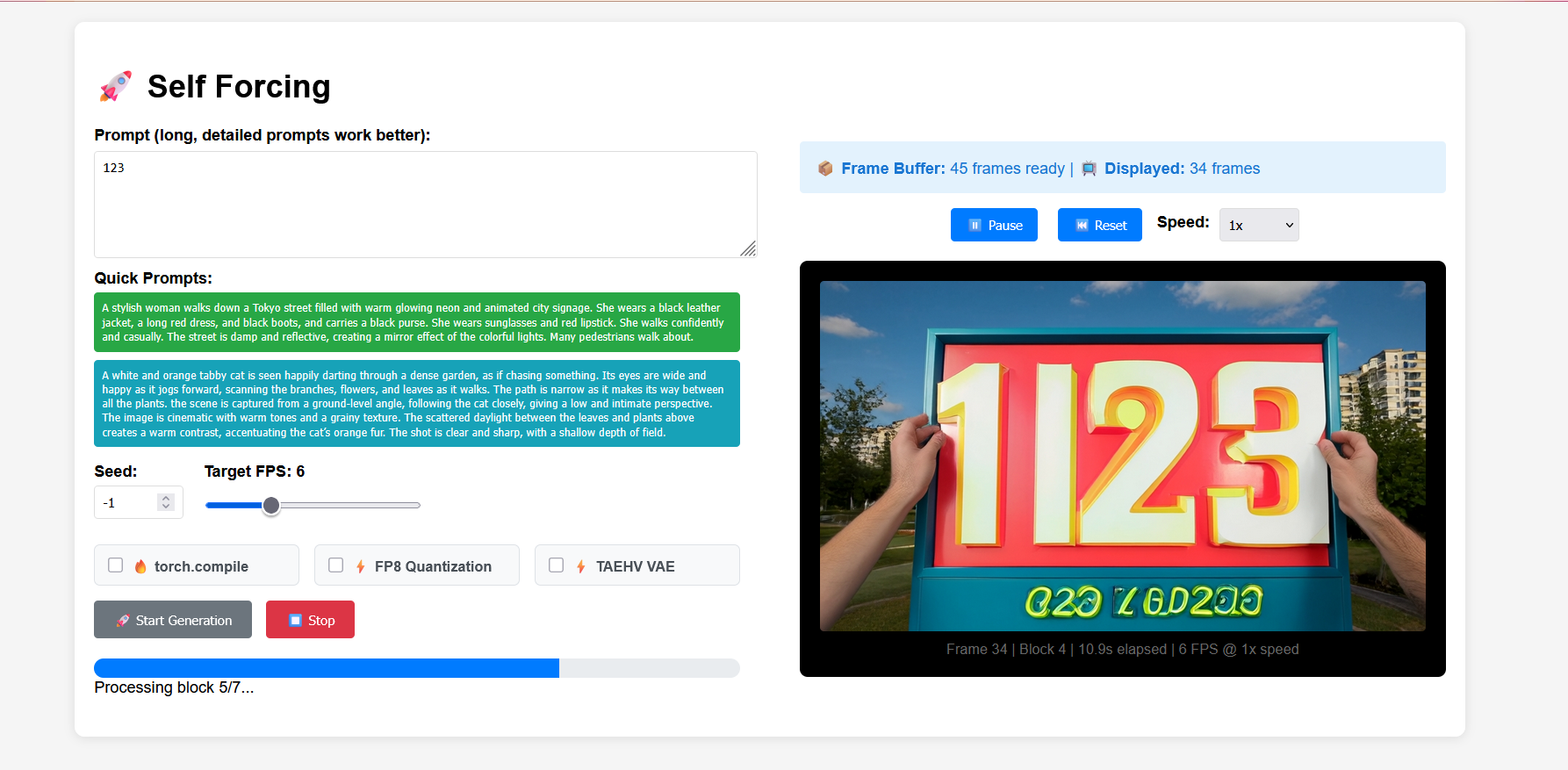

二、项目示例

三、运行步骤

1. 启动容器后点击 API 地址即可进入 Web 界面

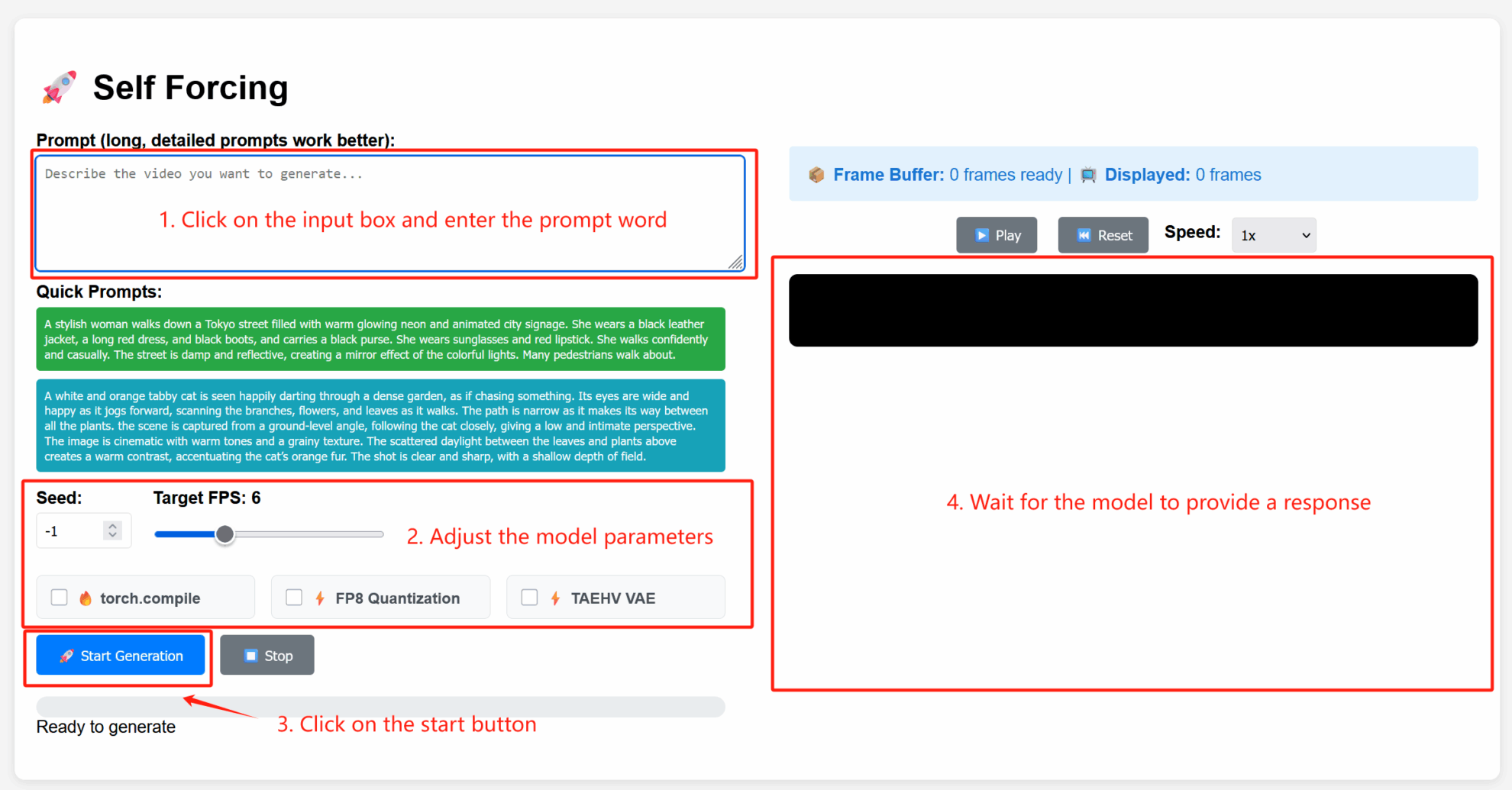

2. 使用步骤

参数说明

- Advanced Settings:

- Seed:随机种子值,控制生成过程的随机性。固定种子可复现相同结果;-1 表示随机种子。

- Target FPS:目标帧率,此处默认为 6,表示生成视频每秒 6 帧。

- torch.compile:启用 PyTorch 编译优化,加速模型推理(需环境支持)。

- FP8 Quantization:启用 8 位浮点量化,降低计算精度以提升生成速度(可能轻微影响质量)。

- TAEHV VAE:指定使用的变分自编码器(VAE)模型类型,可能影响生成细节或风格。

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

引用信息

本项目引用信息如下:

@article{huang2025selfforcing,

title={Self Forcing: Bridging the Train-Test Gap in Autoregressive Video Diffusion},

author={Huang, Xun and Li, Zhengqi and He, Guande and Zhou, Mingyuan and Shechtman, Eli},

journal={arXiv preprint arXiv:2506.08009},

year={2025}

}