Command Palette

Search for a command to run...

LFM2-1.2B:高效边缘部署的文本生成模型

一、教程简介

LFM2-1.2B 是由 Liquid AI 于 2025 年 7 月 10 日推出的第二代液体基础模型(LFMs),是一款基于混合架构的生成式 AI 模型。它以提供行业内最快的设备端生成式 AI 体验为目标,专为低延迟设备端语言模型工作负载设计。

作为采用新型混合架构的模型,LFM2-1.2B 创新性地结合了乘法门控和短卷积,包含 16 个块(10 个双门控短程 LIV 卷积块和 6 个分组查询注意力块),解决了传统模型在处理效率和性能上的不足。其训练基于 10 万亿 tokens 的预训练语料,采用知识蒸馏、大规模监督微调(SFT)和自定义直接偏好优化(DPO)等多阶段训练策略,在知识、数学、指令遵循和多语言能力等多个基准类别上,性能优于同规模模型,甚至能与更大参数规模的模型相竞争。同时,它在 CPU 上的解码和预填充速度比 Qwen 3 快 2 倍,训练效率较上一代 LFM 提升 3 倍,且能高效运行于 CPU 、 GPU 和 NPU 硬件,为边缘设备部署提供了灵活高效的解决方案。

本教程使用 LFM2-1.2B 作为演示,算力资源采用 RTX 4090 。支持的语言:英语、阿拉伯语、中文、法语、德语、日语、韩语和西班牙语。

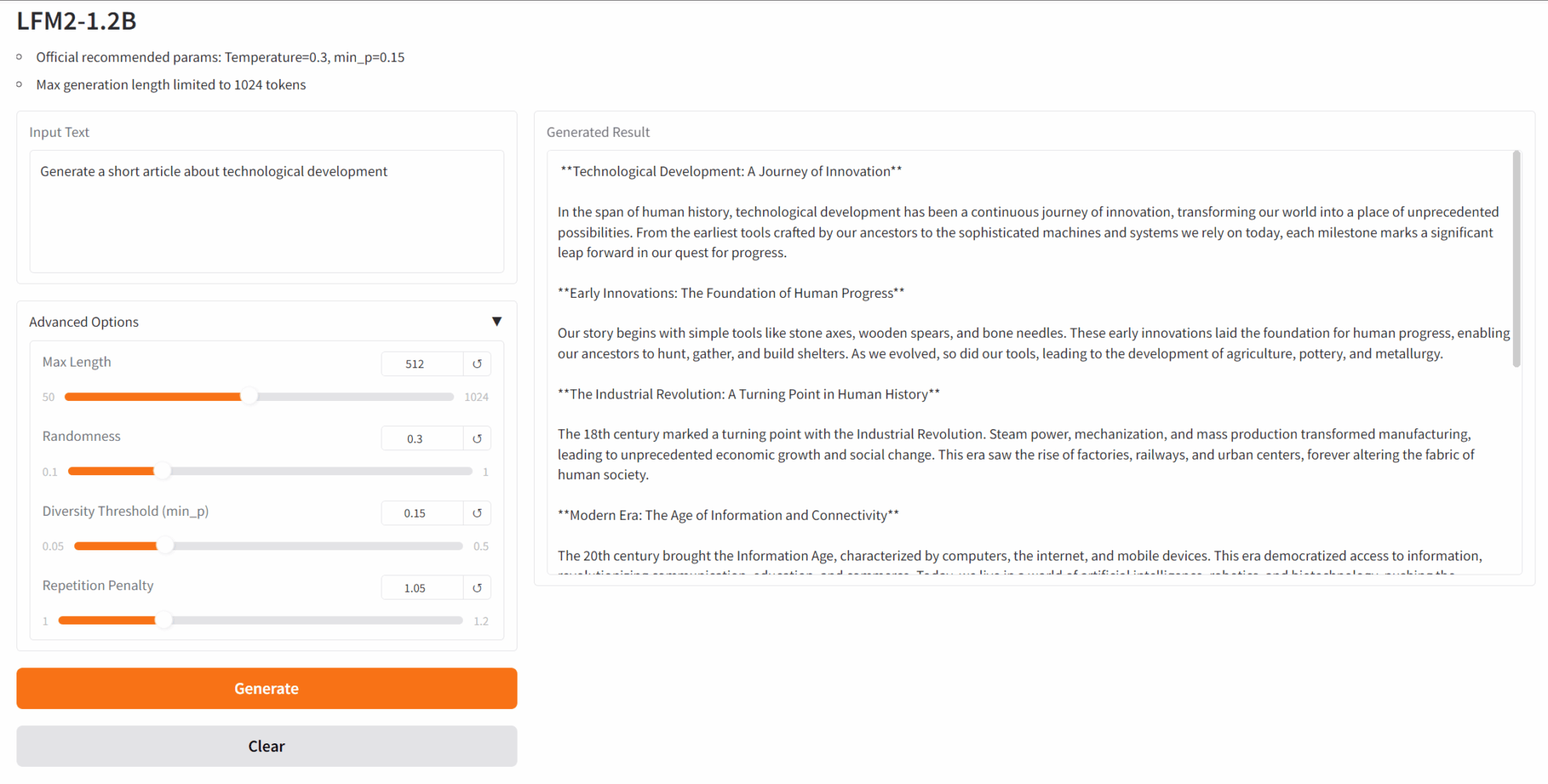

二、项目示例

三、运行步骤

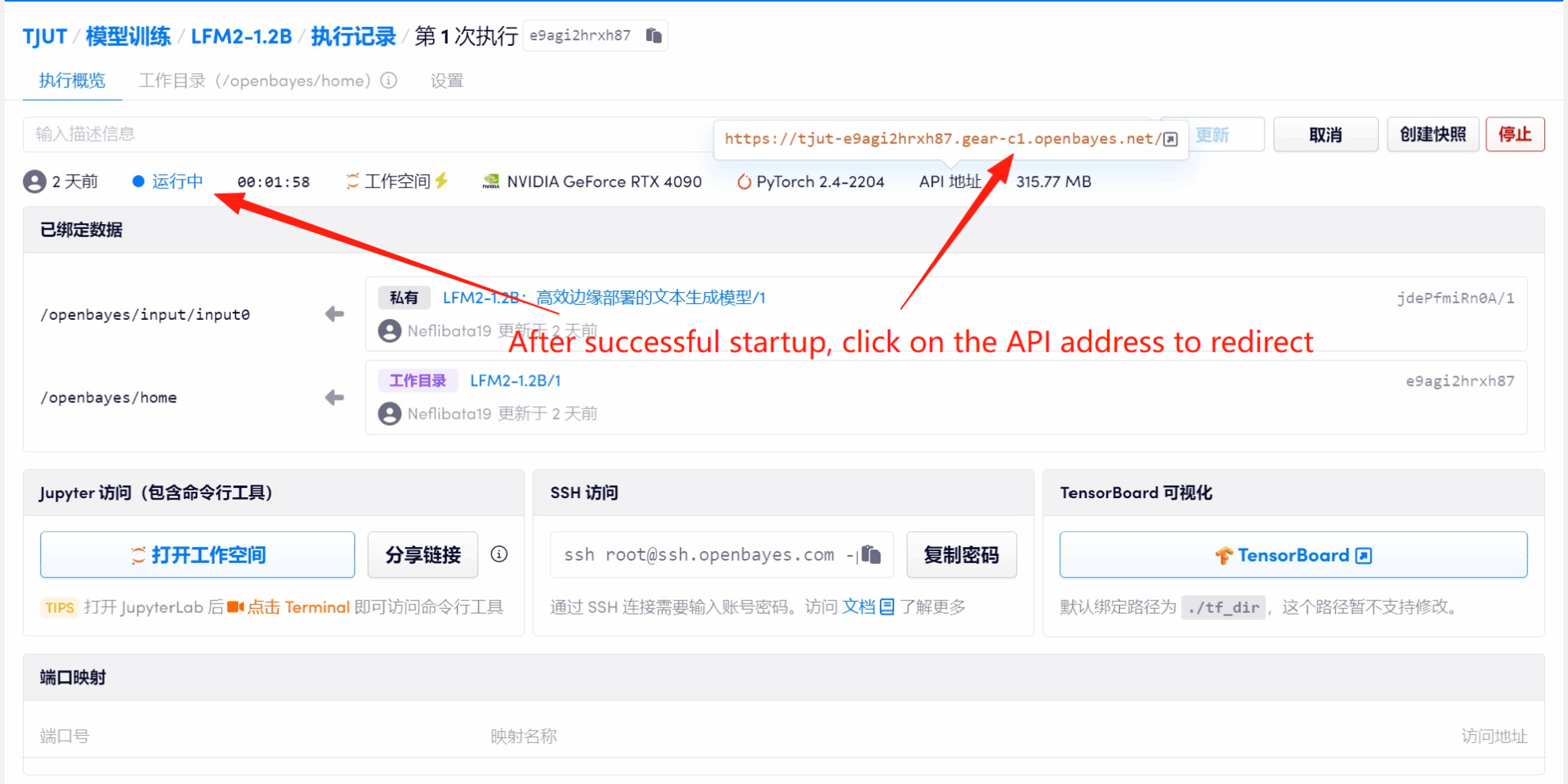

1. 启动容器后点击 API 地址即可进入 Web 界面

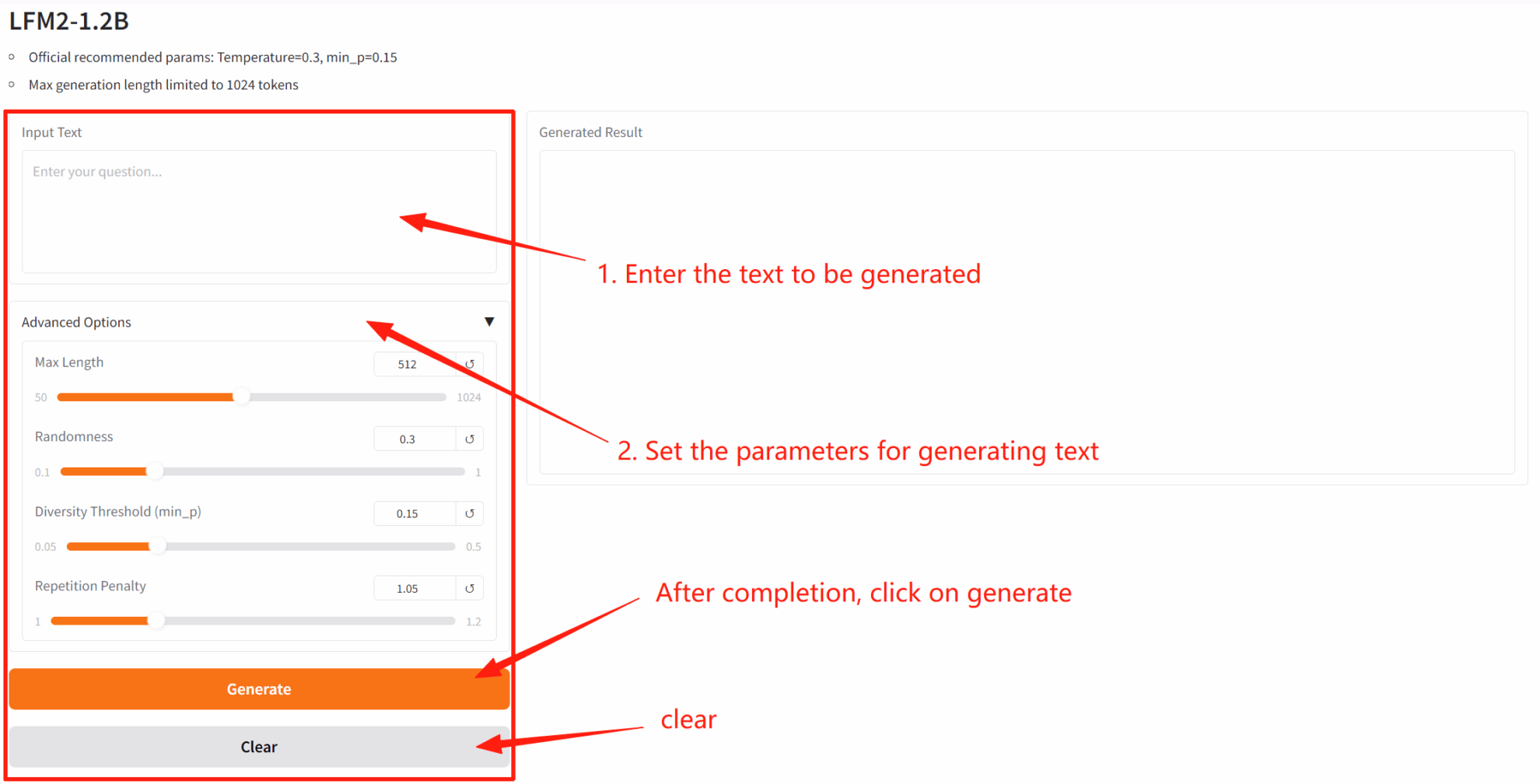

2. 进入网页后,即可与模型展开对话

若显示「Bad Gateway」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

四、交流探讨

如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓