Command Palette

Search for a command to run...

HealthGPT:AI 医疗助手

一、教程简介

HealthGPT 是由浙江大学、电子科技大学、阿里巴巴、香港科技大学、新加坡国立大学于 2025 年 3 月 16 日联合发布的医疗大型视觉语言模型(Med-LVLM),通过异构知识适应技术实现医学视觉理解和生成任务的统一框架。采用创新的异构低秩适应(H-LoRA)技术,将视觉理解与生成任务的知识存储在独立的插件中,避免任务间的冲突。 HealthGPT 提供两种版本:HealthGPT-M3(38 亿参数)和 HealthGPT-L14(140 亿参数),分别基于 Phi-3-mini 和 Phi-4 预训练语言模型。模型引入了分层视觉感知(HVP)和三阶段学习策略(TLS),优化视觉特征的学习和任务适应能力。相关论文成果为 HealthGPT: A Medical Large Vision-Language Model for Unifying Comprehension and Generation via Heterogeneous Knowledge Adaptation 。已被 ICML 2025 收录并评选为 Spotlight 。

本教程采用资源为单卡 RTX A6000 。推荐使用英文。

该项目提供了两种型号的模型:

- HealthGPT-M3:针对速度和减少内存使用进行了优化的较小版本。

- HealthGPT-L14:专为更高性能和更复杂的任务而设计的更大版本。

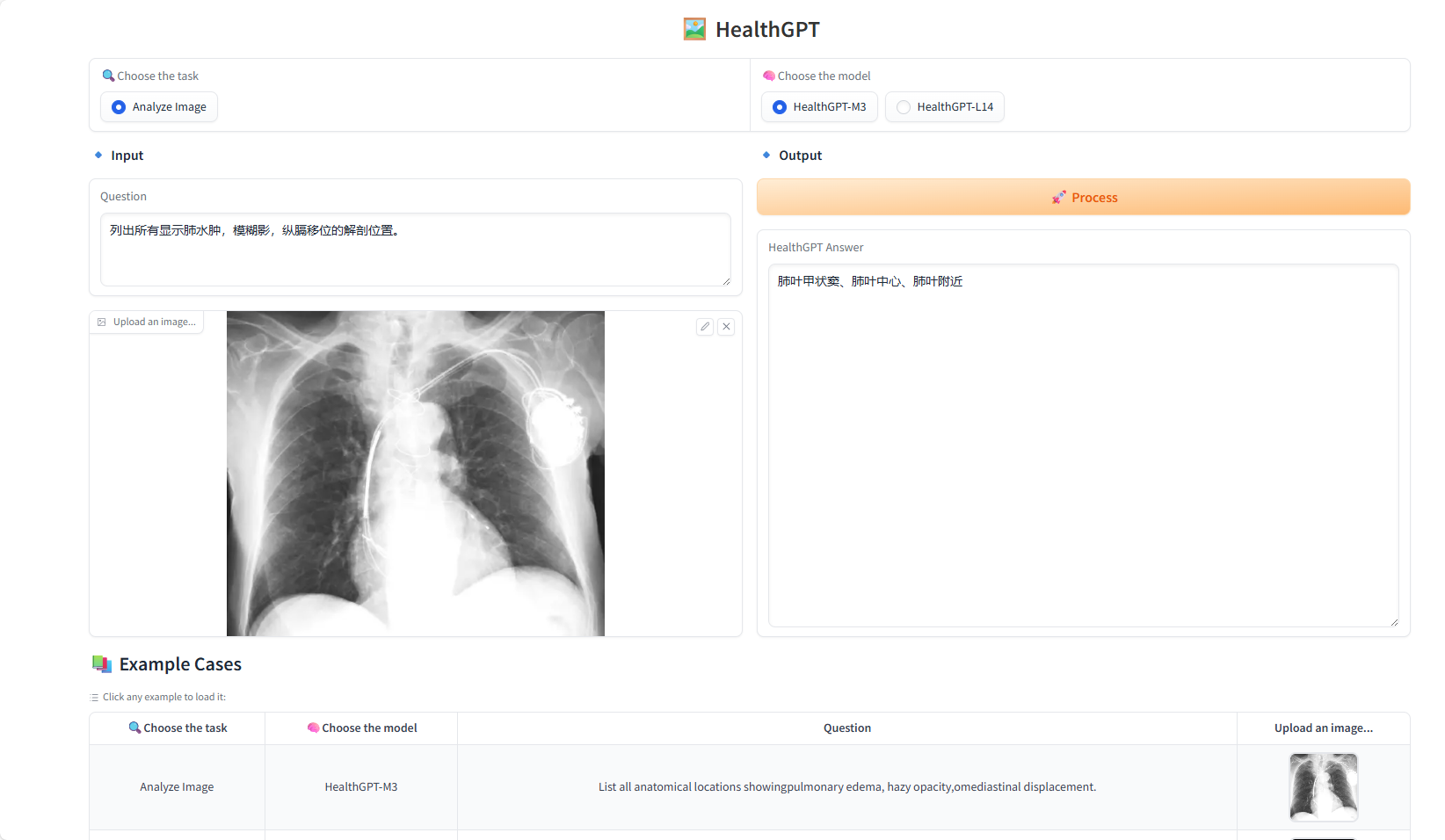

二、项目示例

三、运行步骤

1. 启动容器后点击 API 地址即可进入 Web 界面

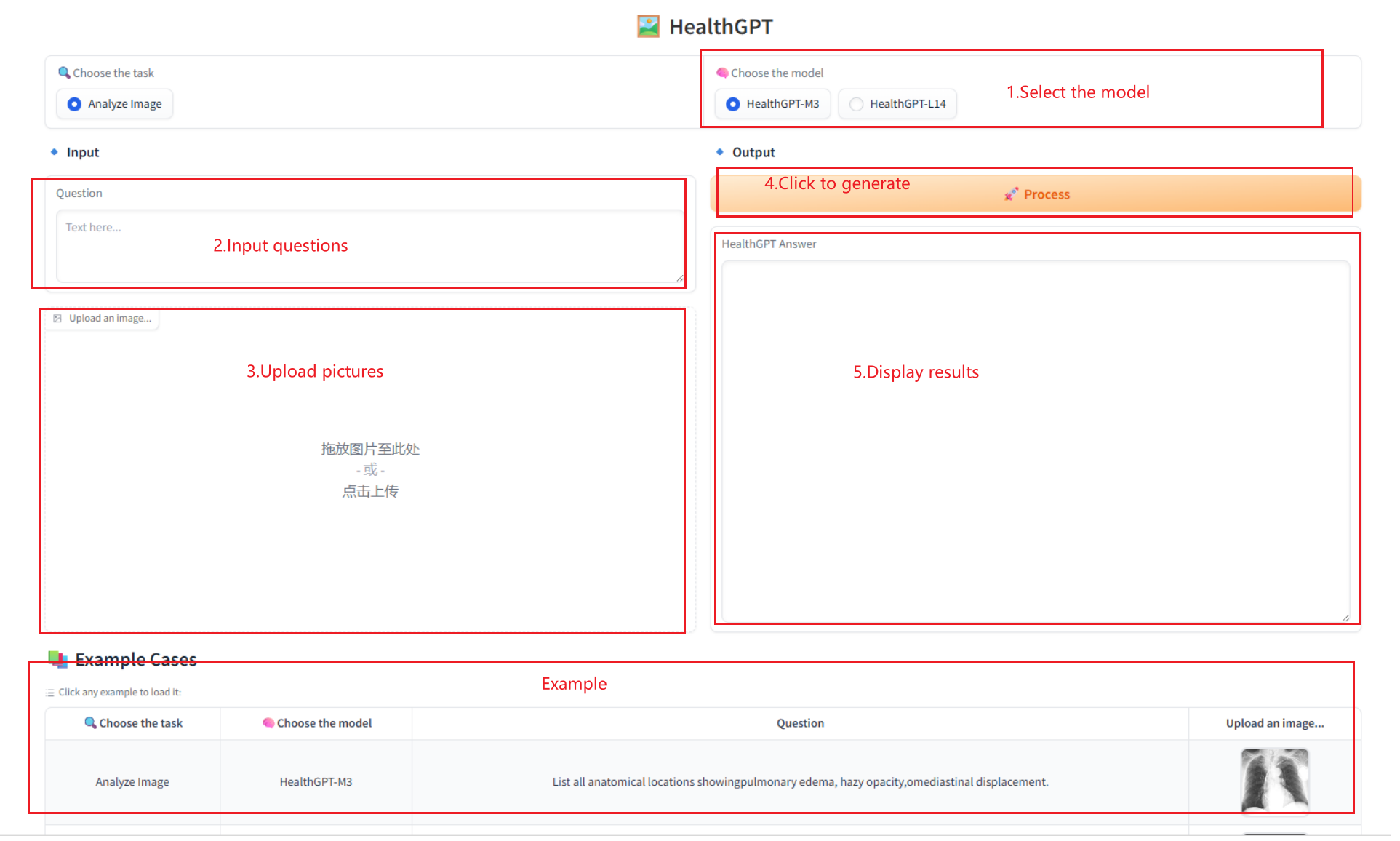

2. 使用步骤

若显示「Bad Gateway」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

引用信息

感谢 Github 用户 xxxjjjyyy1 对本教程的部署。本项目引用信息如下:

@misc{lin2025healthgptmedicallargevisionlanguage,

title={HealthGPT: A Medical Large Vision-Language Model for Unifying Comprehension and Generation via Heterogeneous Knowledge Adaptation},

author={Tianwei Lin and Wenqiao Zhang and Sijing Li and Yuqian Yuan and Binhe Yu and Haoyuan Li and Wanggui He and Hao Jiang and Mengze Li and Xiaohui Song and Siliang Tang and Jun Xiao and Hui Lin and Yueting Zhuang and Beng Chin Ooi},

year={2025},

eprint={2502.09838},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2502.09838},

}