Command Palette

Search for a command to run...

OmniGen2:探索高级多模态生成

一、教程简介

OmniGen2 是北京人工智能研究院(BAAI)于 2025 年 6 月 16 日发布的开源多模态生成模型。旨在为多种生成任务提供统一的解决方案,包括文本到图像生成、图像编辑和上下文生成。与 OmniGen v1 不同,OmniGen2 为文本和图像模态设计了两条独立的解码路径,采用了非共享参数和分离的图像分词器。这一设计使得 OmniGen2 能够在现有的多模态理解模型基础上进行构建,而无需重新适应 VAE 输入,从而保留了原有的文本生成能力。其核心创新在于双路径架构和自我反思机制,成为当前开源多模态模型的新标杆。相关论文成果为 OmniGen2: Exploration to Advanced Multimodal Generation 。

该教程算力资源采用单卡 RTX A6000,目前英语提示的效果更好。

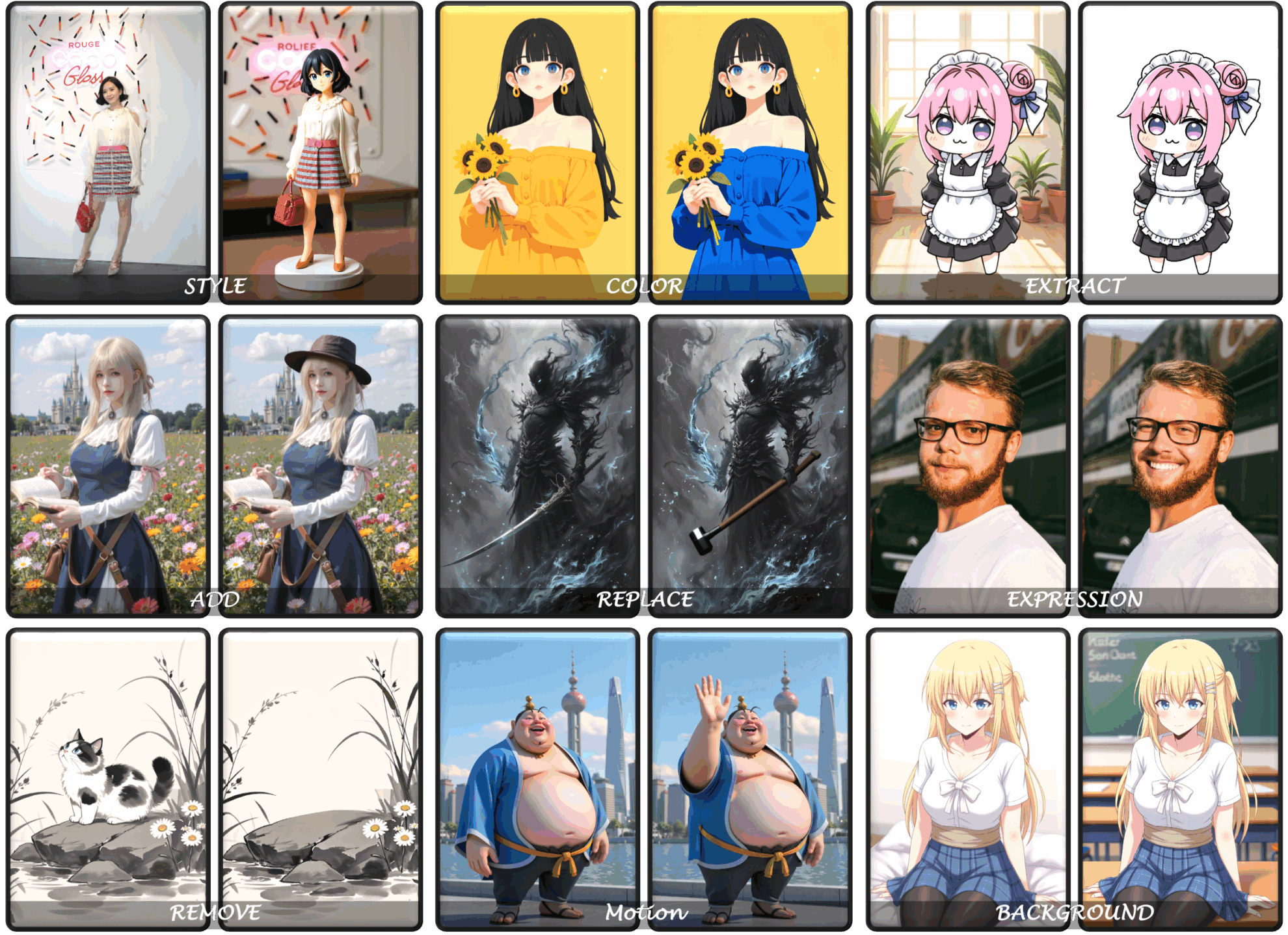

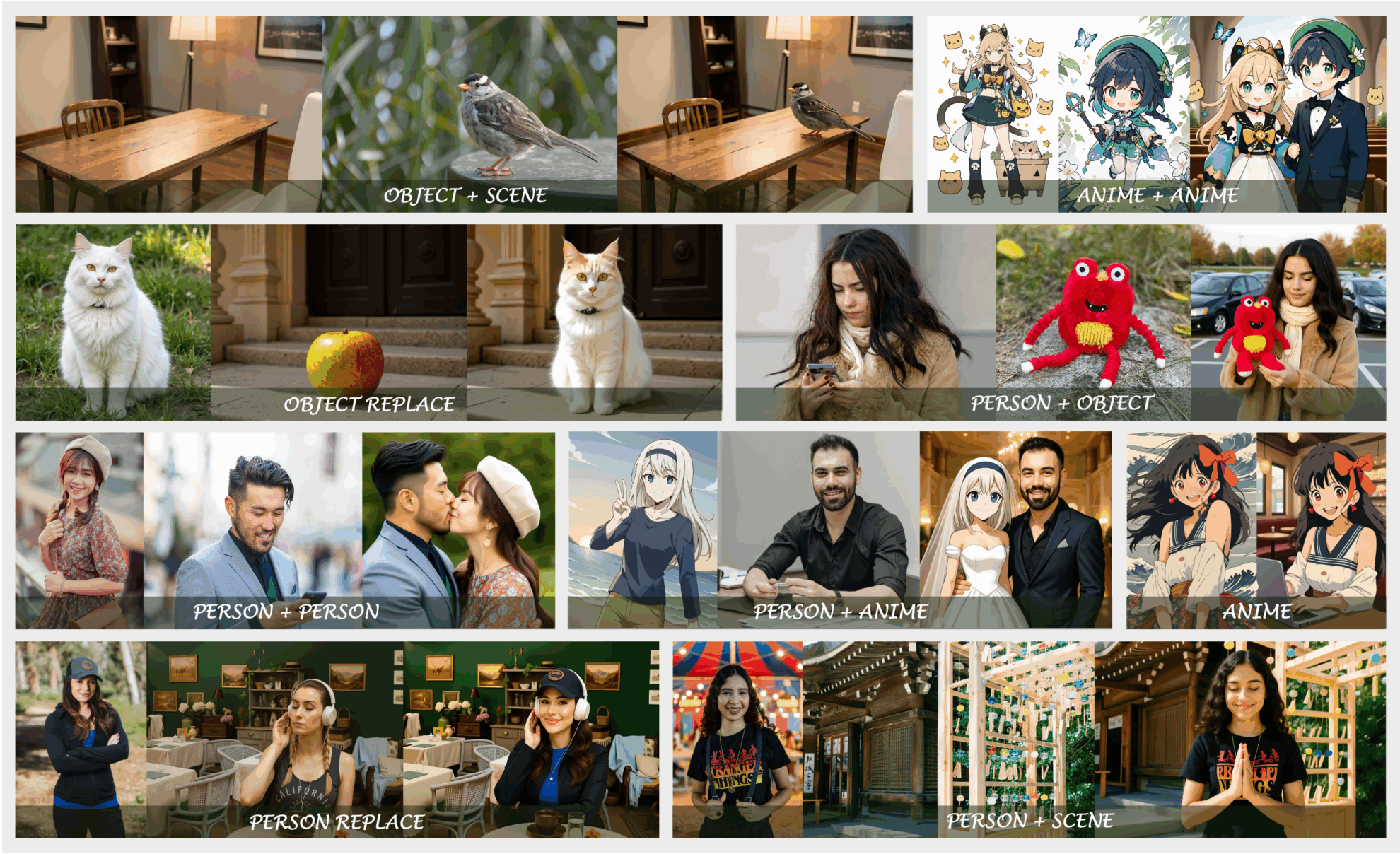

二、效果展示

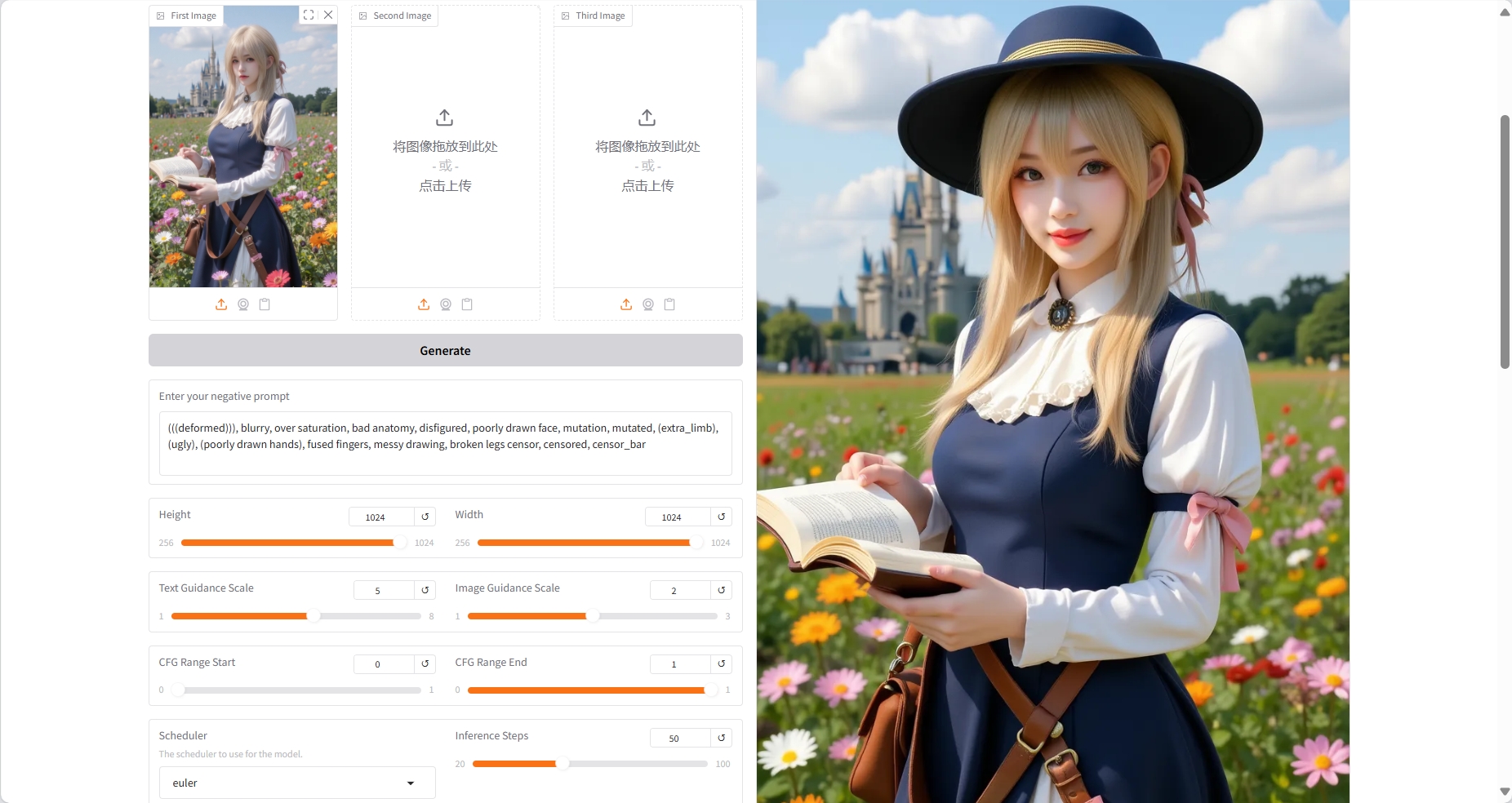

OmniGen2 的一些效果示例:

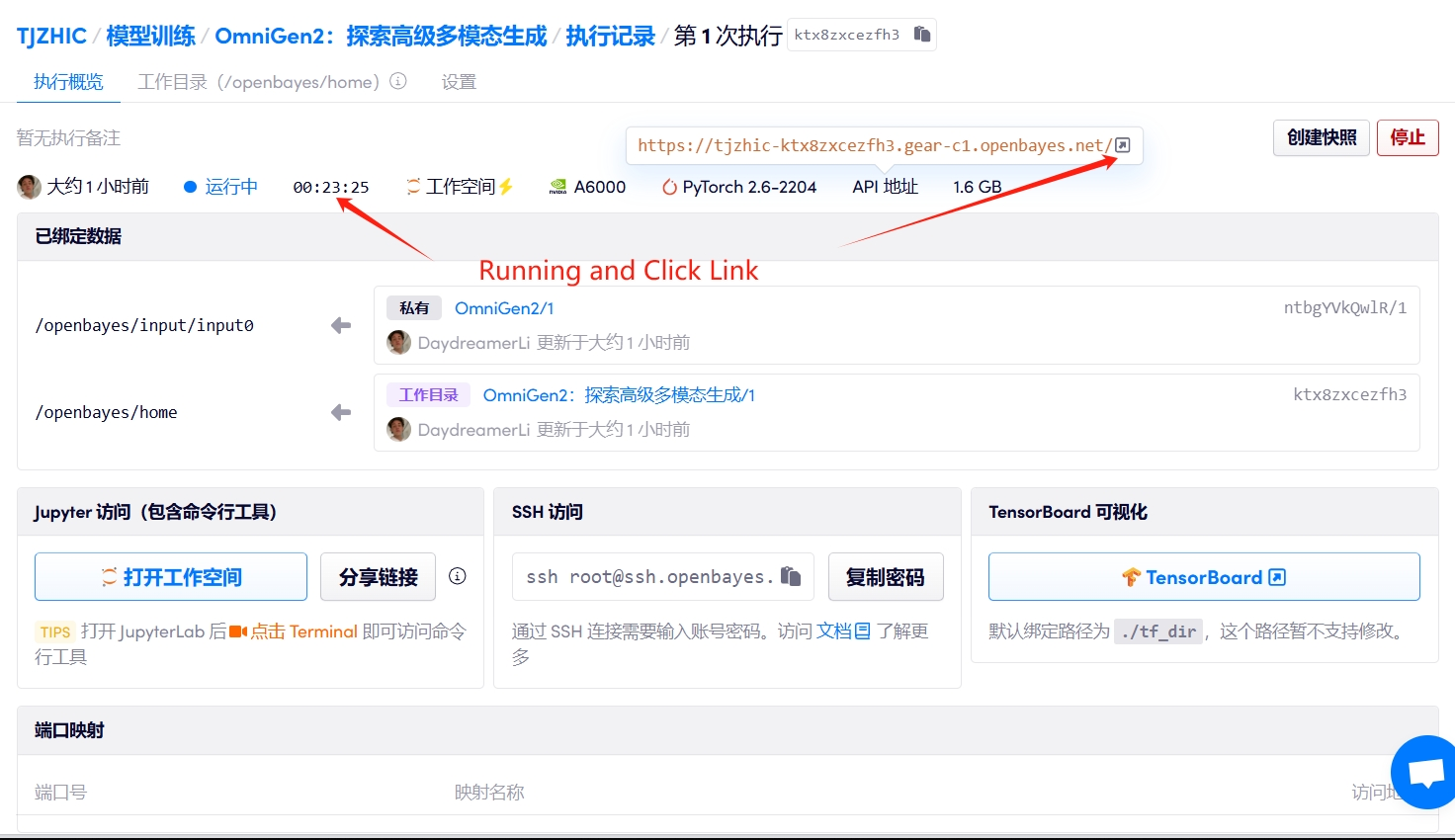

三、运行步骤

1. 启动容器

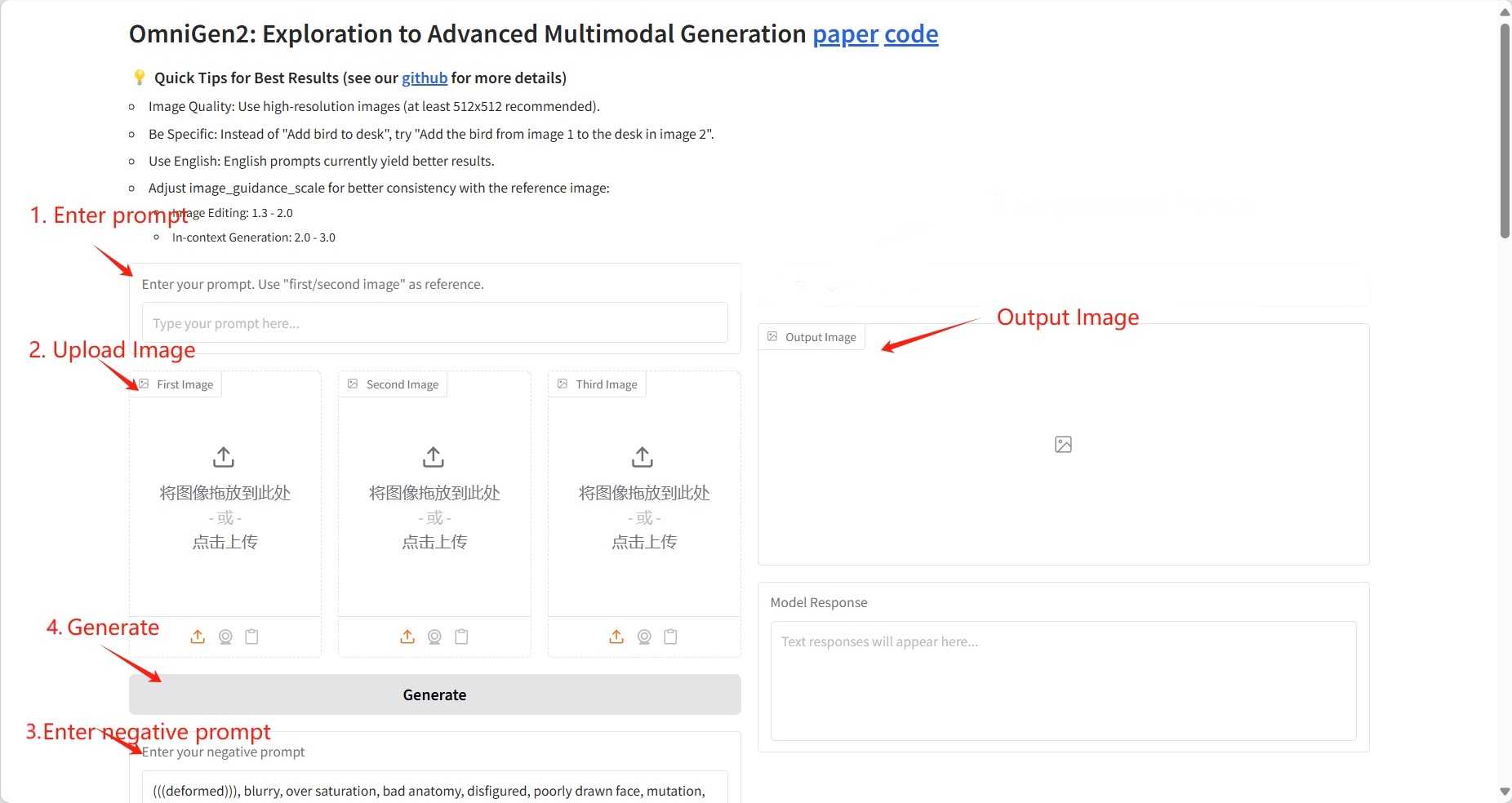

2. 使用步骤

若显示「Bad Gateway」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

第一个例子为图像描述,第二和第三个例子为文生图,其余例子为图像编辑。

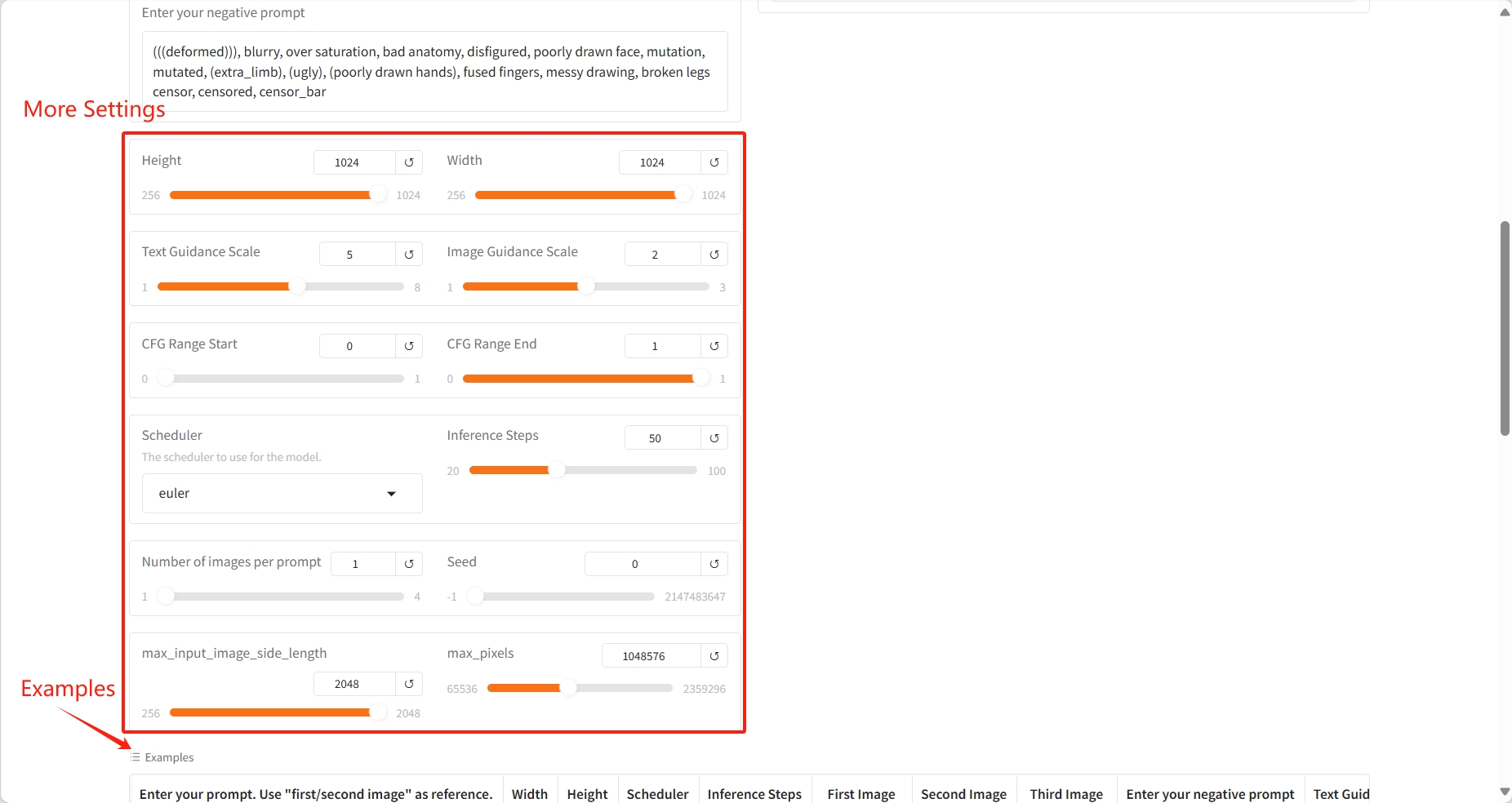

具体参数:

- Height:高度。

- Width:宽度。

- Text Guidance Scale:文本引导尺度。

- Image Guidance Scale:图像引导尺度。

- CFG Range Start: 范围起始。

- CFG Range End:范围结束。

- Scheduler:调度器。

- Inference Steps:推理步骤。

- Number of images per prompt:每条提示的图像数量。

- Seed:种子。

- max_input_image_side_length:最大输入图像边长。

- max_pixels:最大像素。

结果

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

引用信息

本项目引用信息如下:

@article{wu2025omnigen2,

title={OmniGen2: Exploration to Advanced Multimodal Generation},

author={Chenyuan Wu and Pengfei Zheng and Ruiran Yan and Shitao Xiao and Xin Luo and Yueze Wang and Wanli Li and Xiyan Jiang and Yexin Liu and Junjie Zhou and Ze Liu and Ziyi Xia and Chaofan Li and Haoge Deng and Jiahao Wang and Kun Luo and Bo Zhang and Defu Lian and Xinlong Wang and Zhongyuan Wang and Tiejun Huang and Zheng Liu},

journal={arXiv preprint arXiv:2506.18871},

year={2025}

}