HyperAI

Command Palette

Search for a command to run...

vLLM+Open WebUI 部署 KernelLLM-8B

一、教程简介

该教程算力资源采用单卡 RTX 4090 。

KernelLLM 是 Meta AI 推出的一个专为 GPU 内核开发设计的大型语言模型,旨在将 PyTorch 模块自动翻译为高效的 Triton 内核代码,从而简化和加速高性能 GPU 编程的过程。该模型基于 Llama 3.1 Instruct 架构,拥有 80 亿参数,专注于生成高效的 Triton 内核实现。

二、项目示例

三、运行步骤

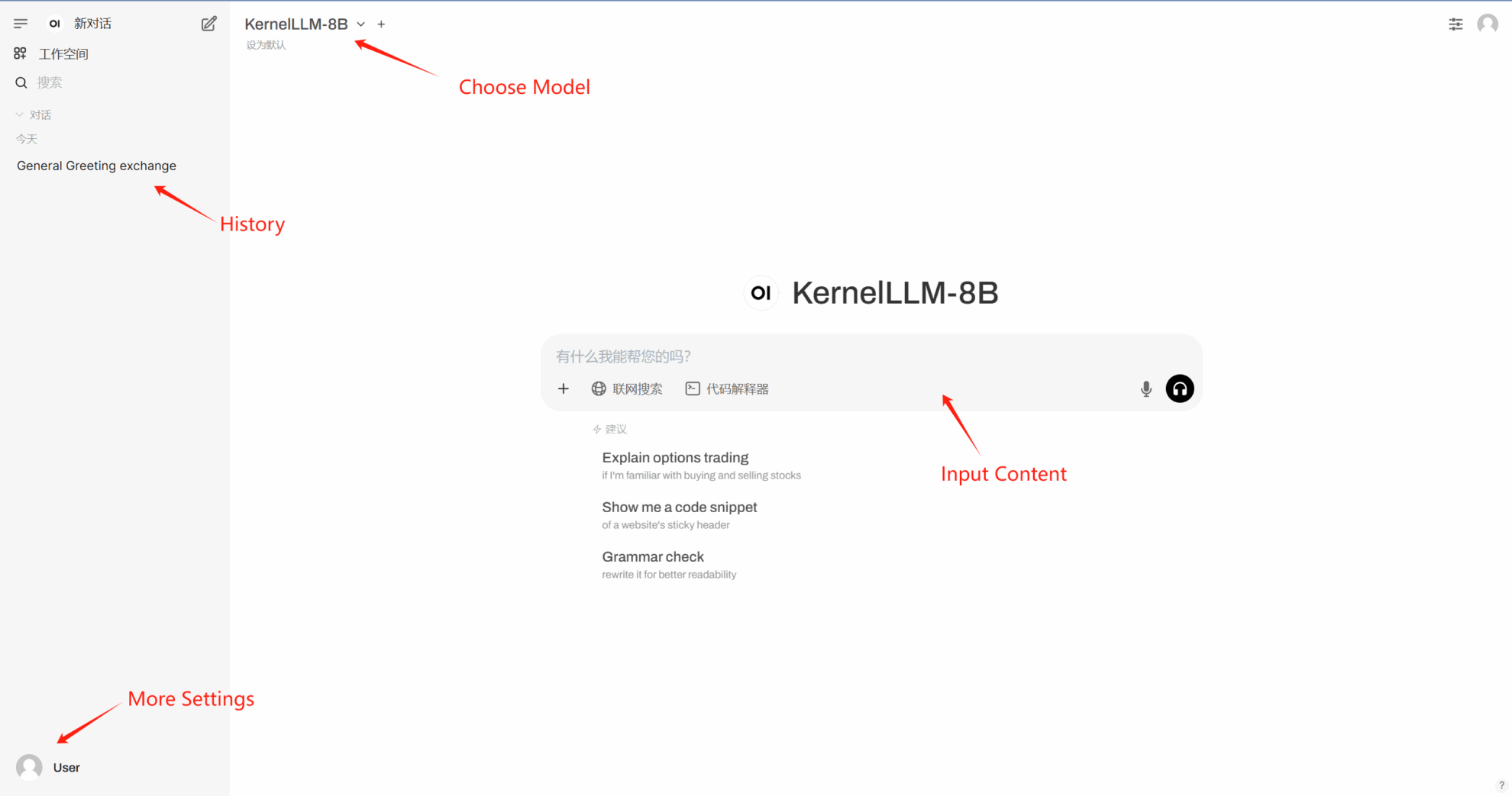

1. 启动容器

若不显示「模型」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

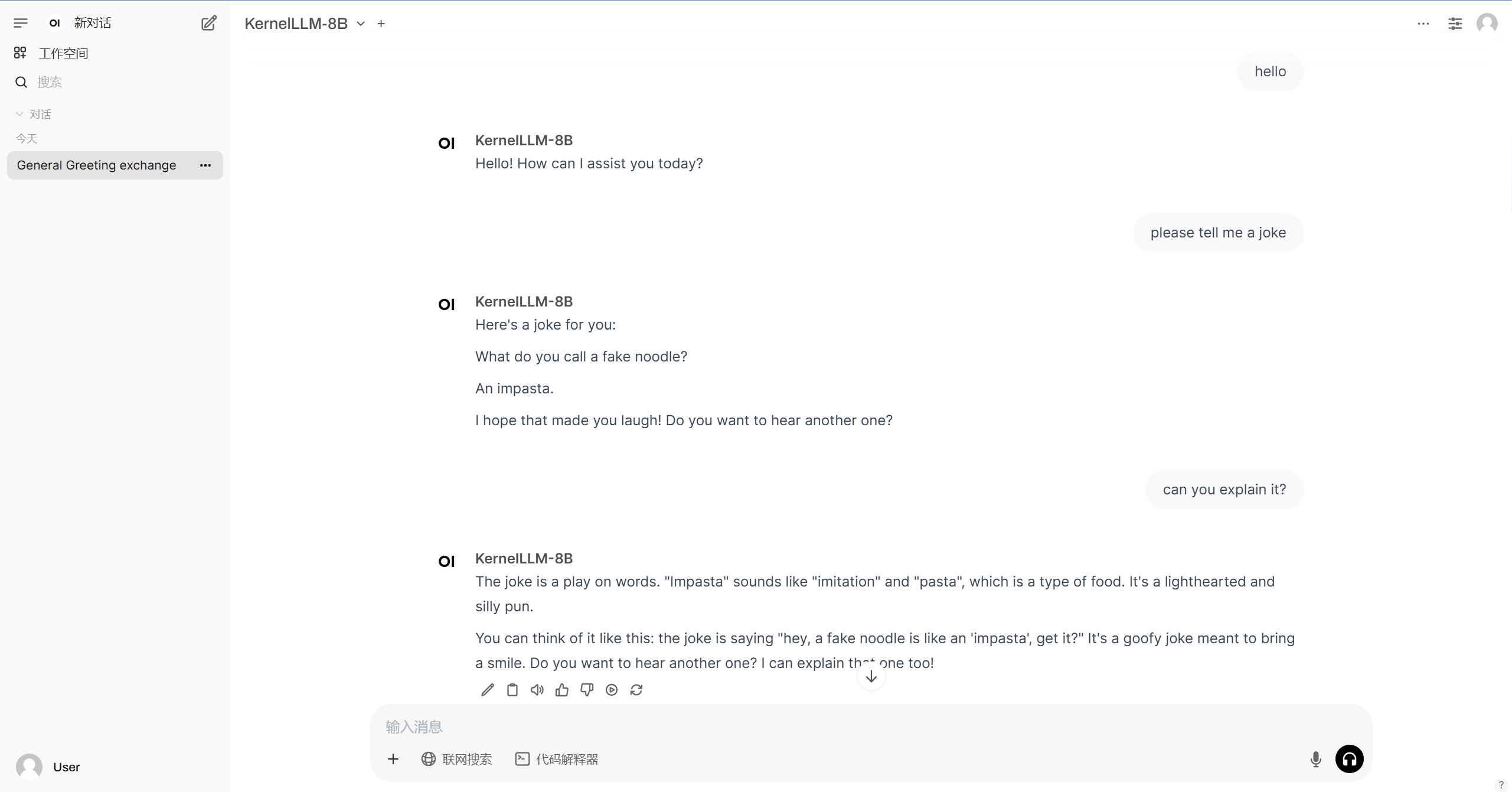

2. 进入网页后,即可与模型展开对话

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

该教程由社区用户贡献,仅供交流学习使用。如内容涉及侵权,请联系邮箱 [email protected] 以便及时审查和下架。