Command Palette

Search for a command to run...

Distill-Any-Depth:单目深度估计器

一、教程简介

Distill-Any-Depth 是由浙江工业大学、西湖大学、河南大学、新加坡国立大学于 2025 年 2 月 28 日联合发布的创新性单目深度估计项目。该项目通过蒸馏算法整合多个开源模型的优势,仅需少量无标签数据即可实现高精度深度估计,刷新了当前 SOTA(State-of-the-Art)性能。相关论文成果为 Distill Any Depth: Distillation Creates a Stronger Monocular Depth Estimator 。

以下是其核心要点:

- 多教师蒸馏框架

- 通过随机选择多个教师模型生成伪标签,综合不同模型的优势,提升伪标签质量。

- 引入跨上下文蒸馏机制,结合局部细节与全局信息,显著增强模型鲁棒性。

- 局部归一化策略

- 传统全局归一化会放大噪声,该项目提出在裁剪区域内进行归一化,保留局部细节(如物体边缘、小孔结构),提升预测精度。

- 低数据依赖

- 仅需 2 万张无标签图像(远低于传统方法百万级标注需求),大幅降低数据标注成本。

- 泛化能力

- 在 NYUv2(室内)、 KITTI(户外驾驶)、 DIODE(复杂光照)等基准测试中,误差指标(AbsRel)显著优于前代模型。

- 鲁棒性

- 在透明物体、反射表面及动态场景中表现稳定,解决了传统模型在复杂条件下的失效问题。

- 效率

- 推理速度较基于 Diffusion 的模型(如 Marigold)提升 10 倍以上,支持实时应用。

该教程算力资源采用单卡 RTX 4090 。

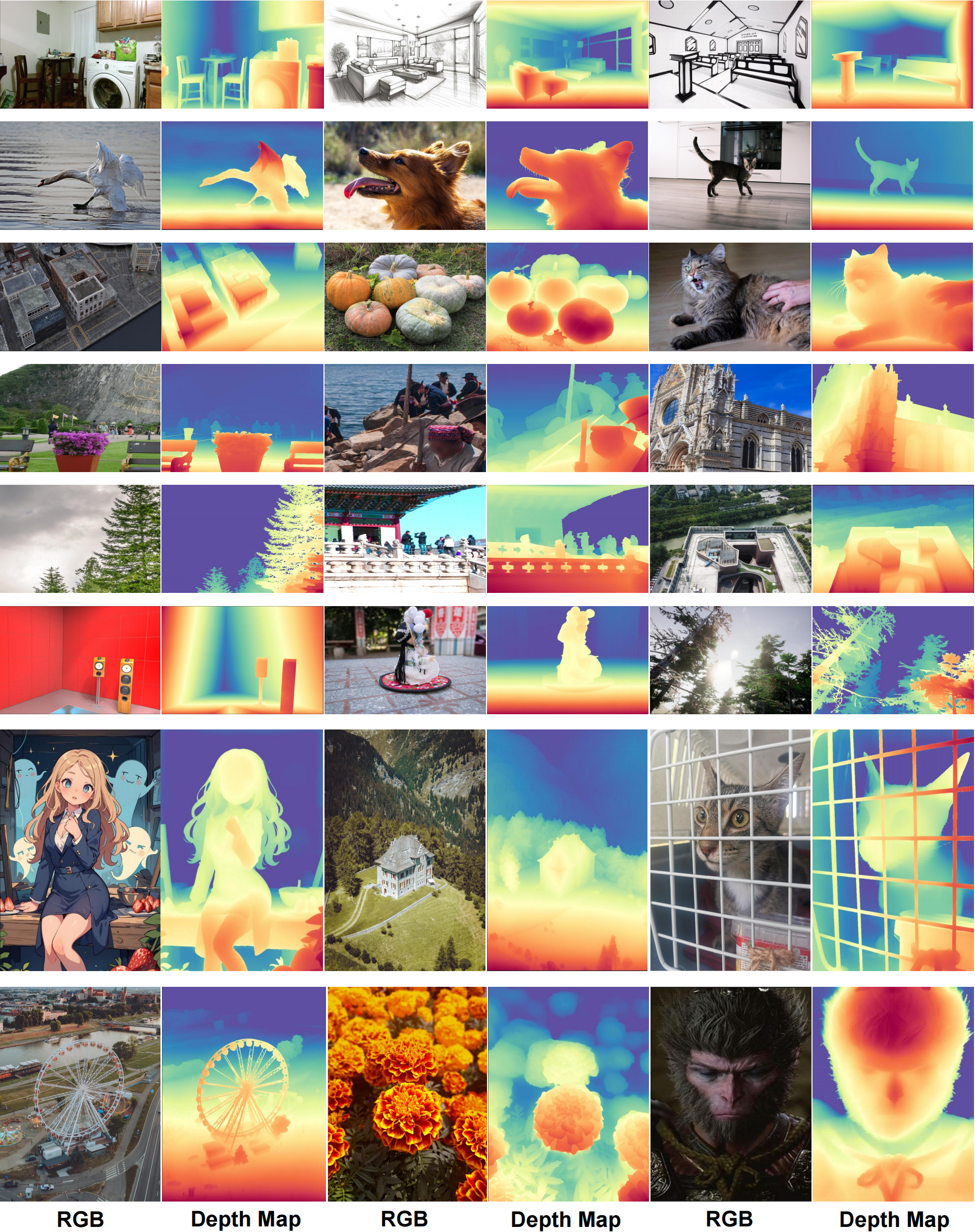

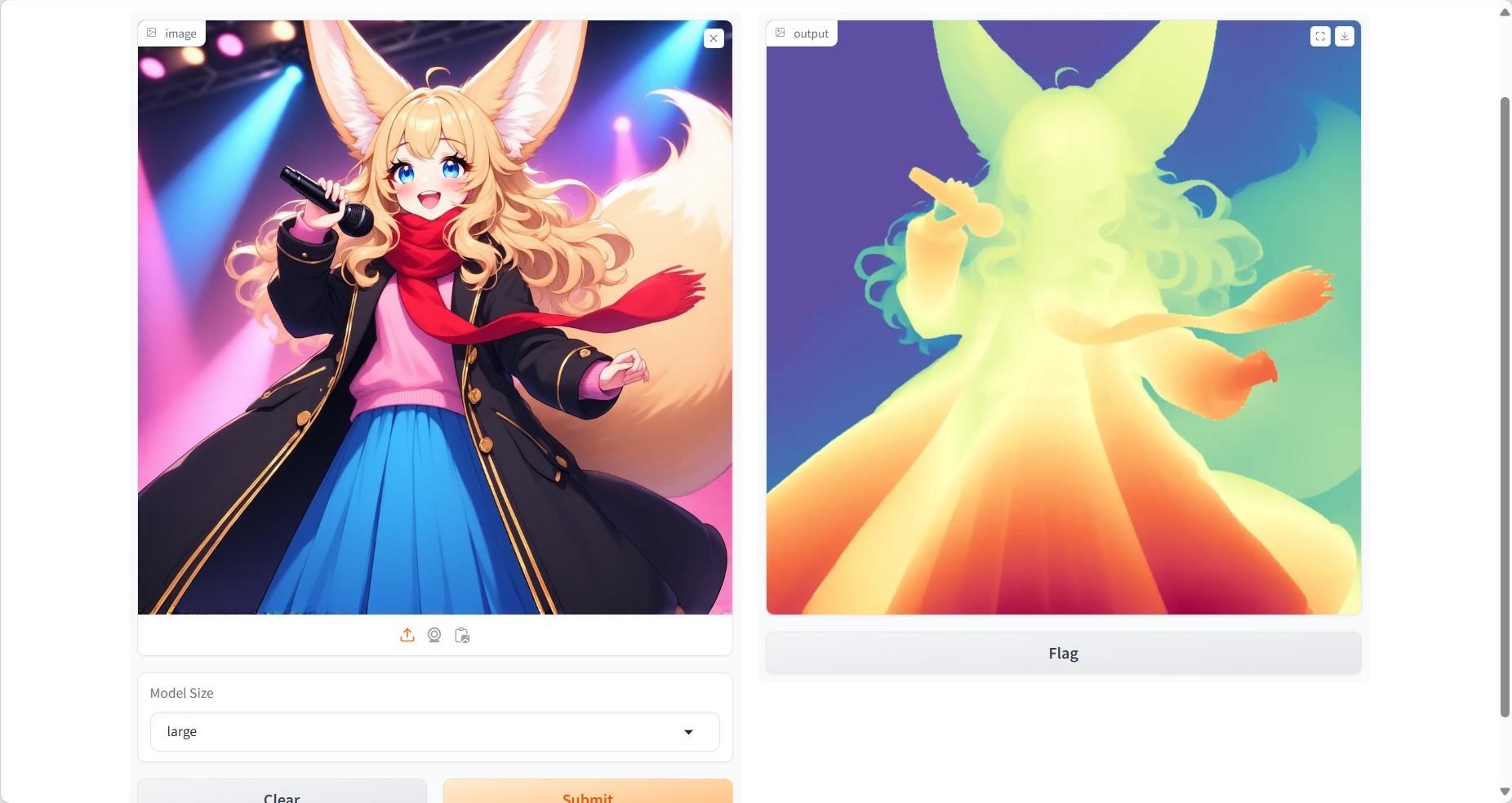

二、效果展示

三、运行步骤

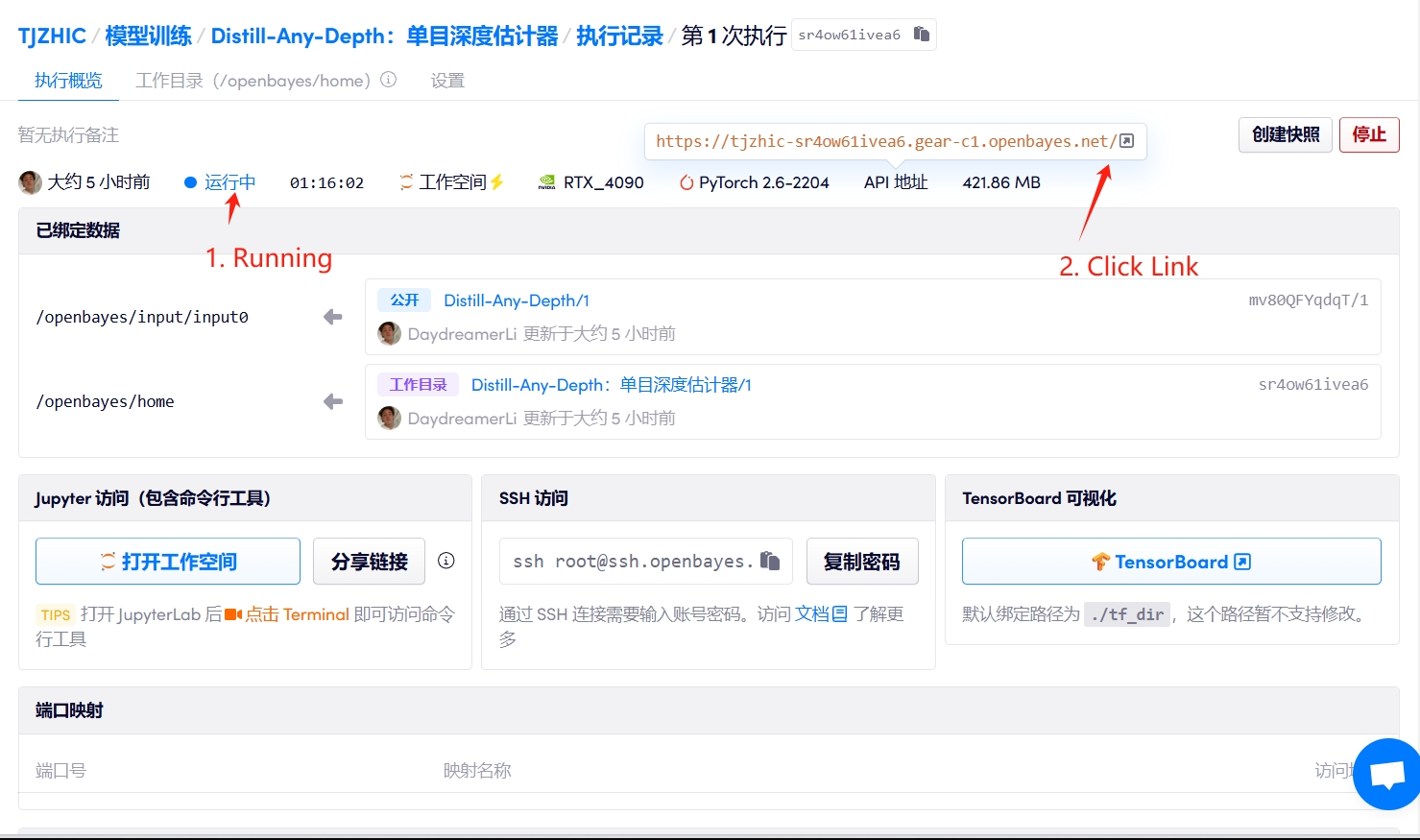

1. 启动容器

若显示「Bad Gateway」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

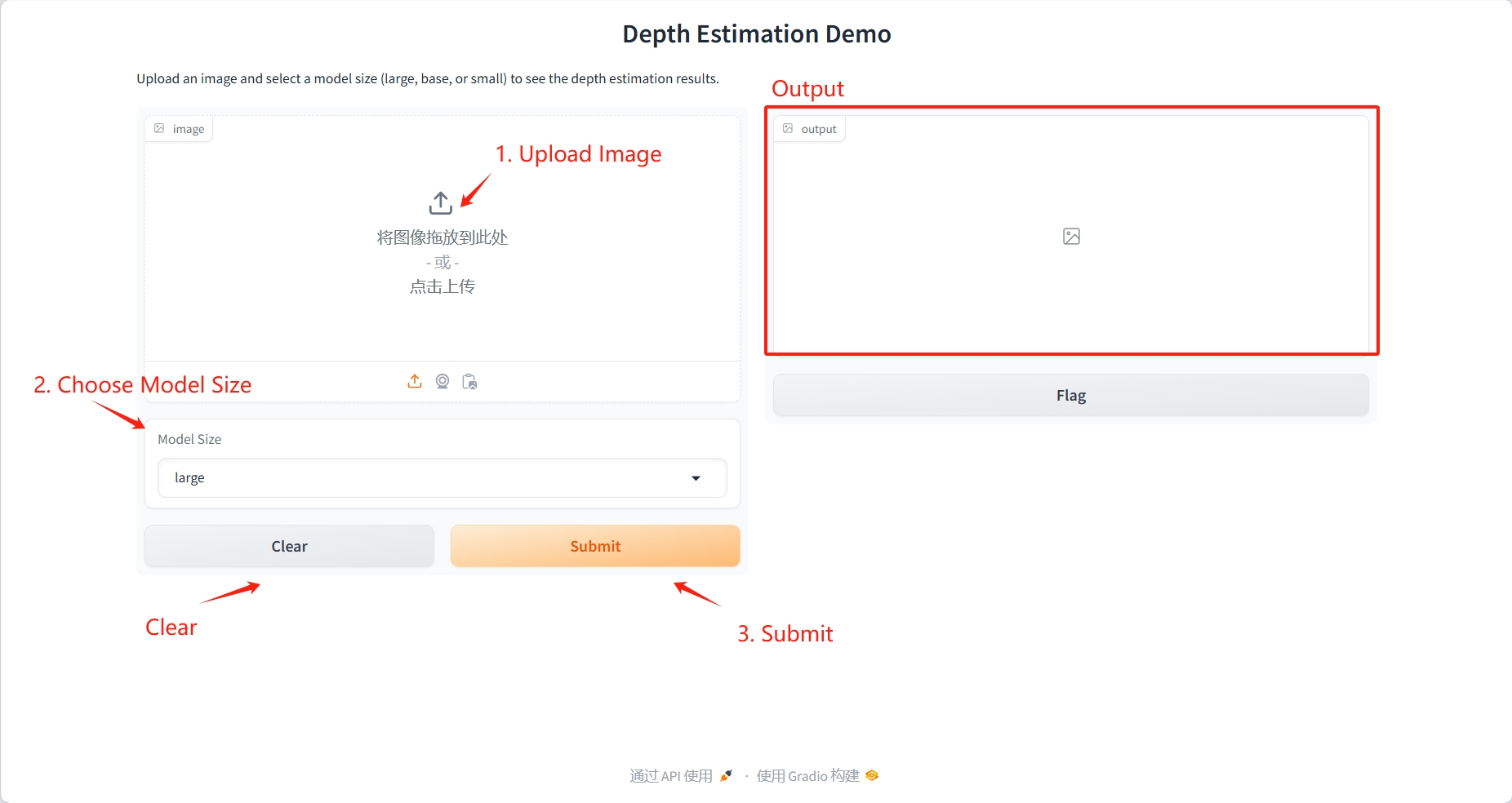

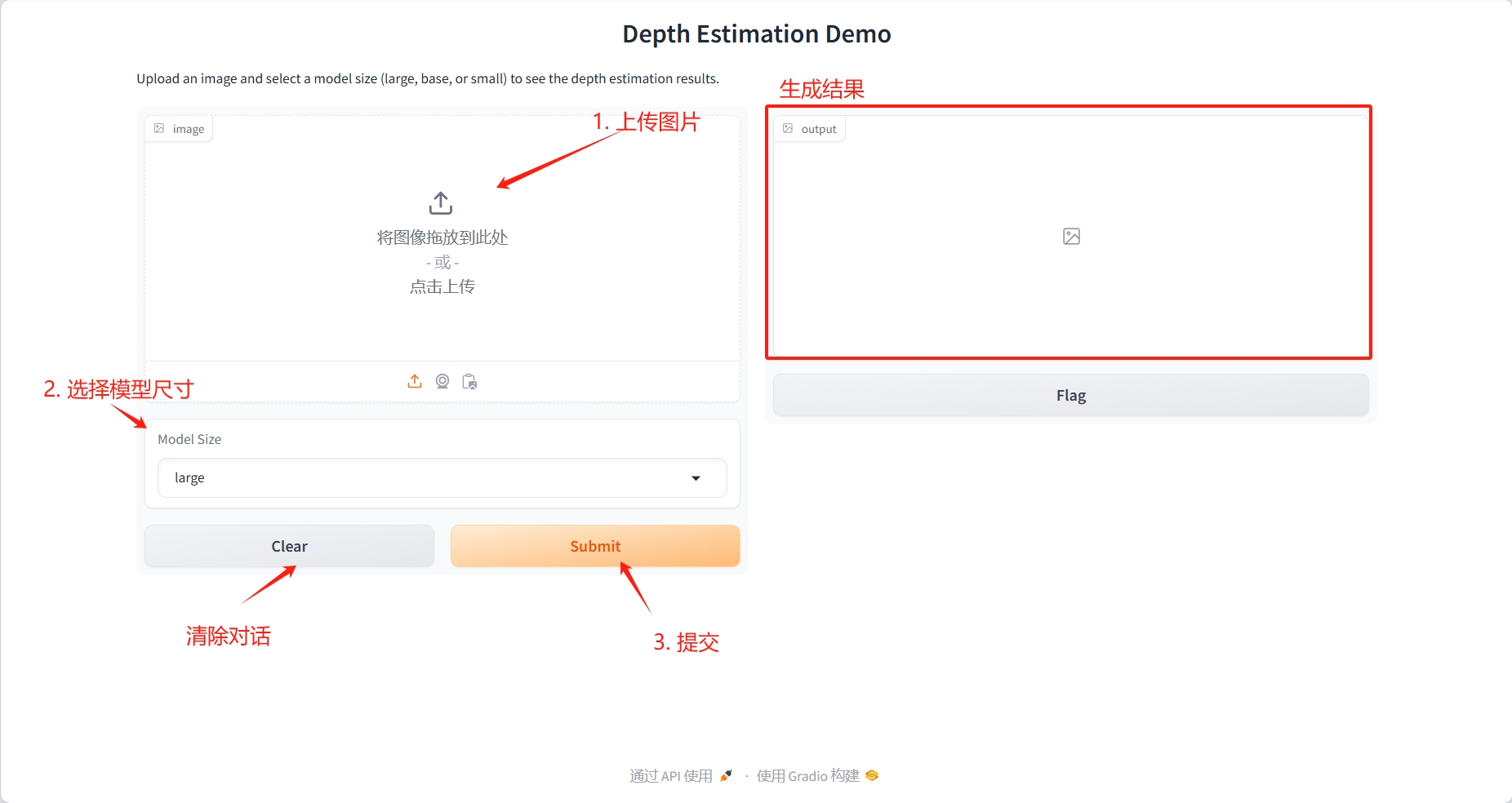

2. 使用步骤

结果

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

引用信息

本项目引用信息如下:

@article{he2025distill,

title = {Distill Any Depth: Distillation Creates a Stronger Monocular Depth Estimator},

author = {Xiankang He and Dongyan Guo and Hongji Li and Ruibo Li and Ying Cui and Chi Zhang},

year = {2025},

journal = {arXiv preprint arXiv: 2502.19204}

}