Command Palette

Search for a command to run...

Vchitect-2.0 视频扩散模型 Demo

项目概述

Vchitect-2.0 是由上海人工智能实验室团队于 2024 年 9 月开发的高质量视频生成系统。该模型采用了创新的并行 Transformer 架构设计,拥有 20 亿参数,能够根据文本提示生成流畅、高质量的视频内容。相关论文成功为 Vchitect-2.0: Parallel Transformer for Scaling Up Video Diffusion Models 。

本教程采用资源为单卡 A6000 。

运行步骤

1. 启动容器后点击 API 地址即可进入 Web 界面

若显示「Bad Gateway」,这表示模型正在初始化,由于模型较大,请等待约 1-2 分钟后刷新页面。

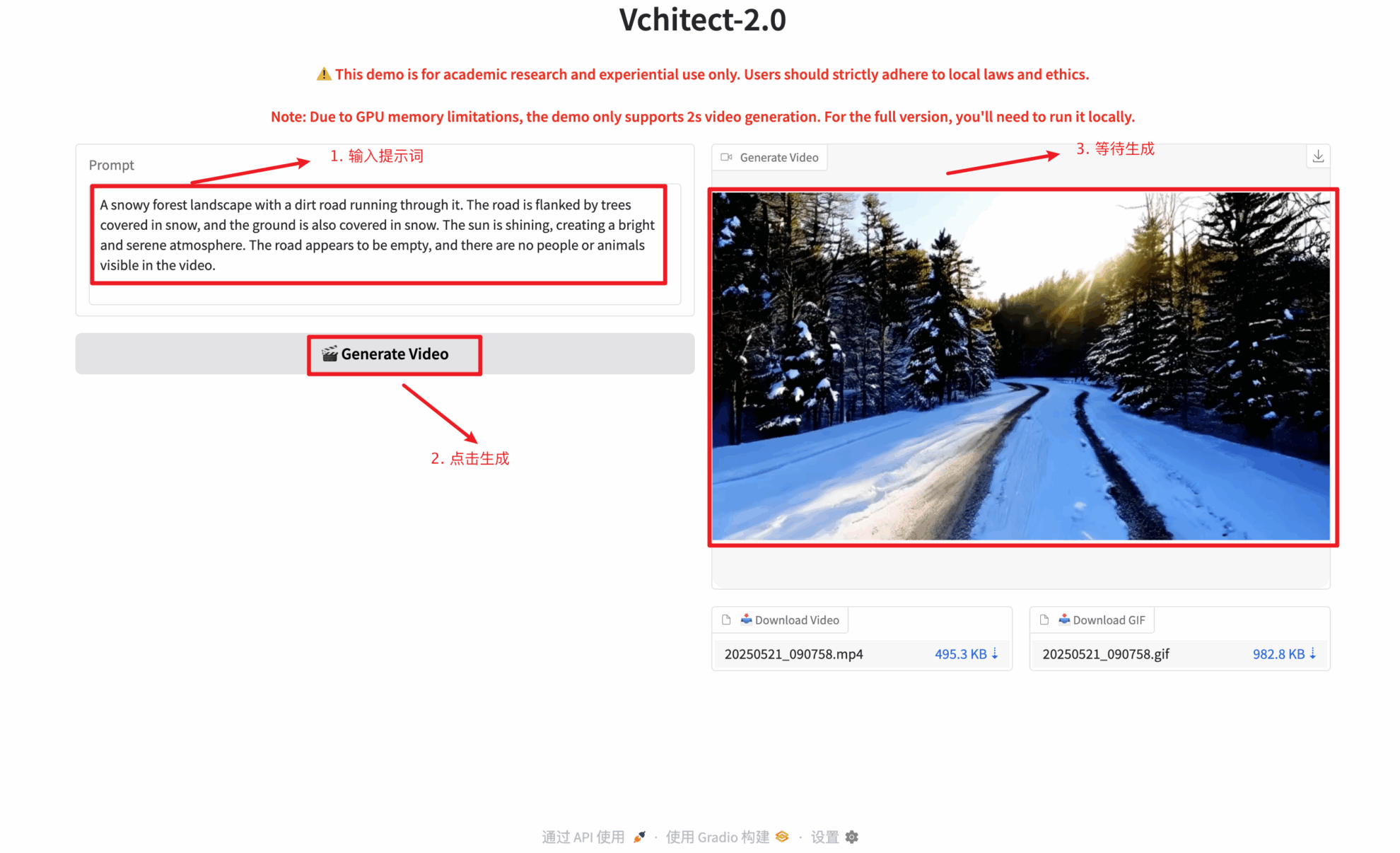

2. 进入网页后,即可与模型进行交互

生成视频需要输入文本提示,文本提示仅支持英语,文本提示可以是任意长度的文本,但建议控制在 100 个字符以内,否则可能会导致生成视频过长,影响视频质量。 视频需要等待约 2-5 分钟左右,请耐心等待。

交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

引用信息

感谢 Github 用户 zhangjunchang 对本教程的部署,本项目引用信息如下:

@article{fan2025vchitect,

title={Vchitect-2.0: Parallel Transformer for Scaling Up Video Diffusion Models},

author={Fan, Weichen and Si, Chenyang and Song, Junhao and Yang, Zhenyu and He, Yinan and Zhuo, Long and Huang, Ziqi and Dong, Ziyue and He, Jingwen and Pan, Dongwei and others},

journal={arXiv preprint arXiv:2501.08453},

year={2025}

}