Command Palette

Search for a command to run...

一键部署 DeepSeek-R1-70B

一、教程简介

DeepSeek-R1-Distill-Llama-70B 是深度求索(DeepSeek)公司于 2025 年推出的开源大语言模型,参数规模高达 700 亿。它是基于 Llama3.3-70B-Instruct 进行训练的,采用强化学习和蒸馏技术提升推理表现,不仅继承了 Llama 系列模型的优势,还在此基础上进一步优化了推理能力,尤其在数学、代码与逻辑推理任务中表现突出。作为 DeepSeek 系列的高性能版本,它在多个基准测试中表现出色。此外,该模型是 DeepSeek AI 提供的一款推理增强型模型,支持多种应用场景,如移动设备与边缘计算、在线推理服务等,以提高响应速度和降低运营成本,其具备非常强大的推理和决策能力。在高级 AI 助手、科研分析等领域,能够提供极其专业和深入的分析结果。例如在医学科研中,70B 版本可以对大量的医学数据进行分析,为疾病研究提供有价值的参考。

本教程使用 Ollama + Open WebUI 部署 DeepSeek-R1-Distill-Qwen-70B 作为演示,算力资源采用「单卡 A6000」。

二、运行步骤

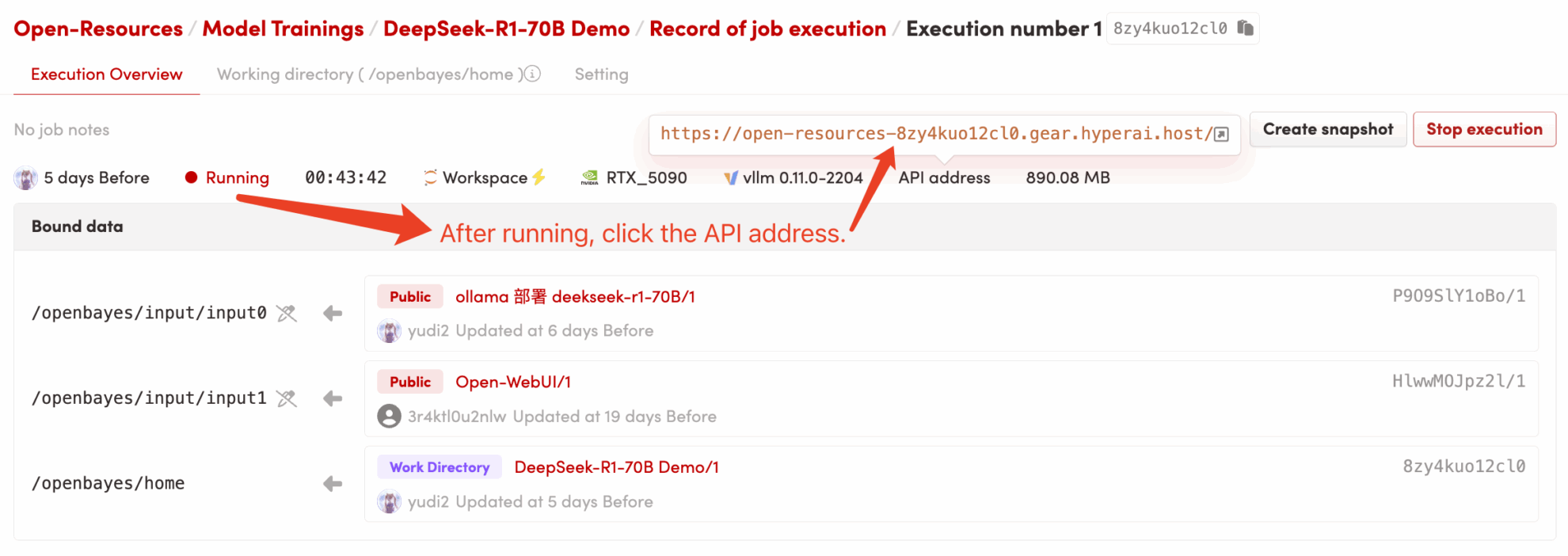

1. 启动容器后点击 API 地址即可进入 Web 界面(若显示「Bad Gateway」,这表示模型正在初始化,由于模型较大,请等待约 5 分钟后重试。)2. 进入网页后,即可与模型展开对话!

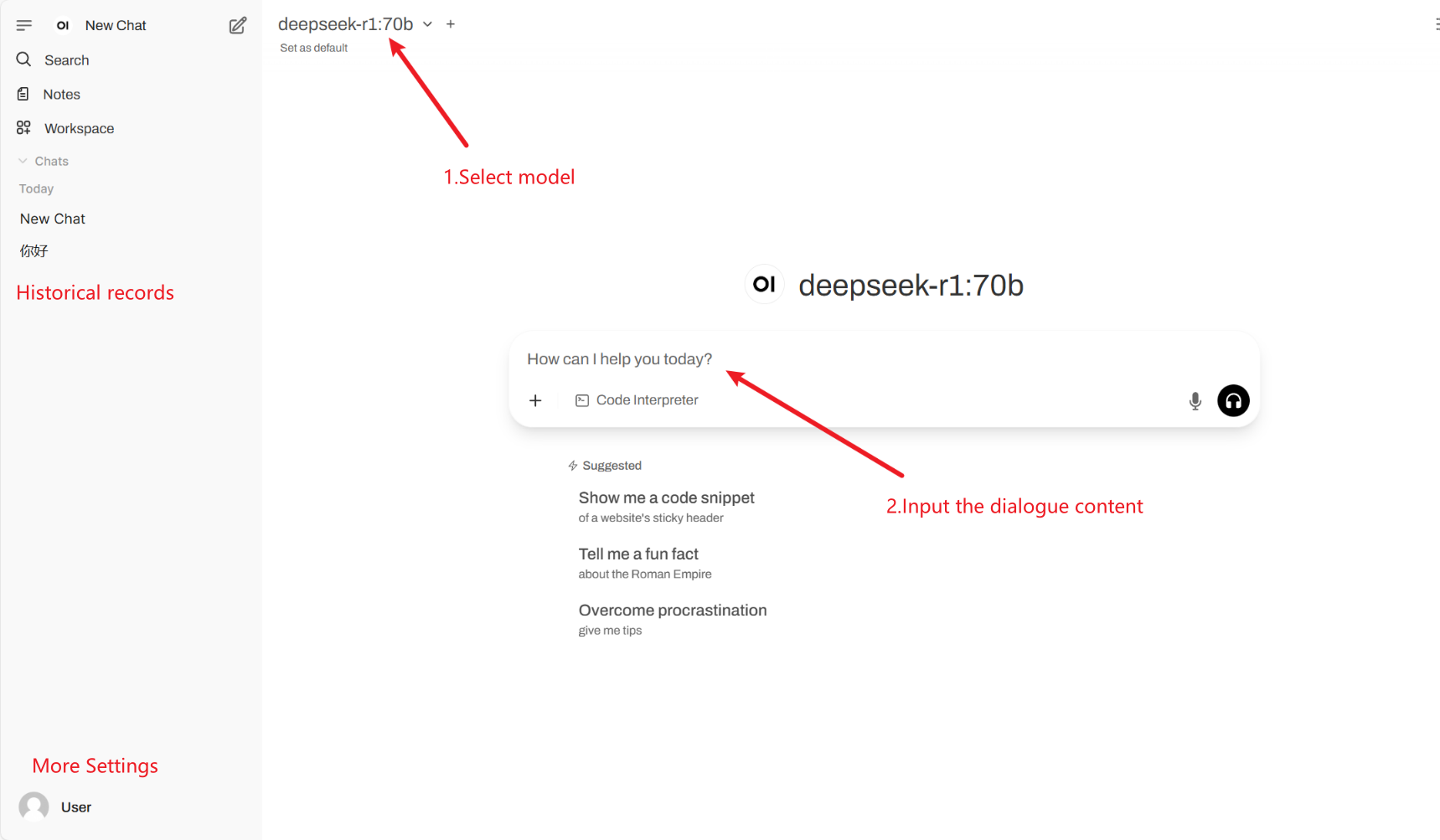

2. 进入网页后,即可与模型展开对话

常见对话设置

1. Temperature(温度)

- 控制输出的随机性,范围一般在 0.0-2.0 之间。

- 低值(如 0.1):更确定,偏向常见词汇。

- 高值(如 1.5):更随机,可能生成更有创意但不稳定的内容。

2. Top-k Sampling(Top-k 采样)

- 只从概率最高的 k 个 词中采样,排除低概率词汇。

- k 值小(如 10):更确定,减少偶然性。

- k 值大(如 50):更多样,增加创新性。

3. Top-p Sampling(Nucleus Sampling,Top-p 采样)

- 选择累计概率达到 p 的词集,不固定 k 值。

- 低值(如 0.3):更确定,减少偶然性。

- 高值(如 0.9):更多样,提升流畅度。

4. Repetition Penalty(重复惩罚)

- 控制文本重复度,通常在 1.0-2.0 之间。

- 值高(如 1.5):减少重复,提升可读性。

- 值低(如 1.0):无惩罚,可能导致模型重复词句。

5. Max Tokens(最大生成长度)

- 限制模型最多生成的 token 数,避免超长输出。

- 典型范围:50-4096(依赖具体模型)。

引用

@misc{deepseekai2025deepseekr1incentivizingreasoningcapability,

title={DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning},

author={DeepSeek-AI},

year={2025},

eprint={2501.12948},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2501.12948},

}