Command Palette

Search for a command to run...

一键部署浦科化学大模型 ChemLLM-7B-chat Demo

教程简介

该教程为 ChemLLM-7B-Chat 一键部署 Demo,只需克隆并启动该容器,直接复制生成的 API 地址,即可对模型进行推理体验。

ChemLLM-7B-Chat 是上海人工智能实验室(上海 AI 实验室)于 2024 年开源的首个用于化学和分子科学的开源大型语言模型「浦科化学 (ChemLLM)」,基于 InternLM-2 构建。相关论文成果为 ChemLLM: A Chemical Large Language Model 。

依托书生·浦语 2.0 基座模型优秀的多语言能力,浦科化学在经过专业化学知识训练后,还具备了优秀的化学专业中英文翻译能力,可帮助化学研究者跨越语言障碍,准确地翻译化学文献中的专有名词,获取更多的化学知识。

此外,研究团队还开源了 ChemData700K 数据集、 ChemPref-10K 的中英文版本数据集、 C-MHChem 数据集和 ChemBench4K 化学能力评测基准数据集。

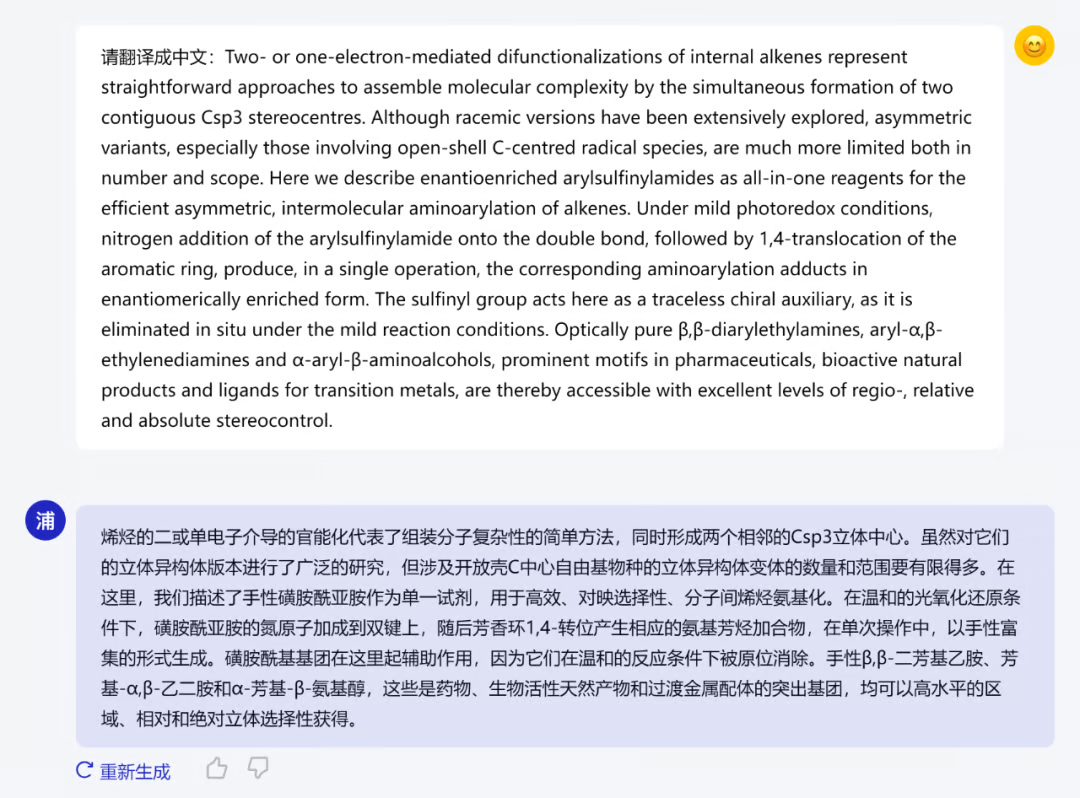

下图展示了浦科化学翻译的一篇 2024 年 1 月 16 日发表在《自然·化学》杂志上论文的摘要。

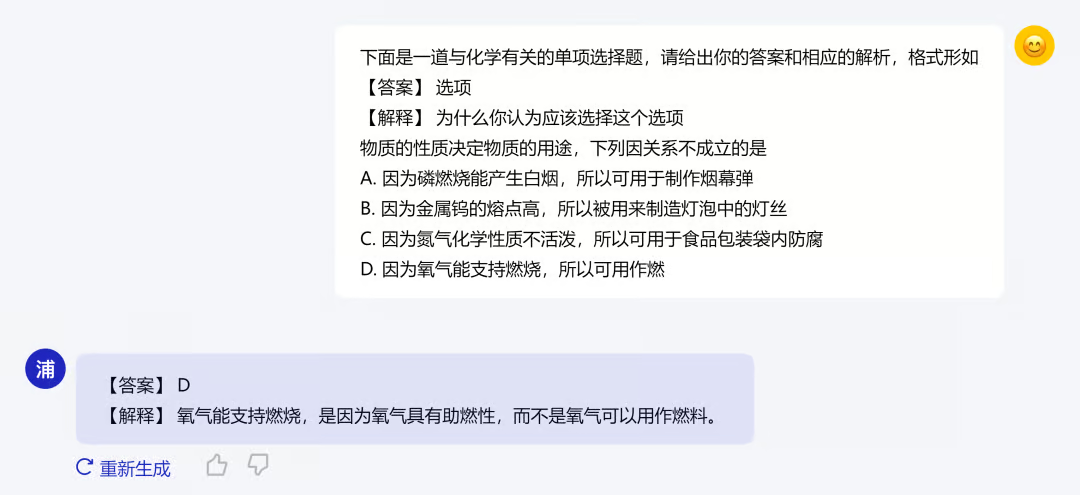

在专业化学知识训练之外,浦科化学也进行了初高中知识的学习。在回答初高中化学题目时,不仅能给出答案,还能给出具体的解释,下图展示了例子:

部署推理步骤

本教程已经将模型与环境部署完毕,大家可根据教程指引直接使用大模型进行推理对话。具体教程如下:

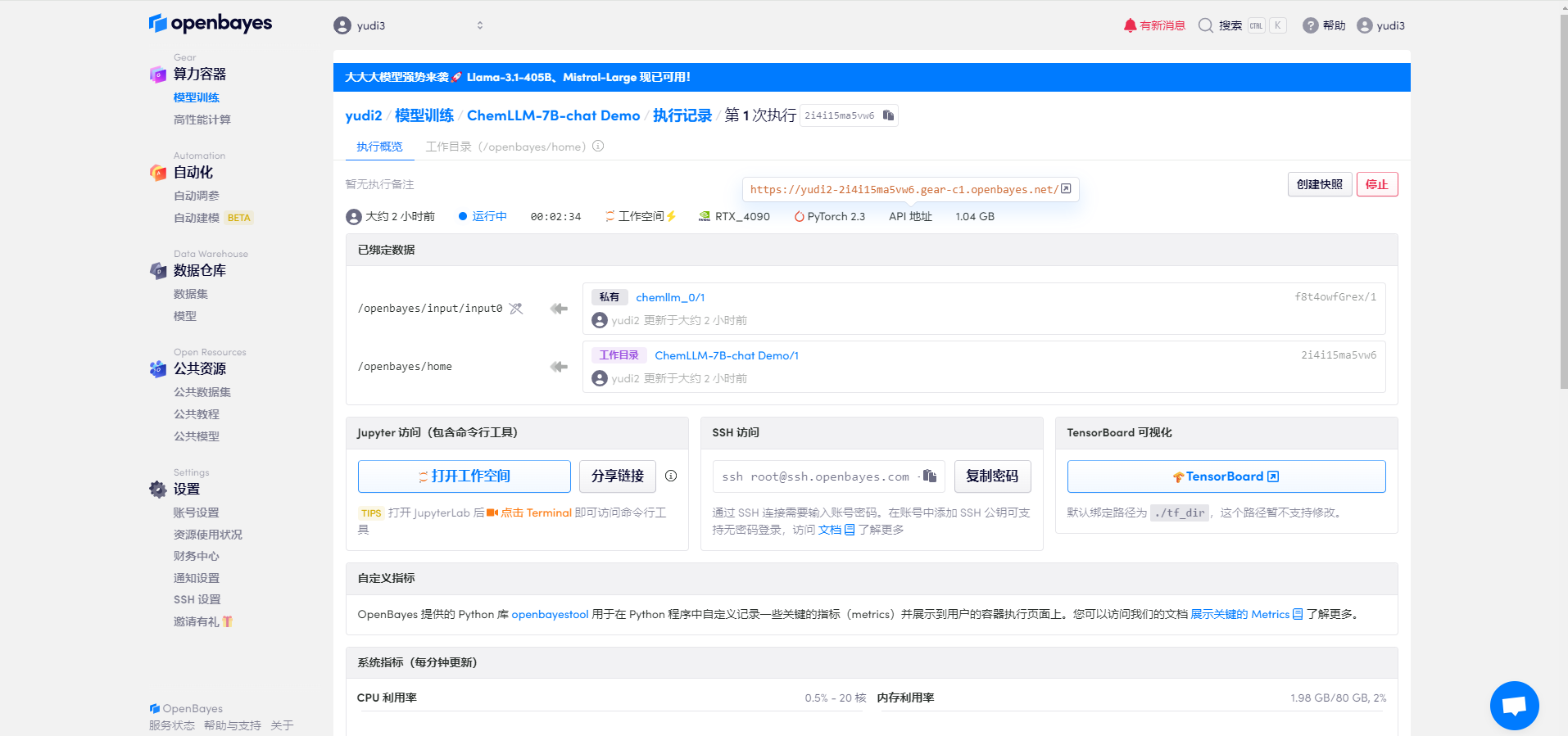

1. 模型配置

待资源配置后启动容器,点击 API 地址处的连接进入 Demo 界面(由于容器启动成功后需要加载模型,所以需要等待约半分钟即可打开网页)

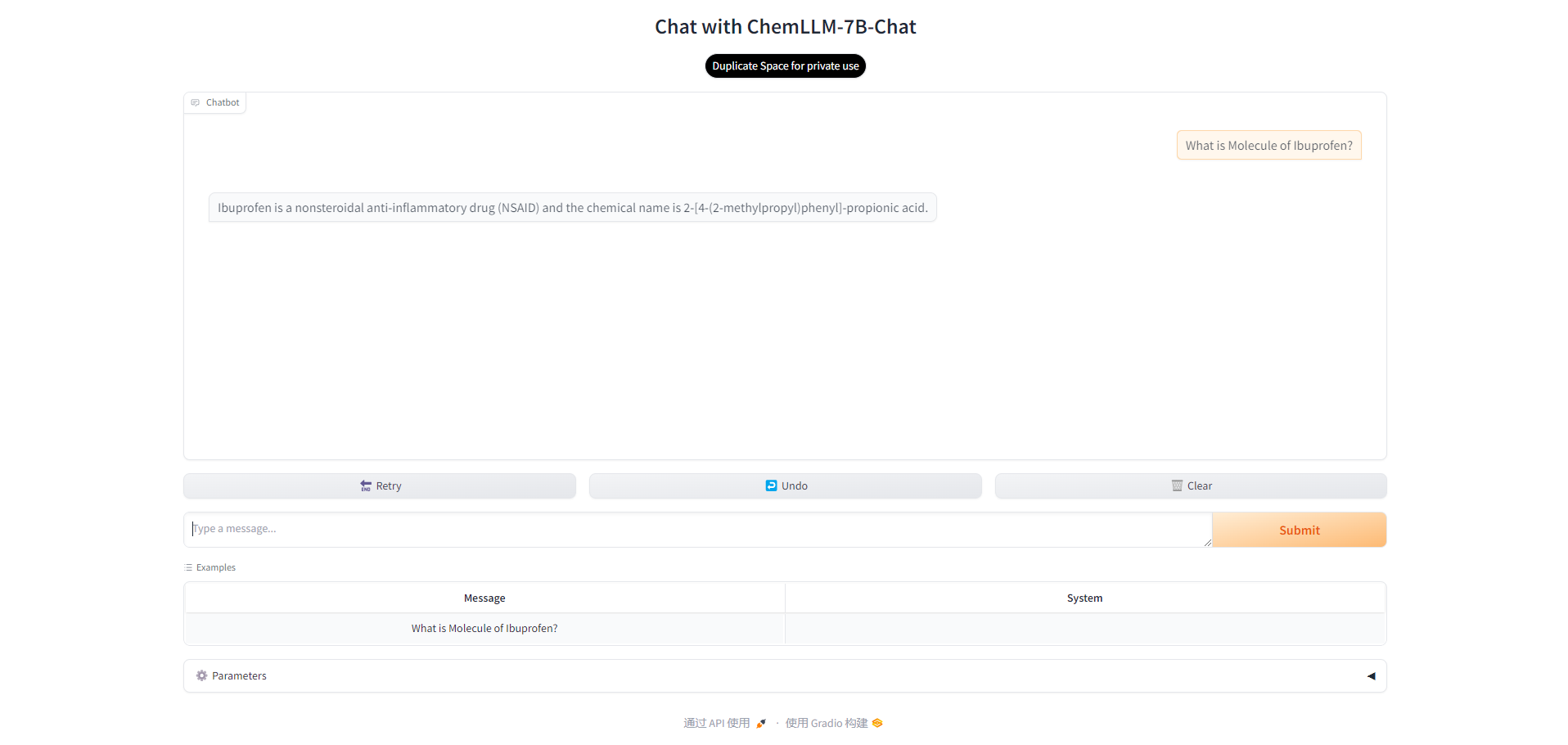

2. 打开界面

稍等片刻后可以看到模型的界面,此时就可以与模型对话了。可以输入示例的问题,也可以输入自己想要提问的问题。

3. 参数调整

其中模型中还有多个可供调整的参数。其中:

- Temperature:用来调节生成文本的随机性。值越低,模型生成的文本越倾向于选择概率最高的词,结果更可预测;值越高,模型越倾向于探索概率较低的词,生成的文本更多样化但可能包含更多错误。

- Max New Tokens:指定了模型生成文本时可以生成的最大词数。通过限制生成的词数,可以控制输出的长度,防止生成过长或过短的文本。

可以根据自己的需求来调整参数。