Command Palette

Search for a command to run...

Kimi-VL 技术报告

Kimi-VL 技术报告

摘要

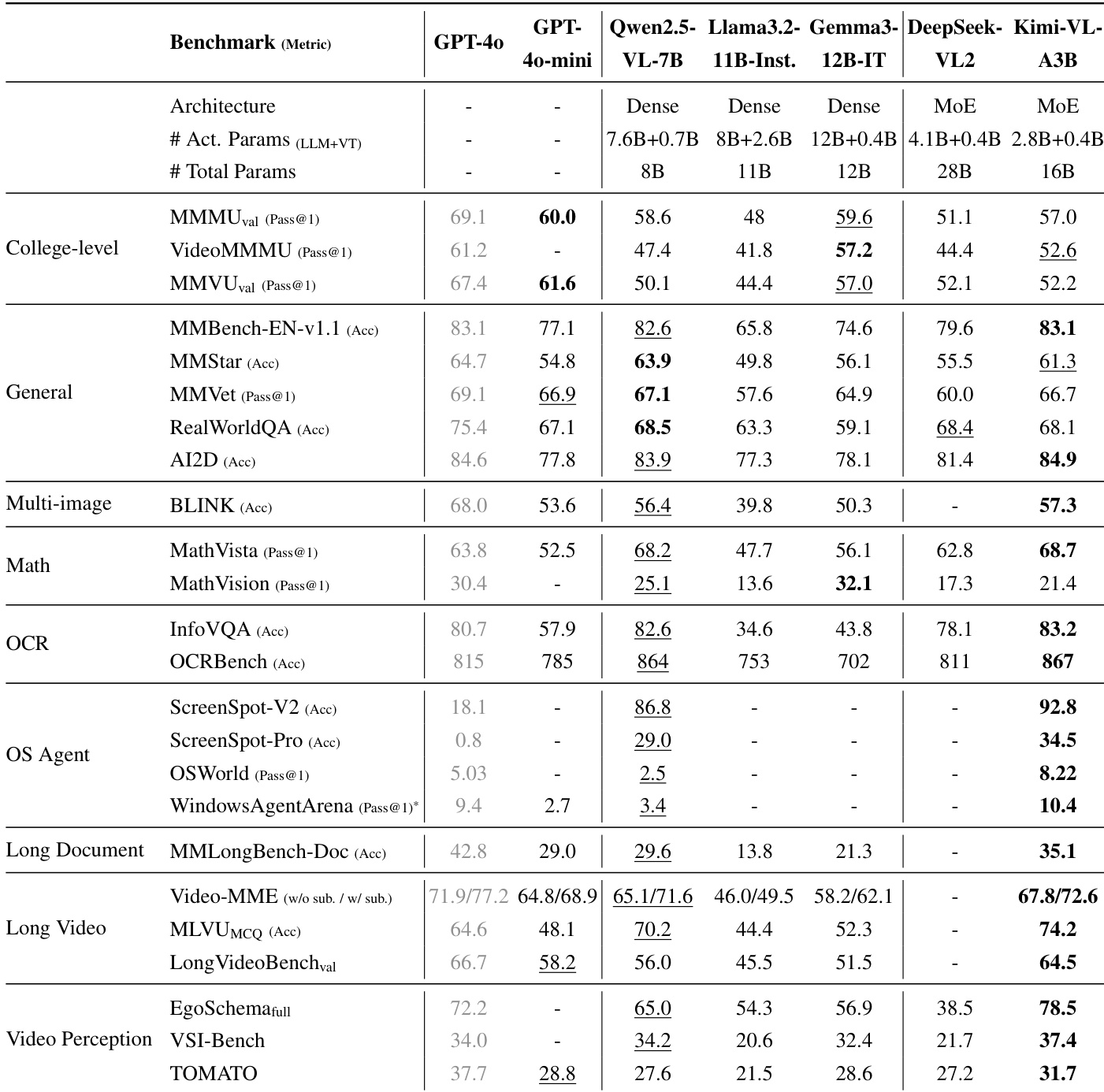

我们提出Kimi-VL,这是一个高效开源的专家混合(Mixture-of-Experts, MoE)视觉语言模型(Vision-Language Model, VLM),具备先进的多模态推理能力、长上下文理解能力以及强大的智能体(agent)性能,同时其语言解码器仅激活28亿参数(Kimi-VL-A3B)。Kimi-VL在多个挑战性领域展现出卓越性能:作为通用型VLM,它在多轮交互式智能体任务(如OSWorld)中表现优异,达到领先模型水平;同时在多样化的高难度视觉语言任务中也展现出显著能力,涵盖大学水平的图像与视频理解、光学字符识别(OCR)、数学推理以及多图像理解等。在对比评估中,Kimi-VL在多项指标上有效媲美当前最先进的高效VLM模型,如GPT-4o-mini、Qwen2.5-VL-7B和Gemma-3-12B-IT,并在多个关键领域超越GPT-4o的表现。此外,Kimi-VL在处理长上下文方面亦取得显著进展,具备清晰的感知能力。其支持长达128K的扩展上下文窗口,能够高效处理各类长序列输入,在LongVideoBench上取得64.5分,在MMLongBench-Doc上达到35.1分,表现优异。其原生高分辨率视觉编码器MoonViT使模型能够感知并理解超高清视觉输入,在InfoVQA任务中取得83.2分,在ScreenSpot-Pro任务中达到34.5分,同时在常规任务中保持较低的计算开销。基于Kimi-VL,我们进一步推出了具备长思维链能力的进阶版本:Kimi-VL-Thinking-2506。该模型通过长链式思维(Chain-of-Thought, CoT)监督微调(SFT)与强化学习(RL)训练而成,在长周期推理任务中展现出强大能力(MMMU任务达64.0分,MMMU-Pro达46.3分,MathVision达56.9分,MathVista达80.1分,VideoMMMU达65.2分),同时保持了出色的通用性能。相关代码与模型已公开,欢迎访问GitHub获取:https://github.com/MoonshotAI/Kimi-VL。

一句话总结

作者提出Kimi-VL,一个高效的开源专家混合(Mixture-of-Experts)视觉语言模型,其语言解码器仅激活28亿参数,搭配原生分辨率MoonViT视觉编码器,实现强大的多模态推理、长达128K的长上下文理解以及高分辨率视觉感知,在关键领域超越GPT-4o的同时保持低计算成本;其进阶版长思维模型Kimi-VL-Thinking-2506通过链式思维微调与强化学习,仅用约30亿激活参数即在长周期推理任务中达到最先进水平。

主要贡献

- Kimi-VL引入了一种高效的开源专家混合(MoE)视觉语言模型,其语言解码器仅激活28亿参数,实现强大的多模态推理、高达128K token的长上下文理解以及先进的智能体能力,同时在常规任务中保持低计算成本。

- 该模型采用原生分辨率视觉编码器MoonViT,在高分辨率视觉任务上达到最先进性能,如InfoVQA(83.2)和ScreenSpot-Pro(34.5),在LongVideoBench(64.5)和MMLongBench-Doc(35.1)等基准上超越多个领先高效VLM。

- Kimi-VL-Thinking-2506通过长链式思维监督微调与强化学习增强,实现在复杂基准上的顶级推理性能,包括MathVista(80.1)和VideoMMMU(65.2),证明仅约30亿激活参数的模型即可在长周期多模态推理中媲美更大模型。

引言

作者采用专家混合(MoE)架构构建Kimi-VL,一个开源视觉语言模型,实现强大的多模态推理、长上下文理解与智能体能力——这些是现实世界AI助手必须处理复杂视觉与语言输入的关键进步。此前开源VLM在效率与推理能力方面落后,常依赖密集模型,上下文有限,且缺乏对长链式思维(CoT)推理的支持。Kimi-VL通过28亿参数激活的语言解码器与原生分辨率MoonViT视觉编码器克服了这些局限,实现对超高清图像与长文本输入(最高达128K token)的高保真感知与高效处理。该模型在多种基准上表现优异,涵盖大学级推理、OCR、多图像理解与长视频分析,在多个领域超越更大模型。作者进一步提出Kimi-VL-Thinking-2506,一种通过CoT微调与强化学习增强的长思维变体,在保持低计算成本的同时,于复杂推理任务中达到最先进水平。

数据集

- 数据集由六大主要多模态数据类别构成:图像描述、图文交错、OCR、知识、视频与智能体数据,辅以高质量纯文本语料库Moonlight(Liu et al. 2025a)。

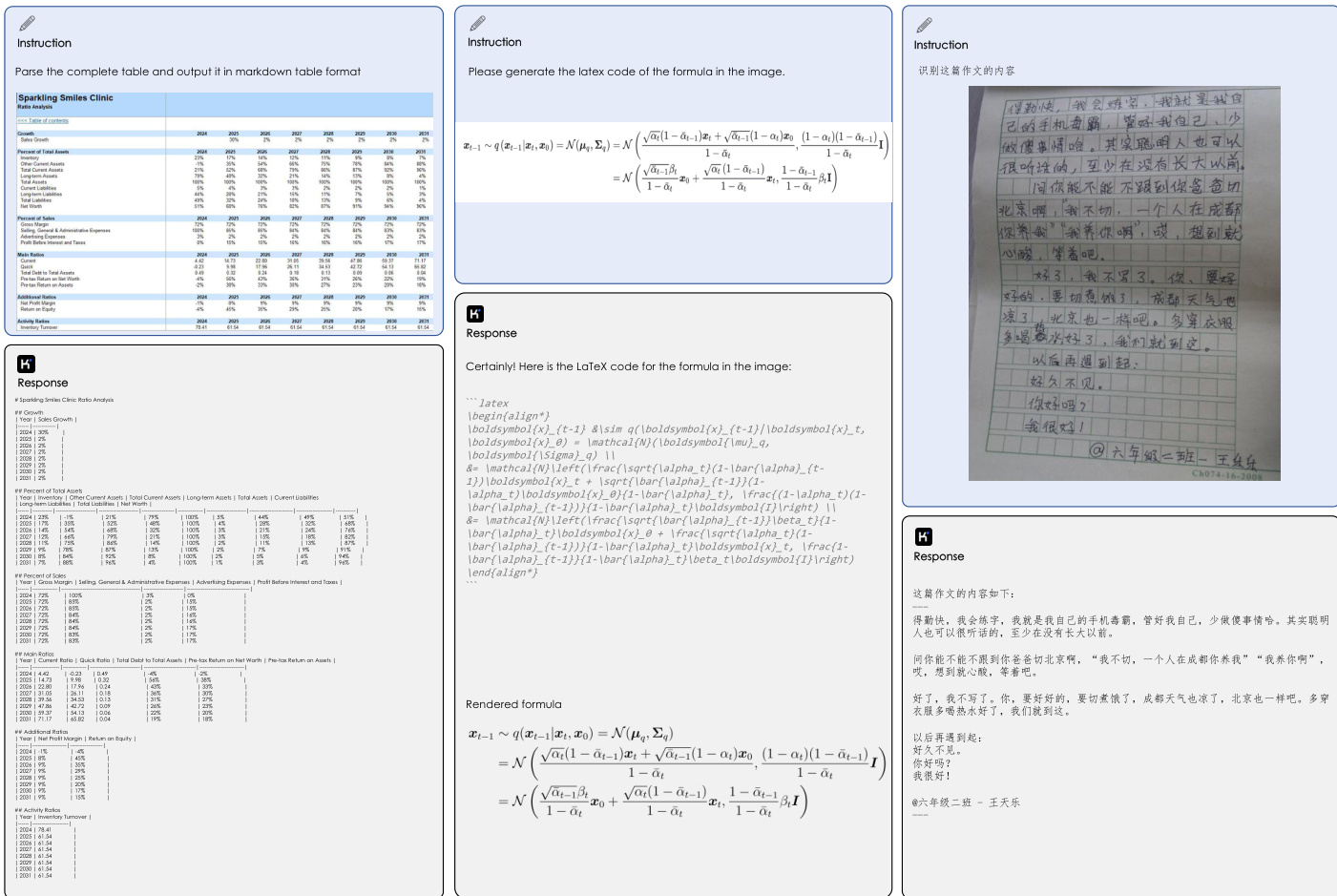

- 图像描述数据包含英文与中文的开源及内部数据集,严格限制合成数据以防止幻觉;经过过滤、去重与分辨率变化处理,确保图文对齐与视觉塔鲁棒性。

- 图文交错数据来自开源数据集与内部资料(如教科书、网页),合成数据用于知识增强;数据重排序流水线确保图像-文本序列正确保留。

- OCR数据涵盖单页与多页文档,覆盖多语言、密集文本、手写体与复杂布局(如表格、图表、mermaid图);通过旋转、扭曲、噪声等广泛增强提升鲁棒性,内部数据支持长文档理解。

- 知识数据源自教科书、研究论文与精选来源,经版面解析与OCR处理;标准化分类体系确保各领域均衡覆盖,并额外设计流水线从信息图中提取纯文本内容。

- 智能体数据通过启发式方法在虚拟机环境中收集,涵盖桌面、移动端与网页平台的截图与操作日志;包含人类标注的多步轨迹与链式思维推理,用于训练规划与定位能力。

- 视频数据来自开源与内部来源,覆盖多样时长、场景与任务;长视频经密集描述流水线处理,合成描述比例受限以降低幻觉风险。

- 纯文本预训练语料库(Moonlight)涵盖英文、中文、代码、数学/推理与知识领域,采用领域特定过滤与质量验证;采样比例经实证评估优化,以平衡知识深度与泛化能力。

- 训练期间,作者采用数据驱动的混合策略:高性能子集被上采样,而多样文档类型以均衡比例保留,以维持模型泛化能力。

- 指令微调阶段通过人工标注创建种子数据集,再利用模型生成响应并经标注者排序与优化扩展;推理任务采用拒绝采样结合奖励模型,过滤低质量思维链。

- 推理数据通过强大长CoT模型(Kimi k1.5)的拒绝采样流水线合成,生成数学、科学与VQA任务的多步推理轨迹,并通过模型评估与规则奖励双重过滤。

- 模型在全面基准集上进行评估:MM-MMU、MMBench、MMStar、MMVet、RealWorldQA、AI2D、MathVision、MathVista、BLINK、InfoVQA、OCRbench、VideoMMMU、MMVU、Video-MME、MLVU、LongVideoBench、EgoSchema、VSI-Bench与TOMATO,覆盖感知、推理、OCR、视频理解与长上下文任务。

- 智能体评估使用ScreenSpot V2、ScreenSpot Pro、OSWorld与WindowsAgentArena,评估GUI定位、任务规划与在真实操作系统(Ubuntu、Windows、macOS)中的表现,涵盖交互式应用级任务。

方法

Kimi-VL模型架构由三个核心组件构成:原生分辨率视觉编码器、MLP投影器与专家混合(MoE)语言模型。视觉编码器名为MoonViT,设计用于在不进行复杂子图像拆分与拼接操作的情况下处理图像的原生分辨率。这一目标通过“打包”方法实现:图像被划分为块,展平并连接为一维序列。该方法使MoonViT能够复用语言模型的核心计算算子与优化技术(如FlashAttention支持的变长序列注意力),从而在不同分辨率图像上保持高训练吞吐量。

如图所示,MoonViT可直接处理不同分辨率的图像,包括小图、长视频与细粒度场景。MoonViT提取的连续图像特征随后输入MLP投影器。该投影器由两层MLP构成,首先通过像素洗牌操作压缩图像特征的空间维度,再投影至语言模型嵌入维度。生成的特征随后输入MoE语言模型进行进一步处理。

Kimi-VL的语言模型组件基于Moonlight模型,一种具有28亿激活参数与160亿总参数的MoE架构,结构与DeepSeek-V3相似。模型从Moonlight预训练阶段的中间检查点初始化,该阶段已处理5.2万亿纯文本数据,支持8192 token上下文长度。初始化后,模型在多模态与纯文本数据组合上进行联合预训练,总计2.3万亿token。

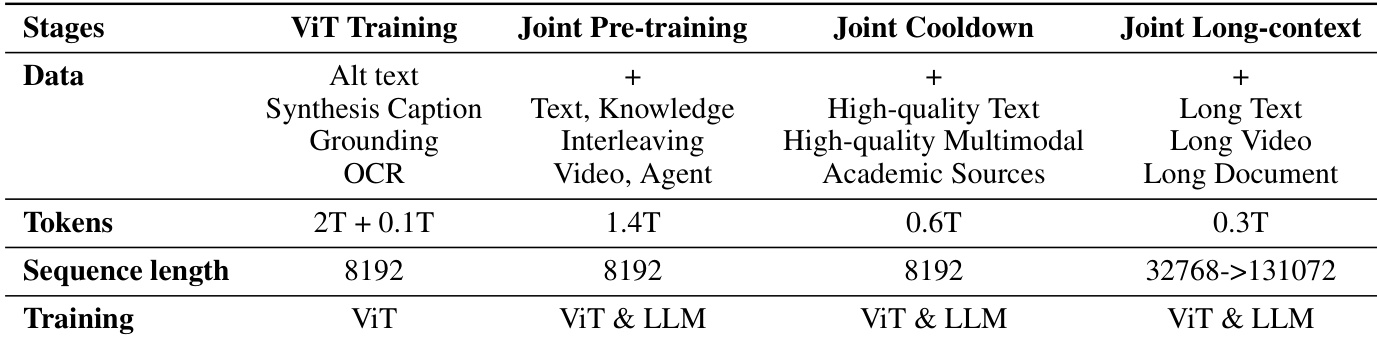

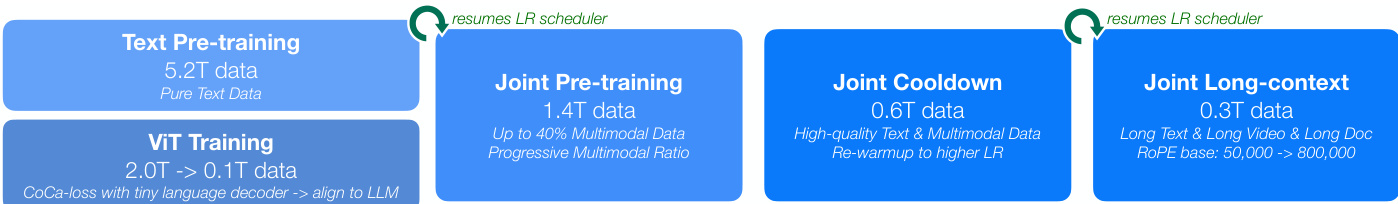

Kimi-VL的预训练过程分为多个阶段,初始纯文本预训练后共消耗4.4万亿token。为保持文本能力,所有更新语言模型的阶段均以联合训练形式进行。训练始于5.2万亿纯文本数据的文本预训练,随后是1.4万亿token的多模态联合预训练。接着是0.6万亿token的高质量文本与多模态数据联合冷却阶段,最后是0.3万亿token的长文本、长视频与长文档数据联合长上下文阶段。每个阶段均从上一阶段的学率调度器继续,确保平滑过渡。

预训练完成后,Kimi-VL进入一系列后训练阶段。第一阶段为联合监督微调(SFT),模型使用基于指令的数据进行微调,以增强其遵循指令与对话能力。该阶段使用纯文本与视觉语言SFT数据混合,仅对答案与特殊标记施加监督。模型在32K token序列长度下训练一epoch,随后在128K token长度下再训练一epoch,学率调度器先衰减后重新预热。

第二阶段为长CoT监督微调,采用小规模高质量长CoT推理路径数据集(涵盖文本与图像输入)。该数据集旨在封装规划、评估、反思与探索等关键认知过程。在该数据集上的轻量级SFT使模型内化这些多模态推理策略,从而生成更详尽且逻辑连贯的响应。

最终阶段为强化学习(RL),进一步提升模型推理能力。RL算法为在线策略镜像下降的变体,迭代优化策略模型以提高问题解决准确率。目标函数通过相对熵正则化以稳定策略更新。每次训练迭代采样问题批次,模型参数通过策略梯度更新。为提升效率,长度奖励惩罚过长响应,课程学习与优先采样策略聚焦于最具教学价值的示例。

实验

- 预训练阶段:Kimi-VL经历四个阶段——ViT训练(2万亿token)、对齐(0.1万亿token)、联合预训练(1.4万亿token)与联合冷却(数据增强含合成内容)。最终长上下文激活阶段将上下文长度扩展至128K token,长数据比例为25%,实现稳健的长文本理解。

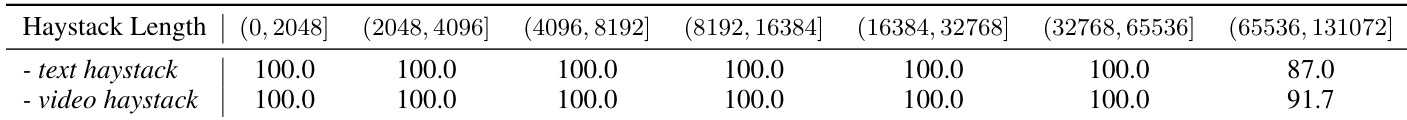

- 针对“针在 haystack 中”(NIAH)测试:在长达128K token的haystack中实现高召回准确率,验证强大的长上下文检索能力。

- 在MMMU验证集上:达到57.0%,优于DeepSeek-VL2(51.1%),与Qwen2.5-VL-7B(58.6%)相当。

- 在MathVista上:得分68.7%,超越GPT-4o(63.8%)与Qwen2.5-VL-7B(68.2%),展现强大的视觉数学推理能力。

- 在OCRBench上:达到86.7%,优于GPT-4o-mini(78.5%)与DeepSeek-VL2(81.1%),凸显卓越的OCR与文档理解能力。

- 在MMBench-EN-v1.1上:达到83.1%,超越所有高效VLM,并与GPT-4o持平。

- 在长文本内容上:在MMLongBench-Doc上得分为35.1%(优于GPT-4o-mini与Qwen2.5-VL-7B),Video-MME(带字幕)得分为72.6%,MLVU MCQ得分为74.2%,展现强大的长文档与视频理解能力。

- 在智能体任务上:在OSWorld上得分为8.22%,在WindowsAgentArena上得分为10.4%,超越GPT-4o(5.03%与9.4%)。

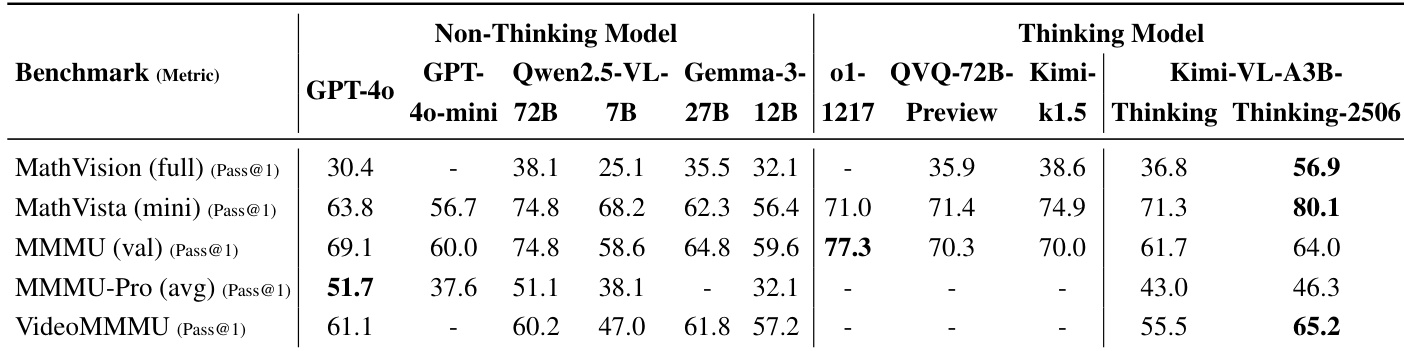

- Kimi-VL-Thinking:在MathVista上提升2.6%,在MMMU上提升4.7%,在MathVision上提升15.4%;在MathVista上达71.3%,在MMMU上达61.7%,以仅30亿激活参数超越GPT-4o与更大模型。

- Kimi-VL-A3B-Thinking-2506:在MathVision上达56.9%(较基础思维模型提升20.1%),MathVista达80.1%,MMMU-Pro达46.3%,MMLongBench-Doc达42.1%;平均输出token减少20%,在视觉、视频与长上下文任务中保持强性能的同时提升效率。

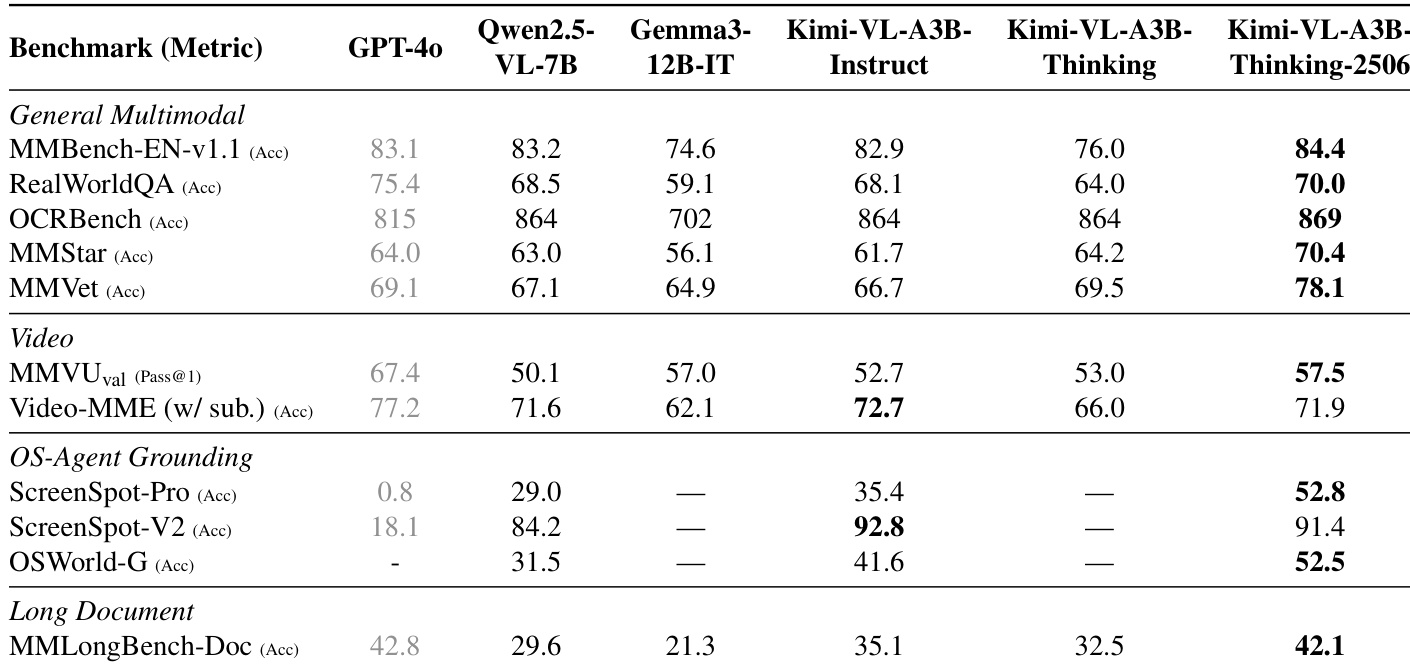

作者使用Kimi-VL-A3B-Thinking-2506在多个多模态基准上实现最先进结果,在多个类别中超越更大模型。该模型在通用视觉理解、数学推理与长文本内容理解方面表现强劲,同时通过减少输出token长度提升效率。

结果表明,Kimi-VL-A3B-Thinking-2506在大多数通用多模态与视频基准上达到最高准确率,超越其他模型(包括GPT-4o与Qwen2.5-VL-7B),在OS智能体定位与长文档任务中也表现强劲。该模型在通用视觉语言任务中保持竞争力,并通过减少输出token长度优于前代模型。

结果表明,Kimi-VL-A3B-Thinking-2506在推理基准上达到最先进性能,超越其他模型(包括GPT-4o与QVQ-72B),在准确率上显著提升,且相比前代模型消耗更少token。该模型同时保持强大的通用多模态理解能力,在各类视觉语言任务中表现优异。

结果表明,Kimi-VL在长达128K token的文本与视频haystack中均保持高召回准确率,所有文本haystack长度下性能维持在100.0%,最长视频haystack下为91.7%。模型展现出强大的长上下文理解能力,体现在其能从不同长度的haystack中检索“针”,包括最大131,072 token的序列。

作者采用四阶段预训练流程构建Kimi-VL,始于使用SigLIP与描述生成损失联合训练的独立ViT阶段,随后是联合预训练、冷却与长上下文激活阶段,逐步整合语言与多模态能力。结果表明,最终长上下文阶段模型可支持高达131,072 token的序列长度,数据构成逐渐增加长文本、视频与文档输入,以实现稳健的长上下文理解。