By 超神经

围棋也下了,DOTA2 也玩了,现在轮到让 AI 做智商测试的推理题了。

受传统智力测试的启发,DeepMind 团队最近发起了一场测试 AI 推理能力的实验,结果显示,AI 不仅可以理解一些抽象概念,还能推理出新的概念。

oops ,AI 又加一分~

不下棋了,用推理题考察 AI

在今年 7 月份瑞典斯德哥尔摩召开的「国际机器学习会议」上,DeepMind 发表了一篇论文,称可以像测试人类智商一样,通过一系列抽象元素,测量神经网络的推理能力。

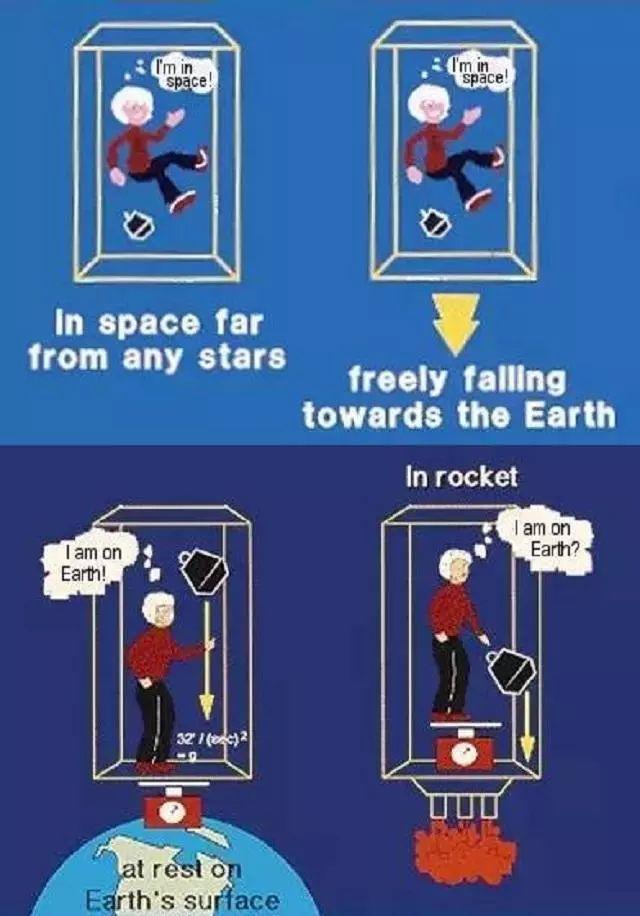

研究人员将这种抽象推理能力定义为,在概念层面检测模式和解决问题。抽象推理是人类智力的象征之一,一个著名的例子是爱因斯坦通过电梯思想实验推理出广义相对论。

在这个实验中,爱因斯坦推理出在均匀加速度下下落的观察者和在均匀重力场中的观察者之间存在一个等价关系。

正是这种将这两个抽象概念联系起来的能力,使他得出广义相对论,并基于此提出时空曲率,这种抽象能力就是人类智力的特征之一。

备注:在《狭义与广义相对论浅说》中爱因斯坦打了个比方,在一个封闭的箱子里有一个人,他看不到外面,在不受外界引力的情况下,有一个未知生物以 9.8 m/s^2 的加速度向上拉这个箱子,于是箱子里的人的感受跟这个箱子静止在地面上是一样的,如果他手里拿一个球,他是无法区分这个重量是因为地球引力产生的还是因为向上 g 的加速度产生的,所以引力质量等于惯性质量。

AI 除了处理数据也具备抽象能力

那么,AI 是否也具备通过一些抽象元素,推理出新概念的能力呢?DeepMind 团队的实验证明,答案是肯定的。

团队最初打算依靠训练素材的形状、位置和线条颜色等属性来测试 AI 的推理能力,但结果并不理想,很难准确反映 AI 的推理能力。

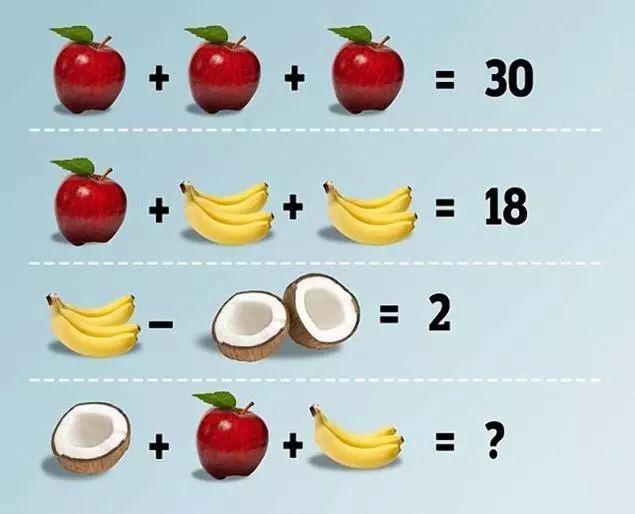

常见的智力测试题题型

主要原因在于如果准备的实验素材太多,或者过于具体,神经网络依靠强大的学习能力,会由于发现其中的一般性规律,而拒绝推理,人类也会如此。

对此,研究团队的解决方案是构建一个问题生成器。这个问题生成器是由一系列抽象元素创建的问题集组成,专门用来来训练和测试 AI 的推理能力,这些抽象元素包括关系(例如事物的发展)和属性(例如颜色和大小)等。

大多数 AI 模型在测试中表现良好,其中一些模型的性能甚至能达到 75% 。研究人员发现问题集的精确度与 AI 推断抽象概念的能力相关性很强,可以通过调节问题集的属性来提高其推理能力。

图像推理题难倒了大部分 AI

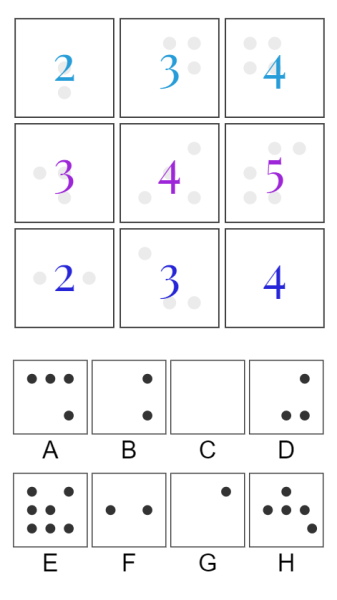

相比之下,视觉推理的难度要更高,需要 AI 自己根据图像所展现出的元素,创建问题集。不过,DeepMind 团队称已经有部分 AI 模型可以进行视觉推理。

为了实现视觉推理,这些模型需要从图像的原始像素中归纳和检验出抽象概念,就像逻辑运算和算术级数,并将这些概念运用到从来没有观察过的对象身上。

图注:DeepMind 团队设计的机器学习模型所完成的一个视觉推理测试

整个测试证明,神经网络可以让 AI 具备推理能力,但目前这种能力还存在较大局限,就算是当前最优秀的 Wild Relation Network(WReN)也无法完全解决。

AI 推理的局限

这个局限主要在于神经网络很难发现问题集之外的元素,这就导致它在推理过程中的泛化能力降低。

研究小组在博客中写到:「神经网络在某些特定条件下的推理能力很好,而当条件发生变化后,推理能力就会急速下降。另外,模型推理的成功与否也与很多因素有关,比如该模型的架构、是否经过训练等。」

若能找到一些改善模型泛化概括能力的方法,并探索出能在未来模型中使用「结构丰富,且普遍适用」的归纳偏差,或许可以解决这个局限。

不过,莫非工程师们都是抖 M ?

从围棋到 DOTA2 ,人类一次又一次的被 AI 打败,真的很有意思么?

送你们一句名人名言↓↓↓