Command Palette

Search for a command to run...

谷歌发布 MedGemma,基于 Gemma 3 构建,专攻医学文本与图像理解

近两日,Google I/O 2025 热度正盛,公司 CEO Sundar Pichai 在活动首日的主题演讲中便分享了多项创新,例如 Gemini 2.5 的全系列升级,Agent Mode 上线 Chrome,编码智能体 Jules 开启公测,Android XR 正式版亮相等等。而在一众令人眼花缭乱的重磅更新之中,还隐藏着一个面向于医疗领域的重磅开源成果——MedGemma 。

据官方介绍,MedGemma 系列模型基于 Gemma 3 构建,包含谷歌在医学文本与图像理解方面最强大的开源模型,提供 2 个版本,分别为 40 亿参数的多模态版本,以及 270 亿参数的纯文本版本。

其中,MedGemma 4B 多模态版本采用了 SigLIP 图像编码器,该编码器经过专门预训练,使用的数据涵盖去标识化的医学图像,包括胸部 X 光、皮肤病图像、眼科图像和组织病理切片。其大语言模型组件则基于多种医学数据进行训练,涵盖放射影像、组织病理图像块、眼科与皮肤科图像以及医学文本。而 MedGemma 27B 则是专门在医学文本上进行了训练,并针对推理阶段的计算进行了优化。

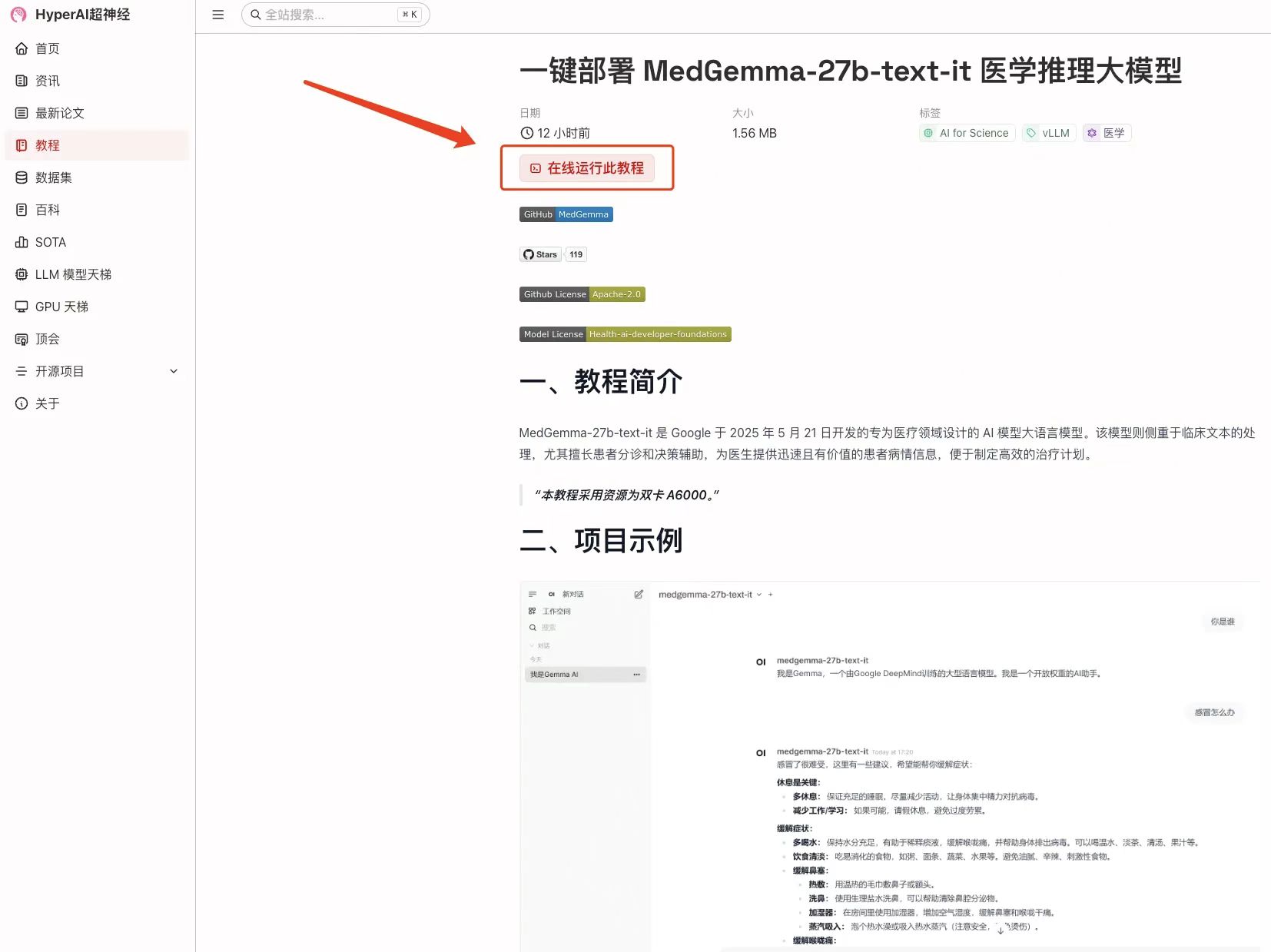

针对医学文本理解与临床推理场景,MedGemma 能够完成病人问诊、分诊、临床决策支持以及医疗文本摘要等多项任务。为了方便读者更加直观地体验 MedGemma 的强大能力,HyperAI 超神经官网的「教程」板块现已上线了「一键部署 MedGemma-27b-text-it 医学推理大模型」,快来体验 AI 医生问诊吧!

* 教程地址:https://go.hyper.ai/Urygb

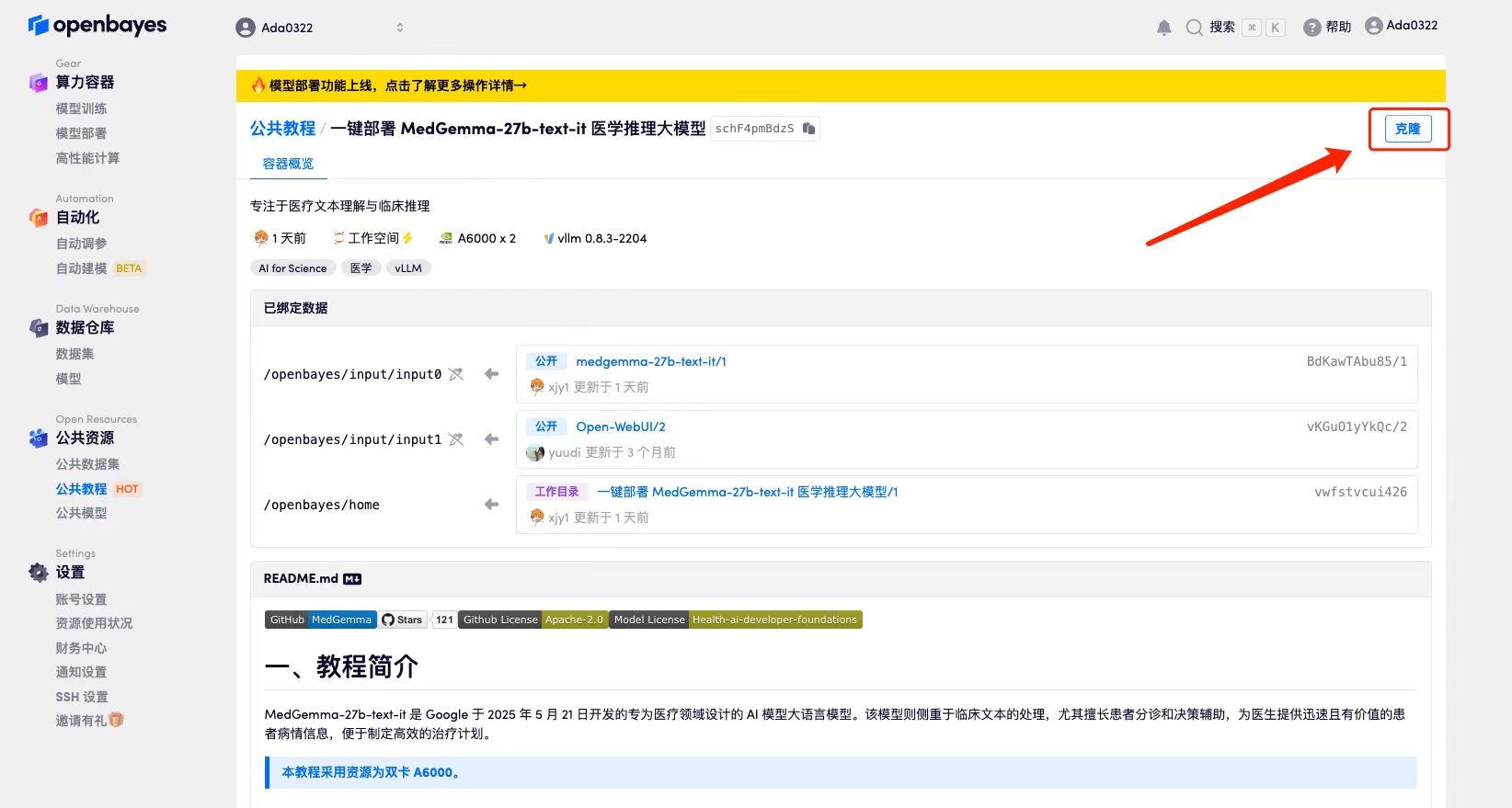

我们还为新注册用户准备了惊喜福利,使用邀请码「MedGemma」注册 OpenBayes 平台,即可获得 4 小时 RTX A6000 免费使用时长(资源有效期为 1 个月),数量有限,先到先得!

此外,官网的教程版块还上线了「vLLM+Open WebUI 部署 II-Medical-8B 医学推理大模型」,该模型基于 Qwen3-8B,通过使用特定于医疗领域的推理数据集进行监督微调,并在硬推理数据集上训练 DAPO(一种可能的优化方法)来优化模型性能。

* 教程地址:https://go.hyper.ai/8fFFY

Demo 运行

1. 进入 hyper.ai 首页后,选择「教程」页面,并选择「一键部署 MedGemma-27b-text-it 医学推理大模型」,点击「在线运行此教程」。

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

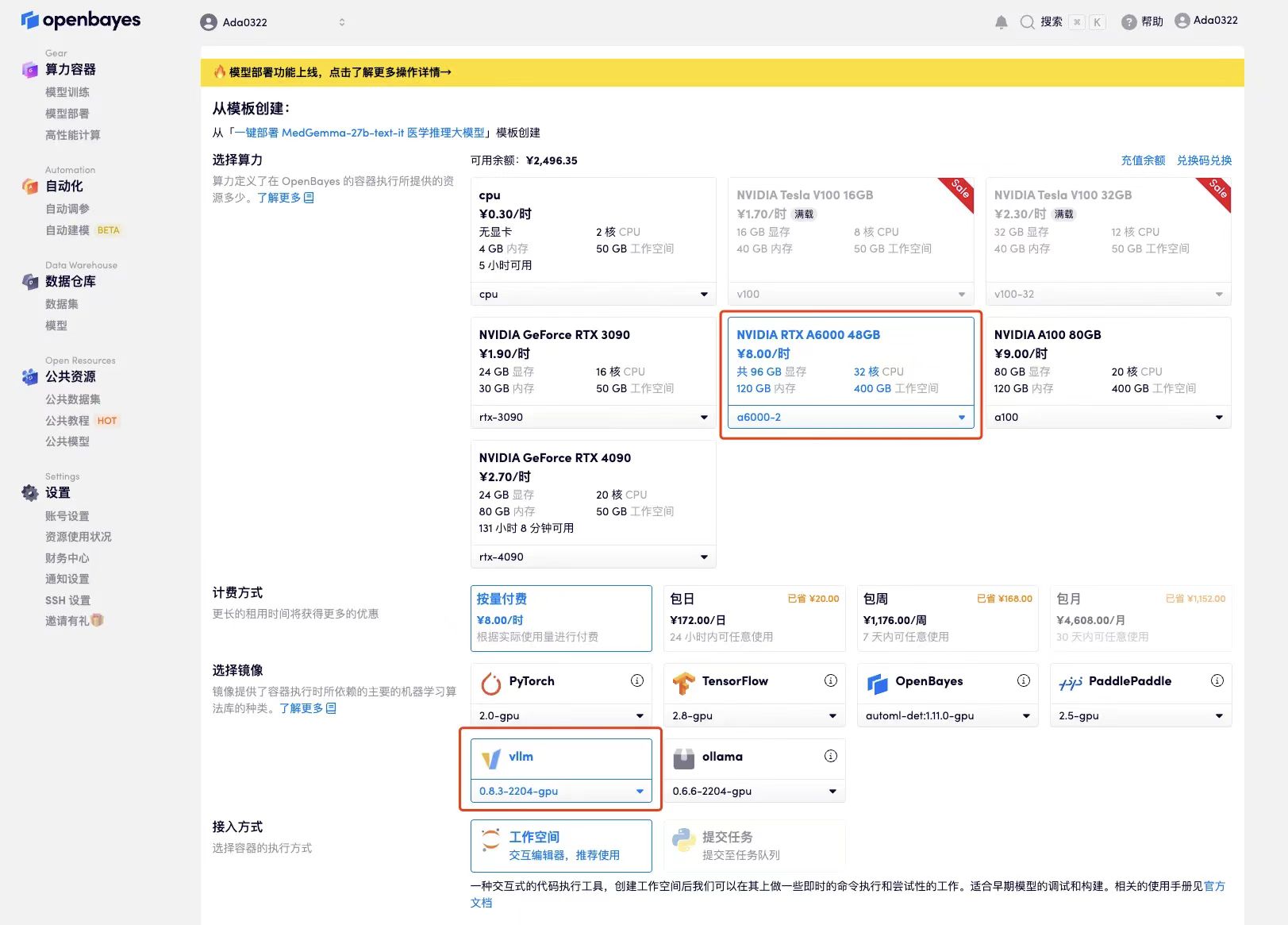

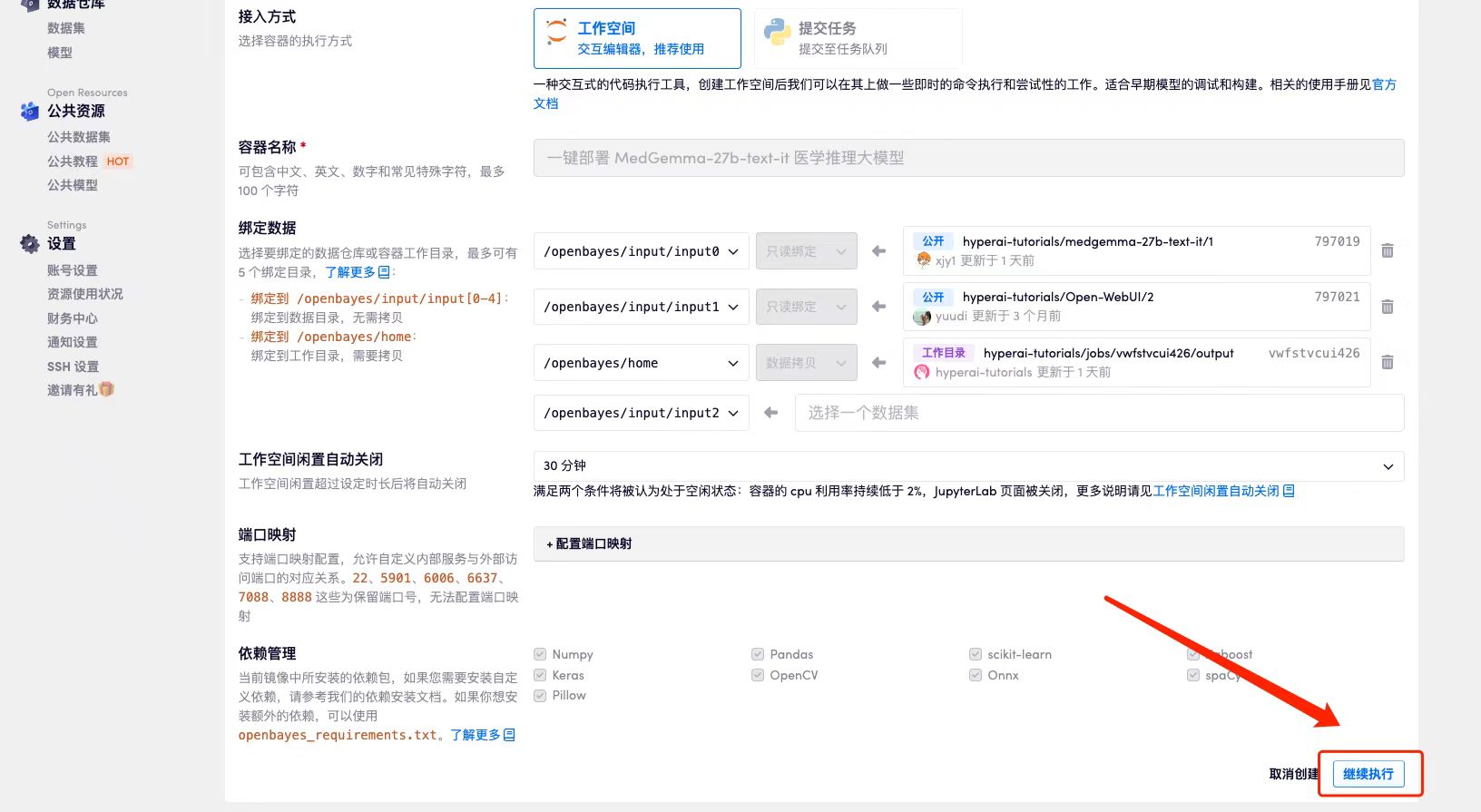

3. 选择「NVIDIA A6000 48GB」以及「vLLM」镜像,OpenBayes 平台提供了 4 种计费方式,大家可以按照需求选择「按量付费」或「包日/周/月」,点击「继续执行」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

HyperAI 超神经专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=Ada0322_NR0n

4. 等待分配资源,首次克隆需等待 2 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」旁边的跳转箭头,即可跳转至 Demo 页面。由于模型较大,需等待约 3 分钟显示 WebUI 界面,否则将显示「Bad Gateway」。请注意,用户需在实名认证后才能使用 API 地址访问功能。

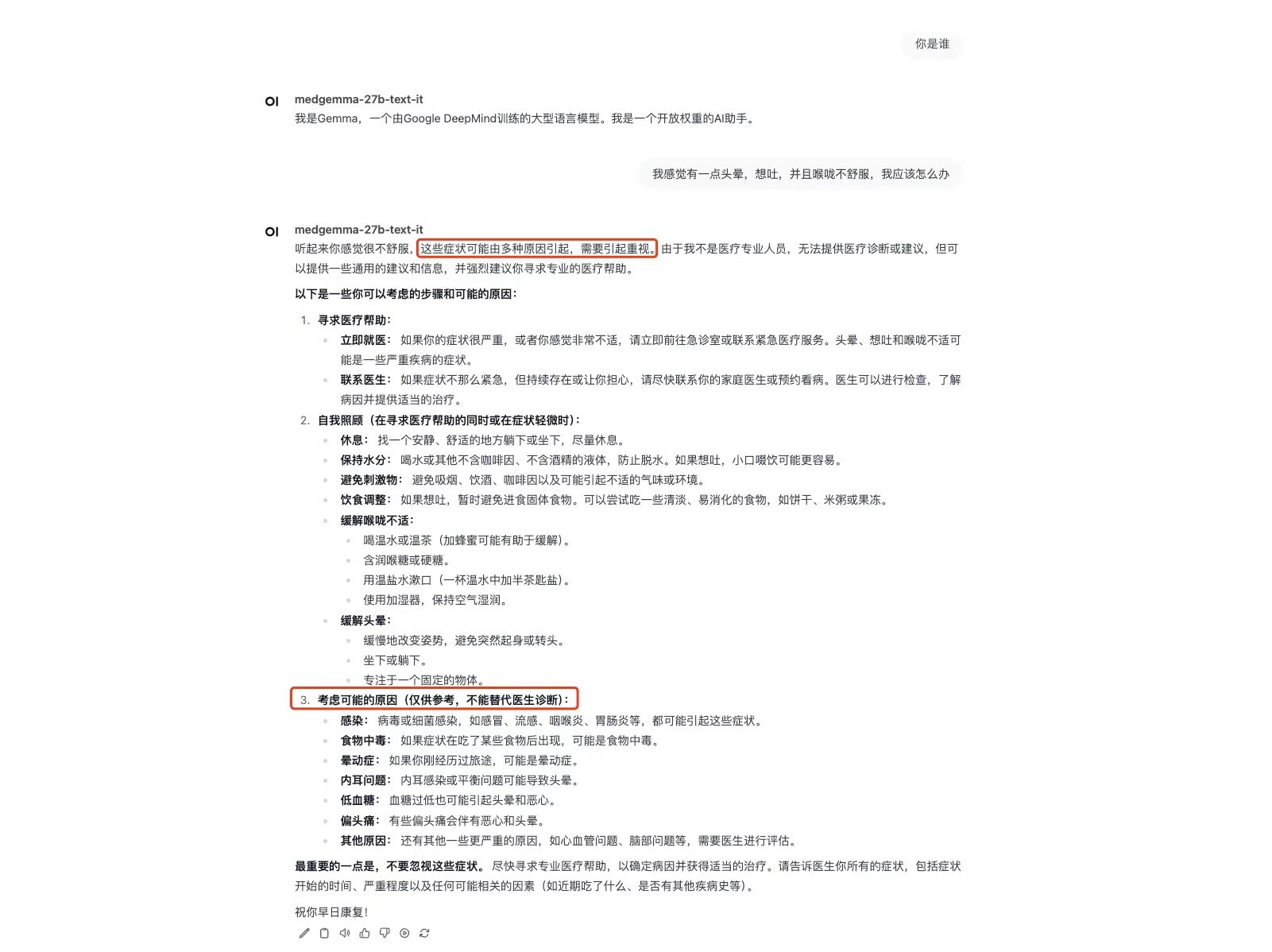

效果演示

笔者描述的症状为:「我感觉有一点头晕,想吐,并且喉咙不舒服,我应该怎么办」,可以看到 MedGemma 不仅给出了「立即就医」与「自我照顾」的不同解决办法,同时还提供了可能引发这一系列症状的病因。