Command Palette

Search for a command to run...

在线教程丨 9 秒处理一张图!In-Context Edit 高效图像编辑框架上线

现有的图像编辑方法主要面临精度与效率之间难以平衡的问题。微调方法需要大量的计算资源和优质数据集,而无需训练的技术则难以满足指令理解和编辑质量。对此,浙江大学和哈佛大学的研究团队推出了 In-Context Edit(ICEdit),一款基于指令的图像编辑框架,仅需极少的文本指令即可实现精准的图像修改,为图像处理和内容创作提供了更多可能性。

In-Context Edit 通过以下 3 个关键贡献解决了现有技术的局限性,即语境编辑框架、 LoRA-MoE 混合调优策略以及早期滤波器推理时间缩放方法。与以往方法相比,其仅使用 1% 的可训练参数(200M)和 0.1% 的训练数据(50k),却展现出更出色的泛化能力,能够胜任多样化的图像编辑任务。同时,与 Gemini 、 GPT-4o 相比,这款开源神器不仅成本更低、速度更快(处理一张图像大约只需 9 秒),同时性能也非常强大。

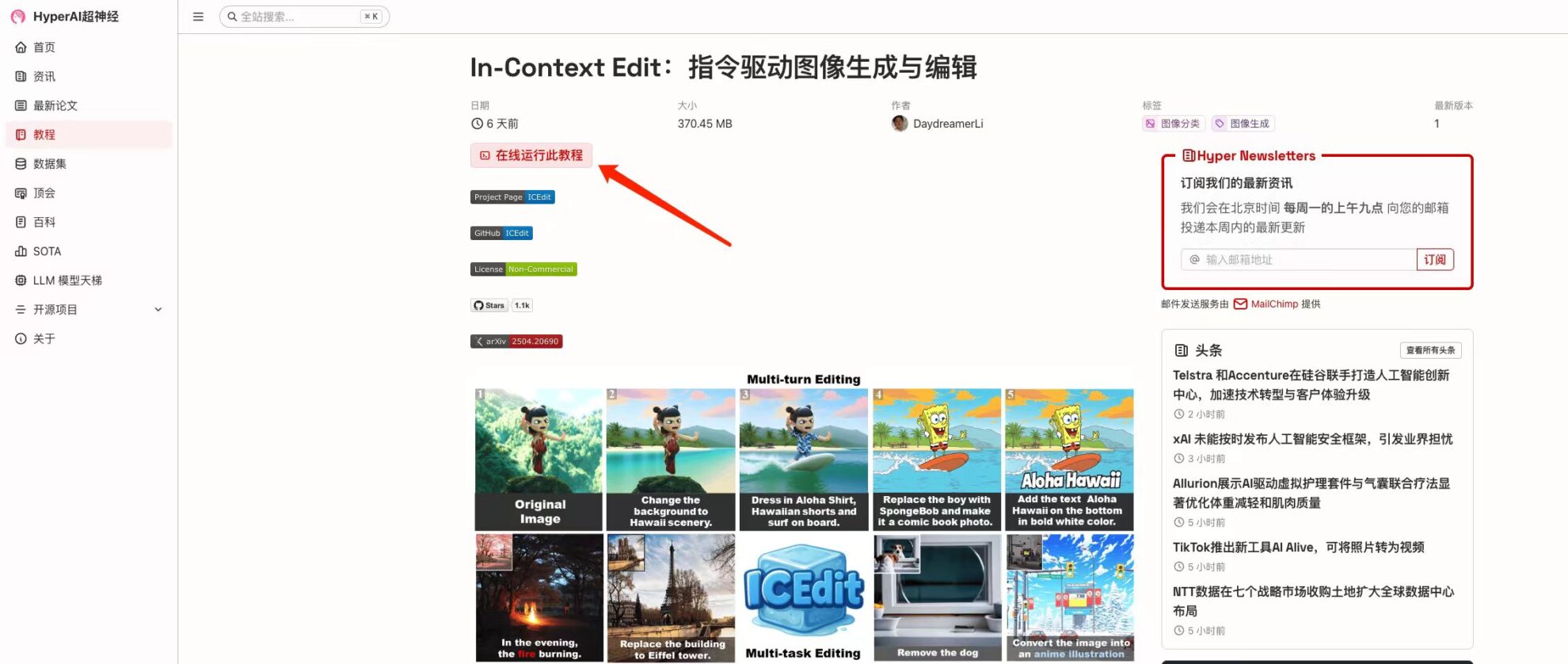

目前,「In-Context Edit:指令驱动图像生成与编辑」已上线至 HyperAI 超神经官网的「教程」板块,点击下方链接即可体验一键部署教程 ⬇️

教程链接:https://go.hyper.ai/SHowG

Demo 运行

1. 进入 hyper.ai 首页后,选择「教程」页面,并选择「In-Context Edit:指令驱动图像生成与编辑」,点击「在线运行此教程」。

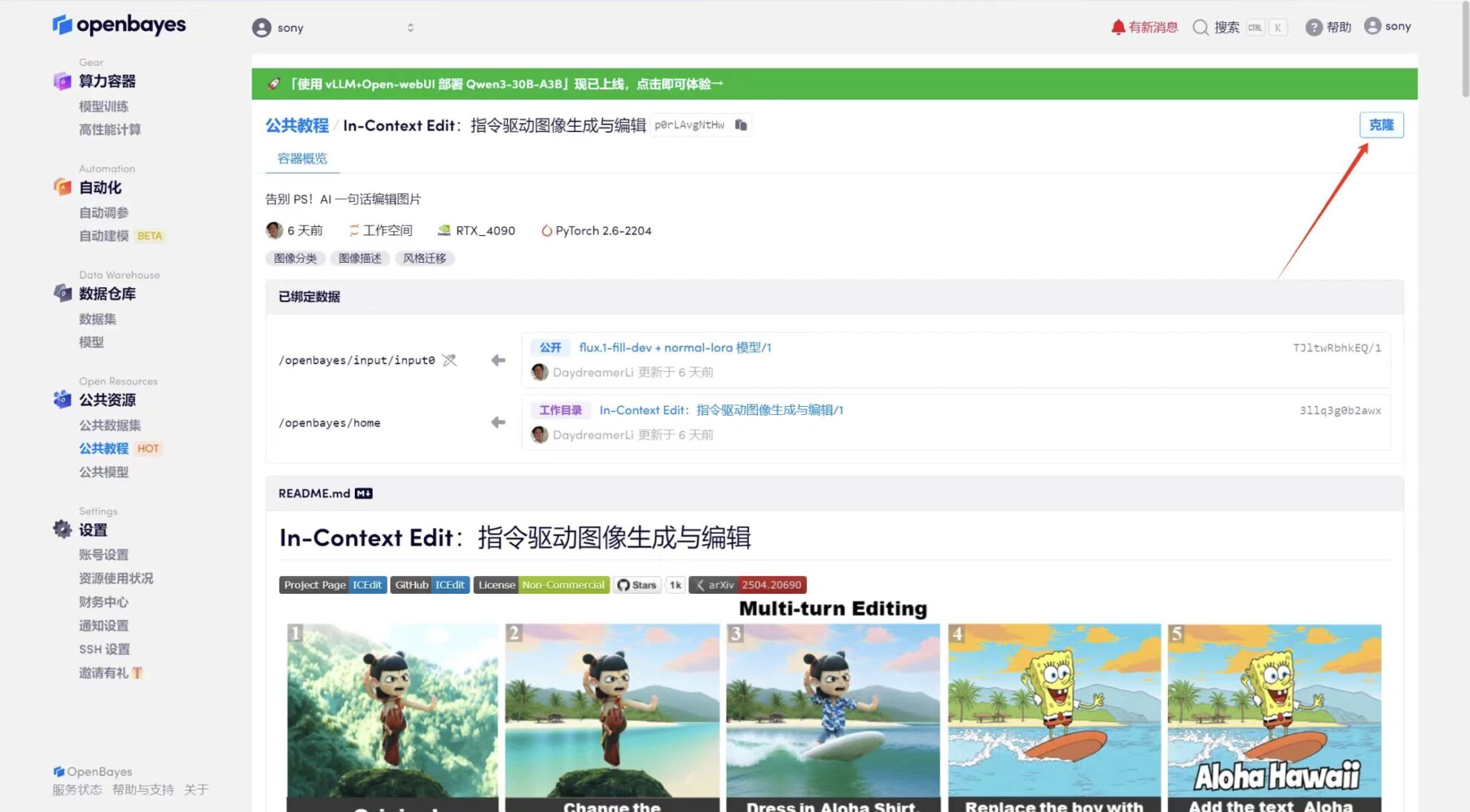

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

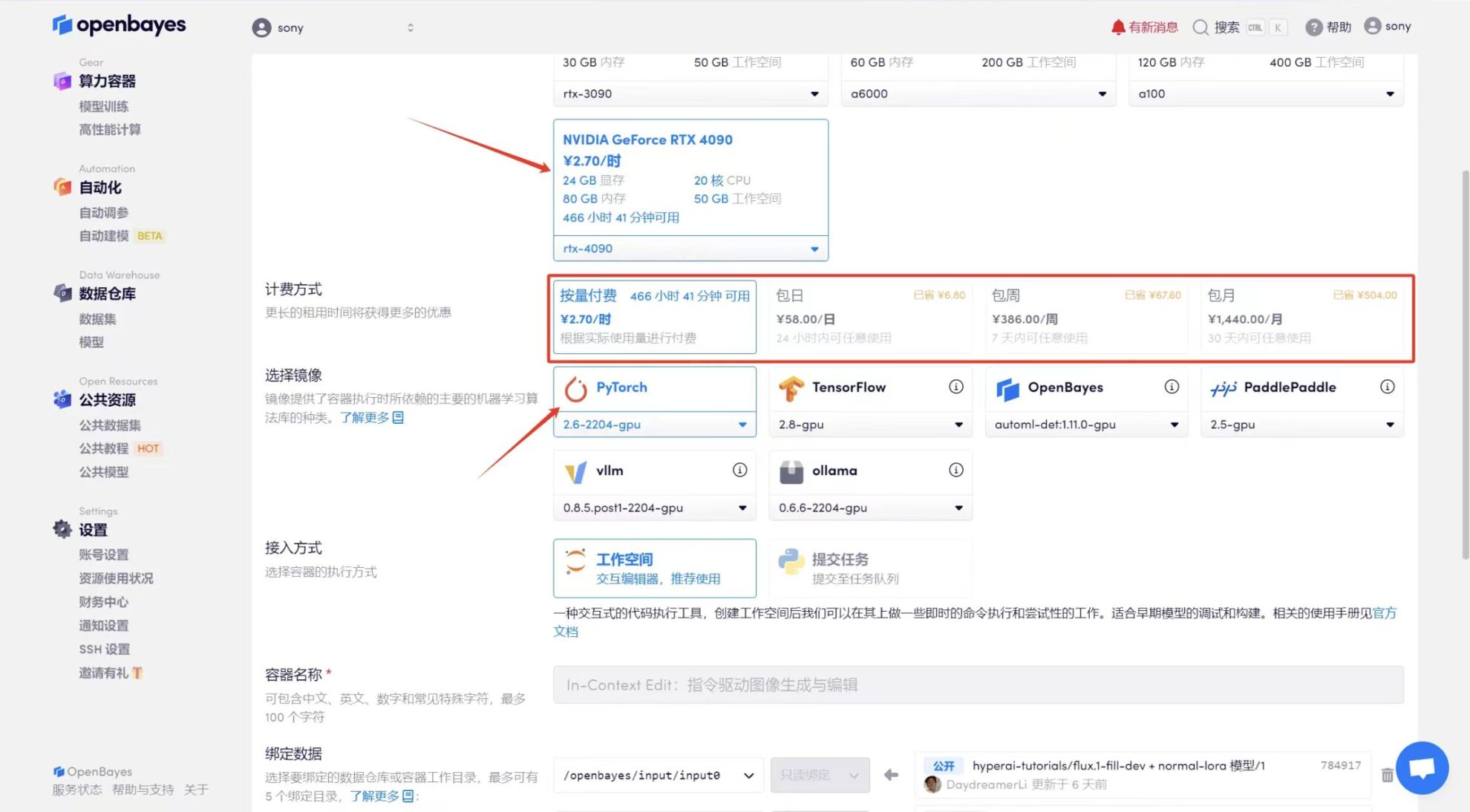

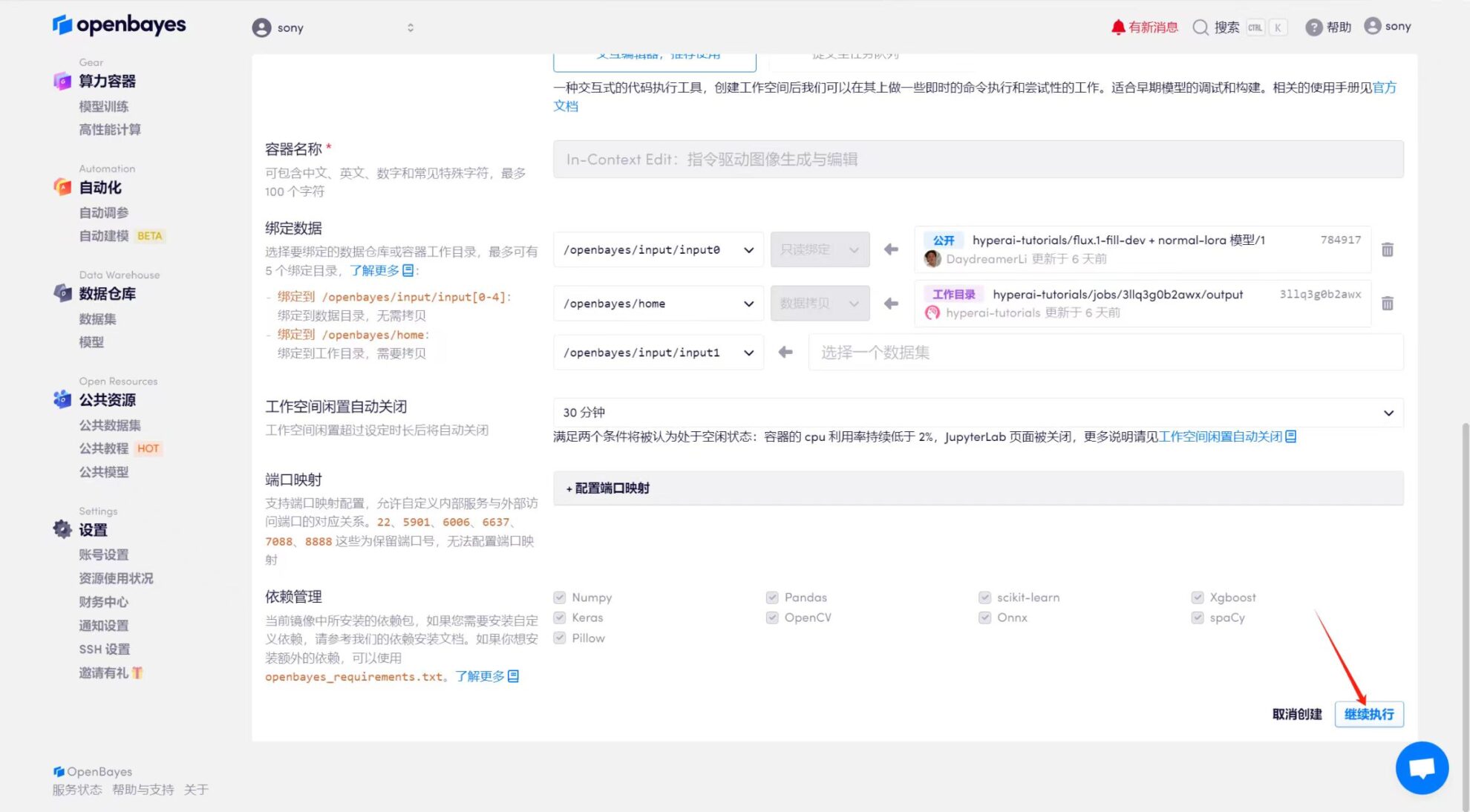

3. 选择「NVIDIA GeForce RTX 4090」以及「PyTorch」镜像,OpenBayes 平台提供了 4 种计费方式,大家可以按照需求选择「按量付费」或「包日/周/月」,点击「继续执行」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

HyperAI 超神经专属邀请链接(直接复制到浏览器打开):

https://openbayes.com/console/signup?r=Ada0322_NR0n

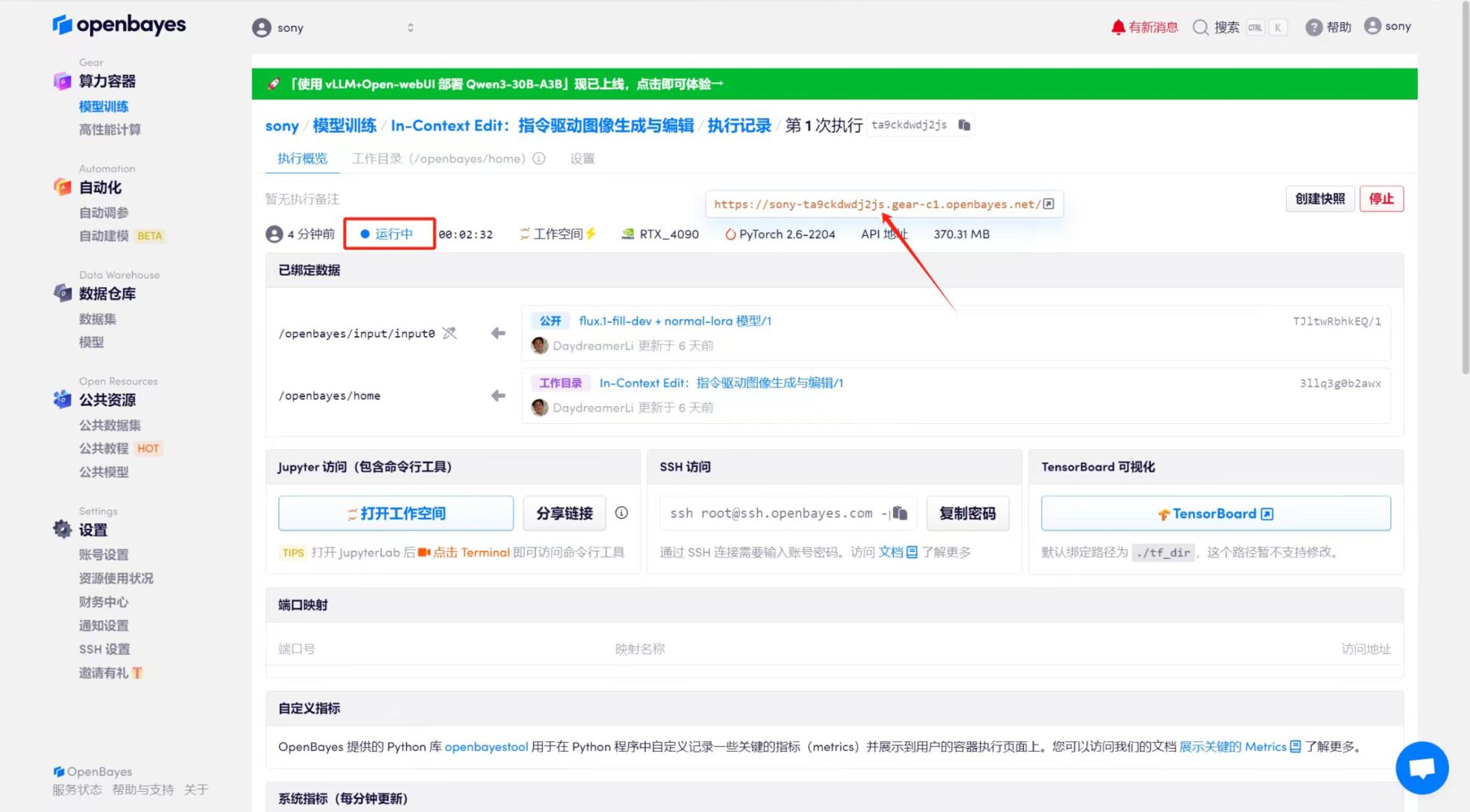

4. 等待分配资源,首次克隆需等待 2 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」旁边的跳转箭头,即可跳转至 Demo 页面。由于模型较大,需等待约 3 分钟显示 WebUI 界面,否则将显示「Bad Gateway」。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果展示

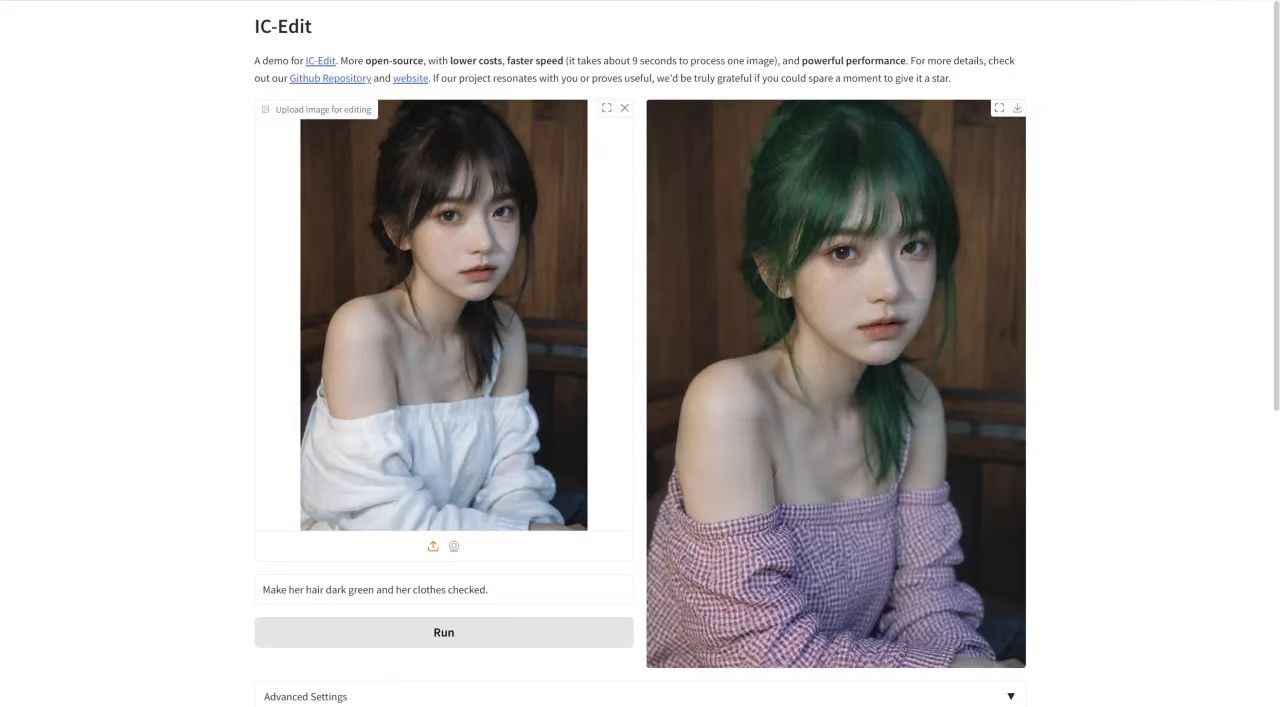

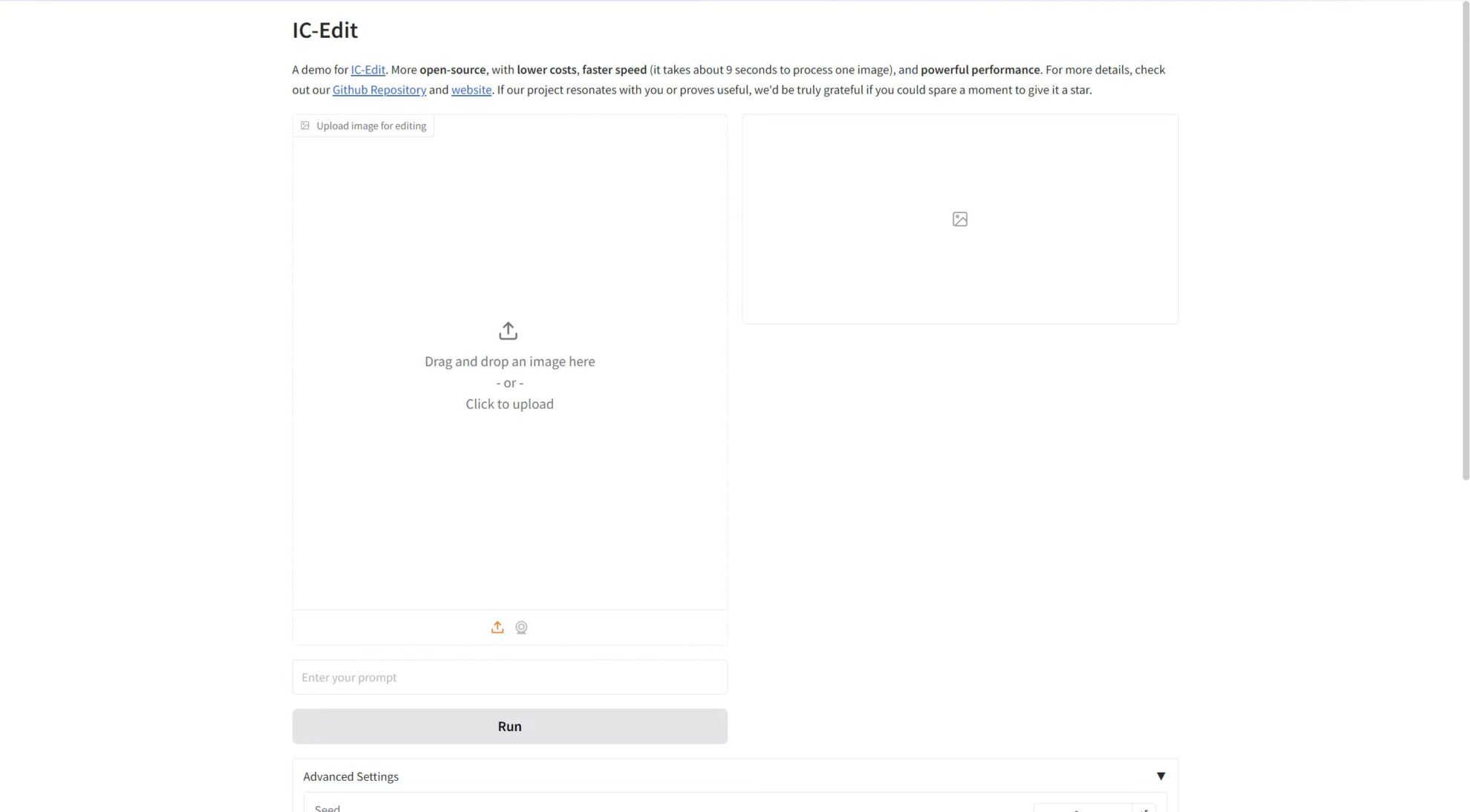

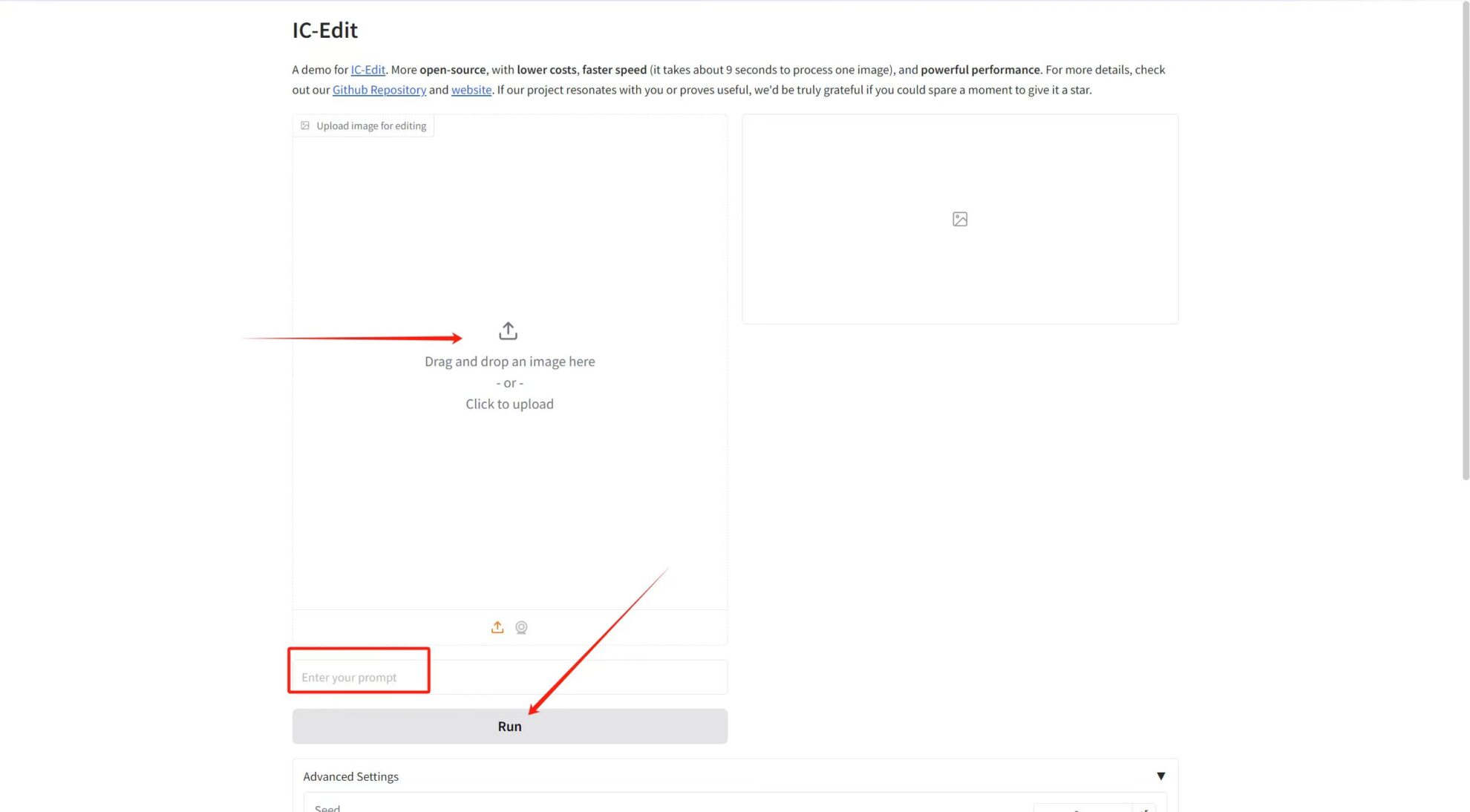

在「Upload image for editing」中上传图片,然后在文本框中输入提示词,最后点击「Run」生成。

参数调整简介:

* Guidance Scale: 用于控制生成模型中条件输入(如文本或图像)对生成结果的影响程度。较高的指导值会让生成结果更加贴近输入条件,而较低的值会保留更多随机性。

* Number of inference steps: 表示模型的迭代次数或推理过程中的步数,代表模型用于生成结果的优化步数。更高的步数通常会生成更精细的结果,但可能增加计算时间。

* Seed: 随机数种子,用于控制生成过程中的随机性。相同的 Seed 值可以生成相同的结果(前提是其他参数相同),这在结果复现中非常重要。

笔者上传了一张人像图片,提示词为:Make her hair dark green and her clothes checked. 效果如下图所示~