Command Palette

Search for a command to run...

Llama 3.2 来了,多模态且开源!AR 眼镜黄仁勋首批体验,Quest 3S 头显价格低到离谱

如果说 OpenAI 的 ChatGPT 拉开了「百模大战」的序幕,那 Meta 的 Ray-Ban Meta 智能眼镜无疑是触发「百镜大战」的导火索。自去年 9 月在 Meta Connect 2023 开发者大会上首次亮相,短短数月,Ray-Ban Meta 就突破百万销量,不仅让马克·扎克伯格直呼 Amazing,更促使了谷歌、三星、字节跳动等国内外大厂的纷纷入局!

时隔一年,Meta 再次在 Connect 开发者大会上推出了智能眼镜新产品 Orion,这是该公司推出的首款全息 AR 眼镜,扎克伯格称其为世界上最先进的眼镜,将会改变未来人与世界的交互方式。

此外,按照惯例,Meta 通常会在 Connect 大会推出 Quest 头显新产品,今年亦是如此。鉴于去年发布的 Meta Quest 3 被用户们普遍反映价格过高,今年 Meta 推出了一款性能与 Quest 3 相近但价格更亲民的新头显 Quest 3S,这款头显被认为是当前市场上最佳的混合现实设备,可以提供极佳的超现实体验。

当然,作为 Meta 旗下备受瞩目的核心技术之一,Llama 模型也在此次发布会上迎来了重大更新。多模态 Llama 3.2 能够同时理解图像和文本,手机也能跑大模型,为其开源生态再添助益。

Meta 的 AR 梦想成真,Orion 眼镜开启全新交互时代

今年 4 月,为庆祝 Reality Labs 成立 10 周年,Meta 曾发布一篇文章概述该部门的发展历史,并在文中预告了其下一个核心产品——首款 AR 眼镜。 Meta 表示,Quest 3 能够让用户在物理世界中与数字内容沉浸式互动,Ray-Ban Meta 眼镜让用户享受到 Meta AI 的实用性和娱乐性,而新款 AR 眼镜则会结合这两者的优点,实现最佳的技术融合。

随着 Meta Connect 2024 的临近,市场上越来越多的声音推测,这款 AR 眼镜将会在本次大会中发布。不出所望,今天,Meta 发布了其首款 AR 眼镜 Orion 。

扎克伯格表示,Orion 致力于改变人与世界的交互方式,是有史以来最先进的 AR 眼镜,历经 10 年研发而成。它拥有最先进的 AR 显示屏、定制的硅芯片、碳化硅镜片、复杂的光波导 (waveguides) 、 uLED 投影仪等,多种技术加持让强大的 AR 体验能够在一副眼镜上运行,而所消耗的电力和重量仅为 MR 头显的一小部分。

简单来说,这种 AR 眼镜采用一种全新的显示架构,利用微型投影仪将光线投射到波导中,再将不同深度和大小的全息图投射到用户面前的世界,并由一块装在眼镜腿里的电池供电。例如,用户如果想与远方的朋友相聚,他们将以全息图的形式出现在客厅,就像真的在身旁一样。

值得一提的是,Orion 在镜框边缘嵌入了 7 个微型摄像头和传感器,并结合语音、眼动和手势追踪,配备 EMG 腕带,用户可以轻松地进行滑动、点击和滚动操作。例如,如果晨跑时想拍照,只需轻轻一按指尖,Orion 就能定格精彩瞬间。此外,只需轻敲手指,还能召唤纸牌游戏、国际象棋或全息乒乓球等娱乐活动。

英伟达创始人兼 CEO 黄仁勋都迫不及待试用啦!

最佳混合现实设备 Quest 3S,性价超高

继去年 Meta 在 Connect 大会上发布全球首款混合现实头显 Meta Quest 3 之后,Meta 今年推出了 Quest 3 的精简版本——Quest 3S 。

扎克伯格表示,「Quest 3S 不仅性价比高,而且是目前市面上能买到的最佳混合现实设备!」它具备与 Quest 3 相似的核心功能,即高分辨率全彩混合现实,用户可以在物理世界和虚拟世界中「无缝穿越」,能够进行娱乐、健身、游戏、社交体验等一系列活动。不同的是,Quest 3S 改进了镜片,并在技术栈、有效分辨率和延迟等方面做了优化,其混合现实手部追踪软件表现更为出色。

混合现实的神奇之处在于,它将写实的空间带入元宇宙,让用户有一种身临其境的感觉,并在不同的体验间自由切换。比如,用户可以选择影院模式,把屏幕放大成一个电影院,获得最佳的剧场观看体验。

在现场演示中,扎克伯格展示了从 2D 移动应用到远程桌面的 PC 的沉浸式体验,用户可以打开屏幕并将其放置在任何位置,形成一个巨大的虚拟显示器,并进行工作。他提到,Meta 一直在与微软合作升级远程桌面功能,不久之后,这种功能或许就可以连接到 Windows 11 电脑上。

值得一提的是,Meta Quest 3S 以难以置信的价格提供超现实的体验,起价仅为 299.99 美元,将在 10 月 15 日上市。今年秋天购买 Quest 3S 的用户,还将获赠《Batman: Arkham Shadow》游戏的 VR 体验。

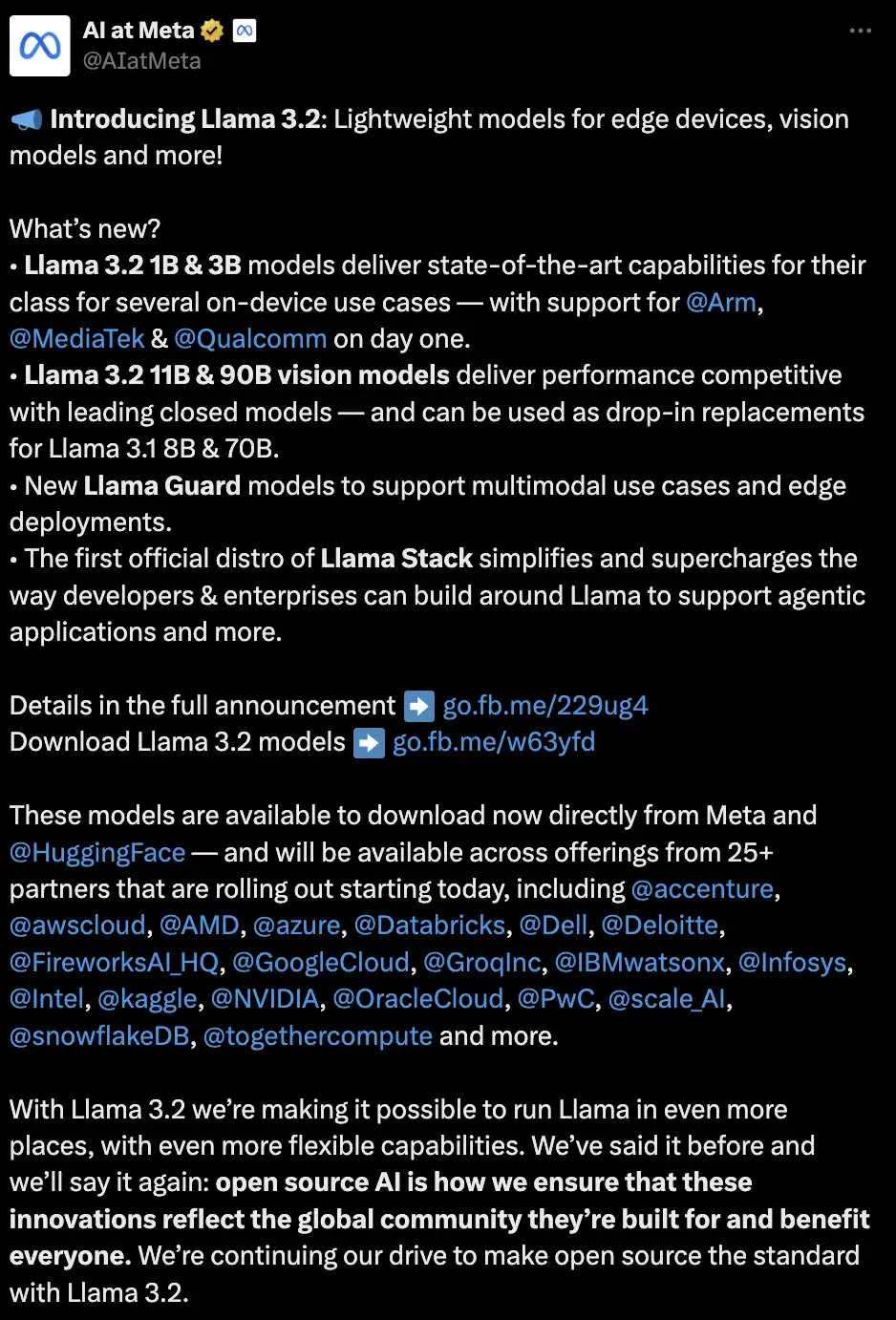

首个支持视觉任务的 Llama 模型,多模态且开源

除了重磅的硬件发布外,小扎还带来了 Llama 的更新,推出 Llama 3.2 模型。作为第一个支持视觉任务的 Llama 模型,Llama 3.2 能够同时理解图像和文本。其中包含适用于边缘和移动设备的中小型视觉模型 (11B 和 90B) 以及轻量级纯文本模型 (1B 和 3B),这两个类别均包括预训练版和指令微调版。值得一提的是,这些不同规格的模型均可通过 Meta AI 进行试用。

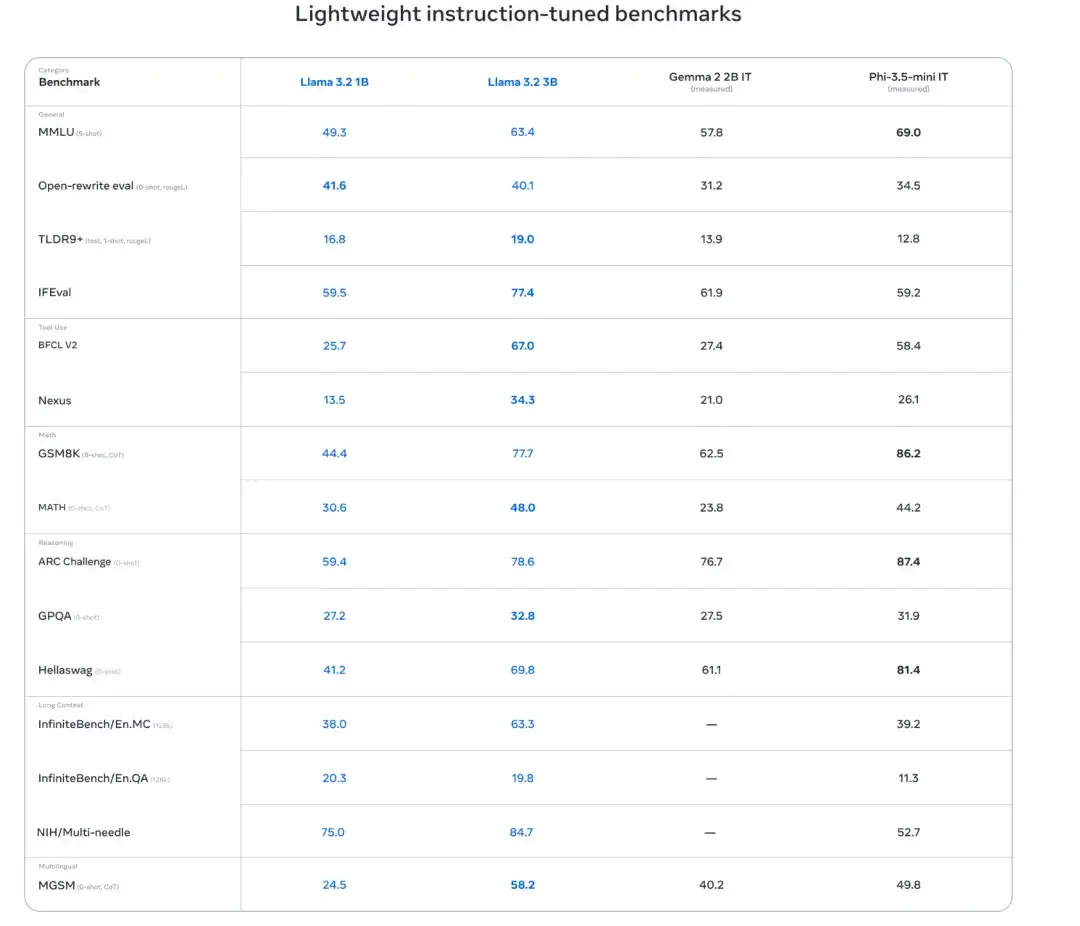

模型性能评估

研究人员在超过 150 个跨语言的基准数据集评估模型性能。结果显示,Llama 3.2 1B 和 3B 模型支持 128K tokens 的上下文长度,在遵循指令、总结、提示改写和工具使用等任务上,3B 模型优于 Gemma 2 2.6B 和 Phi 3.5-mini 模型,而 1B 模型则能够与 Gemma 模型一争高下。

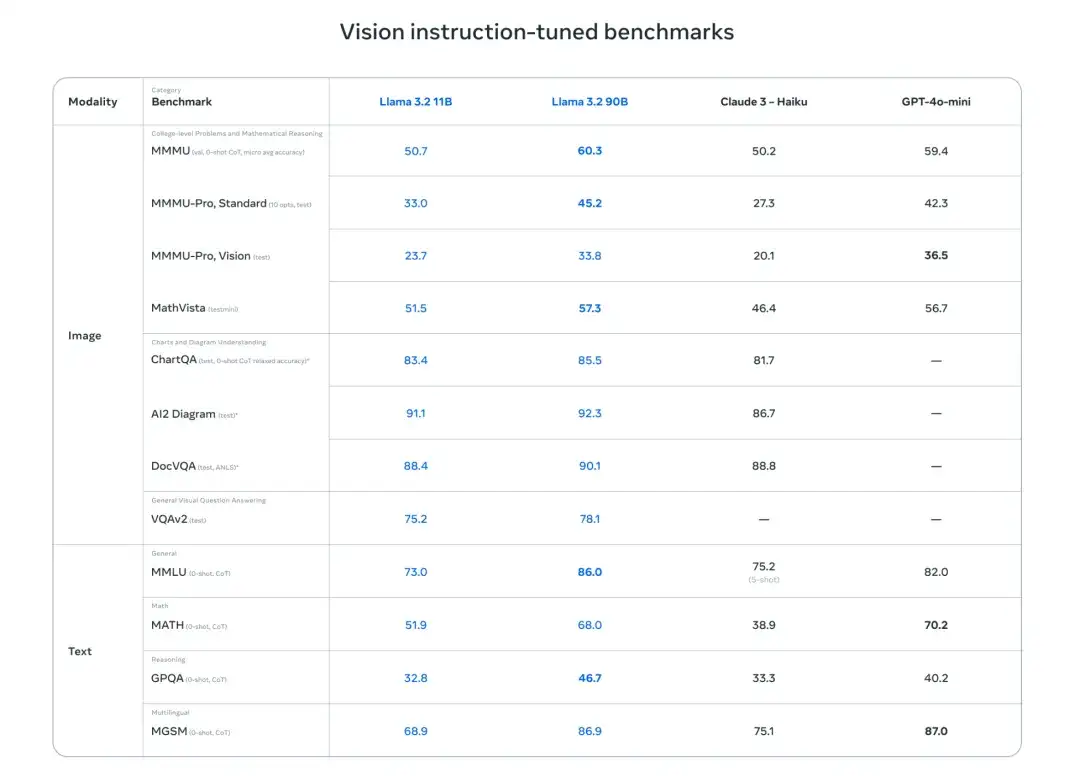

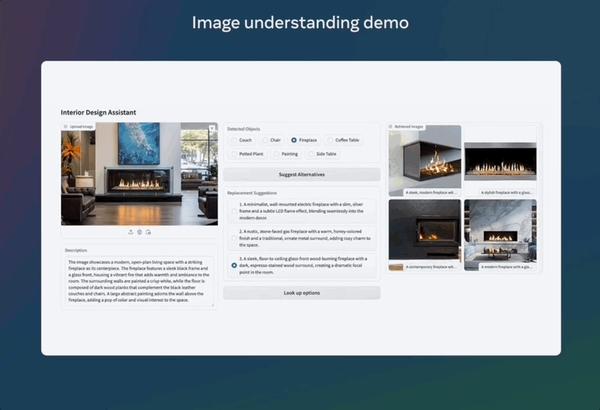

此外,研究人员评估了模型在图像理解和视觉推理基准的性能。结果显示,Llama 3.2 11B 和 90B 视觉模型可以无缝替代相应的文本模型,同时在图像理解任务上超越了诸如 Claude 3 Haiku 之类的闭源模型。

轻量级模型训练

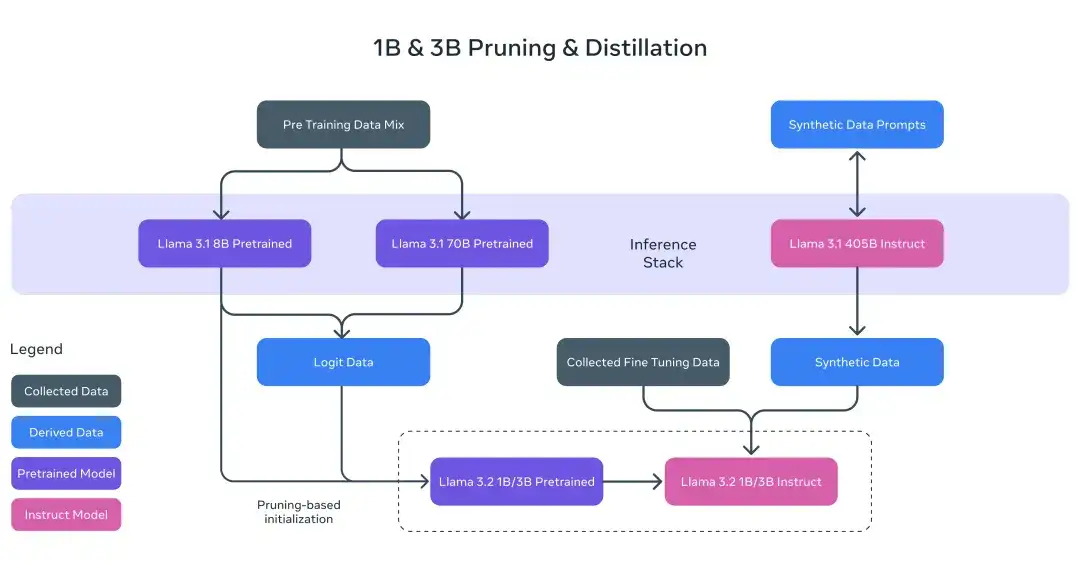

对于 Llama 3.2 1B 和 3B 模型,研究人员采用剪枝和蒸馏两种方法,从 8B/70B 模型中提炼出高效的 1B/3B 模型。

具体而言,研究人员将 Llama 3.1 的 8B 和 70B 模型的 Logit Date 纳入预训练阶段,使用这些较大模型的输出 (logit date) 作为 token 级别的目标,进行结构化剪枝。剪枝完成后,研究人员利用知识蒸馏来恢复模型的性能。

视觉模型训练

Llama 3.2 的训练流程分为多个阶段。首先,从预训练的 Llama 3.1 文本模型开始。接着,研究人员添加图像适配器和编码器,并在大规模的噪声(图像、文本)配对数据上进行预训练。然后,在中等规模的高质量域内和知识增强的(图像、文本)配对数据上进行训练。

在后期训练中,研究人员采用与文本模型相似的方法,通过多轮对齐来进行监督微调、拒绝采样和直接偏好优化。研究人员使用 Llama 3.1 模型生成合成数据,对域内图像的问题和答案进行过滤和增强,并使用奖励模型对所有候选答案进行排序,从而确保高质量的微调数据。

此外,研究人员还引入了安全缓解数据,以打造一个兼具高度安全性和实用性的模型。最终,能够同时理解图像和文本的 Llama 3.2 模型诞生,标志着 Llama 模型在通向更丰富代理能力的道路上又迈出了重要的一步。

本地部署模型及时且安全

研究人员指出本地运行 Llama 3.2 模型有两大优势。首先,在响应速度上,由于处理全部在本地完成,提示和响应的速度可以达到接近即时的效果。

其次,在隐私安全上,本地运行模型无需将消息和日历等数据发送到云端,保障了用户隐私,使应用程序更加私密。通过本地处理,应用程序可以明确控制哪些查询留在设备上,哪些查询需要交由云端更大的模型来处理。

坚守开源初心,模型部署更加简化和高效

Meta 始终坚守开源初心,为了大幅简化开发者在不同环境(包括单节点、内部部署、云端和设备)中使用 Llama 模型的流程,实现检索增强生成 (RAG) 和工具支持型应用的一键部署,并集成安全功能,Meta 宣布将分享首批官方 Llama Stack 发行版。

据官方介绍,Llama 3.2 模型将在 http://llama.com 和 Hugging Face 上提供下载,并将在包括 AMD 、 AWS 、 Databricks 、 Dell 、 Google Cloud 、 Groq 、 IBM 、 Intel 、 Microsoft Azure 、 NVIDIA 、 Oracle Cloud 、 Snowflake 等在内的合作伙伴平台上提供即时开发支持。

作为一贯的开源倡导者,扎克伯格曾在与黄仁勋的对谈中介绍道,「Meta 从开源生态中获益,已节省数十亿美元」。而 Llama 无疑是其打造开源生态的重要触手,Llama 3.2 进一步向视觉任务拓展,实现多模态,也势必将为其开源生态再添助益。