揭开科技巨头的“碳黑箱”:一篇论文揭示人工智能背后的隐性环境代价

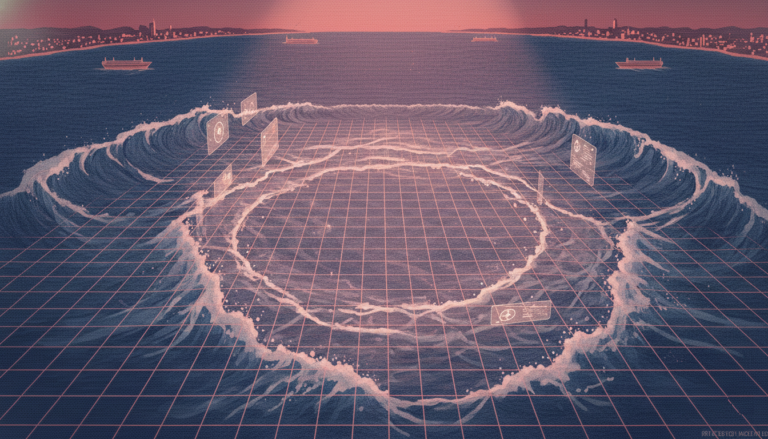

人工智能的隐性碳成本,正从幕后走向台前。本周,谷歌首次公开披露了其AI模型Gemini每次提问的真实环境影响:一次普通文本查询耗电0.24瓦时,相当于微波炉运行一秒;产生0.03克二氧化碳,冷却服务器需消耗0.26毫升水——仅约五滴。 六年前,这类数据几乎不存在。AI的能耗曾是企业内部的“黑箱”指标,无人追问,也无人公开。直到2019年,美国马萨诸塞大学博士生艾玛·斯特鲁贝尔(Emma Strubell)发表一篇论文,彻底打破沉默。她计算发现,训练一个顶尖自然语言模型所产生的碳排放,可能相当于五辆汽车一生的排放总量。她研究的正是后来支撑GPT系列模型的Transformer架构。 斯特鲁贝尔的发现揭示了一个残酷现实:AI训练并非一次完成,而是反复迭代数千次,每一次调整都消耗巨大能源。她的研究将抽象的技术成本转化为普通人能理解的环境代价,成为AI伦理与可持续性讨论的转折点。 两年后,谷歌研究员蒂姆尼特·格布鲁(Timnit Gebru)等人基于这一数据,发表题为《关于随机鹦鹉的危险:语言模型是否太大?》的论文,直指大模型不仅存在伦理风险,更带来不可持续的生态负担。论文引发轩然大波,谷歌却要求她撤稿或删除公司署名,最终导致她被解雇。这一事件在全球引发强烈抗议,超过1400名谷歌员工联署抗议,社交媒体上#ISupportTimnit等话题席卷全球。 谷歌随后试图平息争议,2022年科学家戴夫·帕特森(Dave Patterson)发文反驳斯特鲁贝尔的估算,称其高估了88倍,强调TPU芯片效率提升、数据中心绿色化等进展。然而,外界质疑:这些“进步”是否掩盖了根本问题? 如今,谷歌终于迈出关键一步,公布每项AI请求的能耗与碳排数据。结果显示:58%能耗来自TPU计算,25%用于CPU与内存,10%为备用系统,8%用于冷却。更值得关注的是,谷歌称其AI效率较去年提升33倍,碳排放下降44倍——这是可验证的实绩。 但专家提醒:效率提升可能引发“杰文斯悖论”——越便宜越用得多,全球数据中心能耗可能十年内翻倍。此外,当前数据未涵盖区域差异(如燃煤地区 vs 可再生能源地区)和全生命周期碳足迹。 谷歌的透明化,不仅是公关姿态,更是技术演进的必然。AI正深度嵌入生活,能效成为核心竞争力。真正的挑战在于:如何将透明度转化为问责机制,推动政府、学术界与媒体共同监督,让AI的发展真正可持续。