Command Palette

Search for a command to run...

MedTrinity-25M 大规模多模态医学数据集

该数据集是由华中科技大学、加州大学圣克鲁斯分校、哈佛大学和斯坦福大学的研究团队于 2024 年共同推出的大规模多模态医学数据集,相关论文成果为「MedTrinity-25M: A Large-scale Multimodal Dataset with Multigranular Annotations for Medicine」。

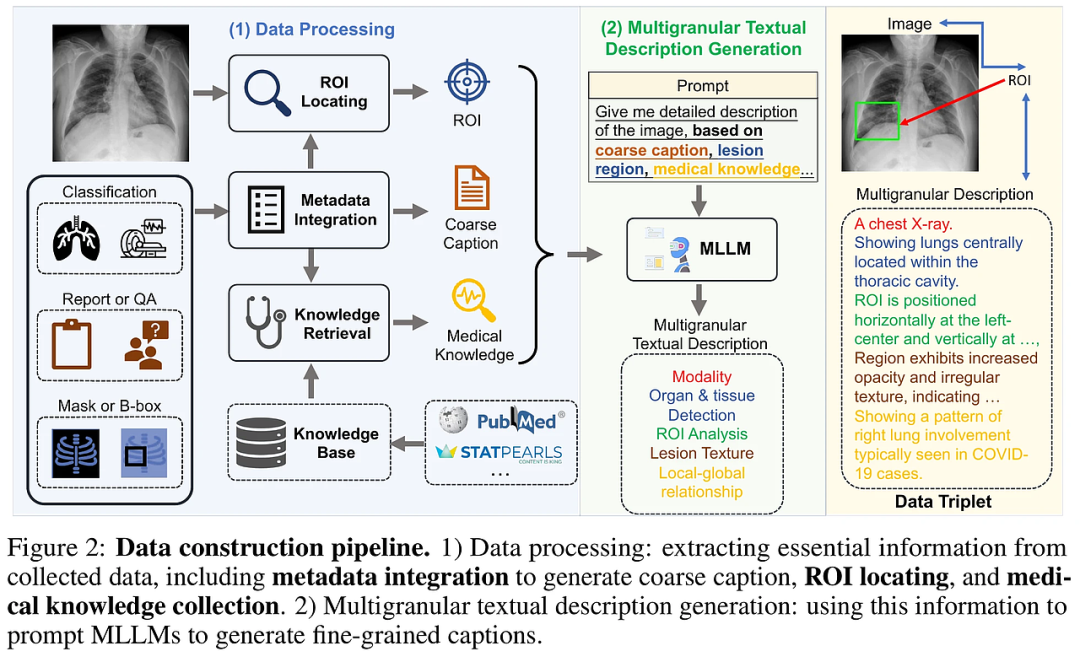

MedTrinity-25M 包含了超过 2,500 万张医学图像,涵盖了 10 种成像模式,还标注了 65 种以上的疾病。此数据集不仅包含丰富的全局及局部注释,同时还在多种模态(如 CT 、 MRI 、 X 光等)中整合了多层次的信息注释。这些注释包括疾病或病变类型、成像模态、区域特定描述及器官之间的关系等。通过对 90 多个不同来源的数据进行预处理与整合,研究团队开发出一个独特的自动化数据构建流程,用于生成多层次的视觉与文本注释。这种方法突破了传统依赖于配对图像-文本的限制,实现了注释的自动生成。该数据集将为医学图像处理、报告生成、分类和分割等多模态任务提供巨大的支持,同时推动基于医学的人工智能模型的预训练。