Command Palette

Search for a command to run...

LiveCC: 실시간 영상 해설 대형 모델

프로젝트 개요

LiveCC는 2025년 4월 25일 싱가포르 국립대학교 쇼랩(Show Lab)과 바이트댄스(ByteDance)에 의해 처음 출시되었습니다. LiveCC는 대규모 스트리밍 음성 전사에 중점을 둔 비디오 언어 모델 프로젝트입니다. 이 프로젝트는 혁신적인 비디오 자동 음성 인식(ASR) 스트리밍 방식을 통해 실시간 해설 기능을 갖춘 최초의 비디오 언어 모델을 학습하여 스트리밍 및 오프라인 벤치마크 모두에서 최첨단(SOTA) 수준을 달성하는 것을 목표로 합니다. 관련 논문 결과는 다음과 같습니다.LiveCC: 대규모 스트리밍 음성 전사를 통한 비디오 LLM 학습"는 CVPR 2025에 포함되었습니다.

이 튜토리얼에서는 리소스로 단일 RTX A6000 카드를 사용합니다.

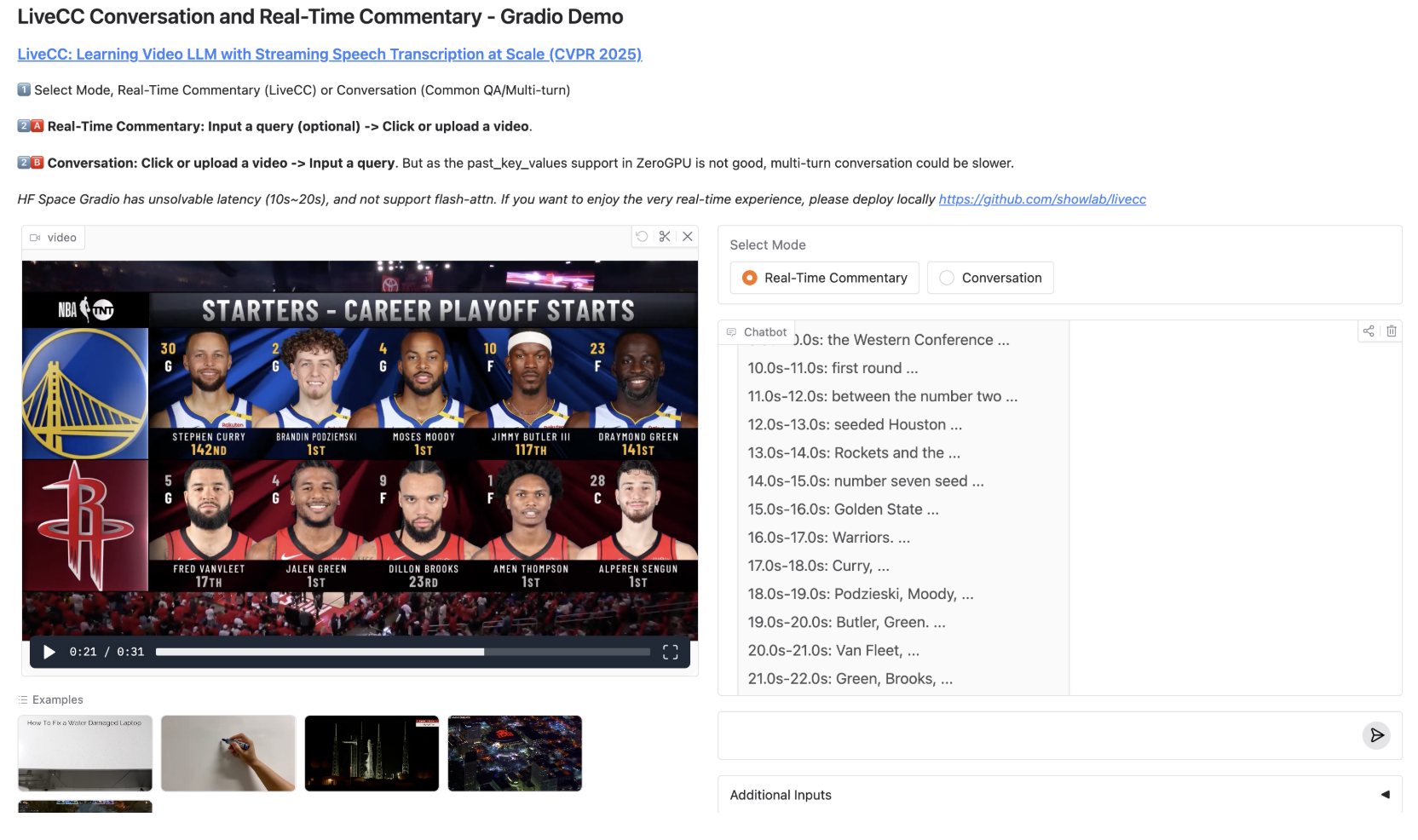

프로젝트 예시

실행 단계

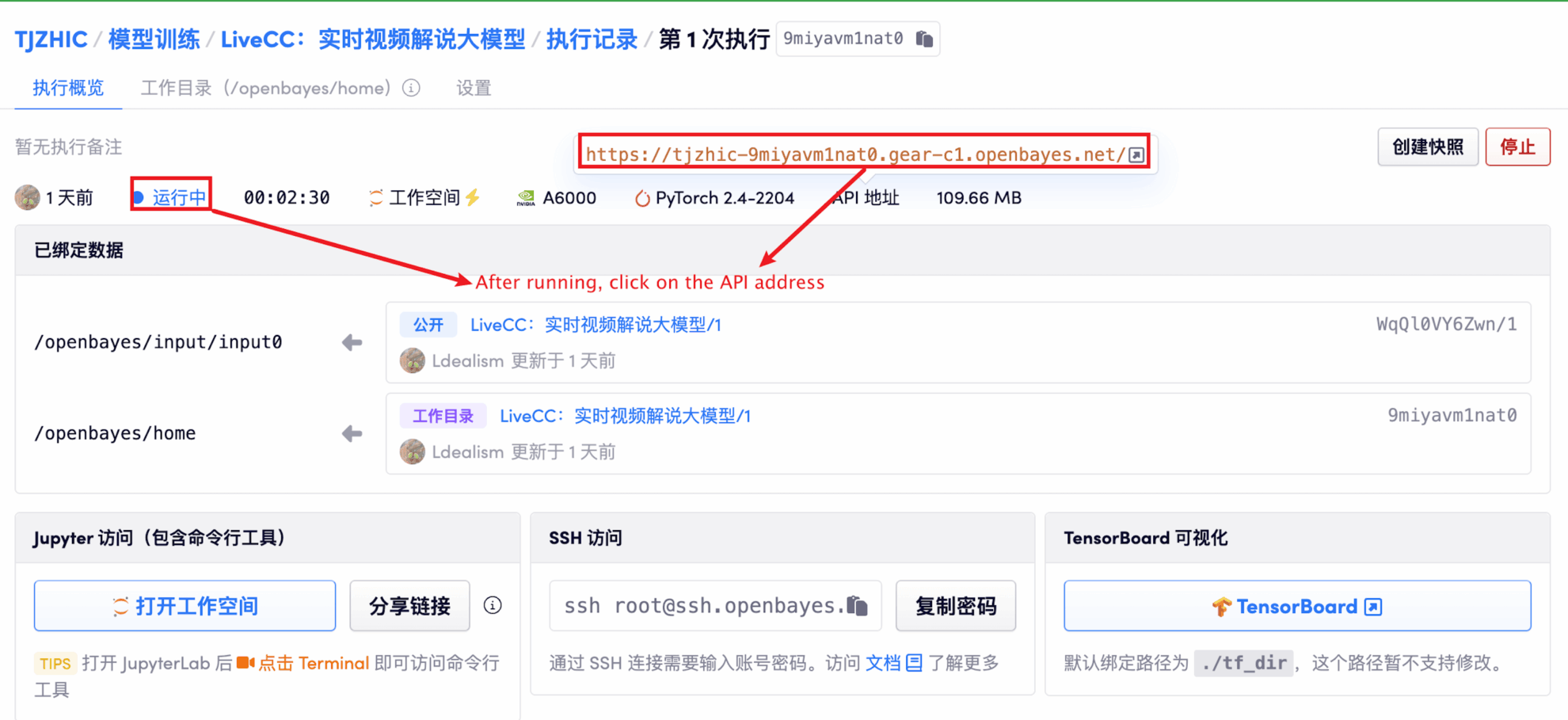

1. 컨테이너 시작 후 API 주소를 클릭하여 웹 인터페이스로 진입합니다.

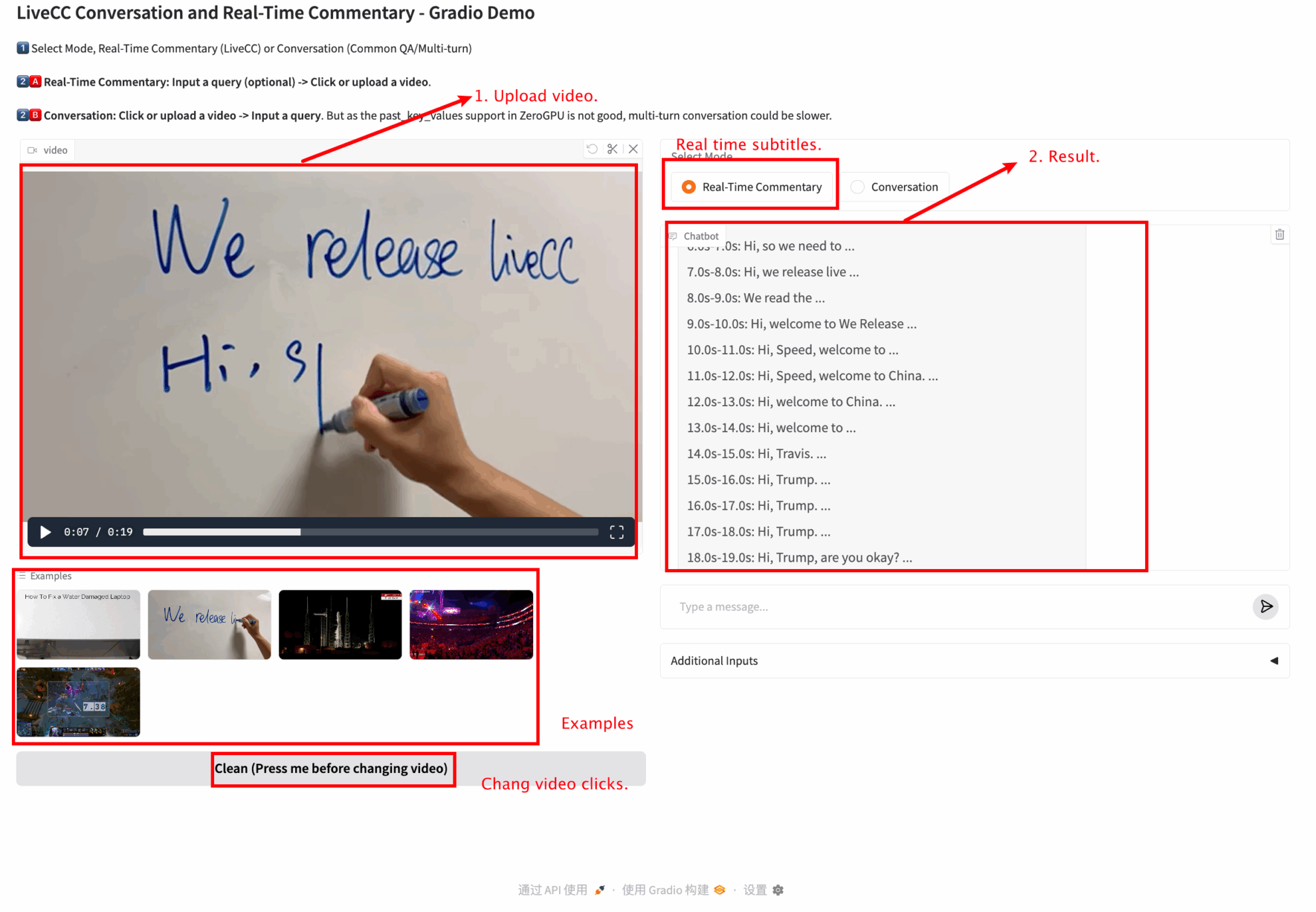

2. 웹 페이지에 접속하면 모델과 상호작용이 가능합니다.

"잘못된 게이트웨이"가 표시되면 모델이 초기화 중임을 의미합니다. 모델이 크기 때문에 1~2분 정도 기다리신 후 페이지를 새로고침해 주세요.

이 튜토리얼에서는 실시간 해설 모듈과 대화 모듈이라는 두 가지 모듈 테스트를 제공합니다.

리소스 혼잡을 피하려면 모델을 자주 전환하지 마세요.

각 모듈의 기능은 다음과 같습니다.

실시간 해설

교류 및 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

이 프로젝트에 대한 인용 정보는 다음과 같습니다.

@inproceedings{livecc,

author = {Joya Chen and Ziyun Zeng and Yiqi Lin and Wei Li and Zejun Ma and Mike Zheng Shou},

title = {LiveCC: Learning Video LLM with Streaming Speech Transcription at Scale},

booktitle = {CVPR},

year = {2025},

}