Command Palette

Search for a command to run...

Hunyuan-GameCraft-1.0: 대화형 게임 비디오 생성 프레임워크

1. 튜토리얼 소개

Hunyuan-GameCraft-1.0은 텐센트 Hunyuan 팀과 화중과학기술대학교가 2025년 8월 공동 출시한 고도로 동적인 인터랙티브 게임 비디오 생성 프레임워크입니다. 키보드와 마우스 입력을 공유 카메라 표현 공간으로 통합하여 정교한 동작 제어를 구현하고 복잡한 인터랙티브 입력을 지원합니다. 이 프레임워크는 비디오 시퀀스를 자기회귀적으로 확장하고, 게임 장면 정보를 유지하며, 장기적인 시간적 일관성을 보장하는 혼합 히스토리 조건 학습 전략을 도입합니다. 모델 증류 기술을 기반으로 하는 Hunyuan-GameCraft-1.0은 추론 속도를 크게 향상시키고 복잡한 인터랙티브 환경에서의 실시간 배포에 적합합니다. 이 모델은 대규모 AAA 게임 데이터세트를 기반으로 학습되었으며, 뛰어난 시각적 충실도, 신뢰성, 그리고 동작 제어성을 보여주어 기존 모델보다 훨씬 뛰어난 성능을 보입니다. 관련 논문 결과는 다음과 같습니다.Hunyuan-GameCraft: 하이브리드 히스토리 조건을 갖춘 고동적 인터랙티브 게임 영상 생성".

이 튜토리얼에서는 4개의 RTX 4090 그래픽 카드를 컴퓨팅 리소스로 사용합니다.

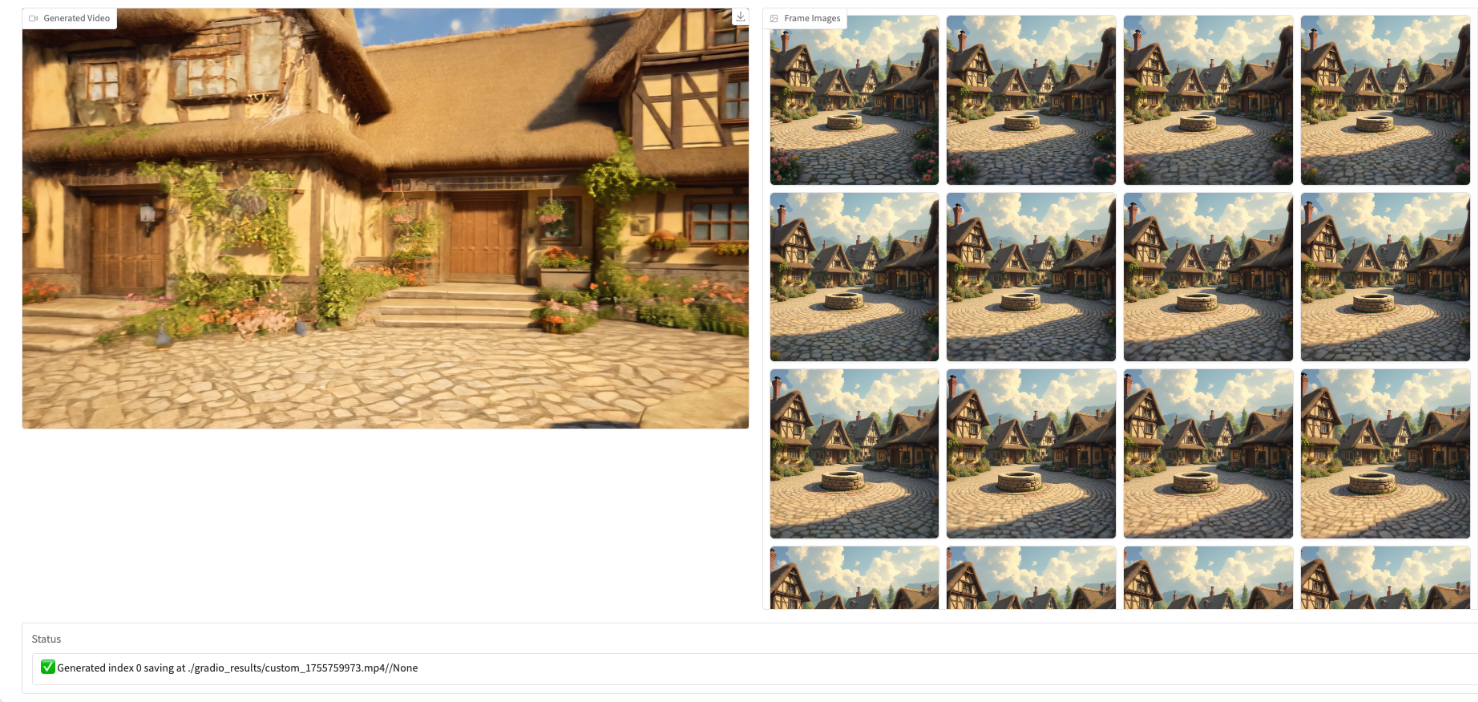

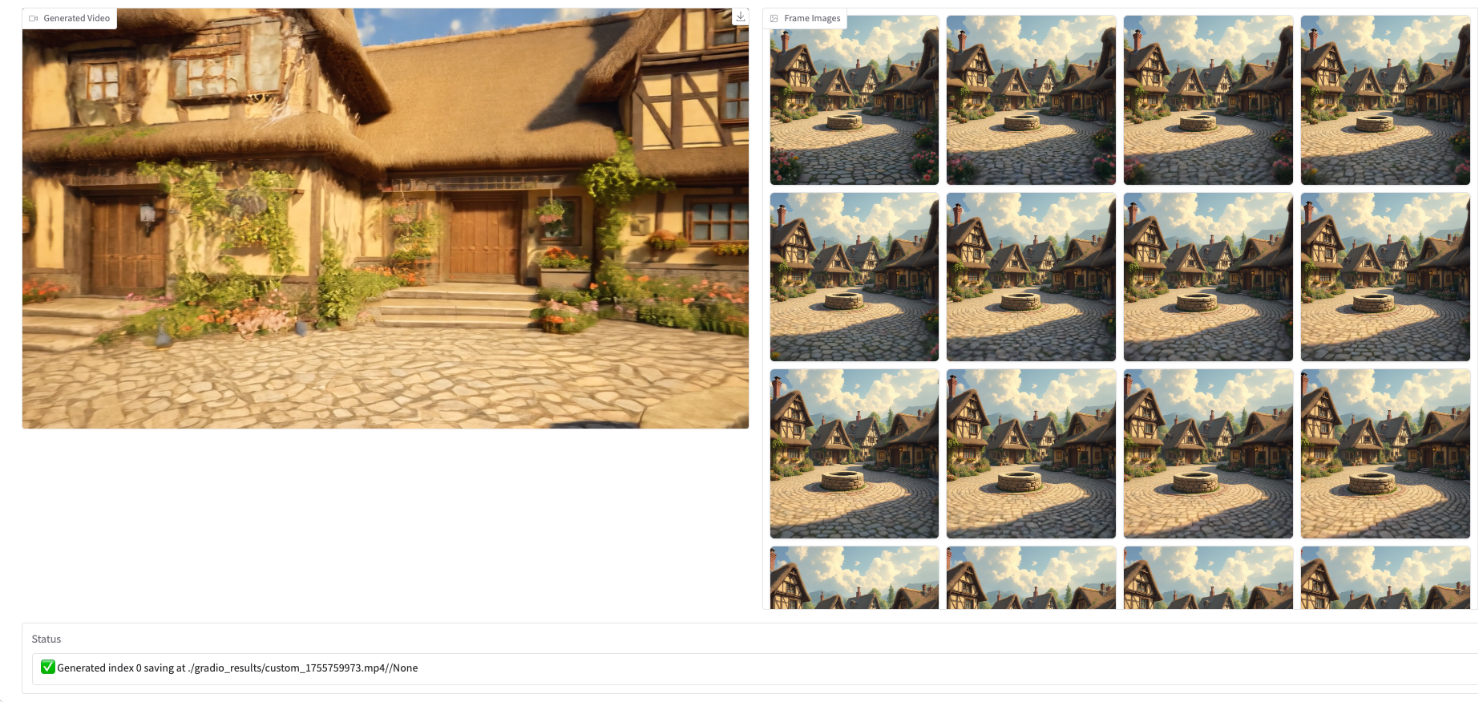

2. 효과 표시

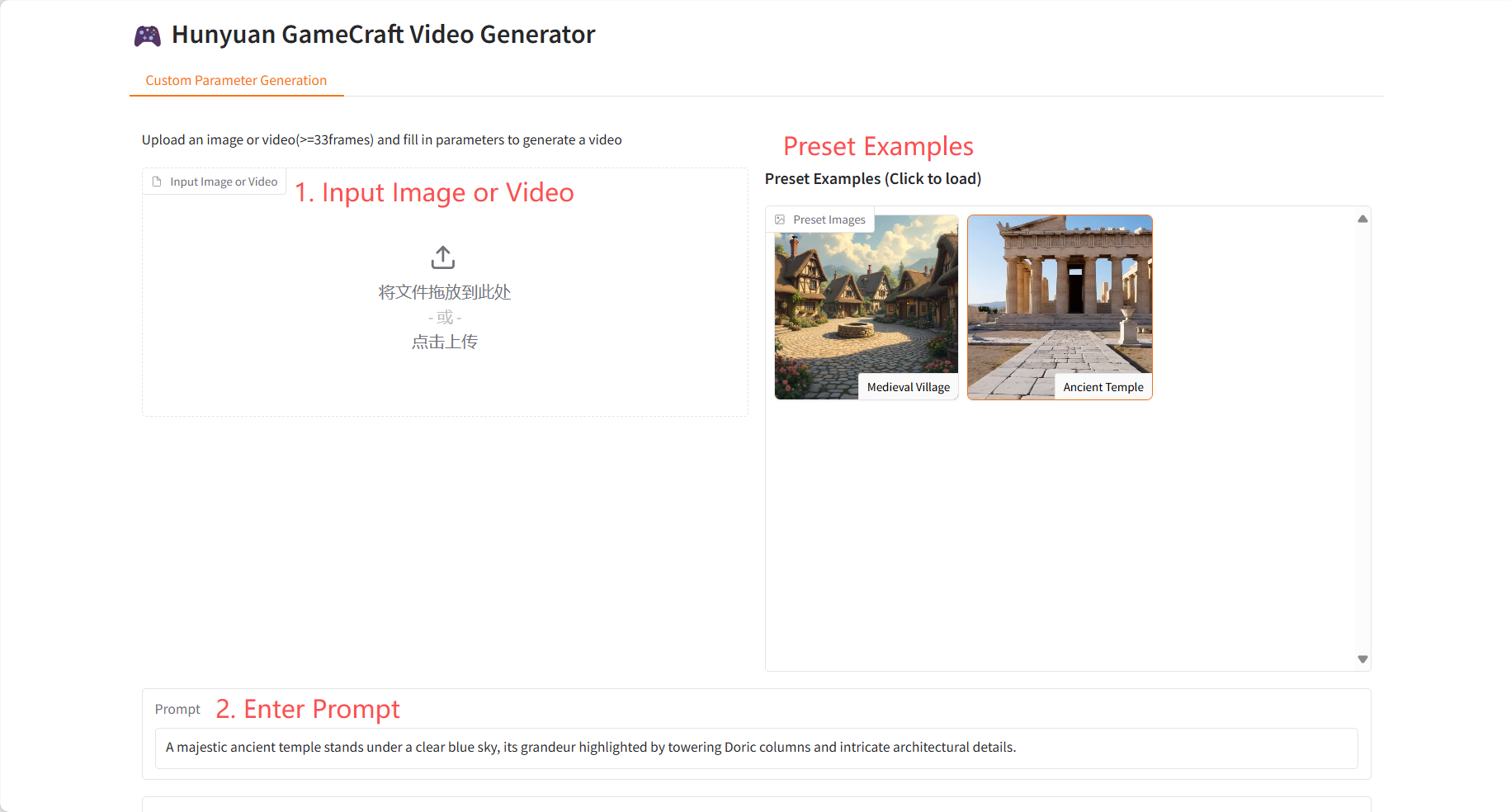

3. 작업 단계

1. 컨테이너를 시작하세요

2. 사용 단계

"잘못된 게이트웨이"가 표시되면 모델이 초기화 중임을 의미합니다. 모델이 크기 때문에 약 5~6분 정도 기다린 후 페이지를 새로 고침하세요. Gradio 인터페이스를 사용하기 전에 모델 초기화가 완료되었는지 확인하세요.

참고: 추론 단계/비디오 프레임이 많을수록 생성되는 효과는 더 좋지만, 추론 생성 시간이 길어집니다. 추론 단계/비디오 프레임을 적절하게 설정하세요. (추론 단계가 5이고 비디오 프레임이 33일 경우, 비디오 생성에 약 15분이 소요됩니다.)

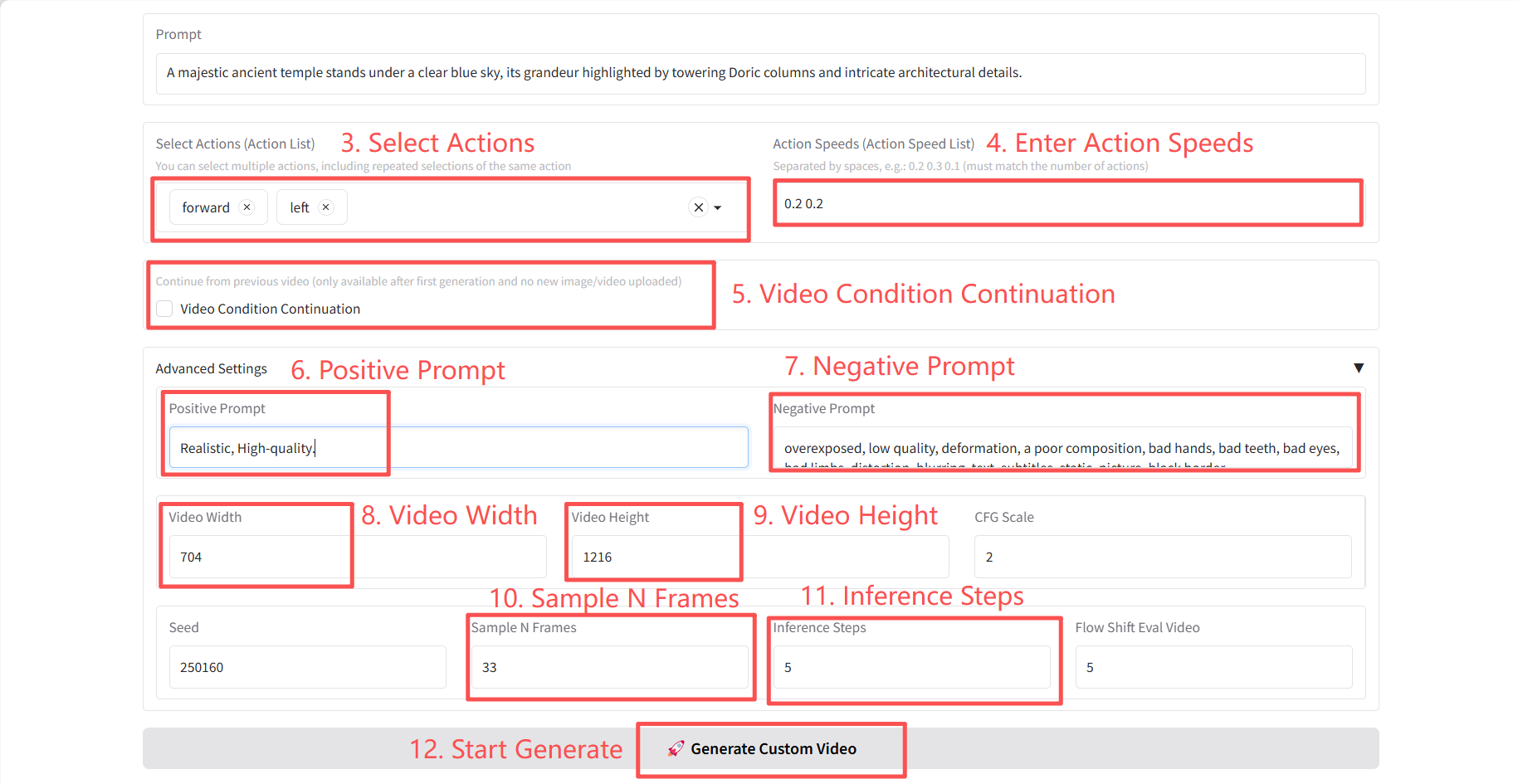

구체적인 매개변수:

- 작업 선택(작업 목록):

- 앞으로: 방향을 바꾸지 않고 현재 방향(카메라/캐리어 바로 앞)을 따라 직선으로 앞으로 이동합니다.

- 왼쪽: 방향을 변경하지 않고 현재 방향의 왼쪽으로 수평 이동합니다.

- 오른쪽: 방향을 변경하지 않고 현재 방향의 오른쪽으로 수평 이동합니다.

- 뒤로: 방향을 바꾸지 않고 현재 방향의 반대 방향으로 직선으로 뒤로 이동합니다.

- up_rot: 뷰/피치 각도를 수평 축을 기준으로 위쪽으로 회전합니다(피치 ↑). 뷰 방향만 변경하고 위치는 변경하지 않습니다.

- right_rot: 수직 축을 중심으로 카메라를 오른쪽으로 회전(yaw →)하여 위치는 변경하지 않고 방향만 변경합니다.

- left_rot: 카메라를 수직 축을 중심으로 왼쪽으로 회전(yaw ←)하여 위치는 변경하지 않고 방향만 변경합니다.

- down_rot: 수평 축(pitch↓)을 중심으로 뷰/피치 각도를 아래로 회전하여 뷰 방향만 변경하고 위치는 변경하지 않습니다.

- CFG 스케일: 프롬프트 단어가 생성되는 결과에 미치는 영향을 조절합니다. 값이 클수록 프롬프트 단어에 더 잘 맞습니다.

- 샘플 N 프레임: 생성된 비디오의 총 프레임 수입니다.

- 추론 단계: 비디오 생성을 위한 반복적 최적화 단계의 수입니다.

- Flow Shift Eval Video: 비디오의 부드러움을 제어하는 매개변수입니다.

4. 토론

🖌️ 고품질 프로젝트를 발견하시면, 백그라운드에 메시지를 남겨 추천해주세요! 또한, 튜토리얼 교환 그룹도 만들었습니다. 친구들의 QR코드 스캔과 [SD 튜토리얼] 댓글을 통해 그룹에 가입하여 다양한 기술 이슈에 대해 논의하고 신청 결과를 공유해 주시기 바랍니다.↓

인용 정보

Github 사용자에게 감사드립니다 슈퍼양 이 튜토리얼의 배포. 이 프로젝트에 대한 인용 정보는 다음과 같습니다.

@misc{li2025hunyuangamecrafthighdynamicinteractivegame,

title={Hunyuan-GameCraft: High-dynamic Interactive Game Video Generation with Hybrid History Condition},

author={Jiaqi Li and Junshu Tang and Zhiyong Xu and Longhuang Wu and Yuan Zhou and Shuai Shao and Tianbao Yu and Zhiguo Cao and Qinglin Lu},

year={2025},

eprint={2506.17201},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2506.17201},

}